بدائل RouteLLM لعام 2026: متى تختار ShareAI (وما الذي يجب مراعاته أيضًا)

تم التحديث في فبراير 2026

يختار المطورون روتLLM لتوجيه الطلبات إلى نماذج أرخص مع استهداف جودة قريبة من GPT-4—خاصة للمهام المشابهة للمعايير حيث يمكن لجهاز التوجيه المتعلم تقليل المستوى بثقة. ولكن إذا كنت تهتم أكثر بـ شفافية السوق قبل كل مسار (السعر المباشر، زمن الاستجابة، وقت التشغيل، التوفر)،, التبديل الفوري بين مزودين متعددين, سياسة الحافة والتدقيق, ، أو وكيل/بوابة مستضافة ذاتيًا, ، فإن أحد هذه بدائل RouteLLM قد يناسب احتياجاتك بشكل أفضل.

هذا الدليل للمشتري مكتوب كما لو كان بانيًا: مقايضات محددة، اختيارات سريعة، استكشافات عميقة، مقارنات جنبًا إلى جنب، ونسخ ولصق ShareAI للبدء السريع حتى تتمكن من الإطلاق اليوم.

فهم RouteLLM (وأين قد لا يكون مناسبًا)

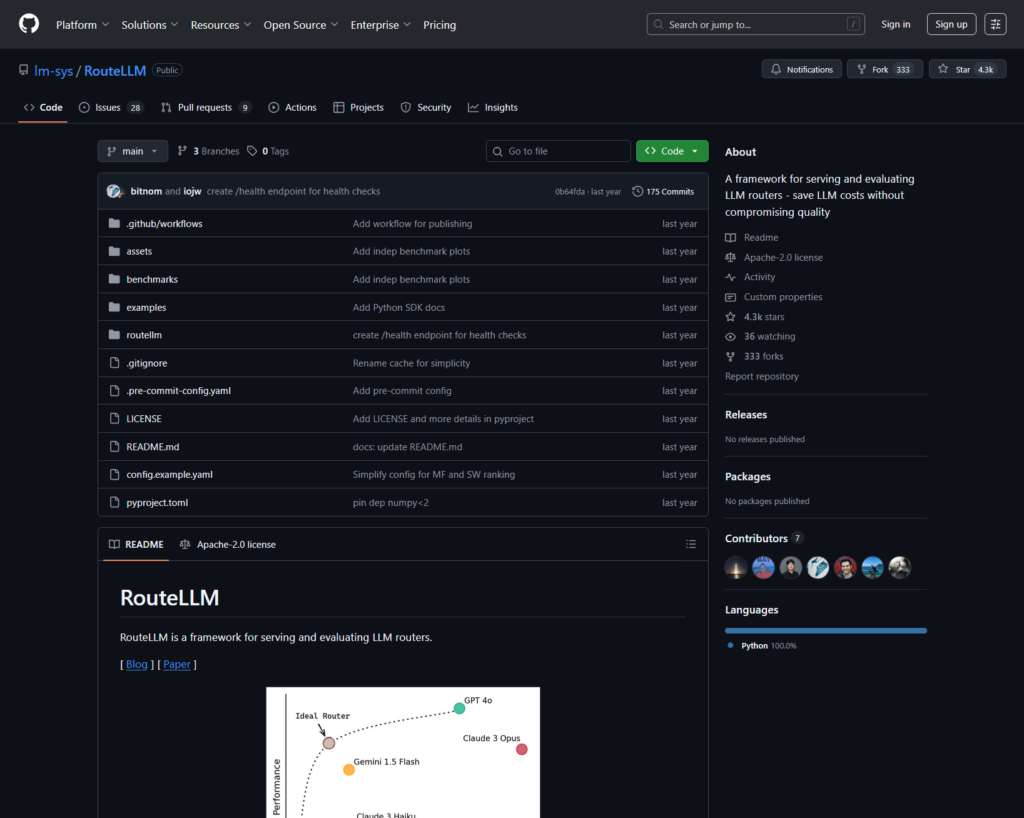

ما هو RouteLLM. RouteLLM هو إطار عمل مفتوح المصدر لخدمة وتقييم أجهزة توجيه LLM. يوفر عميل/خادم متوافق مع OpenAI ويشحن نماذج توجيه مدربة يمكنها توجيه الاستفسارات الأبسط إلى نماذج أرخص—تم الإبلاغ عن تقليل التكلفة بنسبة تصل إلى 85% مع الحفاظ على ~95% من أداء GPT-4 على المعايير الشائعة (مثل MT-Bench).

لماذا تختاره الفرق.

- التوجيه المدرك للتكلفة بسياسات مدعومة بالأبحاث.

- مفتوح المصدر وقابل للتوسيع في Python.

- متوافق مع OpenAI مسار لتجربة التوجيه دون إعادة كتابة SDK بشكل كبير.

أين قد لا يناسب RouteLLM.

- تريد شفافية السوق الحي (السعر، التأخير، وقت التشغيل، التوفر) قبل كل مسار - وليس فقط سياسة متعلمة.

- تحتاج تجاوز الفشل متعدد المزودين

- خارطة الطريق الخاصة بك تمتد واجهات برمجة التطبيقات متعددة الوسائط مثل التعرف على النصوص، الصوت، الترجمة، وتحليل المستندات تحت سقف واحد.

كيفية اختيار بديل RouteLLM

- التكلفة الإجمالية للملكية (TCO). لا تتوقف عند $/1K tokens. احسب معدلات ضربات التخزين المؤقت، المحاولات/البدائل، الانتظار، تكاليف التقييم، وعبء العمليات من السجلات/التنبيهات. يمكن للموجهات والبوابات المدركة للتخزين المؤقت مع التخزين المؤقت الدلالي أن تجعل “سعر القائمة الأكثر تكلفة” أرخص في الواقع.

- زمن الاستجابة والموثوقية. فضل التوجيه المدرك للمناطق، الالتصاق بالمزود عندما يكون التخزين المؤقت دافئًا، والبدائل الدقيقة (إعادة المحاولة 429s، التصعيد عند انتهاء المهلة). الموجهات المستضافة التي تبقيك على نفس المزود للسياقات الدافئة وتعود عند حدوث خلل في المزود تميل إلى الفوز.

- المراقبة والحكم. إذا كانت الحواجز، الحذف، سجلات التدقيق، والسياسة على الحافة مهمة، فإن بوابة الذكاء الاصطناعي (Portkey أو Kong AI Gateway) تكون عادة أقوى من الموجه النقي وحده. العديد من الفرق تجمع بين الموجه + البوابة.

- استضافة ذاتية مقابل مُدار. تفضل Docker/K8s/Helm ووكيل متوافق مع OpenAI؟ جرب LiteLLM. تريد سرعة مستضافة + رؤية السوق؟ فكر في ShareAI أو OpenRouter.

- نطاق أوسع من الدردشة. إذا كنت بحاجة إلى التعرف على النصوص، الصوت، الترجمة، أو تحليل المستندات بجانب محادثة LLM، فإن منسق متعدد الوسائط مثل Eden AI يساعد.

- التوجيه المستند إلى البيانات. إذا كنت تفضل المعايير الحية لتوجيه التكلفة/السرعة/الجودة حسب المنطقة أو عبء العمل، قم بتقييم Unify.

أفضل بدائل RouteLLM (اختيارات سريعة)

ShareAI (اختيارنا لشفافية السوق + اقتصاديات البناء)

واجهة برمجة تطبيقات واحدة عبر كتالوج كبير من النماذج/المزودين مع تجاوز فوري وسوق يظهر السعر، التأخير، وقت التشغيل، التوفر قبل التوجيه. ابدأ بسرعة في ملعب, ، احصل على المفاتيح في وحدة التحكم, ، تصفح الوثائق, ، وقارن الخيارات في النماذج.

Eden AI (منسق متعدد الوسائط)

واجهة برمجة تطبيقات موحدة عبر LLMs بالإضافة إلى الصورة، OCR/تحليل المستندات، الصوت، والترجمة—إلى جانب مقارنة النماذج، المراقبة، التخزين المؤقت، ومعالجة الدُفعات.

OpenRouter (توجيه مدرك للتخزين المؤقت)

جهاز توجيه مستضاف عبر العديد من LLMs مع تخزين مؤقت للمطالبات وثبات المزود لإعادة استخدام السياقات الدافئة؛ يعود عند عدم توفر المزود.

Portkey (السياسات وعمليات SRE عند البوابة)

بوابة AI مع تجاوزات قابلة للبرمجة، كتب تشغيل لتحديد المعدل، وتخزين مؤقت دلالي—بالإضافة إلى تتبع/قياسات مفصلة للتحكم في الإنتاج.

Kong AI Gateway (حوكمة الحافة والتدقيق)

جلب إضافات الذكاء الاصطناعي والسياسات والتحليلات إلى نظام كونغ البيئي؛ مناسب تمامًا عندما تحتاج إلى تحكم مركزي على الحافة عبر الفرق.

توحيد (موجه قائم على البيانات)

واجهة برمجة تطبيقات عالمية مع معايير حية لتحسين التكلفة/السرعة/الجودة حسب المنطقة وحجم العمل.

Orq.ai (التجارب و LLMOps)

التجارب، المقيمون (بما في ذلك مقاييس RAG)، النشر، وRBAC/VPC—رائع عندما تحتاج التقييم والحكم إلى التواجد معًا.

LiteLLM (وكيل/بوابة ذاتية الاستضافة)

وكيل مفتوح المصدر ومتوافق مع OpenAI مع ميزانيات/حدود، تسجيل/مقاييس، وواجهة إدارة. انشر باستخدام Docker/K8s/Helm؛ أنت تملك العمليات.

استكشاف عميق: أفضل بدائل RouteLLM

ShareAI (واجهة برمجة التطبيقات للذكاء الاصطناعي المدعومة من الناس)

ما هو. شبكة ذكاء اصطناعي تركز على المزود وواجهة برمجة تطبيقات موحدة. تصفح كتالوجًا كبيرًا من النماذج/المزودين وقم بالتوجيه مع تجاوز فوري للأعطال. يعرض السوق السعر، التأخير، وقت التشغيل، والتوافر في مكان واحد حتى تتمكن من اختيار المزود المناسب قبل كل توجيه. ابدأ في ملعب, ، أنشئ مفاتيح في وحدة التحكم, ، واتبع البداية السريعة لواجهة برمجة التطبيقات في الوثائق. تصفح سوق النماذج.

- شفافية السوق — شاهد السعر/التأخير/وقت التشغيل/التوافر مقدمًا.

- المرونة بشكل افتراضي — تجاوز سريع إلى أفضل مزود تالي عند حدوث خلل.

- اقتصاديات متوافقة مع البناة — يتم توجيه غالبية الإنفاق إلى مزودي GPU الذين يحافظون على النماذج متصلة.

- بدء بدون احتكاك — اختبر في الملعب، ثم قم بالإطلاق.

حقائق المزود (الكسب من خلال الحفاظ على النماذج متصلة). يمكن لأي شخص أن يصبح مزودًا (مجتمع أو شركة). قم بالإعداد عبر Windows/Ubuntu/macOS أو Docker. ساهم في فترات الخمول أو قم بالتشغيل دائمًا. اختر الحوافز: المكافآت (المال)، التبادل (الرموز/مستهلكي الذكاء الاصطناعي)، أو المهمة (تبرع بنسبة % للمنظمات غير الحكومية). شاهد دليل المزود أو افتح لوحة التحكم للمزود.

مثالي لـ. فرق المنتجات التي تريد شفافية السوق، المرونة، ومساحة للنمو إلى وضع المزود - دون التقييد بمزود معين.

إدن AI

ما هو. واجهة برمجة تطبيقات موحدة تمتد عبر LLMs + توليد الصور + OCR/تحليل المستندات + الصوت + الترجمة حتى لا تضطر إلى دمج SDKs متعددة من المزودين. كما يؤكدون على مقارنة النماذج، المراقبة، والتجميع.

مناسب عندما. خارطة الطريق الخاصة بك متعددة الوسائط وتريد تنسيق OCR/الصوت/الترجمة جنبًا إلى جنب مع محادثة LLM.

أمور يجب الانتباه إليها. إذا كنت بحاجة إلى عرض السوق لكل طلب (السعر/الكمون/وقت التشغيل/التوافر) أو اقتصاديات مستوى المزود، قم بإقران جهاز توجيه السوق مثل ShareAI.

أوبن راوتر

ما هو. جهاز توجيه LLM موحد مع توجيه المزود/النموذج و تخزين المؤقت للمطالبات. مع تمكين التخزين المؤقت، يميل OpenRouter إلى إبقائك على نفس المزود لإعادة استخدام السياقات الدافئة؛ إذا كان هذا المزود غير متاح، فإنه يتراجع. كما يدعم تلميحات الاستراتيجية (مثل الوزن حسب السعر).

مناسب عندما. تريد سرعة مستضافة وتوجيه مدرك للتخزين المؤقت لتقليل التكلفة وتحسين الإنتاجية - خاصة في أحمال العمل ذات معدل الطلب العالي مع المطالبات المتكررة.

أمور يجب الانتباه إليها. لحوكمة المؤسسات العميقة (تصدير SIEM، سياسة على مستوى المنظمة)، تقوم العديد من الفرق بإقران OpenRouter مع Portkey أو Kong AI Gateway.

بورتكي

ما هو. بوابة AI مع استراتيجيات احتياطية قابلة للبرمجة، كتب تشغيل لتحديد المعدل، وتخزين مؤقت بسيط/دلالي، بالإضافة إلى تتبع/مقاييس للتحكم بأسلوب SRE. التخزين المؤقت الدلالي مفيد بشكل خاص للمطالبات/الرسائل القصيرة عندما يتم ضبط عتبات التشابه بشكل جيد.

مناسب عندما. تحتاج إلى توجيه مدفوع بالسياسة مع إمكانية مراقبة من الدرجة الأولى، وأنت مرتاح لتشغيل طبقة بوابة أمام جهاز توجيه واحد أو أكثر/أسواق.

كونغ AI جيتواي

ما هو. بوابة طرفية تجلب إضافات AI، السياسة، والتحليلات إلى نظام Kong البيئي (عبر Konnect أو الإدارة الذاتية). إذا كانت منصة واجهة برمجة التطبيقات الخاصة بك تدور بالفعل حول Kong وتحتاج إلى سياسة/تدقيق مركزي، فهذا خيار قوي.

مناسب عندما. حوكمة الطرفية، القابلية للتدقيق، إقامة البيانات، والضوابط المركزية غير قابلة للتفاوض في بيئتك.

توحيد

ما هو. جهاز توجيه مدفوع بالبيانات يحسن التكلفة/السرعة/الجودة باستخدام معايير حية، يتكيف حسب المنطقة وحمل العمل.

مناسب عندما. تريد اختيارًا موجهًا بالمعايير يتكيف باستمرار مع الأداء الواقعي.

أورك.ai

ما هو. منصة تعاون AI توليدية + LLMOps: تجارب، مقيمون (بما في ذلك مقاييس RAG)، عمليات نشر، وRBAC/VPC. رائعة عندما تحتاج التقييم والحوكمة إلى التواجد معًا.

مناسب عندما. تحتاج إلى التجربة + التقييم مع الحوكمة في مكان واحد—ثم النشر مباشرة من نفس السطح.

LiteLLM

ما هو. وكيل/بوابة مفتوحة المصدر مع نقاط نهاية متوافقة مع OpenAI، ميزانيات وحدود معدلات، تسجيل/قياسات، وواجهة إدارة. انشر عبر Docker/K8s/Helm؛ احتفظ بحركة المرور داخل شبكتك الخاصة.

مناسب عندما. تريد الاستضافة الذاتية والتحكم الكامل بالبنية التحتية مع توافق بسيط مع SDKs الشائعة بأسلوب OpenAI.

أمور يجب الانتباه إليها. كما هو الحال مع أي بوابة OSS، أنت المسؤول عن العمليات والترقيات.

البداية السريعة: قم باستدعاء نموذج في دقائق (ShareAI)

ابدأ في ملعب, ، ثم احصل على مفتاح API وابدأ. المراجع: البداية السريعة لواجهة برمجة التطبيقات • الصفحة الرئيسية للوثائق • الإصدارات.

#!/usr/bin/env bash"

// ShareAI — إكمالات الدردشة (JavaScript، Node 18+);

نصيحة الهجرة. قم بتعيين النماذج التي اخترتها في RouteLLM إلى ما يعادلها في ShareAI، وعاكس أشكال الطلب/الاستجابة، وابدأ خلف علم ميزة. أرسل 5–10% من حركة المرور أولاً، قارن بين التأخير/التكلفة/الجودة، ثم قم بالزيادة. إذا كنت تدير أيضًا بوابة (Portkey/Kong)، تأكد من أن التخزين المؤقت/النسخ الاحتياطي لا يتسبب في تشغيل مزدوج بين الطبقات.

مقارنة بنظرة سريعة

| المنصة | مستضاف / استضافة ذاتية | التوجيه والاستبدالات | المراقبة | الشمولية (LLM + ما بعده) | الحوكمة / السياسة | ملاحظات |

|---|---|---|---|---|---|---|

| روتLLM | البرمجيات مفتوحة المصدر | جهاز توجيه متعلم؛ عميل/خادم متوافق مع OpenAI | CLI/سجلات؛ تركيز على البحث | مركزية LLM | السياسة عبر بنيتك التحتية | رائع لتوفير التكاليف على مستوى البحث؛ اجلب أدوات التحكم الخاصة بك. |

| شاركAI | مستضاف + شبكة مزودين | فشل فوري؛ اختيار موجه بالسوق | سجلات الاستخدام؛ إحصائيات السوق | كتالوج نماذج واسع | ضوابط على مستوى المزود | سوق مدعوم من الناس؛ ابدأ بـ ملعب و النماذج. |

| إدن AI | مستضاف | تبديل المزودين؛ دفعة؛ التخزين المؤقت | مراقبة التكلفة وواجهة برمجة التطبيقات | LLM + صورة + OCR + صوت + ترجمة | الفوترة المركزية/إدارة المفاتيح | منسق متعدد الوسائط. |

| أوبن راوتر | مستضاف | توجيه المزود/النموذج؛ تخزين مؤقت للمطالبات؛ ثبات المزود | معلومات على مستوى الطلب | مركزية LLM | سياسات المزود | إعادة استخدام التخزين المؤقت؛ الرجوع عند عدم التوفر. |

| بورتكي | بوابة مستضافة | سياسات الرجوع؛ كتيبات حدود المعدل؛ تخزين مؤقت دلالي | التتبع/المقاييس | LLM أولاً | إعدادات البوابة | حواجز حماية بأسلوب SRE. |

| كونغ AI جيتواي | استضافة ذاتية/مؤسسة | التوجيه العلوي عبر مكونات AI الإضافية | المقاييس/التدقيق عبر Kong | LLM أولاً | حوكمة قوية للحافة | مكون البنية التحتية؛ يقترن بالموجهات/الأسواق. |

| توحيد | مستضاف | توجيه مدفوع بالبيانات حسب التكلفة/السرعة/الجودة | مستكشف المعايير | مركزية LLM | سياسات الموجه | اختيار موجه بالمقارنة. |

| أورك.ai | مستضاف | إعادة المحاولات/البدائل في التنسيق | تحليلات المنصة؛ مقيمو RAG | LLM + RAG + التقييمات | خيارات RBAC/VPC | التركيز على التعاون والتجربة. |

| LiteLLM | استضافة ذاتية/OSS | إعادة المحاولة/الرجوع؛ الميزانيات/الحدود | تسجيل/القياسات؛ واجهة المستخدم الإدارية | مركزية LLM | التحكم الكامل في البنية التحتية | متوافق مع OpenAI؛ نشر Docker/K8s/Helm. |

الأسئلة الشائعة: RouteLLM مقابل البقية

RouteLLM مقابل ShareAI — أيهما أفضل؟

اختر شاركAI إذا كنت تريد سوقًا شفافًا يظهر السعر/الزمن/الجاهزية/التوافر قبل كل مسار، بالإضافة التبديل الفوري والاقتصاد المتوافق مع الباني. اختر روتLLM إذا كنت تفضل جهاز توجيه يعتمد على البحث وتكون مرتاحًا لتشغيل البنية التحتية حوله (البوابات، التسجيل، التدقيق). ابدأ بـ ملعب و سوق النماذج.

RouteLLM مقابل Eden AI — ما الفرق؟

إدن AI يمتد عبر LLMs و متعدد الوسائط (الرؤية/OCR، الصوت، الترجمة) مع المقارنة والمراقبة. روتLLM يركز على التوجيه المتعلم لـ LLMs. إذا كانت خارطة الطريق الخاصة بك تحتاج إلى OCR/الصوت/الترجمة تحت واجهة برمجة تطبيقات واحدة، فإن Eden AI يبسط التسليم؛ إذا كانت أبحاث التوجيه هي الأولوية، فإن RouteLLM يناسب. قم بالاقتران مع ShareAI عندما تريد شفافية السوق لكل طلب.

RouteLLM مقابل OpenRouter — متى تختار كل منهما؟

اختر أوبن راوتر متى تخزين المؤقت للمطالبات وإعادة استخدام ذاكرة التخزين المؤقت الدافئة مهمة (تميل إلى إبقائك على نفس المزود، وتعود إلى الخلف في حالات الانقطاع). اختر روتLLM للسياسات المتعلمة التي تديرها بنفسك. العديد من المجموعات تقرن OpenRouter ببوابة للسياسة/المراقبة—ولا تزال تستخدم ShareAI عندما يريدون شفافية السوق قبل كل مسار.

RouteLLM مقابل Portkey — جهاز توجيه أم بوابة؟

روتLLM هو جهاز توجيه. بورتكي هو بوابة: يتفوق في السياسة/الضوابط (كتب اللعب الاحتياطية، ذاكرة التخزين المؤقت الدلالية) وتتبع دقيق/مقاييس. العديد من الفرق تستخدم كلاهما: بوابة لسياسة المنظمة + جهاز توجيه/سوق لاختيار النموذج والتحكم في التكلفة. يتناسب ShareAI جيدًا هنا عندما تريد رؤية السوق قبل المسار.

RouteLLM مقابل Kong AI Gateway — من يحتاج إلى أيهما؟

اختر كونغ AI جيتواي متى حوكمة الحافة (السياسة المركزية/التدقيق، إقامة البيانات) غير قابلة للتفاوض. احتفظ روتLLM خلفه إذا كنت لا تزال تريد توجيهًا متعلمًا للسعر/الأداء. استخدم شاركAI جنبًا إلى جنب عندما تريد اختيار مقدمي الخدمة بواسطة السعر/الزمن/الجاهزية/التوافر قبل كل مسار.

RouteLLM مقابل Unify — ما الذي يميز Unify؟

توحيد يستخدم معايير حية وسياسات ديناميكية لتحسين التكلفة/السرعة/الجودة. إذا كنت تريد اختيارًا يعتمد على البيانات ويتطور حسب المنطقة/عبء العمل، فإن Unify جذاب؛; روتLLM يركز على نماذج التوجيه المتعلمة التي تستضيفها. استخدم شاركAI عندما تفضل اختيار مقدمي الخدمة مع عرض السوق والتبديل الفوري.

RouteLLM مقابل Orq.ai — أيهما للتقييم وRAG؟

أورك.ai يوفر سطحًا للتجربة/التقييم (بما في ذلك مقيمو RAG)، بالإضافة إلى عمليات النشر وRBAC/VPC. إذا كنت بحاجة إلى LLMOps + مقيمين، فقد يكمل Orq.ai أو يحل محل جهاز توجيه خالص في البداية. أحضر شاركAI عندما تريد اختيار مقدمي الخدمة مع شفافية السوق والمرونة في الإنتاج.

RouteLLM مقابل LiteLLM — مستضاف مقابل مستضاف ذاتيًا؟

روتLLM هو منطق التوجيه OSS؛; LiteLLM هو وكيل/بوابة متوافقة مع OpenAI مع ميزانيات، حدود معدلات، وواجهة مستخدم إدارية—رائع إذا كنت تريد إبقاء حركة المرور داخل VPC الخاص بك وامتلاك مستوى التحكم. غالبًا ما تجمع الفرق بين LiteLLM للاستضافة الذاتية مع شاركAI لرؤية السوق والتبديل الفوري عبر مقدمي الخدمة.

أيهما أرخص لعبء عملي: RouteLLM، ShareAI، OpenRouter، LiteLLM؟

يعتمد ذلك على اختيار النموذج، المنطقة، إمكانية التخزين المؤقت، وأنماط المرور. أجهزة التوجيه مثل شاركAI/OpenRouter يمكن أن تقلل التكلفة عبر التوجيه والالتصاق المدرك للتخزين المؤقت؛ بوابات مثل بورتكي إضافة التخزين المؤقت الدلالي؛; LiteLLM يقلل من عبء المنصة إذا كنت مرتاحًا لتشغيله. قم بقياس الأداء باستخدام تعمل المطالبات وتتبع التكلفة الفعالة لكل نتيجة—ليس فقط السعر المعلن.

ما هو RouteLLM؟

إطار عمل مفتوح المصدر لخدمة وتقييم أجهزة توجيه LLM؛ يتضمن أجهزة توجيه مدربة ومسارات متوافقة مع OpenAI؛ يُشار إليه غالبًا لتقليل التكلفة بشكل كبير مع الحفاظ على جودة قريبة من GPT-4 في مهام مشابهة لـ MT-Bench.

ما هي أسرع طريقة لتجربة ShareAI دون تكامل كامل؟

افتح ملعب, ، اختر نموذجًا/مزودًا، وقم بتشغيل المطالبات في المتصفح. عندما تكون جاهزًا،, أنشئ مفتاحًا وأسقط مقتطفات cURL/JS أعلاه في تطبيقك.

هل يمكنني أن أصبح مزودًا لـ ShareAI وأربح؟

نعم. يمكن لأي شخص الانضمام كـ المجتمع أو الشركة المزود باستخدام Windows/Ubuntu/macOS أو Docker. ساهم بفترات الخمول أو قم بتشغيل دائم التشغيل. اختر الحوافز: المكافآت (المال)،, تبادل (الرموز/محترف AI)، أو المهمة (تبرع بنسبة % للمنظمات غير الحكومية). انظر دليل المزود أو افتح لوحة التحكم للمزود.

الخاتمة

بينما روتLLM هو جهاز توجيه OSS قوي، يعتمد اختيارك الأفضل على الأولويات:

- شفافية السوق + المرونة: شاركAI

- تغطية متعددة الوسائط تحت واجهة برمجة تطبيقات واحدة: إدن AI

- التوجيه المدرك للتخزين المؤقت في الشكل المستضاف: أوبن راوتر

- السياسات/الضوابط عند الحافة: Portkey أو Kong AI Gateway

- التوجيه المستند إلى البيانات: توحيد

- LLMOps + المقيمون: أورك.ai

- طائرة التحكم المستضافة ذاتياً: LiteLLM

إذا السعر/الزمن/الجاهزية/التوافر قبل كل مسار،, التبديل الفوري, ، و اقتصاديات متوافقة مع الباني موجودة في قائمة التحقق الخاصة بك، افتح ملعب, إنشاء مفتاح API, ، وتصفح سوق النماذج لتوجيه طلبك التالي بالطريقة الذكية.