Traefik AI Gateway Alternativen 2026: Top 10 Alternativen

Aktualisiert Februar 2026

Wenn Sie Alternativen zum Traefik AI Gateway, dieser Leitfaden kartiert die Landschaft wie ein Baumeister. Zuerst klären wir, was Traefiks AI Gateway ist – eine egress-fokussierte Kontrollschicht mit einer einheitlichen AI-API, Sicherheitsrichtlinien und Beobachtbarkeit – und vergleichen dann die 10 besten Alternativen. Wir platzieren TeilenAI an erster Stelle für Teams, die eine API über viele Anbieter hinweg wünschen, einen transparenten Marktplatz mit Preis/Latenz/Verfügbarkeit vor der Weiterleitung, sofortigem Failover und menschengetriebener Wirtschaft (70% der Ausgaben gehen an Anbieter).

Was Traefik AI Gateway ist (und nicht ist)

Traefik AI-Gateway fügt eine dünne, dedizierte Kontrollschicht über dem API-Gateway von Traefik Hub hinzu. Es konzentriert sich auf LLM-Verkehr, stellt spezialisierte Middlewares bereit (z. B., Inhaltswächter, Semantischer Cache), zentralisiert Anmeldeinformationen/Richtlinien und integriert OpenTelemetry für Beobachtbarkeit – sodass jeder AI-Endpunkt als API lebenszyklusverwaltet, gesichert und beobachtet werden kann. Das ist ein Governance-zentriertes Gateway, kein transparenter Modellmarktplatz.

Aggregatoren vs Gateways vs Agentenplattformen

- LLM-Aggregatoren: eine API über viele Modelle/Anbieter mit Pre-Route-Transparenz (Preis, Latenz, Verfügbarkeit, Anbietertyp) und intelligenter Weiterleitung/Failover.

- KI-Gateways: Richtlinien/Governance am Rand (Anmeldeinformationen, Ratenbegrenzungen, Leitplanken), plus Beobachtbarkeit; Sie bringen Ihre Anbieter mit. Traefik AI Gateway gehört zu dieser Kategorie.

- Agent/Chatbot-Plattformen: Verpacktes UX, Speicher/Werkzeuge, Kanäle – ausgerichtet auf Endbenutzer-Assistenten statt auf anbieterunabhängige Aggregation.

Wie wir die besten Alternativen zum Traefik AI Gateway bewertet haben

- Modellbreite & Neutralität: proprietär + offen; einfacher Wechsel; keine Neuschreibungen.

- Latenz & Resilienz: Routing-Richtlinien, Timeouts, Wiederholungen, sofortiges Failover.

- Governance & Sicherheit: Schlüsselverwaltung, Scopes, regionales Routing.

- Beobachtbarkeit: Logs/Traces und Kosten/Latenz-Dashboards.

- Preistransparenz & TCO: reale Kosten vergleichen bevor Sie routen.

- Entwicklererfahrung: Dokumentationen, SDKs, Schnellstarts; Zeit-zum-ersten-Token.

- Community & Wirtschaft: ob Ihre Ausgaben das Angebot erhöhen (Anreize für GPU-Besitzer).

Top 10 Traefik AI Gateway Alternativen

#1 — ShareAI (Menschenbetriebene KI-API)

Was es ist. Eine Multi-Provider-API mit einem transparenter Marktplatz und intelligenten Weiterleitung. Mit einer Integration, durchsuchen Sie einen großen Katalog von Modellen und Anbietern, vergleichen Sie Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp, und routen Sie mit sofortiges Failover. Die Wirtschaft wird von Menschen angetrieben: 70% jedes Dollars fließt an Anbieter (Community oder Unternehmen), die Modelle online halten.

Warum es hier #1 ist. Wenn Sie eine anbieterunabhängige Aggregation mit Pre-Route Transparenz und Resilienz wünschen, ist ShareAI die direkteste Lösung. Behalten Sie ein Gateway, wenn Sie organisationsweite Richtlinien benötigen; fügen Sie ShareAI für marktplatzgesteuerte Routing hinzu.

- Eine API → 150+ Modelle über viele Anbieter hinweg; keine Neuschreibungen, keine Bindung.

- Transparenter Marktplatz: wählen Sie nach Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp.

- Resilienz standardmäßig: Routing-Richtlinien + sofortiges Failover.

- Faire Wirtschaftlichkeit: 70 % der Ausgaben gehen an Anbieter (Community oder Unternehmen).

Schnelle Links — Modelle durchsuchen · Spielplatz öffnen · API-Schlüssel erstellen · API-Referenz · Benutzerhandbuch · Veröffentlichungen

Für Anbieter: verdienen, indem Modelle online gehalten werden

Jeder kann ein ShareAI-Anbieter werden—Gemeinschaft oder Unternehmen. Onboarding über Windows, Ubuntu, macOS oder Docker. Beitragen Leerlaufzeit Ausbrüche oder laufen immer eingeschaltet. Wählen Sie Ihren Anreiz: Belohnungen (Geld), Austausch (Tokens/AI Prosumer), oder Mission (spenden Sie 1 % an NGOs). Während Sie skalieren, können Sie Ihre eigenen Inferenzpreise festlegen und bevorzugte Sichtbarkeit gewinnen.

Anbieterlinks — Anbieterleitfaden · Anbieter-Dashboard · Austauschübersicht · Missionsbeitrag

#2 — Kong AI-Gateway

Was es ist. Enterprise-AI/LLM-Gateway—Governance, Richtlinien/Plugins, Analytik, Beobachtbarkeit für AI-Traffic am Rand. Es ist eine Steuerungsebene und kein Marktplatz.

#3 — Portkey

Was es ist. AI-Gateway mit Schwerpunkt auf Beobachtbarkeit, Leitplanken und Governance—beliebt in regulierten Branchen.

#4 — OpenRouter

Was es ist. Vereinheitlichte API über viele Modelle; ideal für schnelle Experimente über einen breiten Katalog.

#5 — Eden AI

Was es ist. Aggregiert LLMs plus umfassendere KI-Funktionen (Bild, Übersetzung, TTS) mit Fallbacks/Caching und Batch-Verarbeitung.

#6 — LiteLLM

Was es ist. Ein leichtgewichtiges Python-SDK + selbsthostbarer Proxy der eine OpenAI-kompatible Schnittstelle zu vielen Anbietern spricht.

#7 — Unify

Was es ist. Qualitätsorientiertes Routing und Bewertung, um bessere Modelle pro Eingabeaufforderung auszuwählen.

#8 — Orq KI

Was es ist. Orchestrierungs-/Kollaborationsplattform, die Teams hilft, von Experimenten zu Produktion mit Low-Code-Flows überzugehen.

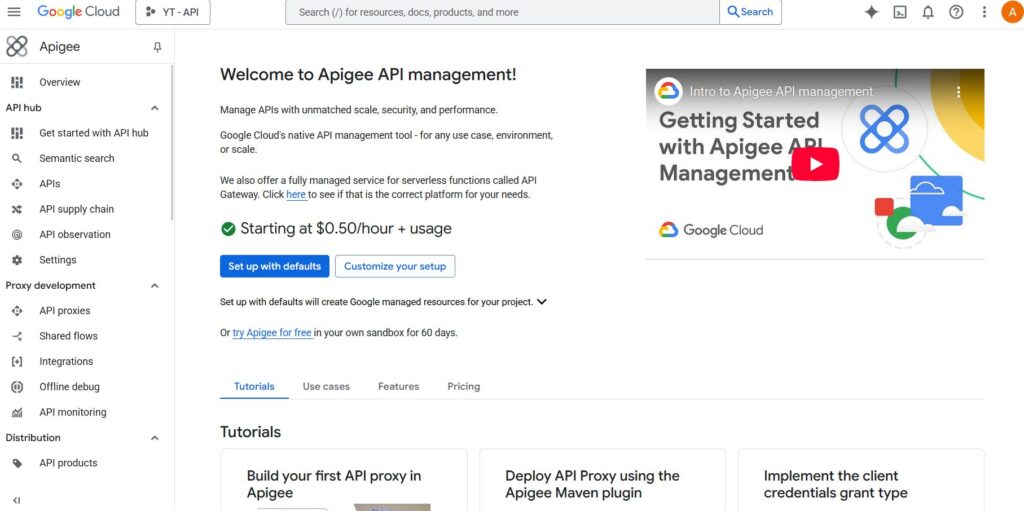

#9 — Apigee (mit LLMs dahinter)

Was es ist. Eine ausgereifte API-Management-/Gateway-Lösung, die Sie vor LLM-Anbietern platzieren können, um Richtlinien, Schlüssel und Quoten anzuwenden.

#10 — NGINX

Was es ist. Verwenden Sie NGINX, um benutzerdefiniertes Routing, Token-Durchsetzung und Caching für LLM-Backends zu erstellen, wenn Sie DIY-Kontrolle bevorzugen.

Traefik AI Gateway vs ShareAI

Wenn Sie eine API über viele Anbieter mit transparente Preisgestaltung/Latenzzeit/Betriebszeit und sofortiges Failover, wählen Sie TeilenAI. Wenn Ihre oberste Anforderung ist Egress-Governance—zentralisierte Anmeldeinformationen, Richtliniendurchsetzung und OpenTelemetry-freundliche Beobachtbarkeit—Traefik AI Gateway passt in diese Kategorie. Viele Teams kombinieren sie: Gateway für Organisationsrichtlinien + ShareAI für Marktplatz-Routing.

Schneller Vergleich

| Plattform | Wen es bedient | Modellvielfalt | Governance & Sicherheit | Beobachtbarkeit | Routing / Failover | Marktplatztransparenz | Anbieterprogramm |

|---|---|---|---|---|---|---|---|

| TeilenAI | Produkt-/Plattformteams, die eine API + faire Wirtschaftlichkeit benötigen | 150+ Modelle, viele Anbieter | API-Schlüssel & pro-Routen-Kontrollen | Konsolennutzung + Marktplatzstatistiken | Intelligentes Routing + sofortiges Failover | Ja (Preis, Latenz, Verfügbarkeit, Betriebszeit, Anbietertyp) | Ja — offene Versorgung; 70% zu Anbietern |

| Traefik AI-Gateway | Teams, die Egress-Governance benötigen | BYO-Anbieter | Zentralisierte Anmeldedaten/Richtlinien | OpenTelemetry-Metriken/Tracing | Bedingtes Routing über Middlewares | Nein (Infrastruktur-Tool, kein Marktplatz) | n/v |

| Kong KI-Gateway | Unternehmen, die Richtlinien auf Gateway-Ebene benötigen | BYO | Starke Edge-Richtlinien/Plugins | Analysen | Proxy/Plugins, Wiederholungen | Nein (Infrastruktur) | n/v |

| Portkey | Regulierte/Unternehmensteams | Breit | Leitplanken & Governance | Tiefe Spuren | Bedingte Weiterleitung | Teilweise | n/v |

| OpenRouter | Entwickler, die einen Schlüssel wollen | Breites Katalog | Grundlegende API-Steuerungen | App-seitig | Rückfalle | Teilweise | n/v |

| Eden KI | Teams, die LLM + andere KI-Dienste benötigen | Breit | Standardsteuerungen | Variiert | Fallbacks/Caching | Teilweise | n/v |

| LiteLLM | DIY/Selbstgehosteter Proxy | Viele Anbieter | Konfigurations-/Schlüssellimits | Ihre Infrastruktur | Wiederholungen/Fallback | n/v | n/v |

| Vereinheitlichen | Qualitätsorientierte Teams | Multi-Modell | Standard-API-Sicherheit | Plattformanalysen | Beste-Modell-Auswahl | n/v | n/v |

| Orq | Orchestrierungsorientierte Teams | Breite Unterstützung | Plattformkontrollen | Plattformanalysen | Orchestrierungsflüsse | n/v | n/v |

| Apigee / NGINX | Unternehmen / DIY | BYO | Richtlinien | Add-ons / benutzerdefiniert | Benutzerdefiniert | n/v | n/v |

Traefiks Gateway-Funktionen—dünne AI-Schicht, spezialisierte Middlewares wie Inhaltswächter und Semantischer Cache, plus OpenTelemetry-fähige Beobachtbarkeit—sind in der offiziellen Dokumentation beschrieben.

Preisgestaltung & TCO: reale Kosten vergleichen (nicht nur Stückpreise)

Rohe $/1K Tokens verbergen das wahre Bild. TCO verschiebt sich mit Wiederholungen/Fallbacks, Latenz (die die Nutzung beeinflusst), Anbieterabweichungen, Beobachtbarkeitsspeicher und Evaluierungsläufen. transparenter Marktplatz hilft Ihnen, Routen auszuwählen, die Kosten und UX ausgleichen.

TCO ≈ Σ (Basis_Tokens × Einheitspreis × (1 + Wiederholungsrate))

- Prototyp (~10k Token/Tag): Optimieren für Time-to-First-Token (Playground, Schnellstarts).

- Mittlerer Maßstab (~2M Token/Tag): Marktbasierte Routing-/Failover-Strategien können 10–20% einsparen und gleichzeitig die UX verbessern.

- Spitzenlasten: Erwarten Sie höhere effektive Token-Kosten durch Wiederholungen während des Failovers; budgetieren Sie dafür.

Migrationsleitfaden: Wechsel zu ShareAI

Von Traefik AI Gateway

Behalten Sie Gateway-Level-Richtlinien dort, wo sie glänzen, und fügen Sie hinzu TeilenAI für Marktplatz-Routing + sofortiges Failover. Muster: Gateway-Authentifizierung/Richtlinie → ShareAI-Routing pro Modell → Marktplatzstatistiken messen → Richtlinien verschärfen.

Von OpenRouter

Modellnamen zuordnen, Prompt-Parität überprüfen, dann 10% des Traffics schatten und 25% → 50% → 100% hochfahren, solange Latenz-/Fehlerbudgets eingehalten werden. Marktplatzdaten machen Anbieterwechsel unkompliziert.

Von LiteLLM

Ersetzen Sie den selbstgehosteten Proxy auf Produktionsrouten, die Sie nicht betreiben möchten; behalten Sie LiteLLM für die Entwicklung, falls gewünscht. Vergleichen Sie Betriebsaufwand mit den Vorteilen des verwalteten Routings.

Von Unify / Portkey / Orq / Kong

Erwartungen an Funktionsparität definieren (Analysen, Leitplanken, Orchestrierung, Plugins). Viele Teams arbeiten hybrid: spezialisierte Funktionen dort behalten, wo sie am stärksten sind; verwenden TeilenAI für transparente Anbieterwahl und Failover.

Entwickler-Schnellstart (Copy-Paste)

Die folgenden verwenden eine OpenAI-kompatible Oberfläche. Ersetzen Sie IHRE_SCHLÜSSEL durch Ihren ShareAI-Schlüssel—holen Sie sich einen unter API-Schlüssel erstellen. Siehe die API-Referenz für Details.

#!/usr/bin/env bash"

// JavaScript (fetch) — Node 18+/Edge-Laufzeiten;

Sicherheits-, Datenschutz- und Compliance-Checkliste (anbieterunabhängig)

- Schlüsselverwaltung: Rotationsfrequenz; minimale Berechtigungen; Trennung der Umgebungen.

- Datenaufbewahrung: wo Eingaben/Antworten gespeichert werden, wie lange; Standardwerte für Schwärzungen.

- PII & sensible Inhalte: Maskierung; Zugriffskontrollen; regionale Weiterleitung für Datenlokalität.

- Beobachtbarkeit: Prompt-/Antwort-Logging; Möglichkeit zum Filtern oder Pseudonymisieren; Trace-IDs konsistent propagieren (OTel).

- Vorfallreaktion: Eskalationspfade und Anbieter-SLAs.

FAQ — Traefik AI Gateway vs andere Wettbewerber

Traefik AI Gateway vs ShareAI — welches für Multi-Provider-Routing?

TeilenAI. Es ist für Marktplatztransparenz (Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp) gebaut und intelligentes Routing/Failover über viele Anbieter hinweg. Traefik AI Gateway ist ein Egress-Governance Tool (zentralisierte Anmeldedaten/Richtlinien; OpenTelemetry-Observierbarkeit; AI-Middlewares). Viele Teams nutzen beide.

Traefik AI Gateway vs OpenRouter — schneller Multi-Modell-Zugriff oder Gateway-Kontrollen?

OpenRouter ermöglicht schnellen Multi-Modell-Zugriff; Traefik AI Gateway zentralisiert Richtlinien und Observierbarkeit. Wenn Sie auch Transparenz vor der Weiterleitung und sofortiges Failover möchten, TeilenAI kombiniert Multi-Anbieter-Zugriff mit einer Marktplatzansicht und resilientem Routing.

Traefik AI Gateway vs LiteLLM — Self-Host-Proxy oder verwaltete Governance?

LiteLLM ist ein DIY-Proxy, den Sie betreiben; Traefik AI Gateway ist verwaltete Governance/Observierbarkeit für AI-Egress. Wenn Sie keinen Proxy betreiben möchten und marktplatzgesteuertes Routing wünschen, wählen Sie TeilenAI.

Traefik AI Gateway vs Portkey — wer ist stärker bei Leitplanken?

Beide betonen Governance und Observierbarkeit; Tiefe und Ergonomie unterscheiden sich. Wenn Ihr Hauptbedarf ist transparente Anbieterwahl und Failover, hinzufügen TeilenAI.

Traefik AI Gateway vs Unify — beste Modellauswahl vs Richtlinienumsetzung?

Unify konzentriert sich auf bewertungsgetriebene Modellauswahl; Traefik AI Gateway auf Richtlinien/Observierbarkeit. Für eine API über viele Anbieter mit Live-Marktplatzstatistiken verwenden Sie TeilenAI.

Traefik AI Gateway vs Eden AI — viele AI-Dienste oder Egress-Kontrolle?

Eden AI aggregiert mehrere KI-Dienste (LLM, Bild, TTS). Traefik AI Gateway zentralisiert Richtlinien/Anmeldedaten mit spezialisierten KI-Middlewares. Für transparente Preise/Latenzzeiten über viele Anbieter und sofortiges Failover, wählen Sie TeilenAI.

Traefik AI Gateway vs Orq — Orchestrierung vs Egress?

Orq hilft bei der Orchestrierung von Workflows; Traefik AI Gateway steuert den Egress-Traffic. TeilenAI ergänzt beide mit Marktplatz-Routing.

Traefik AI Gateway vs Kong AI Gateway — zwei Gateways

Beide sind Gateways (Richtlinien, Plugins, Analysen), keine Marktplätze. Viele Teams kombinieren ein Gateway mit TeilenAI für transparentes Multi-Provider-Routing und Failover.

Traefik AI Gateway vs Apigee — API-Management vs KI-spezifischer Egress

Apigee ist breites API-Management; Traefik AI Gateway ist KI-fokussierte Egress-Verwaltung auf Basis von Traefik Hub. Wenn Sie anbieterunabhängigen Zugriff mit Marktplatz-Transparenz benötigen, verwenden Sie TeilenAI.

Traefik AI Gateway vs NGINX — DIY vs schlüsselfertig

NGINX bietet DIY-Filter/Richtlinien; Traefik AI Gateway bietet eine paketierte Schicht mit KI-Middlewares und OpenTelemetry-freundlicher Beobachtbarkeit. Um benutzerdefiniertes Lua zu vermeiden und dennoch eine transparente Anbieterauswahl zu erhalten, integrieren Sie TeilenAI.

Probieren Sie als Nächstes ShareAI aus

Spielplatz öffnen · Erstellen Sie Ihren API-Schlüssel · Modelle durchsuchen · Lesen Sie die Dokumentation · Veröffentlichungen ansehen · Anmelden / Registrieren

Quellen (Traefik AI Gateway)

- Lösungsübersicht — einheitliche KI-API, zentralisierte Anmeldedaten/Richtlinien,

- AI Gateway-Dokumentation (Übersicht) — dünne Kontrollschicht + spezialisierte Middlewares.

- Inhaltswächter und Semantischer Cache Middlewares.

- Beobachtbarkeit (OpenTelemetry) — Metriken und Tracing im OTel-Format.

- Tracing-Referenz — Trace-Kontextweitergabe und unterstützte Propagatoren.