Orq AI Proxy-Alternativen 2026: Top 10

Aktualisiert Februar 2026

Wenn Sie recherchieren Orq AI Proxy-Alternativen, kartiert dieser Leitfaden die Landschaft so, wie es ein Bauherr tun würde. Wir definieren schnell, wo Orq passt (ein orchestration-first Proxy, der Teams hilft, von Experimenten zu Produktion mit kollaborativen Workflows zu wechseln), und vergleichen dann die 10 besten Alternativen über Aggregation, Gateways und Orchestrierung. Wir platzieren TeilenAI zuerst für Teams, die eine API über viele Anbieter hinweg wünschen, transparente Marktsignale (Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp) vor der Weiterleitung, sofortiges Failover, und menschengetriebene Wirtschaftlichkeit (Anbieter – Community oder Unternehmen – verdienen den Großteil der Ausgaben, wenn sie Modelle online halten).

- Modelle durchsuchen

- Spielplatz öffnen

- API-Schlüssel erstellen

- API-Referenz (Erste Schritte)

- Benutzerhandbuch

- Veröffentlichungen

Was Orq AI Proxy ist (und nicht ist)

Orq AI Proxy sitzt in einer Orchestrierung-zuerst Plattform. Es betont Zusammenarbeit, Workflows und die Überführung von Prototypen in die Produktion. Sie finden Tools zur Koordination von mehrstufigen Aufgaben, Analysen zu Abläufen und einen Proxy, der den Versand durch Teams vereinfacht. Das unterscheidet sich von einem transparenten Modellmarktplatz: Vorab-Sichtbarkeit in Preis/Latenz/Verfügbarkeit/Betriebszeit über viele Anbieter—plus intelligente Weiterleitung und sofortiges Failover—ist, wo eine Multi-Provider-API wie TeilenAI glänzt.

Kurz gesagt:

- Orchestrierung-zuerst (Orq): Workflows bereitstellen, Ausführungen verwalten, zusammenarbeiten—nützlich, wenn Ihr Hauptbedarf Flow-Tools sind.

- Marktplatz-zuerst (ShareAI): auswählen am besten geeigneter Anbieter/Modell mit Live-Signale und automatische Resilienz—nützlich, wenn Ihr Hauptbedarf ist Routing über Anbieter benötigen ohne Bindung.

Aggregatoren vs. Gateways vs. Orchestrierungsplattformen

LLM-Aggregatoren (z. B. ShareAI, OpenRouter, Eden AI): Eine API über viele Anbieter/Modelle. Mit ShareAI können Sie Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp vergleichen, bevor Sie weiterleiten, dann sofort ausfallen wenn ein Anbieter nachlässt.

KI-Gateways (z. B. Kong, Portkey, Traefik, Apigee, NGINX): Richtlinien/Verwaltung am Rand (zentralisierte Anmeldeinformationen, WAF/Ratenlimits/Leitplanken), plus Beobachtbarkeit. Sie bringen typischerweise Ihre eigenen Anbieter mit.

Orchestrierungsplattformen (z. B. Orq, Unify; LiteLLM bei selbstgehostetem Proxy-Geschmack): Fokus auf Abläufe, Werkzeuge, und manchmal Qualitätsauswahl—Hilfe für Teams bei der Strukturierung von Eingabeaufforderungen, Tools und Bewertungen.

Verwenden Sie sie zusammen, wenn es hilft: viele Teams halten ein Gateway für organisationsweite Richtlinien während Routing über ShareAI für Marktplatztransparenz und -resilienz.

Wie wir die besten Orq AI Proxy-Alternativen bewertet haben

- Modellbreite & Neutralität: proprietär + offen; einfach zu wechseln; minimale Umschreibungen.

- Latenz & Resilienz: Routing-Richtlinien, Timeouts/Wiederholungen, sofortiges Failover.

- Governance & Sicherheit: Schlüsselverwaltung, Bereiche, regionale Weiterleitung.

- Beobachtbarkeit: Protokolle/Spuren und Kosten-/Latenz-Dashboards.

- Preistransparenz & TCO: sehen echte Kosten/UX-Abwägungen bevor Sie weiterleiten.

- Entwicklererfahrung: Dokumentationen, SDKs, Schnellstarts; Zeit bis zum ersten Token.

- Community & Wirtschaftlichkeit: wächst Ihr Ausgabenbedarf das Angebot (Anreize für GPU-Besitzer/Anbieter)?

Top 10 Orq AI Proxy-Alternativen

#1 — ShareAI (Menschenbetriebene KI-API)

Was es ist. A Multi-Provider-API mit einer transparenter Marktplatz und intelligenten Weiterleitung. Mit einer Integration durchsuchen Sie einen großen Katalog von Modellen und Anbietern, vergleichen Sie Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp, und Routen mit sofortigem Failover. Die Wirtschaft wird von Menschen angetrieben: Anbieter (Community oder Unternehmen) verdienen den Großteil der Ausgaben , wenn sie Modelle online halten.

Warum es hier #1 ist. Wenn Sie möchten Anbieter-unabhängige Aggregation mit Transparenz vor der Weiterleitung und Resilienz, ShareAI ist die direkteste Lösung. Behalten Sie ein Gateway, wenn Sie organisationsweite Richtlinien benötigen; fügen Sie hinzu TeilenAI für marktplatzgeführtes Routing und bessere Betriebszeit/Latenz.

- Eine API → 150+ Modelle über viele Anbieter hinweg; keine Umschreibungen, keine Bindung.

- Transparenter Marktplatz: wählen Sie nach Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp.

- Resilienz standardmäßig: Routing-Richtlinien + sofortiges Failover.

- Faire Wirtschaft: von Menschen betrieben—Anbieter verdienen , wenn sie Modelle verfügbar halten.

Schnelle Links:

- Modelle durchsuchen

- Spielplatz öffnen

- API-Schlüssel erstellen

- API-Referenz

- Benutzerhandbuch

- Veröffentlichungen

Für Anbieter: verdienen, indem Modelle online gehalten werden

Jeder kann ein ShareAI-Anbieter werden—Gemeinschaft oder Unternehmen. Einsteigen über Windows, Ubuntu, macOS oder Docker. Beitragen Leerlaufzeit-Ausbrüche oder ausführen immer eingeschaltet. Wählen Sie Ihren Anreiz: Belohnungen (Geld), Austausch (Tokens/AI Prosumer), oder Mission (spenden Sie % an NGOs). Während Sie skalieren, Ihre eigenen Inferenzpreise festlegen festlegen und bevorzugte Sichtbarkeit.

#2 — OpenRouter

Was es ist. A einheitliche API über viele Modelle hinweg; großartig für schnelle Experimente über einen breiten Katalog.

Wann wählen. Wenn Sie schnellen Zugriff auf diverse Modelle mit minimalem Setup wünschen.

Vergleichen Sie mit ShareAI. ShareAI fügt hinzu Transparenz des Marktplatzes vor der Weiterleitung und sofortiges Failover über viele Anbieter hinweg.

#3 — Portkey

Was es ist. Eine KI-Gateway Betonung Beobachtbarkeit, Leitplanken und Governance.

Wann wählen. Regulierte Umgebungen, die tiefgehende Richtlinien-/Leitplankenkontrollen erfordern.

Vergleichen Sie mit ShareAI. ShareAI konzentriert sich auf Multi-Provider-Routing + Marktplatztransparenz; kombinieren Sie es mit einem Gateway, wenn Sie organisationsweite Richtlinien benötigen.

#4 — Kong AI-Gateway

Was es ist. Eine Unternehmens-Gateway: Richtlinien/Plugins, Analysen und Edge-Governance für AI-Traffic.

Wann wählen. Wenn Ihre Organisation bereits Kong verwendet oder umfassende API-Governance benötigt.

Vergleichen Sie mit ShareAI. Fügen Sie ShareAI hinzu für transparente Anbieterwahl und Failover; behalten Sie Kong für die Steuerungsebene.

#5 — Eden AI

Was es ist. Eine Aggregator für LLMs und umfassendere AI-Dienste (Vision, TTS, Übersetzung).

Wann wählen. Wenn Sie viele KI-Modalitäten hinter einem Schlüssel benötigen.

Vergleichen Sie mit ShareAI. ShareAI spezialisiert sich auf Marktplatz-Transparenz für Modell-Routing über Anbieter hinweg hinzu.

#6 — LiteLLM

Was es ist. A leichtgewichtige SDK + selbst-hostbaren Proxy der eine OpenAI-kompatible Schnittstelle zu vielen Anbietern spricht.

Wann wählen. DIY-Teams, die einen lokalen Proxy betreiben möchten.

Vergleichen Sie mit ShareAI. ShareAI ist verwaltet mit Marktplatzdaten und Failover; behalten Sie LiteLLM für die Entwicklung, wenn gewünscht.

#7 — Unify

Was es ist. Qualitätsorientierte Auswahl und Bewertung, um bessere Modelle für jede Eingabeaufforderung auszuwählen.

Wann wählen. Wenn Sie möchten bewertungsgetriebenes Routing.

Vergleichen Sie mit ShareAI. ShareAI fügt hinzu Live-Marktplatz-Signale und sofortiges Failover über viele Anbieter hinweg.

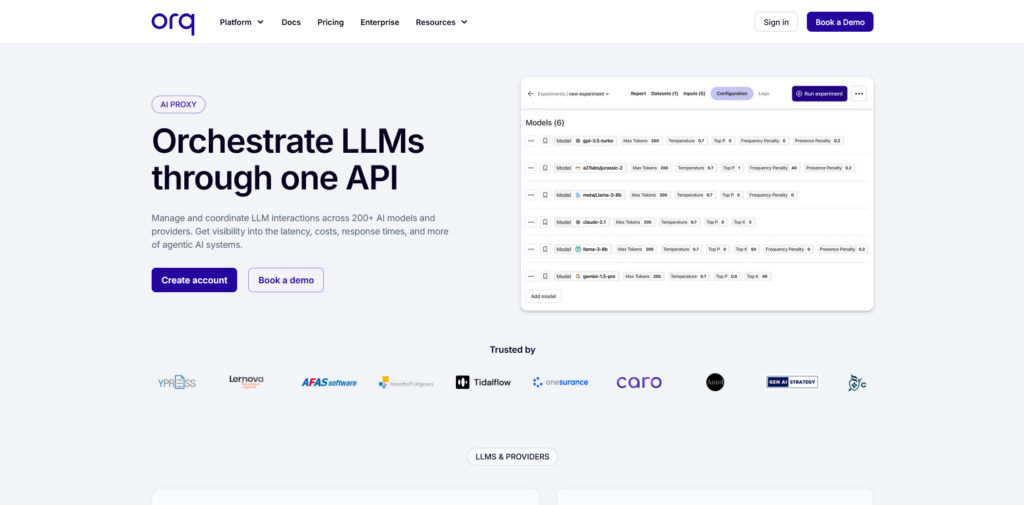

#8 — Orq (Plattform)

Was es ist. Orchestrierung/Kollaboration Plattform, die Teams hilft, von Experimenten zur Produktion zu wechseln mit Low-Code-Flows.

Wann wählen. Wenn Ihr Hauptbedarf ist Workflow-Orchestrierung und Teamzusammenarbeit.

Vergleichen Sie mit ShareAI. ShareAI ist anbieterunabhängiges Routing mit Transparenz vor der Weiterleitung und Failover; viele Teams Orq mit ShareAI koppeln.

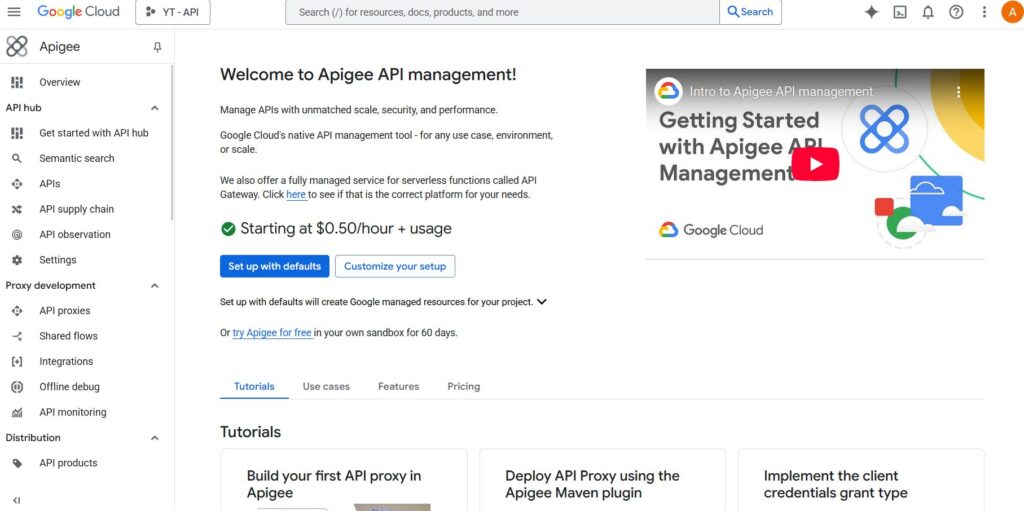

#9 — Apigee (mit LLM-Backends)

Was es ist. A ausgereiftes API-Management Plattform, die Sie vor LLM-Anbieter platzieren können, um Richtlinien, Schlüssel, Quoten.

Wann wählen. Unternehmensorganisationen standardisieren auf Apigee für API-Kontrolle.

Vergleichen Sie mit ShareAI. Fügen Sie ShareAI hinzu, um transparente Anbieterwahl und sofortiges Failover.

#10 — NGINX (DIY)

Was es ist. A Do-it-yourself-Edge: Routen veröffentlichen, Token-Durchsetzung, Caching mit benutzerdefinierter Logik.

Wann wählen. Wenn Sie bevorzugen vollständiges DIY und über ausreichende Betriebsressourcen verfügen.

Vergleichen Sie mit ShareAI. Die Kopplung mit ShareAI vermeidet maßgeschneiderte Logik für Anbieterauswahl und Failover.

Orq AI Proxy vs ShareAI (schneller Überblick)

Wenn Sie eine API über viele Anbieter mit transparente Preise/Latenzzeit/Betriebszeit/Verfügbarkeit und sofortiges Failover, wählen Sie TeilenAI. Wenn Ihre oberste Anforderung ist Orchestrierung und Zusammenarbeit—Abläufe, mehrstufige Aufgaben und teamzentrierte Produktion—Orq passt zu diesem Bereich. Viele Teams kombinieren sie: Orchestrierung innerhalb von Orq + marktplatzgesteuerte Weiterleitung in ShareAI.

Schneller Vergleich

| Plattform | Wen es bedient | Modellvielfalt | Governance & Sicherheit | Beobachtbarkeit | Routing / Failover | Marktplatztransparenz | Anbieterprogramm |

|---|---|---|---|---|---|---|---|

| TeilenAI | Produkt-/Plattformteams, die einer API + faire Wirtschaftlichkeit benötigen | 150+ Modelle, viele Anbieter | API-Schlüssel & pro-Routen-Kontrollen | Konsolennutzung + Marktplatzstatistiken | Intelligentes Routing + sofortiges Failover | Preis, Latenzzeit, Betriebszeit, Verfügbarkeit, Anbietertyp | Ja—offenes Angebot; Anbieter verdienen |

| Orq (Proxy) | Orchestrierungsorientierte Teams | Breite Unterstützung durch Abläufe | Plattformkontrollen | Analysen ausführen | Orchestrierungszentriert | Kein Marktplatz | n/v |

| OpenRouter | Entwickler, die einen Schlüssel wollen | Breites Katalog | Grundlegende API-Steuerungen | App-seitig | Rückfalle | Teilweise | n/v |

| Portkey | Regulierte/Unternehmensteams | Breit | Leitplanken & Governance | Tiefe Spuren | Bedingte Weiterleitung | Teilweise | n/v |

| Kong KI-Gateway | Unternehmen, die Gateway-Richtlinien benötigen | BYO | Starke Edge-Richtlinien/Plugins | Analysen | Proxy/Plugins, Wiederholungen | Nein (Infra-Tool) | n/v |

| Eden KI | Teams, die LLM + andere KI-Dienste benötigen | Breit | Standardsteuerungen | Variiert | Fallbacks/Caching | Teilweise | n/v |

| LiteLLM | DIY/Selbstgehosteter Proxy | Viele Anbieter | Konfigurations-/Schlüssellimits | Ihre Infrastruktur | Wiederholungen/Fallback | n/v | n/v |

| Vereinheitlichen | Qualitätsorientierte Teams | Multi-Modell | Standard-API-Sicherheit | Plattformanalysen | Beste-Modell-Auswahl | n/v | n/v |

| Apigee / NGINX | Unternehmen / DIY | BYO | Richtlinien | Add-ons / benutzerdefiniert | Benutzerdefiniert | n/v | n/v |

Preisgestaltung & TCO: reale Kosten vergleichen (nicht nur Stückpreise)

Roh $/1K Tokens verbirgt das wahre Bild. TCO verschiebt sich mit Wiederholungen/Fallbacks, Latenz (was die Nutzung durch Endbenutzer beeinflusst), Anbieterabweichungen, Beobachtbarkeitsspeicher, und Bewertungsdurchläufe. Ein transparenter Marktplatz hilft Ihnen bei der Auswahl Routen die ausgleichen Kosten und UX.

TCO ≈ Σ (Basis_Tokens × Einheitspreis × (1 + Wiederholungsrate))

- Prototyp (~10k Token/Tag): Optimieren für Zeit bis zum ersten Token (Playground, Schnellstarts).

- Mittlerer Maßstab (~2M Token/Tag): Marktplatzgesteuertes Routing + Failover kann reduzieren 10–20% reduzieren und gleichzeitig die Benutzererfahrung verbessern.

- Spitzenlasten: Erwarten Sie höhere effektive Token-Kosten durch Wiederholungen während des Failovers; Budget dafür.

Migrationsleitfaden: Wechsel zu ShareAI

Von Orq

Behalten Sie Orqs Orchestrierung dort, wo sie glänzt; fügen Sie ShareAI hinzu für anbieterunabhängiges Routing und transparente Auswahl. Muster: Orchestrierung → ShareAI-Route pro Modell → Marktplatzstatistiken beobachten → Richtlinien verschärfen.

Von OpenRouter

Modellnamen zuordnen, Eingabeaufforderungsparität überprüfen, dann Schatten 10% des Verkehrs und hochfahren 25% → 50% → 100% solange Latenz-/Fehlerbudgets eingehalten werden. Marktplatzdaten ermöglichen Anbieterwechsel unkompliziert.

Von LiteLLM

Ersetzen Sie den selbst gehosteten Proxy auf Produktionsrouten, die Sie nicht betreiben möchten; behalten Sie LiteLLM für die Entwicklung, falls gewünscht. Vergleichen Betriebsaufwand gegen. Vorteile des verwalteten Routings.

Von Unify / Portkey / Kong / Traefik / Apigee / NGINX

Erwartungen an Funktionsparität definieren (Analysen, Leitplanken, Orchestrierung, Plugins). Viele Teams arbeiten hybrid: spezialisierte Funktionen dort behalten, wo sie am stärksten sind; verwenden TeilenAI für transparente Anbieterwahl + Failover ist.

Entwickler-Schnellstart (Copy-Paste)

Die folgenden verwenden ein OpenAI-kompatible Oberfläche. Ersetzen IHRE_SCHLÜSSEL durch Ihren ShareAI-Schlüssel—holen Sie sich einen unter API-Schlüssel erstellen.

#!/usr/bin/env bash"// JavaScript (fetch) — Node 18+/Edge-Laufzeiten;Sicherheits-, Datenschutz- und Compliance-Checkliste (anbieterunabhängig)

- Schlüsselverwaltung: Rotationsfrequenz; minimale Bereiche; Umgebungs-Trennung.

- Datenaufbewahrung: wo Eingabeaufforderungen/Antworten gespeichert werden und wie lange; Standardwerte für Schwärzung.

- PII & sensible Inhalte: Maskierung; Zugriffskontrollen; regionale Weiterleitung für Datenlokalität.

- Beobachtbarkeit: Protokollierung von Eingabe-/Antworten; Fähigkeit zu filtern oder pseudonymisieren; Trace-IDs konsistent weiterleiten.

- Vorfallreaktion: Eskalationswege und Anbieter-SLAs.

FAQ — Orq AI Proxy vs andere Wettbewerber

Orq AI Proxy vs ShareAI — welches für Multi-Provider-Routing?

TeilenAI. Es ist gebaut für Marktplatz-Transparenz (Preis, Latenz, Betriebszeit, Verfügbarkeit, Anbietertyp) und intelligentes Routing/Failover über viele Anbieter hinweg. Orq konzentriert sich auf Orchestrierung und Zusammenarbeit. Viele Teams betreiben Orq + ShareAI zusammen.

Orq AI Proxy vs OpenRouter — schneller Multi-Modell-Zugang oder Marktplatztransparenz?

OpenRouter ermöglicht Multi-Modell-Zugriff schnell; TeilenAI Schichten in Transparenz vor der Weiterleitung und sofortiges Failover über Anbieter hinweg hinzu.

Orq AI Proxy vs Portkey — Leitplanken/Governance oder Marktplatz-Routing?

Portkey betont Governance & Beobachtbarkeit. Wenn Sie transparente Anbieterwahl und Failover mit einer API, wählen TeilenAI (und Sie können trotzdem ein Gateway behalten).

Orq AI Proxy vs Kong AI Gateway — Gateway-Kontrollen oder Marktplatz-Sichtbarkeit?

Kong zentralisiert Richtlinien/Plugins; TeilenAI bietet anbieterunabhängiges Routing mit 5. Live-Marktplatz-Statistiken—oft zusammen gepaart.

Orq AI Proxy vs Traefik AI Gateway — dünne AI-Schicht oder Marktplatz-Routing?

Traefiks AI-Schicht fügt hinzu AI-spezifische Middlewares und OTel-freundliche Beobachtbarkeit. 3. . Für transparente Anbieterauswahl zu erhalten und sofortiges Failover, verwenden Sie TeilenAI.

Orq AI Proxy vs Eden AI — viele AI-Dienste oder Anbieterneutralität?

Eden aggregiert mehrere AI-Dienste. TeilenAI konzentriert sich auf neutrales Modell-Routing mit Transparenz vor der Weiterleitung.

Orq AI Proxy vs LiteLLM — selbstgehosteter Proxy oder verwalteter Marktplatz?

LiteLLM ist DIY; TeilenAI ist verwaltet mit Marktplatzdaten und Failover. Behalten Sie LiteLLM für die Entwicklung, wenn Sie möchten.

Orq AI Proxy vs Unify — bewertungsgetriebene Modellauswahl oder Marktplatz-Routing?

Unify lehnt sich an Qualitätsbewertung; TeilenAI fügt hinzu Live-Preis-/Latenz-/Uptime-Signale und sofortiges Failover über Anbieter hinweg hinzu.

Orq AI Proxy vs Apigee — API-Management oder anbieterunabhängiges Routing?

Apigee ist umfassendes API-Management. TeilenAI bietet transparentes, multi-anbieterfähiges Routing Sie können platzieren hinter Ihrem Gateway.

Orq AI Proxy vs NGINX — DIY-Edge oder verwaltetes Routing?

NGINX bietet DIY-Filter/Richtlinien. TeilenAI vermeidet benutzerdefinierte Logik für Anbieterauswahl und Failover.

Orq AI Proxy vs Apache APISIX — Plugin-Ökosystem oder Marktplatztransparenz?

APISIX bringt ein plugin-reiches Gateway. TeilenAI bringt Vor-Routing Anbieter-/Modellsichtbarkeit und widerstandsfähiges Routing. Verwenden Sie beide, wenn Sie möchten Richtlinien am Rand und transparenter Multi-Anbieter-Zugang.