RouteLLM Alternativen 2026: Wann man ShareAI wählen sollte (und was sonst zu beachten ist)

Aktualisiert Februar 2026

Entwickler wählen RouteLLM um Eingabeaufforderungen an günstigere Modelle weiterzuleiten und dabei eine Qualität nahe GPT-4 zu erreichen – insbesondere für benchmarkähnliche Aufgaben, bei denen ein gelernter Router sicher herunterschalten kann. Aber wenn Ihnen mehr an Marktplatztransparenz vor jeder Route (Live-Preis, Latenz, Betriebszeit, Verfügbarkeit) liegt, sofortiges Failover über mehrere Anbieter hinweg,, Edge-Policy und Audit,, oder ein selbstgehosteter Proxy/Gateway, wichtiger sind, RouteLLM-Alternativen, Requesty-Alternativen.

Dieser Einkaufsführer ist so geschrieben, wie es ein Entwickler tun würde: spezifische Kompromisse, schnelle Empfehlungen, tiefgehende Analysen, Gegenüberstellungen und ein Copy-Paste-ShareAI-Quickstart, damit Sie noch heute loslegen können.

Verständnis von RouteLLM (und wo es möglicherweise nicht passt),

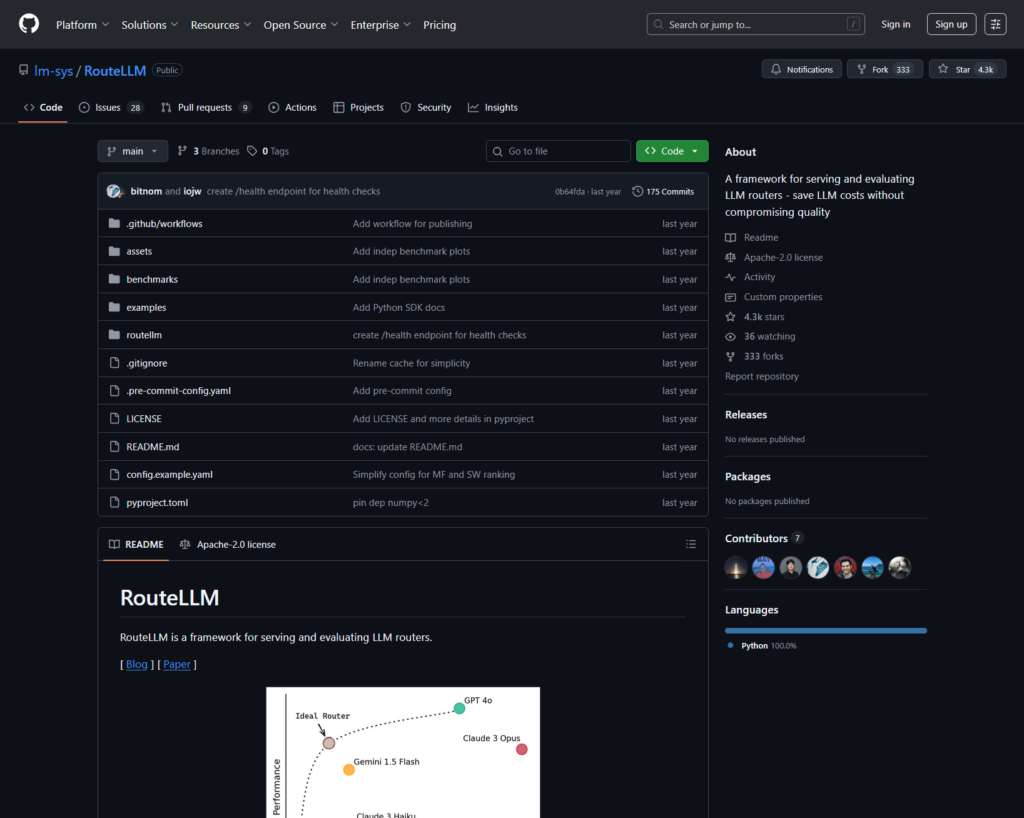

Was RouteLLM ist. RouteLLM ist ein Open-Source-Framework zum Bereitstellen und Bewerten von LLM-Routern. Es bietet einen sofort einsatzbereiten OpenAI-kompatiblen Client/Server und liefert trainierte Routing-Modelle, die einfachere Abfragen an günstigere Modelle weiterleiten können – mit einer gemeldeten Kostenreduktion von bis zu 85% bei gleichzeitiger Beibehaltung von ~95% der GPT-4-Leistung bei gängigen Benchmarks (z. B. MT-Bench).

Warum Teams es wählen.

- Kostenbewusstes Routing, mit forschungsbasierten Richtlinien.

- Open Source, und erweiterbar in Python.

- OpenAI-kompatibel Möglichkeit zum Testen von Routing ohne umfangreiche SDK-Überarbeitungen.

Wo RouteLLM möglicherweise nicht passt.

- Sie möchten Transparenz des Live-Marktplatzes (Preis, Latenz, Betriebszeit, Verfügbarkeit) vor jeder Route – nicht nur eine erlernte Richtlinie.

- Sie benötigen Multi-Provider-Failover

- Ihre Roadmap umfasst multimodale APIs wie OCR, Sprache, Übersetzung und Dokumentenverarbeitung unter einem Dach.

Wie man eine RouteLLM-Alternative wählt

- Gesamtkosten des Eigentums (TCO). Hören Sie nicht bei $/1K Tokens auf. Berücksichtigen Sie Cache-Trefferquoten, Wiederholungen/Fallbacks, Warteschlangen, Evaluator-Kosten und die Betriebsbelastung durch Protokolle/Alarme. Cache-bewusste Router und Gateways mit semantischem Cache können einen “teureren Listenpreis” in der Praxis günstiger machen.

- Latenz & Zuverlässigkeit. Bevorzugen Sie regionsbewusstes Routing, Anbieter-Stickiness, wenn ein Cache warm ist, und präzise Fallbacks (429er erneut versuchen, bei Timeouts eskalieren). Gehostete Router, die Sie beim gleichen Anbieter für warme Kontexte halten und zurückfallen, wenn ein Anbieter ausfällt, tendieren dazu, zu gewinnen.

- Beobachtbarkeit & Governance. Wenn Leitplanken, Redaktion, Prüfprotokolle und Richtlinien am Rand wichtig sind, ist ein KI-Gateway (Portkey oder Kong AI Gateway) typischerweise stärker als ein reiner Router allein. Viele Teams kombinieren Router + Gateway.

- Selbst gehostet vs. verwaltet. Bevorzugen Sie Docker/K8s/Helm und einen OpenAI-kompatiblen Proxy? Probieren Sie LiteLLM. Möchten Sie gehostete Geschwindigkeit + Marktplatzsichtbarkeit? Erwägen Sie ShareAI oder OpenRouter.

- Breite über den Chat hinaus. Wenn Sie OCR, Sprache, Übersetzung oder Dokumentenverarbeitung neben LLM-Chat benötigen, hilft ein multimodaler Orchestrator wie Eden AI.

- Datengetriebene Weiterleitung. Wenn Sie Live-Benchmarks bevorzugen, um Kosten/Geschwindigkeit/Qualität nach Region oder Arbeitslast zu steuern, evaluieren Sie Unify.

Beste RouteLLM-Alternativen (schnelle Auswahl)

ShareAI (unsere Wahl für Marktplatztransparenz + Erbauerökonomie)

Eine API über einen großen Katalog von Modellen/Anbietern mit sofortigem Failover und einem Marktplatz, der Preis, Latenz, Betriebszeit, Verfügbarkeit bevor Sie weiterleiten. Starten Sie schnell in der Spielplatz, greifen Sie Schlüssel in der Konsole, durchsuchen Sie Dokumentation, und vergleichen Sie Optionen in Modelle.

Eden AI (multimodaler Orchestrator)

Einheitliche API über LLMs hinweg plus Bild, OCR/Dokumenten-Parsing, Sprache und Übersetzung – zusammen mit Modellvergleich, Überwachung, Caching und Batch-Verarbeitung.

OpenRouter (cache-bewusste Weiterleitung)

Gehosteter Router über viele LLMs mit Prompt-Caching und Anbieterbindung zur Wiederverwendung warmer Kontexte; wechselt zurück, wenn ein Anbieter nicht verfügbar ist.

Portkey (Richtlinien- & SRE-Operationen am Gateway)

KI-Gateway mit programmierbaren Fallbacks, Playbooks zur Ratenbegrenzung und semantischem Cache – plus detaillierte Traces/Metriken für die Produktionskontrolle.

Kong AI Gateway (Edge-Governance & Audit)

Bringen Sie KI-Plugins, Richtlinien und Analysen in das Kong-Ökosystem; eine starke Lösung, wenn Sie zentralisierte Edge-Kontrollen über Teams hinweg benötigen.

Unify (datengetriebener Router)

Universelle API mit Live-Benchmarks zur Optimierung von Kosten/Geschwindigkeit/Qualität nach Region und Arbeitslast.

Orq.ai (Experimentierung & LLMOps)

Experimente, Evaluatoren (einschließlich RAG-Metriken), Bereitstellungen und RBAC/VPC—ideal, wenn Evaluierung und Governance zusammengeführt werden müssen.

LiteLLM (selbstgehosteter Proxy/Gateway)

Open-Source, OpenAI-kompatibler Proxy mit Budgets/Limits, Logging/Metriken und einer Admin-Benutzeroberfläche. Bereitstellung mit Docker/K8s/Helm; Sie übernehmen den Betrieb.

Tiefgehende Analysen: Top-Alternativen zu RouteLLM

ShareAI (Menschenbetriebene KI-API)

Was es ist. Ein Anbieter-zentriertes KI-Netzwerk und eine einheitliche API. Durchsuchen Sie einen großen Katalog von Modellen/Anbietern und routen Sie mit sofortigem Failover. Der Marktplatz zeigt Preis, Latenz, Verfügbarkeit und Betriebszeit an einem Ort, sodass Sie vor jeder Route den richtigen Anbieter auswählen können. Starten Sie im Spielplatz, erstellen Sie Schlüssel im Konsole, und folgen Sie dem API-Quickstart in Dokumentation. Durchsuchen Sie die Modell-Marktplatz.

- Marktplatztransparenz — sehen Sie Preis/Latenz/Betriebszeit/Verfügbarkeit auf einen Blick.

- Resilienz-als-Standard — schnelles Failover zum nächstbesten Anbieter, wenn einer ausfällt.

- Erbauer-ausgerichtete Wirtschaftlichkeit — der Großteil der Ausgaben fließt an GPU-Anbieter, die Modelle online halten.

- Reibungsloser Start — testen Sie im Playground und liefern Sie dann aus.

Anbieter-Fakten (verdienen durch das Online-Halten von Modellen). Jeder kann Anbieter werden (Community oder Unternehmen). Onboarding über Windows/Ubuntu/macOS oder Docker. Tragen Sie Burst-Zeiten im Leerlauf bei oder betreiben Sie immer aktiv. Wählen Sie Anreize: Belohnungen (Geld), Austausch (Tokens/AI Prosumer) oder Mission (spenden Sie % an NGOs). Sehen Sie die Anbieterleitfaden oder öffnen Sie die Anbieter-Dashboard.

Ideal für. Produktteams, die Marktplatztransparenz, Resilienz und Raum für Wachstum in den Providermodus wünschen – ohne Anbieterbindung.

Eden KI

Was es ist. Eine einheitliche API, die LLMs + Bildgenerierung + OCR/Dokumentenparsing + Sprache + Übersetzung umfasst, sodass Sie nicht mehrere Anbieter-SDKs zusammenfügen müssen. Sie betonen auch Modellvergleich, Überwachung und Batch-Verarbeitung.

Gute Passform, wenn. Ihre Roadmap ist multimodal und Sie möchten OCR/Sprache/Übersetzung neben LLM-Chat orchestrieren.

Vorsicht. Wenn Sie ein Marktplatzansicht pro Anfrage (Preis/Latenzzeit/Betriebszeit/Verfügbarkeit) oder Anbieterökonomie auf Marktplatzebene, kombinieren Sie einen Marktplatz-Router wie ShareAI.

OpenRouter

Was es ist. Ein einheitlicher LLM-Router mit Anbieter-/Modell-Routing und Prompt-Caching. Mit aktiviertem Caching neigt OpenRouter dazu, Sie beim gleichen Anbieter zu halten, um warme Kontexte wiederzuverwenden; wenn dieser Anbieter nicht verfügbar ist, erfolgt ein Fallback. Es unterstützt auch Strategiehinweise (z. B. preisgewichtete).

Gute Passform, wenn. Sie möchten gehostete Geschwindigkeit und cache-bewusstes Routing, um Kosten zu senken und den Durchsatz zu verbessern – insbesondere bei hochfrequenten Chat-Workloads mit wiederholten Eingabeaufforderungen.

Vorsicht. Für tiefgehende Unternehmens-Governance (SIEM-Exporte, organisationsweite Richtlinien) kombinieren viele Teams OpenRouter mit Portkey oder Kong AI Gateway.

Portkey

Was es ist. Ein AI-Gateway mit programmierbaren Fallbacks, Playbooks zur Ratenbegrenzung und einfachem/semantischem Cache sowie Traces/Metriken für SRE-ähnliche Kontrolle. Semantischer Cache ist besonders hilfreich für kurze Eingabeaufforderungen/Nachrichten, wenn Ähnlichkeitsschwellen gut abgestimmt sind.

Gute Passform, wenn. Sie benötigen richtliniengesteuertes Routing mit erstklassiger Beobachtbarkeit und sind in der Lage, eine Gateway-Schicht vor einem oder mehreren Routern/Marktplätzen zu betreiben.

Kong KI-Gateway

Was es ist. Ein Edge-Gateway, das AI-Plugins, Richtlinien und Analysen in das Kong-Ökosystem einbringt (über Konnect oder selbstverwaltet). Wenn Ihre API-Plattform bereits um Kong herum aufgebaut ist und Sie zentrale Richtlinien/Audits benötigen, ist dies eine gute Wahl.

Gute Passform, wenn. Edge-Governance, Prüfungsfähigkeit, Datenresidenz und zentrale Kontrollen sind in Ihrer Umgebung unverzichtbar.

Vereinheitlichen

Was es ist. Ein datengetriebener Router, der Kosten/Geschwindigkeit/Qualität mithilfe von Live-Benchmarks optimiert und sich nach Region und Workload anpasst.

Gute Passform, wenn. Sie möchten eine benchmarkgesteuerte Auswahl, die sich kontinuierlich an die reale Leistung anpasst.

Orq.ai

Was es ist. Eine generative KI-Kollaborations- + LLMOps-Plattform: Experimente, Evaluatoren (einschließlich RAG-Metriken), Bereitstellungen und RBAC/VPC. Hervorragend geeignet, wenn Bewertung und Governance zusammengeführt werden müssen.

Gute Passform, wenn. Sie benötigen Experimente + Evaluierung mit Governance an einem Ort – und können dann direkt von derselben Oberfläche aus bereitstellen.

LiteLLM

Was es ist. Ein Open-Source-Proxy/Gateway mit OpenAI-kompatiblen Endpunkten, Budgets & Ratenlimits, Logging/Metriken und einer Admin-Benutzeroberfläche. Bereitstellung über Docker/K8s/Helm; halten Sie den Datenverkehr in Ihrem eigenen Netzwerk.

Gute Passform, wenn. Sie möchten Self-Hosting und vollständige Infrastrukturkontrolle mit einfacher Kompatibilität für beliebte OpenAI-ähnliche SDKs.

Vorsicht. Wie bei jedem OSS-Gateway sind Sie für Betrieb und Upgrades verantwortlich.

Schnellstart: Modell in Minuten aufrufen (ShareAI)

Starten Sie in der Spielplatz, dann holen Sie sich einen API-Schlüssel und legen los. Referenzen: API-Schnellstart • Docs Startseite • Veröffentlichungen.

#!/usr/bin/env bash"

// ShareAI — Chat Completions (JavaScript, Node 18+);

Migrationstipp. Ordnen Sie Ihre aktuellen, von RouteLLM ausgewählten Modelle den entsprechenden ShareAI-Modellen zu, spiegeln Sie die Anfrage-/Antwortformate und starten Sie hinter einem Feature-Flag. Senden Sie zunächst 5–10% des Datenverkehrs, vergleichen Sie Latenz/Kosten/Qualität und erhöhen Sie dann. Wenn Sie auch ein Gateway (Portkey/Kong) betreiben, stellen Sie sicher, dass Caching/Fallbacks nicht zwischen den Schichten doppelt ausgelöst werden.

Vergleich auf einen Blick

| Plattform | Gehostet / Selbst-Hosting | Routing & Fallbacks | Beobachtbarkeit | Breite (LLM + darüber hinaus) | Governance / Richtlinien | Notizen |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Gelerntes Routing; OpenAI-kompatibler Client/Server | CLI/Logs; Forschungsschwerpunkt | LLM-zentriert | Richtlinien über Ihre Infrastruktur | Ideal für forschungsorientierte Kosteneinsparungen; bringen Sie Ihre eigenen Edge-Kontrollen mit. |

| TeilenAI | Gehostet + Providernetzwerk | Sofortiges Failover; marktplatzgesteuerte Auswahl | Nutzungsprotokolle; Marktplatzstatistiken | Breiter Modellkatalog | Anbieterbezogene Steuerungen | Menschenbetriebener Marktplatz; beginnen Sie mit Spielplatz und Modelle. |

| Eden KI | Gehostet | Anbieter wechseln; Batch; Caching | Kosten- und API-Überwachung | LLM + Bild + OCR + Sprache + Übersetzung | Zentrale Abrechnung/Schlüsselverwaltung | Multimodaler Orchestrator. |

| OpenRouter | Gehostet | Anbieter-/Modell-Routing; Prompt-Caching; Anbieter-Bindung | Anforderungsbezogene Informationen | LLM-zentriert | Anbieter-Richtlinien | Cache-Wiederverwendung; Rückgriff bei Nichtverfügbarkeit. |

| Portkey | Gehostetes Gateway | Richtlinien-Fallbacks; Playbooks zur Ratenbegrenzung; semantischer Cache | Traces/Metriken | LLM-zuerst | Gateway-Konfigurationen | SRE-ähnliche Schutzmaßnahmen. |

| Kong KI-Gateway | Selbst-Hosting/Unternehmen | Upstream-Routing über AI-Plugins | Metriken/Audit über Kong | LLM-zuerst | Starke Edge-Governance | Infrastrukturkomponente; kombiniert mit Routern/Marktplätzen. |

| Vereinheitlichen | Gehostet | Datengetriebenes Routing nach Kosten/Geschwindigkeit/Qualität | Benchmark-Explorer | LLM-zentriert | Router-Richtlinien | Benchmark-gesteuerte Auswahl. |

| Orq.ai | Gehostet | Wiederholungen/Fallbacks in der Orchestrierung | Plattformanalysen; RAG-Bewerter | LLM + RAG + Bewertungen | RBAC/VPC-Optionen | Fokus auf Zusammenarbeit & Experimente. |

| LiteLLM | Selbst-Hosting/OSS | Wiederholen/Fallback; Budgets/Limits | Protokollierung/Metriken; Admin-UI | LLM-zentriert | Volle Infrastrukturkontrolle | OpenAI-kompatibel; Docker/K8s/Helm-Bereitstellung. |

FAQs: RouteLLM vs. der Rest

RouteLLM vs. ShareAI — welches ist besser?

Wählen TeilenAI wenn Sie einen transparenten Marktplatz möchten, der aufzeigt Preis/Latenz/Verfügbarkeit/Betriebszeit vor jeder Route, plus sofortiges Failover und wirtschaftlich abgestimmt auf den Builder. Wählen RouteLLM wenn Sie einen forschungsgetriebenen, lernenden Router bevorzugen und mit der Infrastruktur (Gateways, Logging, Audit) vertraut sind. Beginnen Sie mit dem Spielplatz und Modell-Marktplatz.

RouteLLM vs Eden AI — was ist der Unterschied?

Eden KI umfasst LLMs und multimodal (Vision/OCR, Sprache, Übersetzung) mit Vergleich und Überwachung. RouteLLM konzentriert sich auf lernendes Routing für LLMs. Wenn Ihre Roadmap OCR/Sprache/Übersetzung unter einer API benötigt, vereinfacht Eden AI die Bereitstellung; wenn Routing-Forschung Priorität hat, passt RouteLLM. Kombinieren Sie es mit ShareAI, wenn Sie Marktplatztransparenz pro Anfrage wünschen.

RouteLLM vs OpenRouter — wann sollte man welches wählen?

Wählen OpenRouter wann Prompt-Caching und Wiederverwendung von Warm-Cache sind wichtig (es neigt dazu, Sie beim selben Anbieter zu halten und bei Ausfällen zurückzufallen). Wählen RouteLLM für lernende Richtlinien, die Sie selbst betreiben. Viele Stacks kombinieren OpenRouter mit einem Gateway für Richtlinien/Beobachtbarkeit – und nutzen dennoch ShareAI, wenn sie Marktplatztransparenz vor jeder Route wünschen.

RouteLLM vs Portkey — Router oder Gateway?

RouteLLM ist ein Router. Portkey ist ein Gateway: es glänzt bei Richtlinien/Schutzmaßnahmen (Fallback-Playbooks, semantischer Cache) und detaillierten Spuren/Metriken. Viele Teams nutzen beides: ein Gateway für organisationsweite Richtlinien + einen Router/Marktplatz für Modellwahl und Kostenkontrolle. ShareAI passt hier gut, wenn Sie Marktplatzsichtbarkeit vor der Route wünschen.

RouteLLM vs Kong AI Gateway — wer braucht was?

Wählen Kong KI-Gateway wann Edge-Governance (zentralisierte Richtlinien/Audit, Datenresidenz) ist nicht verhandelbar. Behalten RouteLLM dahinter, wenn Sie weiterhin lernendes Routing für Preis/Leistung wünschen. Verwenden TeilenAI zusammen mit, wenn Sie Anbieter auswählen möchten nach Preis/Latenz/Verfügbarkeit/Betriebszeit vor jeder Route.

RouteLLM vs Unify — was ist einzigartig an Unify?

Vereinheitlichen verwendet Live-Benchmarks und dynamische Richtlinien zur Optimierung für Kosten/Geschwindigkeit/Qualität. Wenn Sie eine datengesteuerte Auswahl wünschen, die sich nach Region/Arbeitslast entwickelt, ist Unify überzeugend; RouteLLM konzentriert sich auf erlernte Routing-Modelle, die Sie hosten. Verwenden Sie TeilenAI wenn Sie Anbieter mit einer Marktübersicht und sofortigem Failover auswählen möchten.

RouteLLM vs Orq.ai — welches für Evaluation & RAG?

Orq.ai bietet eine Experimentier-/Evaluierungsoberfläche (einschließlich RAG-Evaluatoren) sowie Bereitstellungen und RBAC/VPC. Wenn Sie LLMOps + Evaluatoren benötigen, kann Orq.ai frühzeitig einen reinen Router ergänzen oder ersetzen. Bringen Sie TeilenAI wenn Sie Anbieterauswahl mit Markttransparenz und Resilienz in der Produktion wünschen.

RouteLLM vs LiteLLM — gehostet vs selbst gehostet?

RouteLLM ist OSS-Routing-Logik; LiteLLM ist ein OpenAI-kompatibler Proxy/Gateway mit Budgets, Ratenlimits und einer Admin-Benutzeroberfläche – ideal, wenn Sie den Datenverkehr in Ihrem VPC halten und die Steuerungsebene besitzen möchten. Teams kombinieren oft LiteLLM für Selbsthosting mit TeilenAI für Markttransparenz und sofortiges Failover über Anbieter hinweg.

Welches ist am günstigsten für meine Arbeitslast: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Es hängt von der Modellwahl, Region, Cachefähigkeit und Verkehrsmustern ab. Router wie ShareAI/OpenRouter können Kosten durch Routing und cache-bewusste Stickiness reduzieren; Gateways wie Portkey fügen semantisches Caching hinzu; LiteLLM reduzieren den Plattform-Overhead, wenn Sie sich mit dem Betrieb wohlfühlen. Benchmarken Sie mit läuft Ihre Eingabeaufforderungen und verfolgen die effektiven Kosten pro Ergebnis—nicht nur den Listenpreis.

Was ist RouteLLM?

Ein Open-Source-Framework zum Bereitstellen und Evaluieren von LLM-Routern; liefert trainierte Router und OpenAI-kompatible Pfade; wird oft zitiert, um die Kosten erheblich zu senken und gleichzeitig eine Qualität nahe GPT-4 bei Aufgaben wie MT-Bench zu halten.

Was ist der schnellste Weg, ShareAI ohne vollständige Integration auszuprobieren?

Öffnen Sie die Spielplatz, wählen Sie ein Modell/Anbieter aus und führen Sie Eingabeaufforderungen im Browser aus. Wenn bereit, erstellen Sie einen Schlüssel und fügen Sie die oben genannten cURL/JS-Snippets in Ihre App ein.

Kann ich ein ShareAI-Anbieter werden und verdienen?

Ja. Jeder kann sich als Gemeinschaft oder Unternehmen Anbieter mit Windows/Ubuntu/macOS oder Docker. Tragen Sie bei Leerlaufzeit Ausbrüche oder laufen immer eingeschaltet. Wählen Sie Anreize: Belohnungen (Geld), Austausch (Tokens/AI Prosumer), oder Mission (spenden Sie % an NGOs). Siehe die Anbieterleitfaden oder öffnen Sie die Anbieter-Dashboard.

Fazit

Während RouteLLM ist ein starker OSS-Router, Ihre beste Wahl hängt von den Prioritäten ab:

- Marktplatztransparenz + Resilienz: TeilenAI

- Multimodale Abdeckung unter einer API: Eden KI

- Cache-bewusstes Routing in gehosteter Form: OpenRouter

- Richtlinien/Leitplanken am Edge: Portkey oder Kong AI Gateway

- Datengetriebenes Routing: Vereinheitlichen

- LLMOps + Evaluatoren: Orq.ai

- Selbstgehostete Steuerungsebene: LiteLLM

Wenn Preis/Latenz/Verfügbarkeit/Betriebszeit vor jeder Route, sofortiges Failover, und wirtschaftliche Ausrichtung auf den Ersteller stehen auf Ihrer Checkliste, öffnen Sie die Spielplatz, erstellen Sie einen API-Schlüssel, und durchsuchen Sie die Modell-Marktplatz , um Ihre nächste Anfrage auf intelligente Weise zu leiten.