Alternativas a Portkey 2026: Portkey vs ShareAI

Actualizado en febrero 2026

Si estás buscando un Alternativa a Portkey, esta guía compara opciones como lo haría un constructor: a través de enrutamiento, gobernanza, observabilidad y costo total (no solo titulares de $/1K tokens). Comenzamos aclarando qué es Portkey, luego clasificamos las mejores alternativas con criterios, consejos de migración y un inicio rápido de copiar y pegar para ShareAI.

TL;DR — Si quieres una API entre muchos proveedores, datos transparentes previos al enrutamiento (precio, latencia, tiempo de actividad, disponibilidad, tipo de proveedor), y conmutación por error instantánea, comienza con ShareAI. Mantén una puerta de enlace si necesitas políticas a nivel organizacional; agrega ShareAI para enrutamiento guiado por el mercado.

Qué es (y qué no es) Portkey

Portkey es una puerta de enlace de IA centrada en gobernanza (políticas/guías), observabilidad (rastros/registros) y herramientas para desarrolladores para operar tráfico LLM en tu borde—centralizando claves, políticas y protecciones. Eso es poderoso para el cumplimiento y la confiabilidad, pero es no un modelo transparente mercado y no proporciona de forma nativa un lado de oferta impulsado por personas.

Agregadores vs Gateways vs plataformas de agentes

- Agregadores LLM: Una API sobre muchos modelos/proveedores, con transparencia previa a la ruta (precio, latencia, tiempo de actividad, disponibilidad, tipo de proveedor) y funciones integradas enrutamiento inteligente/failover.

- Gateways de IA: Política/gobernanza en el borde (credenciales, límites de tasa, barandillas) + observabilidad; tú traes proveedores. Portkey vive aquí.

- Plataformas de agentes/chatbots: UX del usuario final, memoria/herramientas, canales—menos sobre enrutamiento bruto, más sobre asistentes empaquetados.

Cómo evaluamos las mejores alternativas a Portkey

- Amplitud y neutralidad del modelo — propietario + abierto; cambio fácil; sin reescrituras.

- Latencia y resiliencia — políticas de enrutamiento, tiempos de espera/reintentos, instantáneo conmutación por error.

- Gobernanza y seguridad — manejo de claves, alcances, redacción, enrutamiento regional.

- Observabilidad — registros/rastros, paneles de costos/latencia, señales compatibles con OTel.

- Transparencia de precios y TCO — comparar real costos antes de enrutar.

- Experiencia del desarrollador — documentos, SDKs, inicios rápidos; tiempo hasta el primer token.

- Comunidad y economía — ¿tu gasto ayuda aumentar la oferta (incentivos para proveedores/propietarios de GPU)?

Las 10 mejores alternativas a Portkey (clasificadas)

#1 — ShareAI (API de IA impulsada por personas)

Qué es. A API de múltiples proveedores con un mercado transparente and enrutamiento inteligente. Una integración te da un amplio catálogo de modelos y proveedores; puedes comparar precio, latencia, tiempo de actividad, disponibilidad y tipo de proveedor antes de enrutar—luego cambiar instantáneamente si un proveedor falla.

Por qué es #1 aquí. Si estás evaluando Portkey pero tu necesidad principal es agregación independiente del proveedor con transparencia previa a la ruta and resiliencia, ShareAI es el ajuste más directo. Mantén una puerta de enlace para políticas a nivel organizacional, agrega ShareAI para enrutamiento guiado por el mercado y sin bloqueo.

- Una API → 150+ modelos entre muchos proveedores; cambio fácil.

- Mercado transparente: elige por precio, latencia, tiempo de actividad, disponibilidad, tipo de proveedor.

- Resiliencia por defecto: políticas de enrutamiento + conmutación por error instantánea.

- Economía justa: 70% de cada dólar fluye hacia los proveedores (comunidad o empresa).

13. Qué es API7 AI Gateway (y qué no es) — Explorar Modelos · Abrir Playground · Crear clave API · Referencia de API · Guía del Usuario · Lanzamientos

Para proveedores: gana manteniendo modelos en línea. Cualquiera puede convertirse en un proveedor de ShareAI—Comunidad o Empresa. Regístrate en Windows, Ubuntu, macOS o Docker. Contribuye con ráfagas de tiempo inactivo o ejecuta siempre activo. Elige un incentivo: Recompensas (dinero), Intercambio (tokens/AI Prosumer) o Misión (donar un % a ONGs). A medida que escalas, puedes establecer tus propios precios de inferencia y ganar exposición preferencial. Guía del proveedor.

#2 — Kong AI Gateway

Puerta de enlace empresarial de AI/LLM: políticas, complementos y análisis para tráfico de AI en el borde. Un plano de control en lugar de un mercado; fuerte para gobernanza, no para transparencia de proveedores.

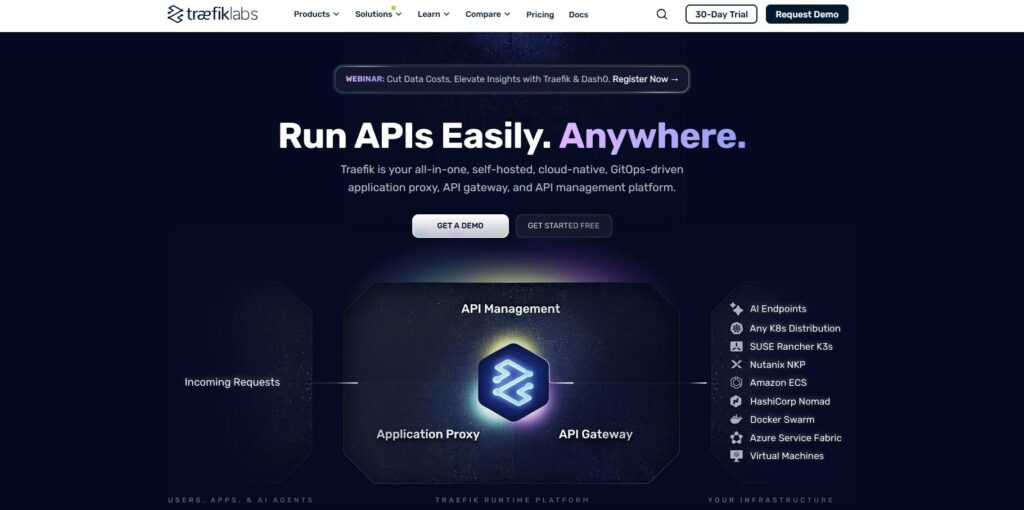

#3 — Traefik AI Gateway

Una capa delgada de AI sobre una puerta de enlace API con credenciales/políticas centralizadas, middlewares especializados en AI y observabilidad compatible con OTel. Gran gobernanza de salida; trae tus propios proveedores.

#4 — OpenRouter

Una API unificada sobre muchos modelos; ideal para experimentación rápida en un amplio catálogo. Menos énfasis en gobernanza; más sobre cambio fácil de modelos.

#5 — Eden AI

Agrega no solo LLMs sino también imagen, traducción y TTS. Ofrece respaldos/caché y agrupamiento; adecuado cuando necesitas muchos tipos de servicios de AI en un solo lugar.

#6 — LiteLLM

Un SDK ligero de Python + proxy auto-hospedable que habla una interfaz compatible con OpenAI para muchos proveedores. Flexibilidad DIY; las operaciones son tu responsabilidad.

#7 — Unify

Enrutamiento y evaluación orientados a la calidad para elegir mejores modelos por solicitud. Fuerte para selección del mejor modelo, menos sobre transparencia del mercado.

#8 — Orq

Plataforma de orquestación/colaboración para pasar de experimentos a producción con flujos de bajo código y coordinación de equipos.

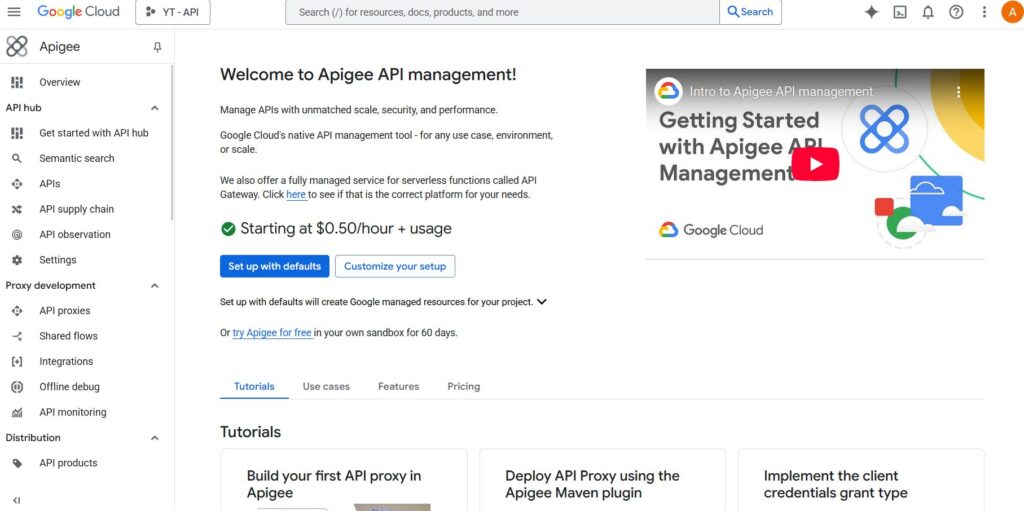

#9 — Apigee (con LLMs detrás)

Una gestión de API/gateway madura que puedes colocar frente a proveedores de LLM para aplicar políticas, claves y cuotas. Amplia, no específica de AI.

#10 — NGINX

Enfoque DIY: construye enrutamiento personalizado, aplicación de tokens y caché para backends de LLM si deseas máximo control y mínimos extras.

Menciones honorables: Cloudflare AI Gateway (políticas de borde, almacenamiento en caché, análisis), OpenAI API (profundidad y madurez de un solo proveedor).

Portkey vs ShareAI (cuándo elegir cuál)

Si su requisito #1 es 2. gobernanza de salida—credenciales centralizadas, aplicación de políticas y observabilidad profunda—Portkey encaja bien.

Si su requisito #1 es acceso independiente del proveedor con datos transparentes antes de la ruta and conmutación por error instantánea, elegir ShareAI. Muchos equipos ejecutan ambos: un gateway para políticas a nivel organizacional + ShareAI para enrutamiento resiliente guiado por el mercado.

7. A quién sirve

| Plataforma | 8. Amplitud del modelo | 9. Enrutamiento / conmutación por error | Gobernanza y seguridad | Observabilidad | 10. Transparencia del mercado | 11. Programa de proveedores | 12. Equipos de producto/plataforma que necesitan una API + economía justa |

|---|---|---|---|---|---|---|---|

| ShareAI | 13. , muchos proveedores | más de 150 modelos entre muchos proveedores | Claves API y controles por ruta | Uso de consola + estadísticas del mercado | Enrutamiento inteligente + conmutación por error instantánea | Sí (precio, latencia, tiempo de actividad, disponibilidad, tipo de proveedor) | Sí — suministro abierto; 70% a proveedores |

| Portkey | Equipos que desean gobernanza de salida | Proveedores propios | Credenciales/políticas centralizadas y barandillas | Trazas/registros profundos | Enrutamiento condicional mediante políticas | Parcial (herramienta de infraestructura, no un mercado) | n/a |

| Kong IA Gateway | Empresas que necesitan políticas a nivel de puerta de enlace | Trae lo tuyo | Políticas/plugins de borde fuertes | Analíticas | Reintentos/plugins | No (infra) | n/a |

| Puerta de Enlace de IA de Traefik | Equipos enfocados en el control de salida de IA | Trae lo tuyo | Middlewares y políticas de IA | Compatible con OTel | Middlewares condicionales | No (infra) | n/a |

| OpenRouter | Desarrolladores que quieren una clave | Catálogo amplio | Controles básicos de API | Lado de la aplicación | Alternativas | Parcial | n/a |

| Eden IA | Equipos que necesitan LLM + IA más amplia | Amplio | Controles estándar | Varía | Alternativas/caché | Parcial | n/a |

| LiteLLM | Proxy DIY/autohospedado | Muchos proveedores | Límites de configuración/clave | Tu infraestructura | Reintentos/alternativas | n/a | n/a |

| Unificar | Equipos orientados a la calidad | Multi-modelo | Seguridad estándar de API | Analíticas de plataforma | Selección del mejor modelo | n/a | n/a |

| Orq | Equipos centrados en la orquestación | Amplio soporte | Controles de plataforma | Analíticas de plataforma | Flujos de orquestación | n/a | n/a |

| Apigee / NGINX | Empresas / DIY | Trae lo tuyo | Políticas/personalizado | Complementos / personalizados | Personalizado | n/a | n/a |

Precios y TCO: comparar costos reales (no solo precios unitarios)

Crudo $/1K tokens oculta la imagen real. TCO se mueve con reintentos/retrocesos, latencia (afecta el uso), variación del proveedor, almacenamiento de observabilidad, y ejecuciones de evaluación. Un mercado transparente te ayuda a elegir rutas equilibrando costo and UX.

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))

- Prototipo (~10k tokens/día): Optimizar tiempo hasta el primer token con Playground + inicios rápidos.

- Escala media (~2M tokens/día): Enrutamiento/failover guiado por el marketplace puede recortar un 10–20% mientras mejora la UX.

- Cargas de trabajo irregulares: Espera costos efectivos de tokens más altos por reintentos durante el failover—presupuesta para ello.

Guía de migración: muévete a ShareAI desde Portkey u otros

Desde Portkey → Mantén las políticas a nivel de gateway de Portkey donde destacan; añade ShareAI para enrutamiento de mercado + conmutación por error instantánea. Patrón: autenticación/política del gateway → ruta ShareAI por modelo → medir estadísticas del mercado → ajustar políticas.

Desde OpenRouter → Mapear nombres de modelos, verificar paridad de prompts, luego redirige el 10% del tráfico y aumentar 25% → 50% → 100% a medida que los presupuestos de latencia/errores lo permitan. Los datos del mercado hacen que los cambios de proveedor sean sencillos.

Desde LiteLLM → Reemplaza el proxy autohospedado en producción rutas que no quieras operar; mantén LiteLLM para desarrollo si lo deseas. Compara la sobrecarga operativa frente a los beneficios del enrutamiento gestionado.

Desde Unify / Orq / Kong / Traefik → Definir expectativas de paridad de características (analíticas, límites, orquestación, plugins). Muchos equipos operan híbridos: mantener características especializadas donde son más fuertes; usar ShareAI 3. para elección transparente de proveedores and conmutación por error.

Inicio rápido para desarrolladores (compatible con OpenAI)

Crea una clave API en la Consola, luego envía tu primera solicitud.

Crear clave API · Abrir Playground · Referencia de API

cURL — Completaciones de Chat

#!/usr/bin/env bash"

JavaScript (fetch) — Node 18+/Edge

// Prerrequisitos:;

Lista de verificación de seguridad, privacidad y cumplimiento

- Manejo de claves: cadencia de rotación; alcances mínimos; separación de entornos.

- Retención de datos: dónde se almacenan los prompts/respuestas; redacción predeterminada; ventanas de retención.

- PII y contenido sensible: enmascaramiento; controles de acceso; enrutamiento regional para la localidad de datos.

- Observabilidad: registro de indicaciones/respuestas; capacidad de filtrar o seudonimizar; propagar IDs de rastreo de manera consistente.

- Respuesta a incidentes: rutas de escalamiento y SLAs del proveedor.

Preguntas frecuentes — Portkey vs otros competidores (y dónde encaja ShareAI)

Portkey vs OpenRouter — ¿acceso rápido a múltiples modelos o controles de puerta de enlace?

OpenRouter permite acceso multi-modelo rápido. Portkey centraliza políticas/observabilidad. Si también quieres transparencia previa a la ruta and conmutación por error instantánea, ShareAI combina acceso de múltiples proveedores con una vista de mercado y enrutamiento resiliente. Explorar Modelos.

Portkey vs Traefik AI Gateway — ¿competencia en gobernanza de salida?

Ambos son puertas de enlace (credenciales/política centralizadas; observabilidad). Traefik ofrece una capa de IA ligera y señales compatibles con OTel; Portkey enfatiza límites y ergonomía para desarrolladores. Para elección transparente de proveedores + conmutación por error, añade ShareAI junto con una puerta de enlace.

Portkey vs Kong AI Gateway — ¿política empresarial vs barreras específicas de IA?

Kong trae políticas/plugins de nivel empresarial; Portkey se centra en el tráfico de IA. Muchas empresas combinan un gateway con ShareAI para obtener enrutamiento guiado por el mercado and sin bloqueo.

Portkey vs Eden AI — ¿servicios de IA más amplios o control de salida?

Eden agrega LLM + visión/TTS/traducción; Portkey centraliza egreso de IA. Si quieres precios/transparencia de latencia entre muchos proveedores y conmutación por error instantánea, ShareAI está diseñado específicamente.

Portkey vs LiteLLM — ¿proxy autoalojado o gobernanza gestionada?

LiteLLM es un proxy DIY; Portkey es gobernanza/observabilidad gestionada. Si prefieres no operar el proxy y también quieres enrutamiento impulsado por el mercado, elige ShareAI.

Portkey vs Unify — ¿selección del mejor modelo vs aplicación de políticas?

Unificar se centra en selección impulsada por evaluación; Portkey sobre política/observabilidad. Agregar ShareAI cuando lo necesites una API sobre muchos proveedores con estadísticas de mercado en vivo.

¿Portkey vs Orq — orquestación vs salida?

Orq ayuda a orquestar flujos de múltiples pasos; Portkey gobierna el tráfico de salida. Usa ShareAI 3. para selección transparente de proveedores and enrutamiento resiliente detrás de cualquier enfoque.

¿Portkey vs Apigee — gestión de API vs salida específica de IA?

Apigee es gestión amplia de API; Portkey es gobernanza de salida enfocada en IA. Para acceso independiente del proveedor con transparencia en el mercado, elegir ShareAI.

Portkey vs NGINX

NGINX ofrece filtros/políticas DIY; Portkey ofrece una capa empaquetada con límites de IA y observabilidad. Para evitar Lua personalizada y aún obtener selección transparente de proveedores, capa en ShareAI.

¿Portkey vs OpenAI API — profundidad de un solo proveedor o control de puerta de enlace?

API de OpenAI ofrece profundidad y madurez dentro de un solo proveedor. Portkey centraliza la política de salida a través de tu proveedores. Si quieres muchos proveedores, transparencia previa a la ruta, y conmutación por error, usa ShareAI como tu API de múltiples proveedores.

Portkey vs Cloudflare AI Gateway — ¿red de borde o ergonomía centrada en IA?

Puerta de enlace de IA de Cloudflare se inclina hacia nativo del borde políticas, almacenamiento en caché y análisis; Portkey se centra en la superficie del desarrollador de IA con límites/observabilidad. Para transparencia en el mercado and conmutación por error instantánea entre proveedores, añadir ShareAI.

Prueba ShareAI a continuación

Abrir Playground · Crea tu clave API · Explorar Modelos · Leer la Documentación · Ver lanzamientos · Iniciar sesión / Registrarse