Alternativas de RouteLLM 2026: Cuándo elegir ShareAI (y qué más considerar)

Actualizado en febrero 2026

Los desarrolladores eligen RouteLLM para dirigir indicaciones a modelos más económicos mientras se apunta a una calidad cercana a GPT-4, especialmente para tareas similares a benchmarks donde un enrutador aprendido puede reducir con confianza. Pero si te importa más la transparencia del mercado antes de cada ruta (precio en vivo, latencia, tiempo de actividad, disponibilidad), conmutación instantánea entre múltiples proveedores, política de borde y auditoría, o un proxy/gateway autoalojado, una de estas alternativas a RouteLLM puede adaptarse mejor a tu stack.

Esta guía del comprador está escrita como lo haría un constructor: compensaciones específicas, selecciones rápidas, análisis profundos, comparaciones lado a lado y un inicio rápido de ShareAI para copiar y pegar, para que puedas implementar hoy.

Entendiendo RouteLLM (y dónde puede no encajar)

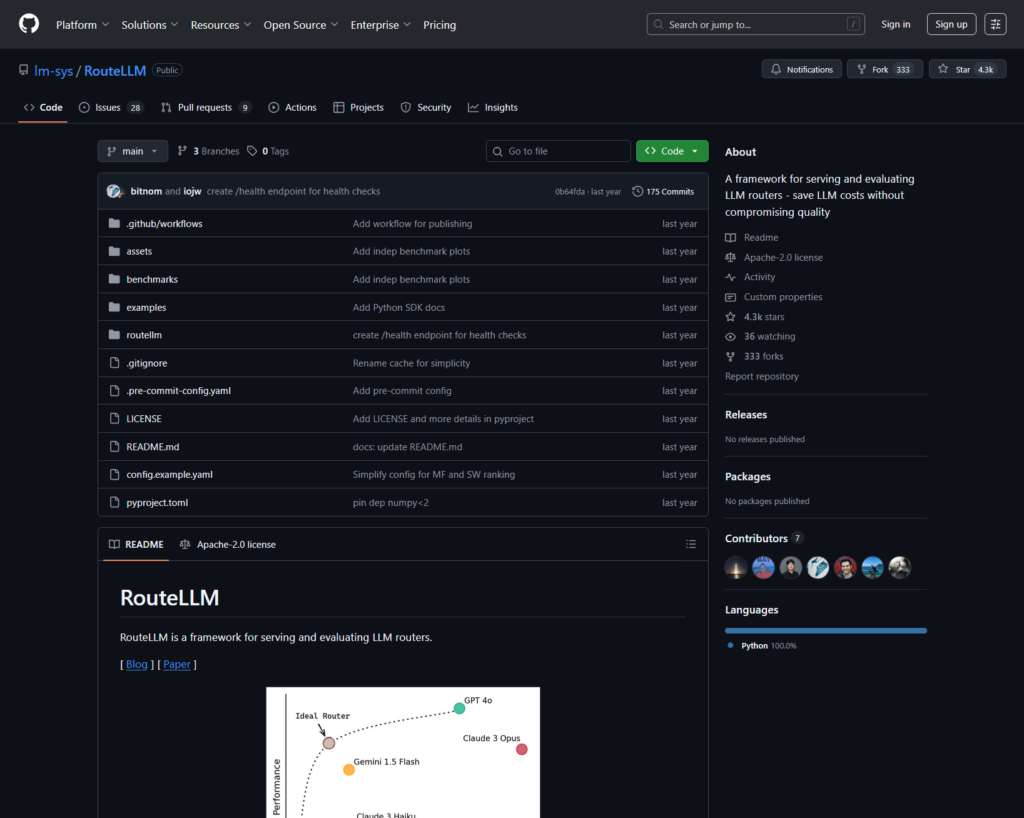

Qué es RouteLLM. RouteLLM es un marco de código abierto para servir y evaluar enrutadores LLM. Ofrece un cliente/servidor compatible con OpenAI y proporciona modelos de enrutamiento entrenados que pueden dirigir consultas más simples a modelos más económicos, reportando hasta un 85% de reducción de costos mientras mantiene ~95% del rendimiento de GPT-4 en benchmarks comunes (por ejemplo, MT-Bench).

Por qué los equipos lo eligen.

- Enrutamiento consciente de costos con políticas respaldadas por investigaciones.

- Código abierto y extensible en Python.

- Compatible con OpenAI camino para probar el enrutamiento sin reescrituras pesadas de SDK.

Dónde RouteLLM puede no encajar.

- Quieres transparencia del mercado en vivo (precio, latencia, tiempo de actividad, disponibilidad) antes de cada ruta, no solo una política aprendida.

- Necesitas conmutación por error de múltiples proveedores

- Tu hoja de ruta abarca APIs multimodales como OCR, voz, traducción y análisis de documentos bajo un mismo techo.

Cómo elegir una alternativa a RouteLLM

- Costo Total de Propiedad (TCO). No te detengas en $/1K tokens. Cuenta las tasas de aciertos de caché, reintentos/retrocesos, encolamiento, costos de evaluadores y la carga operativa de registros/alertas. Los enrutadores y puertas de enlace conscientes de la caché con caché semántico pueden hacer que un “precio de lista más caro” sea más barato en la práctica.

- Latencia y fiabilidad. Favorece el enrutamiento consciente de la región, la adhesión al proveedor cuando una caché está caliente y retrocesos precisos (reintentar 429s, escalar en tiempos de espera). Los enrutadores alojados que te mantienen en el mismo proveedor para contextos calientes y retroceden cuando un proveedor falla tienden a ganar.

- Observabilidad y gobernanza. Si las barreras de seguridad, redacción, registros de auditoría y políticas en el borde son importantes, una puerta de enlace de IA (Portkey o Kong AI Gateway) suele ser más fuerte que un enrutador puro por sí solo. Muchos equipos combinan enrutador + puerta de enlace.

- Autoalojado vs. gestionado. ¿Prefieres Docker/K8s/Helm y un proxy compatible con OpenAI? Prueba LiteLLM. ¿Quieres velocidad alojada + visibilidad del mercado? Considera ShareAI o OpenRouter.

- Amplitud más allá del chat. Si necesitas OCR, voz, traducción o análisis de documentos junto con chat LLM, un orquestador multimodal como Eden AI ayuda.

- Enrutamiento basado en datos. Si prefieres benchmarks en vivo para dirigir costo/velocidad/calidad por región o carga de trabajo, evalúa Unify.

Mejores alternativas a RouteLLM (selecciones rápidas)

ShareAI (nuestra elección para transparencia en el mercado + economía para constructores)

Una API a través de un gran catálogo de modelos/proveedores con conmutación por error instantánea y un mercado que muestra precio, latencia, tiempo de actividad, disponibilidad antes de enrutar. Comienza rápido en el Área de pruebas, toma las llaves en el Consola, navega Documentos, y compara opciones en el Modelos.

Eden AI (orquestador multimodal)

API unificada a través de LLMs más imagen, OCR/análisis de documentos, voz y traducción—junto con comparación de modelos, monitoreo, almacenamiento en caché y procesamiento por lotes.

OpenRouter (enrutamiento consciente del caché)

Router alojado a través de muchos LLMs con almacenamiento en caché de prompts y persistencia de proveedor para reutilizar contextos cálidos; retrocede cuando un proveedor no está disponible.

Portkey (política y operaciones SRE en la puerta de enlace)

Puerta de enlace de IA con conmutaciones programables, libros de jugadas de limitación de tasa y caché semántico—además de trazas/métricas detalladas para control de producción.

Kong AI Gateway (gobernanza y auditoría en el borde)

Lleva complementos de IA, políticas y análisis al ecosistema de Kong; una excelente opción cuando necesitas controles centralizados en el borde entre equipos.

Unificar (enrutador basado en datos)

API universal con evaluaciones en vivo para optimizar costo/velocidad/calidad por región y carga de trabajo.

Orq.ai (experimentación y LLMOps)

Experimentos, evaluadores (incluyendo métricas RAG), implementaciones y RBAC/VPC—ideal cuando la evaluación y la gobernanza necesitan convivir.

LiteLLM (proxy/pasarela autohospedado)

Proxy de código abierto compatible con OpenAI con presupuestos/límites, registro/métricas y una interfaz de administración. Implementa con Docker/K8s/Helm; tú gestionas las operaciones.

Análisis profundos: principales alternativas de RouteLLM

ShareAI (API de IA impulsada por personas)

Qué es. Una red de IA centrada en proveedores y API unificada. Explora un amplio catálogo de modelos/proveedores y enruta con conmutación por error instantánea. El mercado muestra precio, latencia, tiempo de actividad y disponibilidad en un solo lugar para que puedas elegir el proveedor adecuado antes de cada ruta. Comienza en el Área de pruebas, cree claves en el Consola, y sigue el inicio rápido de la API en el Documentos. Explora el Mercado de Modelos.

- 11. Programa de proveedores — consulta precio/latencia/tiempo de actividad/disponibilidad de inmediato.

- Resiliencia por defecto — conmutación rápida al siguiente mejor proveedor cuando uno falla.

- Economía alineada con el constructor — la mayoría del gasto fluye hacia los proveedores de GPU que mantienen los modelos en línea.

- Inicio sin fricciones — prueba en el Playground, luego implementa.

Hechos del proveedor (ganar manteniendo los modelos en línea). Cualquiera puede convertirse en proveedor (Comunidad o Empresa). Regístrate a través de Windows/Ubuntu/macOS o Docker. Contribuye con ráfagas de tiempo inactivo o ejecuta siempre activo. Elige incentivos: Recompensas (dinero), Intercambio (tokens/AI Prosumer) o Misión (donar un % a ONG). Consulta el Guía del proveedor o abre el Panel de Control del Proveedor.

Ideal para. Equipos de producto que desean transparencia en el mercado, resiliencia y espacio para crecer en modo proveedor, sin depender de un único proveedor.

Eden IA

Qué es. Una API unificada que abarca LLMs + generación de imágenes + OCR/análisis de documentos + voz + traducción para que no tengas que integrar múltiples SDK de proveedores. También enfatizan la comparación de modelos, monitoreo y agrupamiento.

Buena opción cuando. Tu hoja de ruta es multimodal y deseas orquestar OCR/voz/traducción junto con chat LLM.

Advertencias. Si necesitas un 1. vista del mercado por solicitud (precio/latencia/tiempo de actividad/disponibilidad) o economía a nivel de proveedor, combina un enrutador de mercado como ShareAI.

OpenRouter

Qué es. Un enrutador LLM unificado con enrutamiento de proveedor/modelo y almacenamiento en caché de solicitudes. Con la caché habilitada, OpenRouter tiende a mantenerte en el mismo proveedor para reutilizar contextos cálidos; si ese proveedor no está disponible, recurre a otro. También admite sugerencias de estrategia (por ejemplo, ponderación por precio).

Buena opción cuando. Deseas velocidad alojada y enrutamiento consciente de la caché para reducir costos y mejorar el rendimiento, especialmente en cargas de trabajo de chat de alta QPS con solicitudes repetidas.

Advertencias. Para una gobernanza empresarial profunda (exportaciones SIEM, políticas a nivel organizacional), muchos equipos combinan OpenRouter con Portkey o Kong AI Gateway.

Portkey

Qué es. Una puerta de enlace de IA con retrocesos programables, libros de jugadas de limitación de velocidad y caché simple/semántica, además de trazas/métricas para un control estilo SRE. La caché semántica es especialmente útil para solicitudes/mensajes cortos cuando los umbrales de similitud están bien ajustados.

Buena opción cuando. Necesitas enrutamiento basado en políticas con observabilidad de primera clase y estás cómodo operando una capa de puerta de enlace frente a uno o más enrutadores/mercados.

Kong IA Gateway

Qué es. Una puerta de enlace perimetral que lleva complementos de IA, políticas y análisis al ecosistema de Kong (a través de Konnect o autogestionado). Si tu plataforma API ya gira en torno a Kong y necesitas políticas/auditorías centrales, esta es una buena opción.

Buena opción cuando. La gobernanza perimetral, la auditabilidad, la residencia de datos y los controles centralizados son innegociables en tu entorno.

Unificar

Qué es. Un enrutador basado en datos que optimiza costo/velocidad/calidad utilizando puntos de referencia en vivo, ajustándose por región y carga de trabajo.

Buena opción cuando. Deseas una selección guiada por puntos de referencia que se adapte continuamente al rendimiento del mundo real.

Orq.ia

Qué es. Una plataforma de colaboración de IA generativa + LLMOps: experimentos, evaluadores (incluyendo métricas RAG), implementaciones y RBAC/VPC. Ideal cuando la evaluación y la gobernanza necesitan coexistir.

Buena opción cuando. Necesitas experimentación + evaluación con gobernanza en un solo lugar, luego implementar directamente desde la misma superficie.

LiteLLM

Qué es. Un proxy/pasarela de código abierto con endpoints compatibles con OpenAI, presupuestos y límites de velocidad, registro/métricas y una interfaz de administración. Implementa vía Docker/K8s/Helm; mantén el tráfico en tu propia red.

Buena opción cuando. Quieres autoalojamiento y control total de la infraestructura con compatibilidad sencilla para SDKs populares estilo OpenAI.

Advertencias. Como con cualquier pasarela OSS, eres responsable de las operaciones y actualizaciones.

Inicio rápido: llama a un modelo en minutos (ShareAI)

Comienza en el Área de pruebas, luego obtén una clave API y envía. Referencias: inicio rápido de la API • Inicio de Documentos • Lanzamientos.

#!/usr/bin/env bash"

// ShareAI — Completaciones de Chat (JavaScript, Node 18+);

Consejo de migración. Mapea tus modelos actuales seleccionados en RouteLLM a equivalentes de ShareAI, refleja las formas de solicitud/respuesta y comienza detrás de una bandera de características. Envía primero entre 5–10% de tráfico, compara latencia/costo/calidad, luego aumenta. Si también ejecutas una pasarela (Portkey/Kong), asegúrate de que el almacenamiento en caché/retrocesos no se activen doblemente entre capas.

Comparación de un vistazo

| Plataforma | Alojado / Autoalojado | Enrutamiento y Alternativas | Observabilidad | Amplitud (LLM + más allá) | Gobernanza / Política | Notas |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Router aprendido; cliente/servidor compatible con OpenAI | CLI/registros; enfoque en investigación | Centrado en LLM | Política a través de tu infraestructura | Ideal para ahorros de costos a nivel de investigación; trae tus propios controles de borde. |

| ShareAI | Alojado + red de proveedores | Conmutación por error instantánea; selección guiada por el mercado | Registros de uso; estadísticas del mercado | Amplio catálogo de modelos | Controles a nivel de proveedor | Mercado impulsado por personas; comienza con Área de pruebas and Modelos. |

| Eden IA | Alojado | Cambiar proveedores; lote; almacenamiento en caché | Monitoreo de costos y API | LLM + imagen + OCR + voz + traducción | Facturación centralizada/gestión de claves | Orquestador multimodal. |

| OpenRouter | Alojado | Enrutamiento de proveedor/modelo; almacenamiento en caché de solicitudes; adhesión al proveedor | Información a nivel de solicitud | Centrado en LLM | Políticas del proveedor | Reutilización de caché; respaldo en caso de no disponibilidad. |

| Portkey | Puerta de enlace alojada | Respaldo de políticas; libros de jugadas de limitación de tasa; caché semántico | Trazas/métricas | LLM-primero | Configuraciones de puerta de enlace | Rieles de seguridad estilo SRE. |

| Kong IA Gateway | Autoalojado/Empresarial | Enrutamiento upstream mediante complementos de IA | Métricas/auditoría a través de Kong | LLM-primero | Gobernanza sólida en el borde | Componente de infraestructura; se combina con enrutadores/mercados. |

| Unificar | Alojado | Enrutamiento basado en datos por costo/velocidad/calidad | Explorador de referencia | Centrado en LLM | Políticas de enrutador | Selección guiada por benchmarks. |

| Orq.ia | Alojado | Reintentos/alternativas en la orquestación | Analítica de plataforma; evaluadores RAG | LLM + RAG + evaluaciones | Opciones RBAC/VPC | Enfoque en colaboración y experimentación. |

| LiteLLM | Autoalojamiento/OSS | Reintento/alternativa; presupuestos/límites | Registro/métricas; Interfaz de administración | Centrado en LLM | Control total de infraestructura | Compatible con OpenAI; Implementación en Docker/K8s/Helm. |

Preguntas frecuentes: RouteLLM vs. el resto

RouteLLM vs ShareAI — ¿cuál es mejor?

Elegir ShareAI si deseas un mercado transparente que destaque 8. antes de enrutar, antes de cada ruta, más conmutación por error instantánea y economía alineada con el constructor. Elige RouteLLM si prefieres un enrutador basado en investigación y estás cómodo operando infraestructura a su alrededor (puertas de enlace, registro, auditoría). Comienza con el Área de pruebas and Mercado de Modelos.

RouteLLM vs Eden AI — ¿cuál es la diferencia?

Eden IA abarca LLMs and multimodal (visión/OCR, habla, traducción) con comparación y monitoreo. RouteLLM se enfoca en el enrutamiento aprendido para LLMs. Si tu hoja de ruta necesita OCR/habla/traducción bajo una API, Eden AI simplifica la entrega; si la investigación de enrutamiento es la prioridad, RouteLLM encaja. Combínalo con ShareAI cuando quieras transparencia del mercado por solicitud.

RouteLLM vs OpenRouter — ¿cuándo elegir cada uno?

Elegir OpenRouter cuándo almacenamiento en caché de solicitudes y la reutilización de caché caliente importan (tiende a mantenerte en el mismo proveedor y recurre a alternativas en caso de fallos). Elige RouteLLM para políticas aprendidas que operas tú mismo. Muchas pilas combinan OpenRouter con una puerta de enlace para política/observabilidad—y aún usan ShareAI cuando quieren transparencia del mercado antes de cada ruta.

RouteLLM vs Portkey — ¿enrutador o puerta de enlace?

RouteLLM es un enrutador. Portkey es un puerta de enlace: sobresale en política/guías (manuales de respaldo, caché semántico) y trazas/métricas detalladas. Muchos equipos usan ambos: una puerta de enlace para política a nivel organizacional + un enrutador/mercado para elección de modelo y control de costos. ShareAI combina bien aquí cuando quieres visibilidad del mercado antes de la ruta.

RouteLLM vs Kong AI Gateway — ¿quién necesita cuál?

Elegir Kong IA Gateway cuándo gobernanza en el borde (política/auditoría centralizada, residencia de datos) es innegociable. Mantén RouteLLM detrás de él si aún quieres enrutamiento aprendido para precio/rendimiento. Usa ShareAI junto cuando quieras elegir proveedores por 8. antes de enrutar, antes de cada ruta.

RouteLLM vs Unify — ¿qué es único acerca de Unify?

Unificar utiliza benchmarks en vivo y políticas dinámicas para optimizar por costo/velocidad/calidad. Si deseas una selección basada en datos que evoluciona por región/carga de trabajo, Unify es convincente; RouteLLM se centra en modelos de enrutamiento aprendidos que alojas. Usa ShareAI cuando prefieras elegir proveedores con una vista de mercado y con conmutación por error instantánea.

RouteLLM vs Orq.ai — ¿cuál para evaluación y RAG?

Orq.ia proporciona una superficie de experimentación/evaluación (incluyendo evaluadores RAG), además de implementaciones y RBAC/VPC. Si necesitas LLMOps + evaluadores, Orq.ai puede complementar o reemplazar un router puro desde el principio. Trae ShareAI cuando quieras elección de proveedores con transparencia de mercado y resiliencia en producción.

RouteLLM vs LiteLLM — ¿alojado vs autoalojado?

RouteLLM es lógica de enrutamiento OSS; LiteLLM es un proxy/pasarela compatible con OpenAI con presupuestos, límites de tasa y una interfaz de administración—ideal si deseas mantener el tráfico dentro de tu VPC y poseer el plano de control. Los equipos a menudo combinan LiteLLM para autoalojamiento con ShareAI para visibilidad del mercado y conmutación por error instantánea entre proveedores.

¿Cuál es el más económico para mi carga de trabajo: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Depende de la elección del modelo, la región, la capacidad de almacenamiento en caché y los patrones de tráfico. Enrutadores como ShareAI/OpenRouter pueden reducir costos mediante el enrutamiento y la adhesión consciente del caché; puertas de enlace como Portkey agregar almacenamiento en caché semántico; LiteLLM reduce la sobrecarga de la plataforma si te sientes cómodo operándolo. Haz pruebas con tu indicaciones y seguimiento el costo efectivo por resultado—no solo el precio de lista.

¿Qué es RouteLLM?

Un marco de código abierto para servir y evaluar enrutadores LLM; incluye enrutadores entrenados y rutas compatibles con OpenAI; a menudo citado para reducir costos sustancialmente mientras mantiene una calidad cercana a GPT-4 en tareas similares a MT-Bench.

¿Cuál es la forma más rápida de probar ShareAI sin una integración completa?

Abre el Área de pruebas, elige un modelo/proveedor y ejecuta indicaciones en el navegador. Cuando estés listo, crea una clave y coloca los fragmentos de cURL/JS anteriores en tu aplicación.

¿Puedo convertirme en un proveedor de ShareAI y ganar dinero?

Sí. Cualquiera puede registrarse como Comunidad or Empresa proveedor usando Windows/Ubuntu/macOS o Docker. Contribuye tiempo inactivo ráfagas o ejecuta siempre activo. Elige incentivos: Recompensas (dinero), Intercambio (tokens/AI Prosumer), o Misión (donar % a ONGs). Mira el Guía del proveedor o abre el Panel de Control del Proveedor.

Conclusión

Mientras RouteLLM es un enrutador OSS sólido, tu mejor elección depende de las prioridades:

- Transparencia del mercado + resiliencia: ShareAI

- Cobertura multimodal bajo una API: Eden IA

- Enrutamiento consciente de caché en forma alojada: OpenRouter

- Políticas/barreras en el borde: Portkey o Kong AI Gateway

- Enrutamiento basado en datos: Unificar

- LLMOps + evaluadores: Orq.ia

- Plano de control autoalojado: LiteLLM

Si 8. antes de enrutar, antes de cada ruta, conmutación por error instantánea, y economía alineada con el constructor están en su lista de verificación, abra el Área de pruebas, cree una clave API, y navegue por el Mercado de Modelos para enrutar su próxima solicitud de manera inteligente.