Bienvenue à GPT-OSS d'OpenAI sur ShareAI

ShareAI s'engage à vous apporter les modèles d'IA les plus récents et les plus puissants—et nous le faisons à nouveau aujourd'hui.

Il y a quelques heures, OpenAI a publié son révolutionnaire GPT-OSS modèles, et vous pouvez déjà commencer à les utiliser au sein du réseau ShareAI !

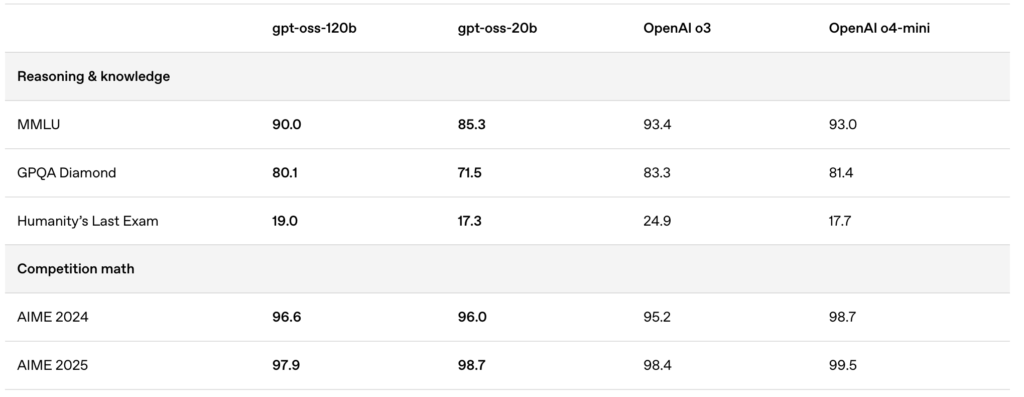

Les modèles nouvellement publiés—gpt-oss:20b et gpt-oss:120b—offrent des expériences de chat local exceptionnelles, des capacités de raisonnement puissantes et un support amélioré pour des scénarios avancés de développement.

🚀 Commencez avec GPT-OSS sur ShareAI

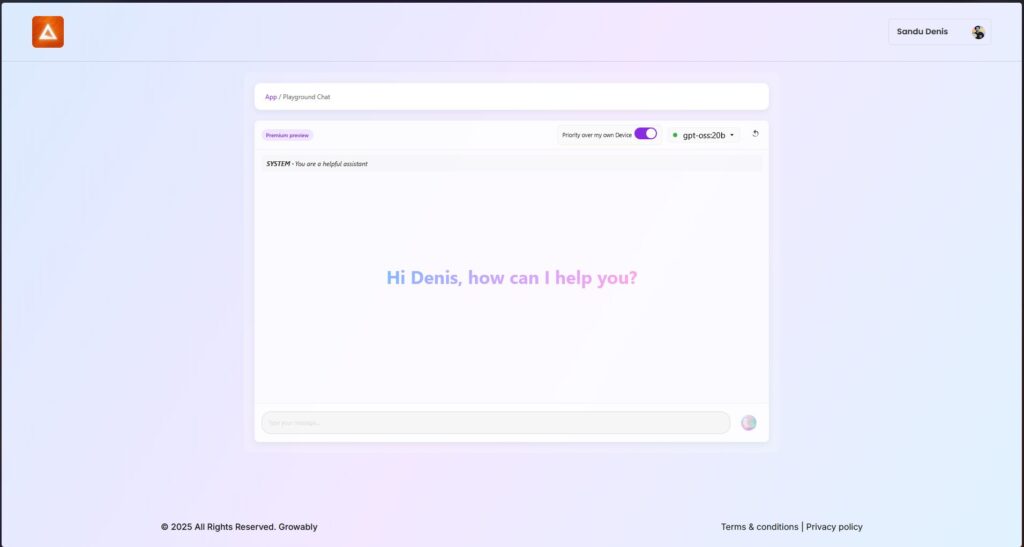

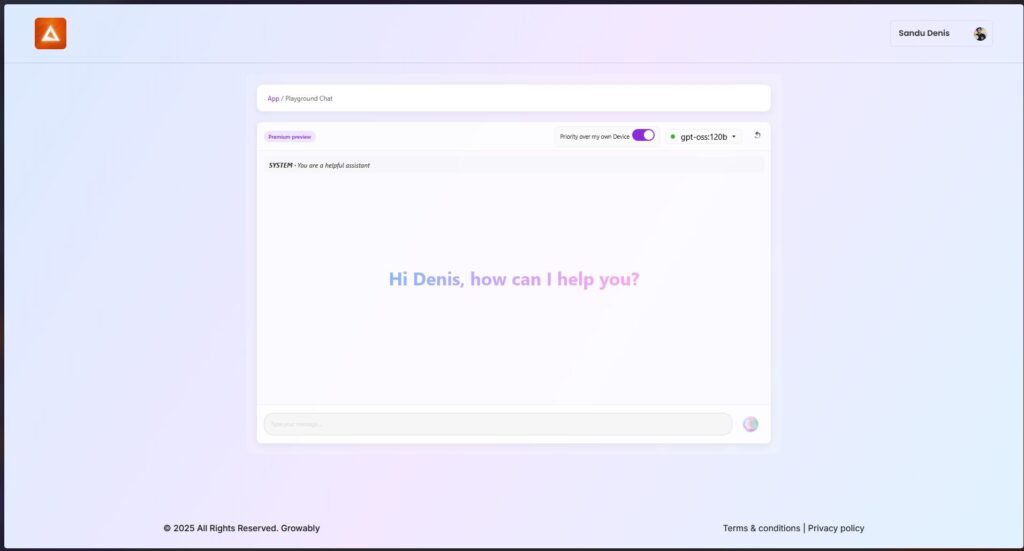

Vous pouvez essayer ces modèles dès maintenant en utilisant la dernière version du client Windows de ShareAI.

- Téléchargez ShareAI pour Windows (lien vers la page de téléchargement)

Après l'installation, vous pouvez facilement télécharger et exécuter les modèles GPT-OSS directement depuis l'application ShareAI—aucune configuration ou installation compliquée requise.

✨ Points forts des fonctionnalités de GPT-OSS

Voici pourquoi GPT-OSS révolutionne vos flux de travail pilotés par l'IA :

- Capacités agentiques:

Exploitez les fonctionnalités intégrées pour les appels de fonctions, la navigation web, les appels d'outils Python et les sorties de données structurées. - Transparence complète de la chaîne de raisonnement:

Obtenez une visibilité claire sur le processus de raisonnement du modèle, permettant un débogage plus facile et une plus grande confiance dans les résultats générés. - Niveaux de raisonnement configurables:

Ajustez facilement l'effort de raisonnement (faible, moyen, élevé) en fonction de vos besoins en latence et complexité. - Architecture ajustable:

Personnalisez les modèles de manière approfondie avec un ajustement des paramètres pour des cas d'utilisation spécifiques. - Licence permissive Apache 2.0:

Innovez librement sans licences copyleft restrictives ou risques de brevets—parfait pour un déploiement commercial et une expérimentation rapide.

🔥 Optimisé avec la quantification MXFP4

OpenAI a introduit la quantification MXFP4, réduisant considérablement l'empreinte mémoire des modèles GPT-OSS :

- Format MXFP4 Expliqué:

Les modèles GPT-OSS utilisent une technique de quantification où les poids Mixture-of-Experts (MoE) sont quantifiés à seulement 4,25 bits par paramètre. Ces poids MoE représentent plus de 90% des paramètres totaux du modèle, rendant la quantification incroyablement efficace. - Compatibilité Améliorée:

Cette quantification optimisée permet :- Au gpt-oss:20b modèle de fonctionner sans problème sur des machines avec seulement 16GB de mémoire.

- Au gpt-oss:120b au modèle de s'adapter confortablement sur un seul GPU de 80GB.

ShareAI prend en charge ce format MXFP4 nativement—aucune étape supplémentaire, conversion ou complication requise. Notre dernière mise à jour du moteur inclut des noyaux nouvellement développés spécifiquement conçus pour le format MXFP4, garantissant des performances optimales.

📌 Modèles GPT-OSS Disponibles Maintenant :

GPT-OSS:20B

- Idéal pour des tâches spécialisées à faible latence ou des déploiements locaux.

- Offre des performances robustes même sur des configurations matérielles modestes.

GPT-OSS:120B

- Offre un raisonnement puissant, des capacités agentiques avancées et une polyvalence adaptée aux tâches exigeantes à grande échelle.

- Parfait pour les développeurs et les entreprises nécessitant un raisonnement approfondi, une précision accrue et des applications d'IA plus larges.

🛠️ Essayez GPT-OSS aujourd'hui

Prêt à découvrir les capacités d'IA de nouvelle génération ?

- Téléchargez le client Windows ShareAI (lien vers la page de téléchargement)

- Voir la documentation (lien vers les documents utilisateur ou tutoriels)

Restez informé—ShareAI continue d'étendre notre bibliothèque de modèles, en renforçant vos projets d'IA à chaque étape.

Bon prompting ! 🚀