RouteLLM विकल्प 2026: कब चुनें ShareAI (और अन्य क्या विचार करें)

अपडेटेड फरवरी 2026

डेवलपर्स चुनते हैं रूटएलएलएम सस्ते मॉडलों को निर्देशित करने के लिए संकेतों को मार्गित करना, जबकि GPT-4 के निकट गुणवत्ता को लक्षित करना—विशेष रूप से बेंचमार्क जैसे कार्यों के लिए जहां एक सीखा हुआ राउटर आत्मविश्वास से डाउनशिफ्ट कर सकता है। लेकिन अगर आप अधिक ध्यान देते हैं प्रत्येक रूट से पहले मार्केटप्लेस पारदर्शिता (लाइव कीमत, विलंबता, अपटाइम, उपलब्धता), कई प्रदाताओं के बीच त्वरित फेलओवर, एज नीति और ऑडिट, या एक स्व-होस्टेड प्रॉक्सी/गेटवे, इनमें से एक RouteLLM विकल्प आपके स्टैक के लिए बेहतर हो सकता है।.

यह खरीदार गाइड एक बिल्डर की तरह लिखा गया है: विशिष्ट ट्रेड-ऑफ्स, त्वरित चयन, गहन विश्लेषण, साइड-बाय-साइड तुलना, और एक कॉपी-पेस्ट ShareAI क्विकस्टार्ट ताकि आप आज ही शिप कर सकें।.

RouteLLM को समझना (और जहां यह फिट नहीं हो सकता है)

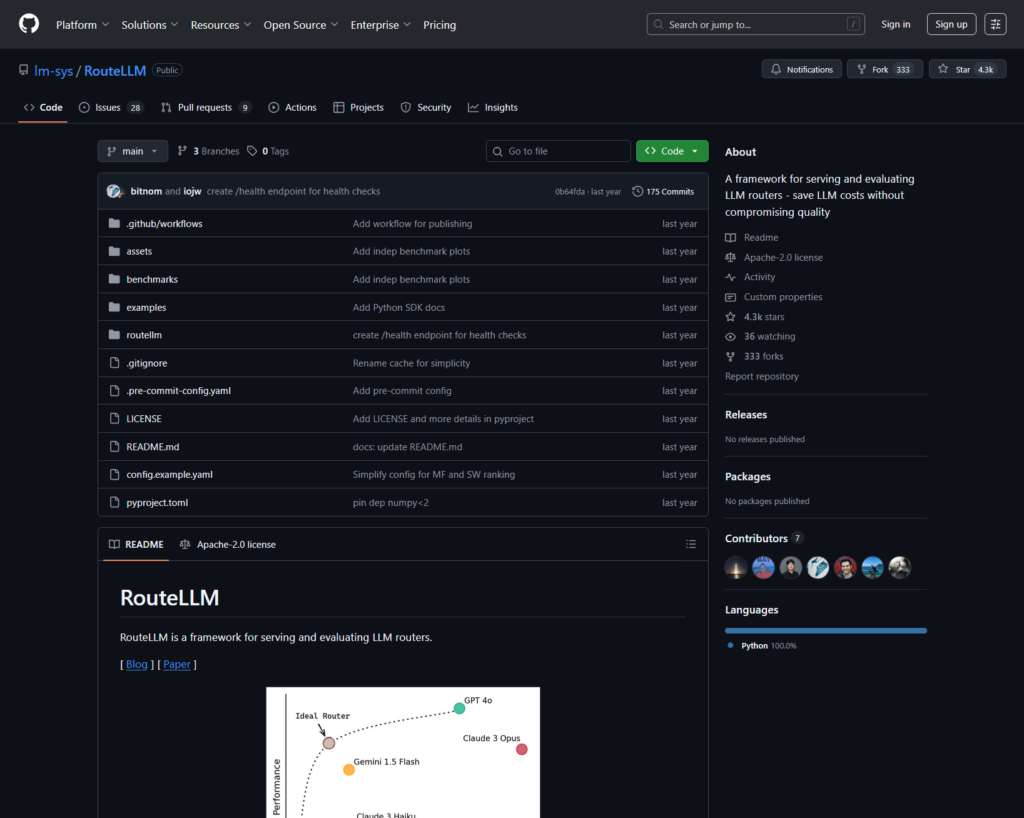

RouteLLM क्या है।. RouteLLM एक ओपन-सोर्स फ्रेमवर्क है जो LLM राउटर को सेवा और मूल्यांकन करने के लिए है। यह एक ड्रॉप-इन OpenAI-संगत क्लाइंट/सर्वर प्रदान करता है और प्रशिक्षित राउटिंग मॉडल भेजता है जो सरल प्रश्नों को सस्ते मॉडलों तक मार्गित कर सकता है—आम बेंचमार्क (जैसे, MT-Bench) पर GPT-4 प्रदर्शन के ~95% को बनाए रखते हुए 85% लागत में कमी की रिपोर्ट की गई है।.

टीमें इसे क्यों चुनती हैं।.

- लागत-सचेत रूटिंग शोध-समर्थित नीतियों के साथ।.

- ओपन सोर्स और पायथन में विस्तार योग्य।.

- OpenAI-संगत भारी SDK पुनर्लेखन के बिना परीक्षण रूटिंग का मार्ग।.

जहां RouteLLM उपयुक्त नहीं हो सकता।.

- आप चाहते हैं लाइव मार्केटप्लेस पारदर्शिता (मूल्य, विलंबता, अपटाइम, उपलब्धता) प्रत्येक मार्ग से पहले—सिर्फ एक सीखी हुई नीति नहीं।.

- आपको आवश्यकता है मल्टी-प्रोवाइडर फेलओवर

- आपका रोडमैप फैला हुआ है मल्टीमॉडल एपीआई जैसे OCR, स्पीच, अनुवाद, और दस्तावेज़ पार्सिंग एक ही छत के नीचे।.

RouteLLM विकल्प कैसे चुनें

- कुल स्वामित्व लागत (TCO)।. $/1K टोकन पर न रुकें। कैश हिट दर, पुनः प्रयास/फॉलबैक, कतारबद्धता, मूल्यांकनकर्ता लागत, और लॉग/अलर्ट के संचालन भार की गणना करें। सेमांटिक कैश के साथ कैश-अवेयर राउटर और गेटवे “अधिक महंगी सूची मूल्य” को व्यवहार में सस्ता बना सकते हैं।.

- विलंबता और विश्वसनीयता।. क्षेत्र-अनुकूल रूटिंग, कैश गर्म होने पर प्रदाता स्थिरता, और सटीक फॉलबैक (429s को पुनः प्रयास करें, टाइमआउट पर एस्केलेट करें) को प्राथमिकता दें। होस्टेड राउटर जो आपको गर्म संदर्भों के लिए एक ही प्रदाता पर रखते हैं और प्रदाता में गड़बड़ी होने पर फॉलबैक करते हैं, आमतौर पर जीतते हैं।.

- अवलोकन और शासन।. यदि गार्डरेल, रिडक्शन, ऑडिट लॉग, और किनारे पर नीति महत्वपूर्ण हैं, तो एक AI गेटवे (Portkey या Kong AI Gateway) आमतौर पर केवल एक शुद्ध राउटर से अधिक मजबूत होता है। कई टीमें राउटर + गेटवे को जोड़ती हैं।.

- स्व-होस्ट बनाम प्रबंधित।. Docker/K8s/Helm और OpenAI-संगत प्रॉक्सी पसंद है? LiteLLM आज़माएं। होस्टेड गति + मार्केटप्लेस दृश्यता चाहते हैं? ShareAI या OpenRouter पर विचार करें।.

- चैट से परे व्यापकता।. यदि आपको LLM चैट के साथ OCR, स्पीच, अनुवाद, या दस्तावेज़ पार्सिंग की आवश्यकता है, तो Eden AI जैसे मल्टीमॉडल ऑर्केस्ट्रेटर मदद करता है।.

- डेटा-चालित रूटिंग।. यदि आप क्षेत्र या कार्यभार के अनुसार लागत/गति/गुणवत्ता को निर्देशित करने के लिए लाइव बेंचमार्क पसंद करते हैं, तो Unify का मूल्यांकन करें।.

सर्वश्रेष्ठ RouteLLM विकल्प (त्वरित चयन)

ShareAI (बाजार पारदर्शिता + निर्माता अर्थशास्त्र के लिए हमारा चयन)

एक बड़े मॉडल/प्रदाता कैटलॉग में एक API के साथ तत्काल फेलओवर और एक बाजार जो सतह पर लाता है मूल्य, विलंबता, अपटाइम, उपलब्धता रूट करने से पहले। तेज़ शुरुआत करें प्लेग्राउंड, चाबियाँ पकड़ें कंसोल, ब्राउज़ करें डॉक्स, और विकल्पों की तुलना करें मॉडल्स.

Eden AI (मल्टीमॉडल ऑर्केस्ट्रेटर)

LLMs के लिए एकीकृत API साथ ही छवि, OCR/दस्तावेज़ पार्सिंग, भाषण, और अनुवाद—मॉडल तुलना, निगरानी, कैशिंग, और बैच प्रोसेसिंग के साथ।.

OpenRouter (कैश-अवेयर रूटिंग)

कई LLMs के बीच होस्टेड राउटर, प्रॉम्प्ट कैशिंग और प्रदाता स्थिरता के साथ गर्म संदर्भों का पुन: उपयोग करता है; जब कोई प्रदाता अनुपलब्ध होता है तो वापस लौटता है।.

Portkey (गेटवे पर नीति और SRE संचालन)

प्रोग्रामेबल फेलओवर, दर-सीमा प्लेबुक्स, और सेमांटिक कैश के साथ AI गेटवे—उत्पादन नियंत्रण के लिए विस्तृत ट्रेस/मेट्रिक्स।.

Kong AI Gateway (एज गवर्नेंस और ऑडिट)

Kong पारिस्थितिकी तंत्र में AI प्लगइन्स, नीति, और विश्लेषण लाएं; जब आपको टीमों के बीच केंद्रीकृत किनारे नियंत्रण की आवश्यकता हो तो यह एक मजबूत फिट है।.

एकीकृत करें (डेटा-चालित राउटर)

क्षेत्र और वर्कलोड द्वारा लागत/गति/गुणवत्ता को अनुकूलित करने के लिए लाइव बेंचमार्क के साथ यूनिवर्सल API।.

Orq.ai (प्रयोग और LLMOps)

प्रयोग, मूल्यांकनकर्ता (RAG मेट्रिक्स सहित), परिनियोजन, और RBAC/VPC—महान जब मूल्यांकन और शासन को एक साथ रहना चाहिए।.

LiteLLM (स्व-होस्टेड प्रॉक्सी/गेटवे)

ओपन-सोर्स, OpenAI-संगत प्रॉक्सी बजट/सीमाओं, लॉगिंग/मेट्रिक्स, और एक एडमिन UI के साथ। Docker/K8s/Helm के साथ परिनियोजित करें; आप संचालन के मालिक हैं।.

गहन अध्ययन: शीर्ष RouteLLM विकल्प

ShareAI (लोगों द्वारा संचालित AI API)

यह क्या है।. एक प्रदाता-प्रथम AI नेटवर्क और एकीकृत API। मॉडल/प्रदाताओं की एक बड़ी सूची ब्राउज़ करें और त्वरित फेलओवर के साथ रूट करें। बाज़ार एक ही स्थान पर मूल्य, विलंबता, अपटाइम, और उपलब्धता को सतह पर लाता है ताकि आप प्रत्येक रूट से पहले सही प्रदाता चुन सकें। शुरू करें प्लेग्राउंड, कुंजियाँ बनाएं कंसोल, और API क्विकस्टार्ट में अनुसरण करें डॉक्स. । ब्राउज़ करें मॉडल मार्केटप्लेस.

- मार्केटप्लेस पारदर्शिता — मूल्य/विलंबता/अपटाइम/उपलब्धता को सामने देखें।.

- डिफ़ॉल्ट रूप से लचीलापन — जब एक प्रदाता ब्लिप करता है तो अगले सर्वश्रेष्ठ प्रदाता पर तेज़ फेलओवर।.

- बिल्डर-संरेखित अर्थशास्त्र — खर्च का अधिकांश हिस्सा GPU प्रदाताओं को जाता है जो मॉडल्स को ऑनलाइन रखते हैं।.

- बिना रुकावट की शुरुआत — प्लेग्राउंड में परीक्षण करें, फिर शिप करें।.

प्रदाता तथ्य (मॉडल्स को ऑनलाइन रखकर कमाएं)।. कोई भी प्रदाता बन सकता है (समुदाय या कंपनी)। Windows/Ubuntu/macOS या Docker के माध्यम से ऑनबोर्ड करें। निष्क्रिय समय के बर्स्ट योगदान करें या हमेशा चालू रखें। प्रोत्साहन चुनें: पुरस्कार (पैसा), एक्सचेंज (टोकन/AI Prosumer), या मिशन (NGOs को % दान करें)। देखें प्रदाता गाइड या खोलें प्रदाता डैशबोर्ड.

के लिए आदर्श।. उत्पाद टीमें जो बाज़ार की पारदर्शिता, लचीलापन, और प्रदाता मोड में बढ़ने की गुंजाइश चाहती हैं—बिना विक्रेता लॉक-इन के।.

ईडन एआई

यह क्या है।. एक एकीकृत API जो LLMs + छवि निर्माण + OCR/दस्तावेज़ पार्सिंग + भाषण + अनुवाद को कवर करता है ताकि आपको कई विक्रेता SDKs को जोड़ने की आवश्यकता न हो। वे मॉडल तुलना, निगरानी, और बैचिंग पर भी जोर देते हैं।.

अच्छा फिट जब।. आपका रोडमैप मल्टीमॉडल है और आप LLM चैट के साथ OCR/भाषण/अनुवाद को व्यवस्थित करना चाहते हैं।.

ध्यान देने योग्य बातें।. यदि आपको एक आवश्यकता है मार्केटप्लेस दृश्य प्रति अनुरोध (मूल्य/विलंबता/अपटाइम/उपलब्धता) या प्रदाता-स्तरीय अर्थशास्त्र, ShareAI जैसे बाज़ार राउटर को जोड़ें।.

ओपनराउटर

यह क्या है।. प्रदाता/मॉडल रूटिंग के साथ एक एकीकृत LLM राउटर। प्रॉम्प्ट कैशिंग. कैशिंग सक्षम होने पर, OpenRouter आपको गर्म संदर्भों को पुन: उपयोग करने के लिए उसी प्रदाता पर रखने की प्रवृत्ति रखता है; यदि वह प्रदाता अनुपलब्ध है, तो यह बैकअप लेता है। यह रणनीति संकेतों (जैसे, मूल्य-भारित) का भी समर्थन करता है।.

अच्छा फिट जब।. आप लागत कम करने और थ्रूपुट सुधारने के लिए होस्टेड गति और कैश-अवेयर रूटिंग चाहते हैं—विशेष रूप से उच्च-QPS चैट वर्कलोड्स में दोहराए गए प्रॉम्प्ट्स के साथ।.

ध्यान देने योग्य बातें।. गहन एंटरप्राइज़ गवर्नेंस (SIEM निर्यात, संगठन-व्यापी नीति) के लिए, कई टीमें OpenRouter को Portkey या Kong AI Gateway के साथ जोड़ती हैं।.

पोर्टकी

यह क्या है।. एक AI गेटवे जिसमें प्रोग्रामेबल फॉलबैक, रेट-लिमिट प्लेबुक्स, और सरल/सामान्य कैश, साथ ही SRE-शैली नियंत्रण के लिए ट्रेस/मेट्रिक्स शामिल हैं। सामांय कैश विशेष रूप से छोटे प्रॉम्प्ट्स/संदेशों के लिए सहायक होता है जब समानता सीमा अच्छी तरह से ट्यून की जाती है।.

अच्छा फिट जब।. आपको नीति-चालित रूटिंग की आवश्यकता है जिसमें प्रथम-श्रेणी की अवलोकनीयता हो, और आप एक या अधिक राउटर/बाज़ारों के सामने गेटवे लेयर संचालित करने में सहज हैं।.

कॉन्ग एआई गेटवे

यह क्या है।. एक एज गेटवे जो AI प्लगइन्स, नीति, और एनालिटिक्स को Kong इकोसिस्टम में लाता है (Konnect या स्व-प्रबंधित के माध्यम से)। यदि आपका API प्लेटफ़ॉर्म पहले से ही Kong के चारों ओर घूमता है और आपको केंद्रीय नीति/ऑडिट की आवश्यकता है, तो यह एक मजबूत विकल्प है।.

अच्छा फिट जब।. एज गवर्नेंस, ऑडिटेबिलिटी, डेटा रेजिडेंसी, और केंद्रीकृत नियंत्रण आपके वातावरण में अनिवार्य हैं।.

एकीकृत करें

यह क्या है।. एक डेटा-चालित राउटर जो लाइव बेंचमार्क्स का उपयोग करके लागत/गति/गुणवत्ता को अनुकूलित करता है, क्षेत्र और वर्कलोड के अनुसार समायोजित करता है।.

अच्छा फिट जब।. आप बेंचमार्क-निर्देशित चयन चाहते हैं जो वास्तविक दुनिया के प्रदर्शन के अनुसार लगातार अनुकूलित होता है।.

ऑर्क.एआई

यह क्या है।. एक जनरेटिव AI सहयोग + LLMOps प्लेटफ़ॉर्म: प्रयोग, मूल्यांकनकर्ता (RAG मेट्रिक्स सहित), परिनियोजन, और RBAC/VPC। जब मूल्यांकन और गवर्नेंस को एक साथ रहने की आवश्यकता होती है, तो यह शानदार है।.

अच्छा फिट जब।. आपको एक ही स्थान पर प्रयोग + मूल्यांकन के साथ शासन की आवश्यकता है—फिर उसी सतह से सीधे तैनात करें।.

लाइटएलएलएम

यह क्या है।. एक ओपन-सोर्स प्रॉक्सी/गेटवे जिसमें OpenAI-संगत एंडपॉइंट्स, बजट और दर सीमाएं, लॉगिंग/मेट्रिक्स, और एक एडमिन UI है। Docker/K8s/Helm के माध्यम से तैनात करें; अपना ट्रैफिक अपने नेटवर्क में रखें।.

अच्छा फिट जब।. आप सेल्फ-होस्टिंग और पूर्ण इंफ्रा नियंत्रण चाहते हैं, जो लोकप्रिय OpenAI-स्टाइल SDKs के लिए सीधा संगत हो।.

ध्यान देने योग्य बातें।. किसी भी OSS गेटवे की तरह, आप संचालन और अपग्रेड के मालिक हैं।.

क्विकस्टार्ट: मिनटों में एक मॉडल कॉल करें (ShareAI)

शुरू करें प्लेग्राउंड, फिर एक API कुंजी प्राप्त करें और शिप करें। संदर्भ: API त्वरित प्रारंभ • डॉक्यूमेंट्स होम • रिलीज़.

#!/usr/bin/env bash"

// ShareAI — चैट पूर्णता (JavaScript, Node 18+);

माइग्रेशन टिप।. अपने वर्तमान RouteLLM-चयनित मॉडल को ShareAI समकक्षों पर मैप करें, अनुरोध/प्रतिक्रिया आकारों को मिरर करें, और फीचर फ्लैग के पीछे शुरू करें। पहले 5–10% ट्रैफिक भेजें, विलंबता/लागत/गुणवत्ता की तुलना करें, फिर बढ़ाएं। यदि आप गेटवे (Portkey/Kong) भी चलाते हैं, तो सुनिश्चित करें कि कैशिंग/फॉलबैक परतों के बीच डबल-ट्रिगर न हो।.

एक नज़र में तुलना

| प्लेटफ़ॉर्म | होस्टेड / सेल्फ-होस्ट | रूटिंग और फॉलबैक्स | अवलोकनीयता | व्यापकता (एलएलएम + उससे आगे) | शासन / नीति | नोट्स |

|---|---|---|---|---|---|---|

| रूटएलएलएम | ओएसएस | सीखा राउटर; OpenAI-संगत क्लाइंट/सर्वर | CLI/लॉग्स; अनुसंधान केंद्रित | एलएलएम-केंद्रित | आपकी इंफ्रा के माध्यम से नीति | अनुसंधान-ग्रेड लागत बचतकर्ताओं के लिए शानदार; अपने स्वयं के एज नियंत्रण लाएं।. |

| शेयरएआई | body: JSON.stringify({ | त्वरित फेलओवर; मार्केटप्लेस-निर्देशित चयन | उपयोग लॉग; मार्केटप्लेस आँकड़े | व्यापक मॉडल कैटलॉग | प्रदाता-स्तरीय नियंत्रण | लोगों द्वारा संचालित बाजार; शुरू करें प्लेग्राउंड और मॉडल्स. |

| ईडन एआई | होस्टेड | प्रदाताओं को स्विच करें; बैच; कैशिंग | लागत और एपीआई मॉनिटरिंग | एलएलएम + छवि + ओसीआर + भाषण + अनुवाद | केंद्रीय बिलिंग/कुंजी प्रबंधन | बहु-मोडल ऑर्केस्ट्रेटर।. |

| ओपनराउटर | होस्टेड | प्रदाता/मॉडल रूटिंग; प्रॉम्प्ट कैशिंग; प्रदाता स्थिरता | अनुरोध-स्तरीय जानकारी | एलएलएम-केंद्रित | प्रदाता नीतियां | कैश पुन: उपयोग; अनुपलब्धता पर फॉलबैक।. |

| पोर्टकी | होस्टेड गेटवे | नीति फॉलबैक; दर-सीमा प्लेबुक्स; सेमांटिक कैश | ट्रेस/मेट्रिक्स | LLM-प्रथम | गेटवे कॉन्फ़िग्स | SRE-शैली गार्डरेल्स।. |

| कॉन्ग एआई गेटवे | स्व-होस्ट/एंटरप्राइज | AI प्लगइन्स के माध्यम से अपस्ट्रीम रूटिंग | मेट्रिक्स/ऑडिट के लिए कॉन्ग | LLM-प्रथम | मजबूत एज गवर्नेंस | इंफ्रा घटक; राउटर्स/बाजारों के साथ जोड़ा गया।. |

| एकीकृत करें | होस्टेड | लागत/गति/गुणवत्ता द्वारा डेटा-चालित रूटिंग | बेंचमार्क एक्सप्लोरर | एलएलएम-केंद्रित | राउटर नीतियां | बेंचमार्क-निर्देशित चयन।. |

| ऑर्क.एआई | होस्टेड | ऑर्केस्ट्रेशन में पुनः प्रयास/फॉलबैक | प्लेटफ़ॉर्म एनालिटिक्स; RAG मूल्यांकनकर्ता | LLM + RAG + मूल्यांकन | RBAC/VPC विकल्प | सहयोग और प्रयोग पर ध्यान।. |

| लाइटएलएलएम | स्व-होस्ट/ओएसएस | पुनः प्रयास/बैकअप; बजट/सीमाएँ | लॉगिंग/मेट्रिक्स; एडमिन UI | एलएलएम-केंद्रित | पूर्ण इंफ्रा नियंत्रण | OpenAI-संगत; Docker/K8s/Helm परिनियोजन।. |

अक्सर पूछे जाने वाले प्रश्न: RouteLLM बनाम अन्य

RouteLLM बनाम ShareAI — कौन बेहतर है?

चुनें शेयरएआई यदि आप एक पारदर्शी बाजार चाहते हैं जो सतह पर लाता है मूल्य/विलंबता/अपटाइम/उपलब्धता प्रत्येक मार्ग से पहले, प्लस त्वरित फेलओवर और बिल्डर-संरेखित अर्थशास्त्र। चुनें रूटएलएलएम यदि आप शोध-चालित, सीखा हुआ राउटर पसंद करते हैं और इसके चारों ओर इंफ्रा संचालित करने में सहज हैं (गेटवे, लॉगिंग, ऑडिट)। शुरू करें प्लेग्राउंड और मॉडल मार्केटप्लेस.

RouteLLM बनाम Eden AI — क्या अंतर है?

ईडन एआई LLMs को फैलाता है और मल्टीमॉडल (विज़न/OCR, स्पीच, अनुवाद) तुलना और निगरानी के साथ।. रूटएलएलएम LLMs के लिए सीखा हुआ रूटिंग पर केंद्रित है। यदि आपकी रोडमैप को एक API के तहत OCR/स्पीच/अनुवाद की आवश्यकता है, तो Eden AI डिलीवरी को सरल बनाता है; यदि रूटिंग अनुसंधान प्राथमिकता है, तो RouteLLM उपयुक्त है। जब आप प्रति अनुरोध मार्केटप्लेस पारदर्शिता चाहते हैं तो ShareAI के साथ जोड़ें।.

RouteLLM बनाम OpenRouter — प्रत्येक को कब चुनें?

चुनें ओपनराउटर कब प्रॉम्प्ट कैशिंग और वार्म-कैश पुन: उपयोग महत्वपूर्ण है (यह आपको एक ही प्रदाता पर बनाए रखने की प्रवृत्ति रखता है, और आउटेज पर वापस गिरता है)। चुनें रूटएलएलएम सीखी हुई नीतियों के लिए जिन्हें आप स्वयं संचालित करते हैं। कई स्टैक OpenRouter को नीति/अवलोकन के लिए गेटवे के साथ जोड़ते हैं—और फिर भी ShareAI का उपयोग करते हैं जब वे प्रत्येक मार्ग से पहले मार्केटप्लेस पारदर्शिता चाहते हैं।.

RouteLLM बनाम Portkey — राउटर या गेटवे?

रूटएलएलएम एक राउटर है।. पोर्टकी है एक गेटवे: यह नीति/गार्डरेल्स (फॉलबैक प्लेबुक्स, सेमांटिक कैश) और विस्तृत ट्रेस/मेट्रिक्स में उत्कृष्ट है। कई टीमें दोनों चलाती हैं: संगठन-व्यापी नीति के लिए एक गेटवे + मॉडल चयन और लागत नियंत्रण के लिए एक राउटर/मार्केटप्लेस। जब आप प्री-रूट मार्केटप्लेस दृश्यता चाहते हैं तो ShareAI यहां अच्छी तरह से मेल खाता है।.

RouteLLM बनाम Kong AI Gateway — किसे क्या चाहिए?

चुनें कॉन्ग एआई गेटवे कब एज गवर्नेंस (केंद्रीकृत नीति/ऑडिट, डेटा निवास) गैर-परक्राम्य है। बनाए रखें रूटएलएलएम इसके पीछे यदि आप अभी भी मूल्य/प्रदर्शन के लिए सीखा हुआ रूटिंग चाहते हैं। उपयोग करें शेयरएआई alongside when you want to pick providers by मूल्य/विलंबता/अपटाइम/उपलब्धता before each route.

RouteLLM vs Unify — what’s unique about Unify?

एकीकृत करें uses live benchmarks and dynamic policies to optimize for लागत/गति/गुणवत्ता के लिए. If you want data-driven selection that evolves by region/workload, Unify is compelling; रूटएलएलएम focuses on learned routing models you host. Use शेयरएआई when you prefer to choose providers with a marketplace view and instant failover.

RouteLLM vs Orq.ai — which for evaluation & RAG?

ऑर्क.एआई provides an experimentation/evaluation surface (including RAG evaluators), plus deployments and RBAC/VPC. If you need LLMOps + evaluators, Orq.ai may complement or replace a pure router early on. Bring शेयरएआई when you want provider choice with marketplace transparency and resilience in production.

RouteLLM vs LiteLLM — hosted vs self-hosted?

रूटएलएलएम is OSS routing logic; लाइटएलएलएम is an OpenAI-compatible proxy/gateway with budgets, rate limits, and an Admin UI—great if you want to keep traffic inside your VPC and own the control plane. Teams often combine LiteLLM for self-hosting with शेयरएआई for marketplace visibility and instant failover across providers.

Which is cheapest for my workload: RouteLLM, ShareAI, OpenRouter, LiteLLM?

यह मॉडल चयन, क्षेत्र, कैशेबिलिटी, और ट्रैफिक पैटर्न पर निर्भर करता है। राउटर जैसे शेयरएआई/ओपनराउटर रूटिंग और कैश-अवेयर स्टिकनेस के माध्यम से लागत कम कर सकते हैं; गेटवे जैसे पोर्टकी सेमांटिक कैशिंग जोड़ें; लाइटएलएलएम प्लेटफ़ॉर्म ओवरहेड को कम करता है यदि आप इसे संचालित करने में सहज हैं। बेंचमार्क करें आपका प्रॉम्प्ट्स और ट्रैक करें प्रति परिणाम प्रभावी लागत—सिर्फ सूची मूल्य नहीं।.

RouteLLM क्या है?

LLM राउटर को सर्व और मूल्यांकन करने के लिए एक ओपन-सोर्स फ्रेमवर्क; प्रशिक्षित राउटर और OpenAI-संगत पथ प्रदान करता है; अक्सर लागत को काफी हद तक कम करने के लिए उद्धृत किया जाता है जबकि MT-Bench जैसे कार्यों पर GPT-4 गुणवत्ता के करीब रहता है।.

ShareAI को बिना पूर्ण एकीकरण के आज़माने का सबसे तेज़ तरीका क्या है?

खोलें प्लेग्राउंड, एक मॉडल/प्रदाता चुनें, और ब्राउज़र में प्रॉम्प्ट्स चलाएं। जब तैयार हो, एक कुंजी बनाएं और ऊपर दिए गए cURL/JS स्निपेट्स को अपने ऐप में डालें।.

क्या मैं ShareAI प्रदाता बन सकता हूँ और कमाई कर सकता हूँ?

हाँ। कोई भी समुदाय या कंपनी Windows/Ubuntu/macOS या Docker का उपयोग करके प्रदाता। योगदान करें निष्क्रिय-समय बर्स्ट्स या चलाएं हमेशा-चालू. । प्रोत्साहन चुनें: पुरस्कार (पैसा), विनिमय (टोकन/एआई प्रोस्यूमर), या मिशन (NGOs को % दान करें)। देखें प्रदाता गाइड या खोलें प्रदाता डैशबोर्ड.

निष्कर्ष

जबकि रूटएलएलएम एक मजबूत OSS राउटर है, आपकी सबसे अच्छी पसंद प्राथमिकताओं पर निर्भर करती है:

- मार्केटप्लेस पारदर्शिता + लचीलापन: शेयरएआई

- एक API के तहत मल्टीमॉडल कवरेज: ईडन एआई

- होस्टेड फॉर्म में कैश-अवेयर रूटिंग: ओपनराउटर

- एज पर नीति/गार्डरेल्स: Portkey या Kong AI Gateway

- डेटा-ड्रिवन रूटिंग: एकीकृत करें

- LLMOps + मूल्यांकनकर्ता: ऑर्क.एआई

- सेल्फ-होस्टेड कंट्रोल प्लेन: लाइटएलएलएम

यदि मूल्य/विलंबता/अपटाइम/उपलब्धता प्रत्येक रूट से पहले, त्वरित फेलओवर, और बिल्डर-संरेखित अर्थशास्त्र आपकी चेकलिस्ट में हैं, तो खोलें प्लेग्राउंड, एक API कुंजी बनाएं, और ब्राउज़ करें मॉडल मार्केटप्लेस अपनी अगली अनुरोध को स्मार्ट तरीके से मार्गित करने के लिए।.