Alternatif RouteLLM 2026: Kapan Memilih ShareAI (dan Apa Lagi yang Perlu Dipertimbangkan)

Diperbarui Februari 2026

Pengembang memilih RouteLLM untuk mengarahkan prompt ke model yang lebih murah sambil menargetkan kualitas mendekati GPT-4—terutama untuk tugas seperti benchmark di mana router yang dipelajari dapat dengan percaya diri menurunkan tingkat. Tetapi jika Anda lebih peduli tentang transparansi marketplace sebelum setiap rute (harga langsung, latensi, waktu aktif, ketersediaan), failover instan di berbagai penyedia, kebijakan edge dan audit, atau proxy/gateway self-hosted, salah satu dari alternatif RouteLLM mungkin lebih cocok untuk stack Anda.

Panduan pembeli ini ditulis seperti seorang pembangun: trade-off spesifik, pilihan cepat, penjelasan mendalam, perbandingan berdampingan, dan ShareAI quickstart copy-paste sehingga Anda dapat mengirimkan hari ini.

Memahami RouteLLM (dan di mana mungkin tidak cocok)

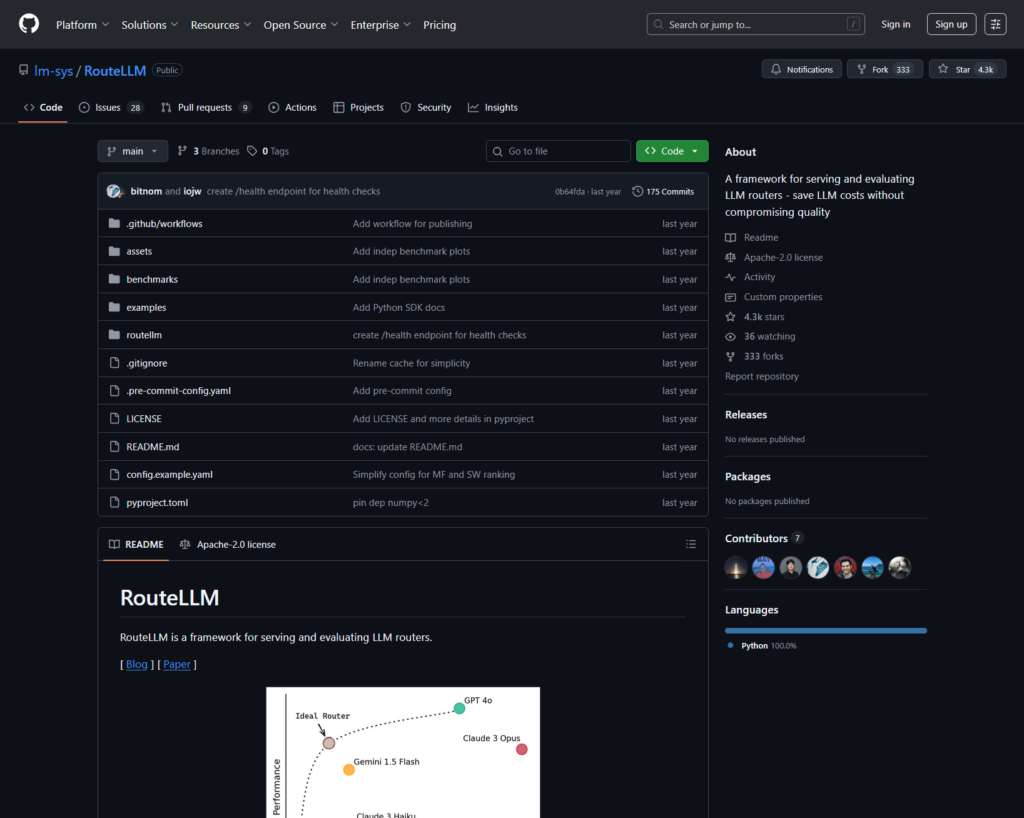

Apa itu RouteLLM. RouteLLM adalah kerangka kerja sumber terbuka untuk melayani dan mengevaluasi router LLM. Ini menawarkan klien/server yang kompatibel dengan OpenAI dan menyediakan model routing yang terlatih yang dapat mengarahkan kueri yang lebih sederhana ke model yang lebih murah—dilaporkan hingga pengurangan biaya 85% sambil mempertahankan ~95% dari kinerja GPT-4 pada benchmark umum (misalnya, MT-Bench).

Mengapa tim memilihnya.

- Routing yang sadar biaya dengan kebijakan yang didukung penelitian.

- Sumber terbuka dan dapat diperluas dalam Python.

- Kompatibel dengan OpenAI jalur untuk mencoba routing tanpa penulisan ulang SDK yang berat.

Di mana RouteLLM mungkin tidak cocok.

- Anda ingin transparansi pasar langsung (harga, latensi, waktu aktif, ketersediaan) sebelum setiap rute—bukan hanya kebijakan yang dipelajari.

- Anda membutuhkan failover multi-penyedia

- Peta jalan Anda mencakup API multimodal seperti OCR, suara, terjemahan, dan parsing dokumen dalam satu tempat.

Cara memilih alternatif RouteLLM

- Total Biaya Kepemilikan (TCO). Jangan berhenti di $/1K token. Hitung tingkat cache hit, pengulangan/fallback, antrian, biaya evaluator, dan beban operasional dari log/alert. Router dan gateway yang sadar cache dengan cache semantik dapat membuat “harga daftar yang lebih mahal” menjadi lebih murah dalam praktiknya.

- Latensi & keandalan. Pilih routing yang sadar wilayah, keterikatan penyedia saat cache hangat, dan fallback yang tepat (ulang 429s, eskalasi pada timeouts). Router yang di-host yang menjaga Anda tetap pada penyedia yang sama untuk konteks hangat dan fallback saat penyedia mengalami gangguan cenderung menang.

- Observabilitas & tata kelola. Jika guardrails, redaksi, log audit, dan kebijakan di tepi penting, gateway AI (Portkey atau Kong AI Gateway) biasanya lebih kuat daripada router murni saja. Banyak tim menggabungkan router + gateway.

- Hosting sendiri vs. dikelola. Lebih suka Docker/K8s/Helm dan proxy yang kompatibel dengan OpenAI? Coba LiteLLM. Ingin kecepatan yang di-host + visibilitas pasar? Pertimbangkan ShareAI atau OpenRouter.

- Luas di luar obrolan. Jika Anda membutuhkan OCR, suara, terjemahan, atau parsing dokumen bersama dengan obrolan LLM, seorang orkestrator multimodal seperti Eden AI membantu.

- Pengarahan berbasis data. Jika Anda lebih memilih tolok ukur langsung untuk mengarahkan biaya/kecepatan/kualitas berdasarkan wilayah atau beban kerja, evaluasi Unify.

Alternatif RouteLLM terbaik (pilihan cepat)

ShareAI (pilihan kami untuk transparansi pasar + ekonomi pembangun)

Satu API di seluruh katalog besar model/penyedia dengan failover instan dan pasar yang muncul harga, latensi, waktu aktif, ketersediaan sebelum Anda mengarahkan. Mulai cepat di Taman bermain, ambil kunci di Konsol, jelajahi Dokumen, dan bandingkan opsi di Model.

Eden AI (orchestrator multimodal)

API Terpadu di seluruh LLM ditambah gambar, OCR/pemrosesan dokumen, suara, dan terjemahan—bersama perbandingan model, pemantauan, caching, dan pemrosesan batch.

OpenRouter (pengarahan sadar cache)

Router yang dihosting di banyak LLM dengan caching prompt dan kekakuan penyedia untuk menggunakan kembali konteks hangat; kembali ketika penyedia tidak tersedia.

Portkey (kebijakan & operasi SRE di gateway)

Gateway AI dengan fallback yang dapat diprogram, buku pedoman pembatasan kecepatan, dan cache semantik—ditambah jejak/metrik terperinci untuk kontrol produksi.

Kong AI Gateway (pengelolaan & audit di edge)

Bawa plugin AI, kebijakan, dan analitik ke ekosistem Kong; sangat cocok saat Anda membutuhkan kontrol edge terpusat di seluruh tim.

Satukan (router berbasis data)

API universal dengan tolok ukur langsung untuk mengoptimalkan biaya/kecepatan/kualitas berdasarkan wilayah dan beban kerja.

Orq.ai (eksperimen & LLMOps)

Eksperimen, evaluator (termasuk metrik RAG), deployment, dan RBAC/VPC—sangat baik saat evaluasi dan tata kelola perlu berjalan bersama.

LiteLLM (proxy/gateway yang di-host sendiri)

Proxy sumber terbuka yang kompatibel dengan OpenAI dengan anggaran/batasan, logging/metrik, dan UI Admin. Deploy dengan Docker/K8s/Helm; Anda mengelola operasinya.

Penjelasan mendalam: alternatif RouteLLM terbaik

ShareAI (API AI yang Didukung oleh Orang)

Apa itu. Jaringan AI berbasis penyedia pertama dan API terpadu. Jelajahi katalog besar model/penyedia dan rute dengan failover instan. Marketplace menampilkan harga, latensi, uptime, dan ketersediaan di satu tempat sehingga Anda dapat memilih penyedia yang tepat sebelum setiap rute. Mulai di Taman bermain, buat kunci di Konsol, dan ikuti API quickstart di Dokumen. Jelajahi Marketplace Model.

- Transparansi pasar — lihat harga/latensi/uptime/ketersediaan di depan.

- Ketahanan-secara-default — failover cepat ke penyedia terbaik berikutnya saat satu mengalami gangguan.

- Ekonomi yang selaras dengan pembangun — sebagian besar pengeluaran mengalir ke penyedia GPU yang menjaga model tetap online.

- Awal tanpa hambatan — uji di Playground, lalu kirimkan.

Fakta penyedia (menghasilkan dengan menjaga model tetap online). Siapa pun dapat menjadi penyedia (Komunitas atau Perusahaan). Onboard melalui Windows/Ubuntu/macOS atau Docker. Kontribusikan ledakan waktu idle atau jalankan selalu aktif. Pilih insentif: Rewards (uang), Exchange (token/AI Prosumer), atau Mission (sumbangkan % ke LSM). Lihat Panduan Penyedia atau buka Dasbor Penyedia.

Ideal untuk. Tim produk yang menginginkan transparansi marketplace, ketahanan, dan ruang untuk berkembang ke mode penyedia—tanpa terkunci oleh vendor.

Eden AI

Apa itu. API terpadu yang mencakup LLM + generasi gambar + OCR/pemrosesan dokumen + suara + terjemahan sehingga Anda tidak perlu menggabungkan beberapa SDK vendor. Mereka juga menekankan perbandingan model, pemantauan, dan batching.

Cocok ketika. Roadmap Anda bersifat multimodal dan Anda ingin mengatur OCR/suara/terjemahan bersama dengan obrolan LLM.

Perhatian. Jika Anda membutuhkan tampilan marketplace per permintaan (harga/latensi/waktu aktif/ketersediaan) atau ekonomi tingkat penyedia, pasangkan router marketplace seperti ShareAI.

OpenRouter

Apa itu. Router LLM terpadu dengan routing penyedia/model. caching prompt. Dengan caching diaktifkan, OpenRouter cenderung menjaga Anda tetap pada penyedia yang sama untuk menggunakan konteks hangat; jika penyedia tersebut tidak tersedia, sistem akan beralih. Ini juga mendukung petunjuk strategi (misalnya, berbasis harga).

Cocok ketika. Anda menginginkan kecepatan yang di-host dan routing yang sadar cache untuk mengurangi biaya dan meningkatkan throughput—terutama dalam beban kerja obrolan QPS tinggi dengan permintaan berulang.

Perhatian. Untuk tata kelola perusahaan yang mendalam (ekspor SIEM, kebijakan tingkat organisasi), banyak tim memasangkan OpenRouter dengan Portkey atau Kong AI Gateway.

Portkey

Apa itu. Gateway AI dengan fallback yang dapat diprogram, buku pedoman batas kecepatan, dan cache sederhana/semantik, ditambah jejak/metrik untuk kontrol gaya SRE. Cache semantik sangat berguna untuk permintaan/pesan pendek ketika ambang batas kesamaan disetel dengan baik.

Cocok ketika. Anda membutuhkan routing berbasis kebijakan dengan observabilitas kelas satu, dan Anda nyaman mengoperasikan lapisan gateway di depan satu atau lebih router/marketplace.

Kong AI Gateway

Apa itu. Gateway edge yang membawa plugin AI, kebijakan, dan analitik ke dalam ekosistem Kong (melalui Konnect atau yang dikelola sendiri). Jika platform API Anda sudah berpusat pada Kong dan Anda membutuhkan kebijakan/audit terpusat, ini adalah pilihan yang kuat.

Cocok ketika. Tata kelola edge, auditabilitas, residensi data, dan kontrol terpusat adalah hal yang tidak dapat dinegosiasikan di lingkungan Anda.

Satukan

Apa itu. Router berbasis data yang mengoptimalkan biaya/kecepatan/kualitas menggunakan tolok ukur langsung, menyesuaikan berdasarkan wilayah dan beban kerja.

Cocok ketika. Anda menginginkan pemilihan yang dipandu oleh tolok ukur yang terus-menerus beradaptasi dengan kinerja dunia nyata.

Orq.ai

Apa itu. Platform kolaborasi AI generatif + LLMOps: eksperimen, evaluator (termasuk metrik RAG), penyebaran, dan RBAC/VPC. Sangat baik ketika evaluasi dan tata kelola perlu hidup bersama.

Cocok ketika. Anda membutuhkan eksperimen + evaluasi dengan tata kelola di satu tempat—kemudian langsung terapkan dari permukaan yang sama.

LiteLLM

Apa itu. Proxy/gateway sumber terbuka dengan endpoint yang kompatibel dengan OpenAI, anggaran & batas kecepatan, logging/metrik, dan UI Admin. Terapkan melalui Docker/K8s/Helm; jaga lalu lintas di jaringan Anda sendiri.

Cocok ketika. Anda menginginkan hosting mandiri dan kontrol infrastruktur penuh dengan kompatibilitas yang sederhana untuk SDK gaya OpenAI yang populer.

Perhatian. Seperti gateway OSS lainnya, Anda memiliki operasi dan pembaruan.

Quickstart: panggil model dalam hitungan menit (ShareAI)

Mulai di Taman bermain, lalu ambil kunci API dan kirimkan. Referensi: Memulai cepat API • Beranda Dokumen • Rilis.

#!/usr/bin/env bash"

// ShareAI — Penyelesaian Chat (JavaScript, Node 18+);

Tip migrasi. Peta model RouteLLM yang Anda pilih saat ini ke model ShareAI yang setara, cerminkan bentuk permintaan/respons, dan mulai di belakang fitur flag. Kirimkan 5–10% lalu lintas terlebih dahulu, bandingkan latensi/biaya/kualitas, lalu tingkatkan. Jika Anda juga menjalankan gateway (Portkey/Kong), pastikan caching/fallback tidak memicu ganda di antara lapisan.

Perbandingan sekilas

| Platform | Dihosting / Self-host | Routing & Fallbacks | Observabilitas | Luas (LLM + lebih dari itu) | Tata Kelola / Kebijakan | Catatan |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Router yang dipelajari; klien/server kompatibel dengan OpenAI | CLI/log; fokus penelitian | Berpusat pada LLM | Kebijakan melalui infrastruktur Anda | Bagus untuk penghemat biaya tingkat penelitian; bawa kontrol edge Anda sendiri. |

| ShareAI | Hosted + jaringan penyedia | Failover instan; pemilihan yang dipandu oleh marketplace | Log penggunaan; statistik marketplace | Katalog model yang luas | Kontrol tingkat penyedia | Marketplace yang didukung oleh orang; mulai dengan Taman bermain dan Model. |

| Eden AI | Dihosting | Beralih penyedia; batch; caching | Pemantauan biaya & API | LLM + gambar + OCR + suara + terjemahan | Penagihan terpusat/manajemen kunci | Orkestrator multimodal. |

| OpenRouter | Dihosting | Routing penyedia/model; caching prompt; kekonsistenan penyedia | Info tingkat permintaan | Berpusat pada LLM | Kebijakan penyedia | Penggunaan ulang cache; fallback saat tidak tersedia. |

| Portkey | Gateway yang dihosting | Fallback kebijakan; playbook pembatasan kecepatan; cache semantik | Jejak/metric | LLM-pertama | Konfigurasi gateway | Guardrail gaya SRE. |

| Kong AI Gateway | Self-host/Perusahaan | Routing upstream melalui plugin AI | Metrik/audit melalui Kong | LLM-pertama | Tata kelola edge yang kuat | Komponen infrastruktur; dipasangkan dengan router/marketplace. |

| Satukan | Dihosting | Routing berbasis data berdasarkan biaya/kecepatan/kualitas | Penjelajah tolok ukur | Berpusat pada LLM | Kebijakan router | Pemilihan berdasarkan panduan benchmark. |

| Orq.ai | Dihosting | Pengulangan/cadangan dalam orkestrasi | Analitik platform; evaluator RAG | LLM + RAG + evaluasi | Opsi RBAC/VPC | Fokus kolaborasi & eksperimen. |

| LiteLLM | Self-host/OSS | Coba ulang/cadangan; anggaran/batas | Logging/metrics; Antarmuka Pengguna Admin | Berpusat pada LLM | Kontrol infra penuh | Kompatibel dengan OpenAI; Deploy Docker/K8s/Helm. |

FAQ: RouteLLM vs. yang lainnya

RouteLLM vs ShareAI — mana yang lebih baik?

Pilih ShareAI jika Anda menginginkan marketplace transparan yang menampilkan harga/latensi/waktu aktif/ketersediaan sebelum setiap rute, ditambah failover instan dan ekonomi yang selaras dengan pembangun. Pilih RouteLLM jika Anda lebih suka router berbasis penelitian, yang dipelajari dan Anda nyaman mengoperasikan infra di sekitarnya (gateway, logging, audit). Mulailah dengan Taman bermain dan Marketplace Model.

RouteLLM vs Eden AI — apa bedanya?

Eden AI mencakup LLM dan multimodal (visi/OCR, ucapan, terjemahan) dengan perbandingan dan pemantauan. RouteLLM berfokus pada routing yang dipelajari untuk LLM. Jika roadmap Anda membutuhkan OCR/ucapan/terjemahan dalam satu API, Eden AI menyederhanakan pengiriman; jika penelitian routing adalah prioritas, RouteLLM cocok. Pasangkan dengan ShareAI saat Anda menginginkan transparansi pasar per permintaan.

RouteLLM vs OpenRouter — kapan memilih masing-masing?

Pilih OpenRouter kapan caching prompt dan penggunaan ulang cache hangat penting (cenderung membuat Anda tetap pada penyedia yang sama, dan kembali pada saat gangguan). Pilih RouteLLM untuk kebijakan yang dipelajari yang Anda operasikan sendiri. Banyak stack memasangkan OpenRouter dengan gateway untuk kebijakan/observabilitas—dan tetap menggunakan ShareAI saat mereka menginginkan transparansi pasar sebelum setiap rute.

RouteLLM vs Portkey — router atau gateway?

RouteLLM adalah router. Portkey adalah gerbang: ini unggul dalam kebijakan/pengaman (buku pedoman fallback, cache semantik) dan jejak/metrik yang terperinci. Banyak tim menjalankan keduanya: gateway untuk kebijakan organisasi + router/pasar untuk pilihan model dan kontrol biaya. ShareAI cocok di sini saat Anda menginginkan visibilitas pasar sebelum rute.

RouteLLM vs Kong AI Gateway — siapa yang membutuhkan yang mana?

Pilih Kong AI Gateway kapan tata kelola edge (kebijakan/audit terpusat, residensi data) tidak dapat dinegosiasikan. Tetap RouteLLM di belakangnya jika Anda masih menginginkan routing yang dipelajari untuk harga/kinerja. Gunakan ShareAI bersama-sama ketika Anda ingin memilih penyedia berdasarkan harga/latensi/waktu aktif/ketersediaan sebelum setiap rute.

RouteLLM vs Unify — apa yang unik tentang Unify?

Satukan menggunakan tolok ukur langsung dan kebijakan dinamis untuk mengoptimalkan biaya/kecepatan/kualitas. Jika Anda menginginkan pemilihan berbasis data yang berkembang berdasarkan wilayah/beban kerja, Unify sangat menarik; RouteLLM berfokus pada model routing yang dipelajari yang Anda hosting. Gunakan ShareAI ketika Anda lebih suka memilih penyedia dengan tampilan pasar dan failover instan.

RouteLLM vs Orq.ai — mana untuk evaluasi & RAG?

Orq.ai menyediakan permukaan eksperimen/evaluasi (termasuk evaluator RAG), ditambah penerapan dan RBAC/VPC. Jika Anda membutuhkan LLMOps + evaluator, Orq.ai dapat melengkapi atau menggantikan router murni di awal. Bawa ShareAI ketika Anda menginginkan pilihan penyedia dengan transparansi pasar dan ketahanan dalam produksi.

RouteLLM vs LiteLLM — dihosting vs self-hosted?

RouteLLM adalah logika routing OSS; LiteLLM adalah proxy/gateway kompatibel OpenAI dengan anggaran, batasan tingkat, dan UI Admin—sangat bagus jika Anda ingin menjaga lalu lintas tetap di dalam VPC Anda dan memiliki control plane. Tim sering menggabungkan LiteLLM untuk self-hosting dengan ShareAI untuk visibilitas pasar dan failover instan di seluruh penyedia.

Mana yang termurah untuk beban kerja saya: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Itu tergantung pada pilihan model, wilayah, kemampuan cache, dan pola lalu lintas. Router seperti ShareAI/OpenRouter dapat mengurangi biaya melalui routing dan stickiness yang sadar cache; gateway seperti Portkey menambahkan caching semantik; LiteLLM mengurangi overhead platform jika Anda nyaman mengoperasikannya. Benchmark dengan infrastruktur prompt dan melacak biaya efektif per hasil—bukan hanya harga daftar.

Apa itu RouteLLM?

Kerangka kerja sumber terbuka untuk melayani dan mengevaluasi router LLM; menyediakan router yang telah dilatih dan jalur yang kompatibel dengan OpenAI; sering disebut dapat mengurangi biaya secara signifikan sambil mempertahankan kualitas mendekati GPT-4 pada tugas seperti MT-Bench.

Apa cara tercepat untuk mencoba ShareAI tanpa integrasi penuh?

Buka Taman bermain, pilih model/penyedia, dan jalankan prompt di browser. Ketika siap, buat kunci dan masukkan cuplikan cURL/JS di atas ke dalam aplikasi Anda.

Bisakah saya menjadi penyedia ShareAI dan mendapatkan penghasilan?

Ya. Siapa pun dapat bergabung sebagai Komunitas atau Perusahaan penyedia menggunakan Windows/Ubuntu/macOS atau Docker. Berkontribusi waktu-idle ledakan atau jalankan selalu aktif. Pilih insentif: Hadiah (uang), Pertukaran (token/AI Prosumer), atau Misi (sumbangkan % ke LSM). Lihat Panduan Penyedia atau buka Dasbor Penyedia.

Kesimpulan

Sementara RouteLLM adalah router OSS yang kuat, pilihan terbaik Anda tergantung pada prioritas:

- Transparansi pasar + ketahanan: ShareAI

- Cakupan multimodal dalam satu API: Eden AI

- Routing yang sadar cache dalam bentuk yang dihosting: OpenRouter

- Kebijakan/pengaman di edge: Portkey atau Kong AI Gateway

- Routing berbasis data: Satukan

- LLMOps + evaluator: Orq.ai

- Pesawat kontrol yang dihosting sendiri: LiteLLM

Jika harga/latensi/waktu aktif/ketersediaan sebelum setiap rute, failover instan, dan ekonomi yang selaras dengan pembangun ada di daftar periksa Anda, buka Taman bermain, buat kunci API, dan jelajahi Marketplace Model untuk merutekan permintaan Anda berikutnya dengan cara yang cerdas.