Requestyの代替案2026: ShareAI対Eden AI、OpenRouter、Portkey、Kong AI、Unify、Orq & LiteLLM

更新日 2026年2月

開発者が選ぶ リクエスティ 多くのLLMプロバイダーにわたる単一のOpenAI互換ゲートウェイに加えて、ルーティング、分析、ガバナンスのために。しかし、もしあなたがより気にするのは 各ルート前のマーケットプレイスの透明性 (価格、遅延、稼働時間、可用性)、, 厳格なエッジポリシー, 、または 自己ホスト型プロキシ, 、これらのうちの一つ Requestyの代替案 があなたのスタックにより適しているかもしれません。.

この購入者ガイドはビルダーのように書かれています:具体的なトレードオフ、明確なクイックピック、深い分析、並列比較、そしてコピー&ペーストの シェアAI クイックスタートで今日出荷できるようにします。.

Requestyを理解する(そしてそれが適合しない場合)

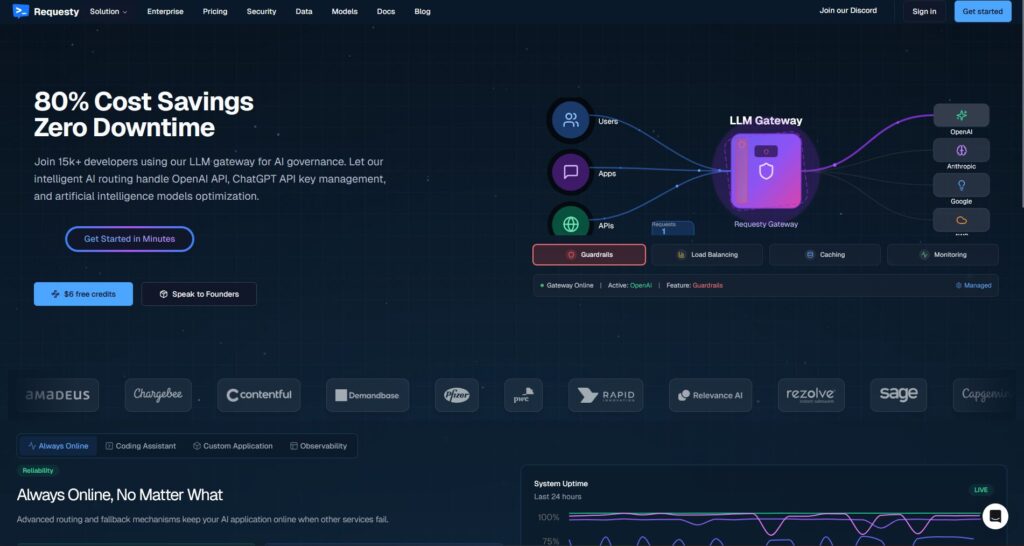

Requestyとは何か。. RequestyはLLMです ゲートウェイ. OpenAI互換クライアントをRequestyエンドポイントに向け、複数のプロバイダー/モデル間でリクエストをルーティングします—しばしばフェイルオーバー、分析、ポリシーガードレールを伴います。それは設計されています 単一の場所 で使用状況を管理し、コストを監視し、AIコール全体でガバナンスを強制するために。.

チームがそれを選ぶ理由。.

- 1つのAPI、多くのプロバイダー。. SDKの乱立を減らし、観測性を集中化します。.

- フェイルオーバーとルーティング。. プロバイダーが一時的に停止しても稼働時間を安定させます。.

- エンタープライズガバナンス。. 中央ポリシー、組織レベルのコントロール、使用予算。.

Requestyが適さない場合。.

- あなたが望むのは 各ルート前のマーケットプレイスの透明性 (価格、遅延、稼働時間、プロバイダーごとの現在の可用性を確認し、それから選択)。.

- あなたが必要なのは エッジグレードポリシー 独自のスタック内(例: Kong, Portkey)または セルフホスティング (LiteLLM)。.

- あなたのロードマップには必要です 幅広いマルチモーダル 機能を1つのプラットフォームで提供すること(OCR、音声、翻訳、文書解析)—LLMチャットを超えて、ShareAIのようなオーケストレーターがより適している場合があります。.

Requestyの代替を選ぶ方法

1) 総所有コスト(TCO)。. $/1Kトークンで止まらないでください。以下を含めてください キャッシュヒット率, 、リトライ/フォールバック、キューイング、評価コスト、リクエストごとのオーバーヘッド、観測性/アラートの運用負担。「最安値のリスト価格」は、無駄を削減するルーター/ゲートウェイに負けることがよくあります。.

2) レイテンシーと信頼性。. 優先するのは リージョン対応のルーティング, 、ウォームキャッシュの再利用(プロンプトキャッシュがアクティブな場合は同じプロバイダーを使用)、および正確なフォールバック(429エラーの再試行、タイムアウト時のエスカレーション、重複支出を避けるためのファンアウト制限)。.

3)可観測性とガバナンス。. ガードレール、監査ログ、編集、 エッジでのポリシー が重要であれば、ゲートウェイのような ポートキー または コングAIゲートウェイ は純粋なアグリゲーターよりも強力であることが多いです。多くのチームは ルーター + ゲートウェイ を組み合わせて最適な結果を得ています。.

4)セルフホスト vs マネージド。. Docker/K8s/Helm と OpenAI 互換エンドポイントを好みますか?参照 LiteLLM (OSS)または コングAIゲートウェイ (エンタープライズインフラ)。 ホスト型のスピード + マーケットプレイスの可視性が必要ですか?参照 シェアAI (私たちの選択)、, オープンルーター, 、または 統一.

5) チャットを超えた広がり。. ロードマップにOCR、音声からテキストへの変換、翻訳、画像生成、文書解析を1つのオーケストレーターの下で含める場合、, シェアAI 配信とテストを簡素化できます。.

6) 将来への備え。. モデル/プロバイダーの交換を容易にする ツールを選択してください (ユニバーサルAPI、動的ルーティング、明示的なモデルエイリアス)を使用して、書き換えなしで新しい/安価な/高速なオプションを採用できるようにします。.

Requestyの最良の代替案(クイックピック)

シェアAI (マーケットプレイスの透明性 + ビルダー経済学に関する私たちの選択)

1つのAPIで 150以上のモデル 即時フェイルオーバーと マーケットプレイスではありません 表示する 価格、遅延、稼働時間、可用性 ルートする前に. 。プロバイダー(コミュニティまたは企業)は保持します 収益の大部分, 、信頼性とインセンティブを一致させる。迅速に開始して プレイグラウンド, 、キーを取得して コンソール, 、そして読む ドキュメント.

エデンAI (マルチモーダルオーケストレーター)

LLM間の統一API に加えて 画像、OCR/ドキュメント解析、音声、翻訳—とともに モデル比較, 、モニタリング、キャッシング、バッチ処理。.

オープンルーター (キャッシュ対応ルーティング)

多くのLLMにわたるホスト型ルーター プロンプトキャッシング とプロバイダーのスティッキネスでウォームコンテキストを再利用;プロバイダーが利用不可になった場合にフォールバック。.

ポートキー (ゲートウェイでのポリシー&SRE運用)

AIゲートウェイと プログラム可能なフォールバック, レート制限プレイブック, 、そして シンプル/セマンティックキャッシュ, 、さらに本番環境制御のための詳細なトレース/メトリクス。.

コングAIゲートウェイ (エッジガバナンス&監査)

持ち込む AIプラグイン、ポリシー、分析 Kongエコシステムへ;チーム間で集中管理が必要な場合、マーケットプレイスルーターと相性が良い。.

統一 (データ駆動型ルーター)

ユニバーサルAPIと ライブベンチマーク 地域やワークロードごとにコスト/速度/品質を最適化するために。.

オルク.ai (実験&LLMOps)

実験、評価者( RAG メトリクスを含む)、デプロイメント、RBAC/VPC—評価とガバナンスを一緒に運用する必要がある場合に最適。.

LiteLLM (セルフホスト型プロキシ/ゲートウェイ)

オープンソース、OpenAI互換のプロキシで 予算/制限, 、ログ/メトリクス、そして管理UIを備えています。Docker/K8s/Helmでデプロイ可能で、運用はあなた自身が管理します。.

詳細分析:トップ代替案

ShareAI(人々が支えるAI API)

それが何であるか。. プロバイダー優先のAIネットワークと統一API。多数のモデル/プロバイダーのカタログを閲覧し、ルート設定が可能です。 即時フェイルオーバー. 。マーケットプレイスでは 価格、遅延、稼働時間、利用可能性 を一箇所で確認できるため、 各ルートの前に適切なプロバイダーを選択できます。. 。まずは プレイグラウンド, で始め、 コンソール, でキーを作成し、 APIクイックスタート.

をフォローしてください。.

- マーケットプレイスの透明性 チームがこれを選ぶ理由。 価格/遅延/稼働時間/可用性 — プロバイダーを事前に確認できます。.

- デフォルトでのレジリエンス — 高速 フェイルオーバー 一つが停止した際に次の最適なプロバイダーへ。.

- ビルダーに合わせた経済性 — 支出の大部分がモデルをオンラインに保つGPUプロバイダーに流れる。.

- 摩擦のないスタート — モデルを閲覧, 、テストを行い プレイグラウンド, 、そして出荷。.

プロバイダーファクト(モデルをオンラインに保つことで収益を得る)。. 誰でもプロバイダーになれる(コミュニティまたは企業)。以下を通じてオンボード: Windows/Ubuntu/macOS/Docker. 。貢献する アイドルタイムバースト または実行 常時オン. 。インセンティブを選択: 報酬 (お金)、, 交換 (トークン/AIプロシューマー)、または ミッション (NGOに1%を寄付)。スケールするにつれて、, 独自の推論価格を設定できます そして得る 市場での優先的な露出. 。詳細: プロバイダーガイド.

理想的な用途:. 製品チームが求める 使用ケース, 耐障害性, 、そして 成長の余地 プロバイダーモードへの移行—ベンダーロックインなしで。.

エデンAI

それが何であるか。. 統一されたAPIがカバーするのは LLMs + 画像生成 + OCR/ドキュメント解析 + 音声 + 翻訳, 、複数のベンダーSDKをつなぎ合わせる必要を排除します。. モデル比較 プロバイダーを並べてテストするのを支援します。また、強調するのは コスト/APIモニタリング, バッチ処理, 、そして キャッシング.

適している場合。. あなたのロードマップが マルチモーダルである そして、単一のインターフェースからOCR/音声/翻訳をLLMチャットと一緒にオーケストレーションしたい場合。.

注意点。. 必要な場合は リクエストごとのマーケットプレイスビュー (価格/遅延/稼働時間/可用性)またはプロバイダーレベルの経済性を考慮し、マーケットプレイススタイルのルーターを検討してください シェアAI Edenのマルチモーダル機能と共に.

オープンルーター

それが何であるか。. 統一されたLLMルーター プロバイダー/モデルルーティング と プロンプトキャッシング. キャッシュが有効になっている場合、OpenRouterは 同じプロバイダー を使用してウォームコンテキストを再利用しようとします。そのプロバイダーが利用できない場合は フォールバック して次善のものに切り替わります.

適している場合。. あなたが望むのは ホストされた速度 と キャッシュ対応ルーティング コストを削減しスループットを向上させるために—特に高QPSのチャットワークロードで繰り返しプロンプトがある場合に.

注意点。. 深い エンタープライズガバナンスのために (例:SIEMエクスポート、組織全体のポリシー)、多くのチーム OpenRouterをPortkeyまたはKong AI Gatewayと組み合わせる.

ポートキー

それが何であるか。. AI オペレーションプラットフォーム + ゲートウェイ プログラム可能な フォールバック, レート制限プレイブック, 、そして シンプル/セマンティックキャッシュ, 、さらに トレース/メトリクス SREスタイルの制御のために。.

- ネストされたフォールバックと条件付きルーティング — リトリーツリーを表現(例:429をリトライ;5xxで切り替え;レイテンシスパイクで切り替え)。.

- セマンティックキャッシュ — 短いプロンプト/メッセージでよく勝つ(制限あり)。.

- 仮想キー/予算 — チーム/プロジェクトの使用をポリシー内に維持。.

適している場合。. あなたが必要なのは ポリシー駆動のルーティング 一流の観測性を備え、操作に慣れている ゲートウェイ 1つ以上のルーター/マーケットプレイスの前に配置されるレイヤー。.

コングAIゲートウェイ

それが何であるか。. の拡張機能 エッジゲートウェイ をもたらす AIプラグイン、ガバナンス、アナリティクス をKongエコシステムに統合します(Konnectまたはセルフマネージド経由)。これはインフラストラクチャであり、APIプラットフォームがすでにKongを中心に展開されている場合に適しています。 中央ポリシー/監査.

適している場合。. エッジガバナンス, 監査可能性, データ居住性, 、そして 集中管理 が環境内で譲れない要件である場合。.

注意点。. 期待してください セットアップとメンテナンス. 。多くのチームが Kongをマーケットプレイスルーターと組み合わせています (例:ShareAI/OpenRouter)プロバイダーの選択とコスト管理のため。.

統一

それが何であるか。. A データ駆動型ルーター を最適化する コスト/速度/品質のために 使用して ライブベンチマーク. 。それは公開します ユニバーサルAPI そして、地域/ワークロードごとにモデルの選択を更新します。.

適している場合。. あなたが望むのは ベンチマークに基づく選択 実際のパフォーマンスに継続的に適応します。.

オルク.ai

それが何であるか。. 生成的AI コラボレーション + LLMOps プラットフォーム:実験、評価者( RAG コンテキストの関連性/忠実性/堅牢性のような指標を含む)、デプロイメント、および RBAC/VPC.

適している場合。. あなたが必要なのは 実験 + 評価 ガバナンスを一元化し、同じインターフェースから直接デプロイします。.

LiteLLM

それが何であるか。. の拡張機能 オープンソースのプロキシ/ゲートウェイ と OpenAI互換 エンドポイント、, 予算とレート制限, 、ログ/メトリクス、および管理UI。デプロイは Docker/K8s/Helm; を使用して行い、トラフィックを自分のネットワーク内に保持します。.

適している場合。. あなたが望むのは セルフホスティング と 完全なインフラ制御 で、人気のあるOpenAIスタイルSDKとの簡単な互換性を提供します。.

注意点。. 他のOSSゲートウェイと同様に、, 運用とアップグレードは自己管理です. 。監視、スケーリング、セキュリティ更新のための時間を確保してください。.

クイックスタート:数分でモデルを呼び出す(ShareAI)

まずは開始して プレイグラウンド, 、APIキーを取得して出荷します。参考: APIクイックスタート • ドキュメントホーム • リリース.

#!/usr/bin/env bash"

1. // ShareAI — チャット完了 (JavaScript, Node 18+);

// 使用方法: // SHAREAI_API_KEY="YOUR_KEY" node chat.js const API_URL = "https://api.shareai.now/v1/chat/completions";. const API_KEY = process.env.SHAREAI_API_KEY; async function main() {, if (!API_KEY) { throw new Error("環境変数にSHAREAI_API_KEYがありません"); const res = await fetch(API_URL, {.

一目で比較

| プラットフォーム | ホスト型 / セルフホスト | ルーティング & フォールバック | 可観測性 | 幅広さ (LLM + それ以上) | ガバナンス/ポリシー | メモ |

|---|---|---|---|---|---|---|

| リクエスティ | ホスト型 | method: "POST", | headers: { | Authorization: `Bearer ${API_KEY}`, | "Content-Type": "application/json" | },. |

| シェアAI | body: JSON.stringify({ | 即時フェイルオーバー; マーケットプレイス主導のルーティング | 使用ログ; マーケットプレイス統計 | 幅広いモデルカタログ | プロバイダーレベルのコントロール | 人力駆動のマーケットプレイス; 始めるには プレイグラウンド. |

| エデンAI | ホスト型 | プロバイダーの切り替え; バッチ; キャッシング | コスト & API モニタリング | LLM + 画像 + OCR + 音声 + 翻訳 | 中央請求/キー管理 | モデル比較でプロバイダーを並べてテスト. |

| オープンルーター | ホスト型 | プロバイダー/モデルのルーティング; プロンプトキャッシング | リクエストレベルの情報 | LLM中心 | プロバイダーポリシー | サポートされている場合のキャッシュ再利用; 利用不可時のフォールバック. |

| ポートキー | ホスティング & ゲートウェイ | ポリシーフォールバック; レート制限プレイブック; セマンティックキャッシュ | トレース/メトリクス | LLM優先 | ゲートウェイ設定 | SREスタイルのガードレールと組織ポリシーに最適です。. |

| コングAIゲートウェイ | セルフホスト/エンタープライズ | AIプラグインを介したアップストリームルーティング | Kongを介したメトリクス/監査 | LLM優先 | 強力なエッジガバナンス | インフラコンポーネント;ルーター/マーケットプレイスと組み合わせ可能。. |

| 統一 | ホスト型 | データ駆動のルーティング コスト/速度/品質による | ベンチマークエクスプローラー | LLM中心 | ルーターの設定 | ベンチマークに基づくモデル選択。. |

| オルク.ai | ホスト型 | オーケストレーションでのリトライ/フォールバック | プラットフォーム分析;; RAG評価ツール | LLM + RAG + 評価 | RBAC/VPCオプション | コラボレーションと実験に注力。. |

| LiteLLM | セルフホスト/OSS | リトライ/フォールバック; 予算/制限 | ロギング/メトリクス; 管理UI | LLM中心 | 完全なインフラ制御 | OpenAI互換; Docker/K8s/Helmデプロイ。. |

よくある質問

Requestyとは何ですか?

LLMです ゲートウェイ 監視、ガバナンス、コスト管理を備えた単一のOpenAI互換APIを介したマルチプロバイダールーティングを提供します。.

Requestyの最良の代替案は何ですか?

トップピックには以下が含まれます シェアAI (マーケットプレイストランスペアレンシー + 即時フェイルオーバー)、, エデンAI (マルチモーダルAPI + モデル比較)、, オープンルーター (キャッシュ対応ルーティング)、, ポートキー (ポリシーとセマンティックキャッシュを備えたゲートウェイ)、, コングAIゲートウェイ (エッジガバナンス)、, 統一 (データ駆動型ルーター)、, オルク.ai (LLMOps/評価者)、および LiteLLM (セルフホスト型プロキシ)。.

Requesty vs ShareAI — どちらが優れている?

選択する シェアAI あなたが望む場合 透明なマーケットプレイス 表示する 価格/遅延/稼働時間/可用性をルート設定前に確認する, 、さらに即時フェイルオーバーとビルダーに合わせた経済性を提供します。選択する リクエスティ もしエンタープライズガバナンスを備えた単一のホスト型ゲートウェイを好み、市場の視点なしでプロバイダーを選ぶことに慣れている場合。ShareAIを試してみてください モデルマーケットプレイス と プレイグラウンド.

Requesty vs Eden AI — 違いは何ですか?

エデンAI 範囲 LLMs + マルチモーダル (ビジョン/OCR、音声、翻訳)を含みます モデル比較; リクエスティ より多くの LLM中心 ルーティング/ガバナンスを備えています。もしあなたのロードマップが1つのAPIでOCR/音声/翻訳を必要とする場合、Eden AIは配信を簡素化します;ゲートウェイスタイルのルーティングにはRequestyが適しています。.

Requesty vs OpenRouter — それぞれを選ぶタイミングは?

選択する オープンルーター いつ プロンプトキャッシング と ウォームキャッシュ再利用 問題(同じプロバイダーを維持し、障害時にフォールバックする傾向があります)。選択 リクエスティ 単一ルーターを使用したエンタープライズガバナンスの場合、キャッシュ対応プロバイダースティッキネスが最優先でない場合。.

Requesty vs Portkey vs Kong AI Gateway — ルーターまたはゲートウェイ?

リクエスティ ルーターです。. ポートキー と コングAIゲートウェイ です ゲートウェイです: 彼らは優れています ポリシー/ガードレール (フォールバック、レート制限、分析、エッジガバナンス)。多くのスタックは使用します 両方: 組織全体のポリシーのためのゲートウェイ + モデル選択とコスト管理のためのルーター/マーケットプレイス。.

Requesty vs Unify — Unifyのユニークな点は何ですか?

統一 使用します ライブベンチマーク そして動的ポリシーを使用してコスト/速度/品質を最適化します。もしあなたが望むなら データ駆動型ルーティング 地域やワークロードによって進化する場合、Unifyは魅力的です;Requestyはゲートウェイスタイルのルーティングとガバナンスに焦点を当てています。.

Requesty vs Orq.ai — 評価とRAGにはどちらが適しているか?

オルク.ai 提供する 実験/評価 表面(RAG評価者を含む)、さらにデプロイメントとRBAC/VPC。必要であれば LLMOps + 評価者, 、Orq.aiは初期段階でルーターを補完または置き換える可能性があります。.

Requesty vs LiteLLM — ホスト型 vs 自己ホスト型?

リクエスティ ホスト型です。. LiteLLM は 自己ホスト型プロキシ/ゲートウェイ と 予算とレート制限 と管理UI;トラフィックをVPC内に保持し、制御プレーンを所有したい場合に最適です。.

私のワークロードに最も安価なのはどれか:Requesty、ShareAI、OpenRouter、LiteLLM?

それは以下によります モデル選択、地域、キャッシュ可能性、そしてトラフィックパターン. ルーターのように シェアAI/OpenRouter ルーティングとキャッシュ対応のスティッキネスを通じてコストを削減できます。ゲートウェイのように ポートキー が追加します セマンティックキャッシング; LiteLLM を使用すると、運用に慣れている場合、プラットフォームのオーバーヘッドを削減できます。ベンチマークを あなたのプロンプトで 実施し、追跡してください 結果ごとの実効コストを—リスト価格だけではありません。.

RequestyからShareAIへの移行を最小限のコード変更で行うにはどうすればよいですか?

モデルをShareAIの同等品にマッピングし、リクエスト/レスポンスの形状をミラーリングし、背後で開始してください。 const API_URL = "https://api.shareai.now/v1/chat/completions";. 最初に小規模な%をルート設定し、レイテンシー/コスト/品質を比較してから増加させます。また、ゲートウェイを運用している場合は、 throw new Error("環境変数にSHAREAI_API_KEYがありません"); 層間で二重トリガーが発生しないようにしてください。.

この記事は「Requestlyの代替案」についてもカバーしていますか?(Requesty vs Requestly)

はい—リクエストリー (と L)は 開発者/QAツールスイート (HTTPインターセプション、APIモック/テスト、ルール、ヘッダー)であり、 LLMルーターではありません. 。もしあなたが探しているのが リクエストリーの代替品, であれば、おそらく比較しているのは ポストマン, フィドラー, mitmproxy, などでしょう。もしあなたが意味しているのが リクエスティ (LLMゲートウェイ)であれば、このガイドの代替案を使用してください。ライブでチャットしたい場合は、ミーティングを予約してください: meet.growably.ro/team/shareai.

ShareAIを完全に統合せずに試す最速の方法は何ですか?

ShareAIプロバイダーになって収益を得ることはできますか?

はい。誰でも コミュニティ または 企業 プロバイダーとしてオンボードできます Windows/Ubuntu/macOS または ドッカー. 。貢献する アイドルタイムバースト または実行 常時オン. を使用して。選択してください 報酬 (お金)、, 交換 (トークン/AIプロシューマー)、または ミッション (NGOに%を寄付)。以下を参照してください プロバイダーガイド.

Requestyの「最高の」代替手段は一つだけですか?

すべてのチームにとって単一の勝者はありません 。もしあなたが マーケットプレイスの透明性 + 即時フェイルオーバー + ビルダー経済性, を重視するなら、まずは シェアAI. 用 マルチモーダルである ワークロード(OCR/音声/翻訳)、見る エデンAI. 必要であれば エッジガバナンス, 、評価する ポートキー または コングAIゲートウェイ. 。好む セルフホスティング?検討する LiteLLM.

結論

一方で リクエスティ は強力なLLMゲートウェイですが、最適な選択は優先順位によります:

- マーケットプレイスの透明性+回復力: シェアAI

- 1つのAPIでのマルチモーダル対応: エデンAI

- ホスト形式でのキャッシュ対応ルーティング: オープンルーター

- エッジでのポリシー/ガードレール: ポートキー または コングAIゲートウェイ

- データ駆動型ルーティング: 統一

- LLMOps+評価者: オルク.ai

- セルフホスト型コントロールプレーン: LiteLLM

プロバイダーを選ぶ場合 各ルートの前に価格/遅延/稼働時間/可用性, 即時フェイルオーバー, 、そして ビルダーに合わせた経済性 チェックリストにある場合、開く プレイグラウンド, APIキーを作成する, 、そして閲覧する モデルマーケットプレイス 次のリクエストをスマートにルートする方法。.