GitLab AI Gatewayの代替案2026 — トップ10

更新日 2026年2月

評価中の場合 GitLab AI Gateway の代替案, 、このガイドはビルダーのように風景をマッピングします。まず、GitLab の AI Gateway レーンが何であるかを明確にします—出力ガバナンスである場合 (集中管理された認証情報/ポリシー)、 LLM 対応の制御レイヤー, 、そして 可観測性—その後、比較します 10 の最良の代替案. を配置します シェアAI チームが望む場合に最初に 多くのプロバイダーにわたる1つのAPI, 、 透明なマーケットプレイス と 価格 / レイテンシー / 稼働時間 / 可用性 前に ルーティング、, 即時フェイルオーバー, 、そして 人々による経済学 (収益の 70% がプロバイダー—コミュニティまたは企業—に還元されます)。.

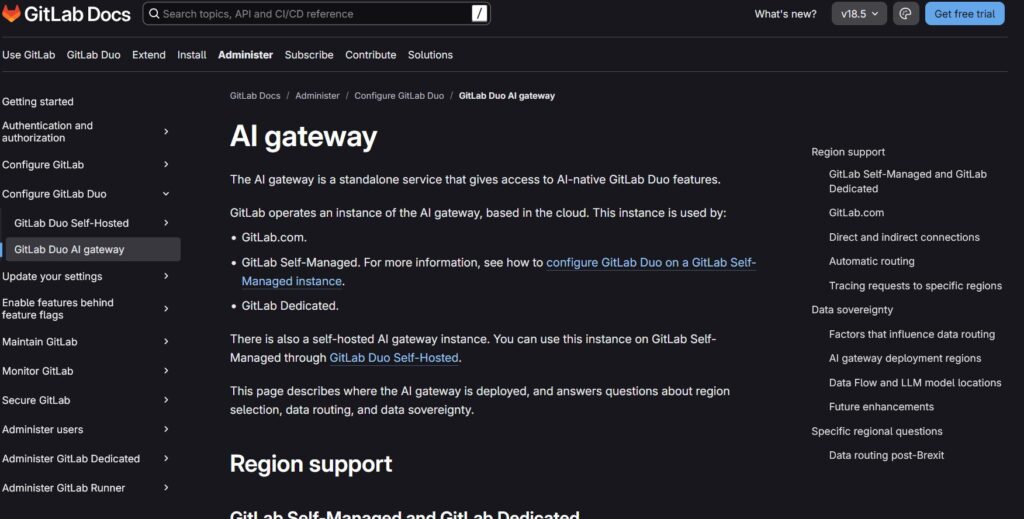

GitLab AI Gateway とは何か(そして何ではないか)

それが何であるか。. ポリシー、キー管理、可観測性を使用して AI トラフィックをルーティングすることに焦点を当てたガバナンス優先のレイヤー—アプリケーションチームが、他のプロダクション API に適用するのと同じ規律で LLM の使用を制御できるようにします。.

何でないか。. 中立的なマーケットプレイスで、あなたを助けます 選択 プロバイダー/モデルを リアルタイムの価格、レイテンシー、稼働時間、可用性に基づいて または 自動的にフェイルオーバーします 複数のプロバイダー間で。ゲートウェイは制御を標準化します;; アグリゲーター 選択肢と回復力を最適化します。.

アグリゲーター vs ゲートウェイ vs エージェントプラットフォーム(簡単な入門編)

- LLMアグリゲーター。. 多くのモデル/プロバイダーにわたる1つのAPI 事前ルートの透明性 (価格、遅延、稼働時間、可用性、プロバイダータイプ)、さらに スマートルーティング/フェイルオーバー.

- AIゲートウェイ。. エッジでのポリシー/ガバナンス (認証情報、レート制限、安全策)、さらに 可観測性. プロバイダーを持ち込む。. GitLab AI Gatewayはここにあります。.

- エージェント/チャットボットプラットフォーム。. パッケージ化されたUX、メモリ/ツール、チャネル—エンドユーザーアシスタントに最適、プロバイダー非依存のルーティングではありません。.

GitLab AI Gatewayのベストな代替案を評価する方法

- モデルの幅広さと中立性。. 独自+オープン;書き換えなしでプロバイダーを切り替え可能。.

- レイテンシーと回復力。. ルーティングポリシー、タイムアウト、リトライ、, 即時フェイルオーバー.

- ガバナンスとセキュリティ。. キーハンドリング、スコープ、地域ルーティング、ガードレール。.

- 可観測性。. ログ/トレースとコスト/レイテンシーダッシュボード。.

- 価格の透明性とTCO。. 比較 実際の ルーティングする前にコストを確認してください。.

- 開発者体験。. ドキュメント、SDK、クイックスタート;; 初回トークンまでの時間.

- コミュニティと経済性。. 支出が供給を増やすかどうか(GPU所有者へのインセンティブ;公正な収益分配)。.

GitLab AI Gatewayのトップ10代替案

#1 — ShareAI(人々が支えるAI API)

それが何であるか。. A マルチプロバイダーAPI と 透明なマーケットプレイス と スマートルーティング. 1つの統合で、モデルとプロバイダーの大規模なカタログを閲覧し、比較 価格、遅延、稼働時間、可用性、プロバイダータイプ, 、そしてルート設定を行う 即時フェイルオーバー. 経済は人々によって支えられています: 70%のすべてのドルがプロバイダーに流れる (コミュニティまたは企業)モデルをオンラインで維持する人々へ。.

なぜここが#1なのか。. もしあなたが望むなら プロバイダーに依存しない集約 と 事前ルートの透明性 と 耐障害性, 、ShareAIは最も直接的に適しています。組織全体のポリシーが必要ならゲートウェイを維持し、ShareAIを追加して マーケットプレイス主導のルーティング と “「常時稼働」の可用性 提供します。.

- 1つのAPI → 150以上のモデル 多くのプロバイダーにわたって;書き換えなし、ロックインなし。.

- 透明なマーケットプレイス: 選択基準 価格、遅延、稼働時間、可用性、プロバイダータイプ.

- デフォルトでの回復力: ルーティングポリシー + 即時フェイルオーバー.

- 公正な経済: 支出の70%がプロバイダーに向かう, 、コミュニティに価値を還元します。.

クイックリンク — モデルを閲覧 · プレイグラウンドを開く · APIキーを作成 · APIリファレンス · ユーザーガイド · リリース

プロバイダー向け:モデルをオンラインに保つことで収益を得る

誰でもShareAIプロバイダーになることができる—コミュニティ または 企業. 。オンボードする方法 ウィンドウズ, ウブントゥ, macOS, 、または ドッカー. 。貢献する アイドルタイムバースト または実行 常時オン. 。インセンティブを選択してください: 報酬 (お金)、, 交換 (トークン / AI Prosumer)、または ミッション (NGOに1%を寄付)。スケールするにつれて、, 独自の推論価格を設定できます そして得る 市場での優先的な露出. プロバイダーガイド · サインイン / サインアップ

#2 — Kong AIゲートウェイ

エンタープライズAI/LLMゲートウェイ—AIトラフィックのための強力なポリシー/プラグイン、分析、観測性。 コントロールプレーン マーケットプレイスではありません。.

#3 — ポートキー

AIゲートウェイは~を強調 可観測性, ガードレール, 、そして ガバナンス—コンプライアンスが厳しい場所で人気。.

#4 — オープンルーター

多くのモデルにわたる統一API; 高速な実験 幅広いカタログ全体で。.

#5 — エデンAI

LLMを集約 に加えて 広範なAI(ビジョン、翻訳、TTS)に最適で、フォールバック/キャッシングおよびバッチ処理を備えています。.

#6 — ライトLLM

軽量 SDK + 自己ホスト可能なプロキシ 多くのプロバイダーに対してOpenAI互換のインターフェースを公開。.

#7 — ユニファイ

プロンプトごとにより良いモデルを選択するための品質指向のルーティングと評価。 より良いモデルを選択。.

#8 — Orq AI

実験 → 本番環境への移行を可能にする オーケストレーション/コラボレーションプラットフォーム。 ローコードフローで。.

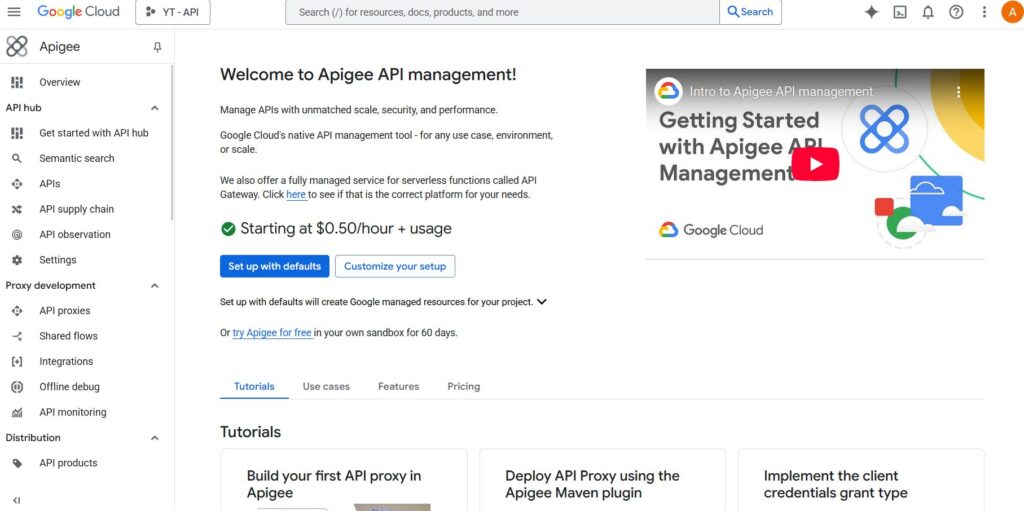

#9 — Apigee(その背後にLLMを搭載)

成熟したAPI管理/ゲートウェイをLLMプロバイダーの前に配置して、 ポリシー、キー、クォータを適用。.

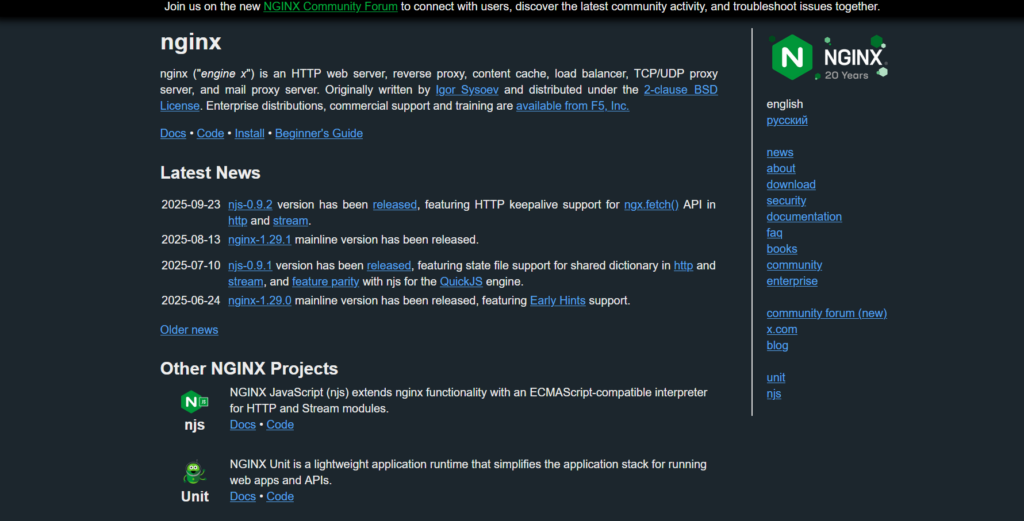

#10 — NGINX

DIYパス:カスタムルーティング、トークン強制、およびキャッシングを構築して、LLMバックエンドを厳密に制御したい場合。.

GitLab AI Gateway 対 ShareAI(要約):

必要性 多くのプロバイダーにわたる1つのAPI マーケットプレイスの透明性と即時フェイルオーバーを備えていますか? ShareAIを選んでください。.

必要性 出力ガバナンス—集中管理された認証情報、ポリシー、可観測性—そしてすでにプロバイダーを選択しましたか? GitLab AIゲートウェイ その役割に適しています。多くのチームがそれらを組み合わせています: 組織ポリシーのためのゲートウェイ + マーケットプレイスガイド付きルーティングのためのShareAI.

クイック比較(一目で)

| プラットフォーム | 対象者 | モデルの幅広さ | ガバナンスとセキュリティ | 可観測性 | ルーティング / フェイルオーバー | マーケットプレイスの透明性 | プロバイダープログラム |

|---|---|---|---|---|---|---|---|

| シェアAI | 1つのAPI + 公正な経済性を必要とする製品/プラットフォームチーム | 150以上のモデル, 、多くのプロバイダー | APIキー & ルートごとのコントロール | コンソール使用 + マーケットプレイス統計 | スマートルーティング + 即時フェイルオーバー | はい (価格、遅延、稼働時間、可用性、プロバイダータイプ) | はい — オープンサプライ; プロバイダーへの70% |

| GitLab AIゲートウェイ | チームが求めるもの 出力ガバナンスである場合 | BYOプロバイダー | 集中管理された資格情報/ポリシー | メトリクス/トレーシング | ポリシーによる条件付きルーティング | いいえ (インフラツール、市場ではない) | 該当なし |

| コングAIゲートウェイ | ゲートウェイレベルのポリシーを必要とする企業 | 持ち込み可 | 強力なエッジポリシー/プラグイン | 分析 | プロキシ/プラグイン、リトライ | いいえ | 該当なし |

| ポートキー | 規制/企業チーム | 広範囲 | ガードレールとガバナンス | 深いトレース | 条件付きルーティング | 部分的 | 該当なし |

| オープンルーター | 多くのモデルに対して1つのキーを求める開発者 | 幅広いカタログ | 基本的なAPIコントロール | アプリ側 | フォールバック | 部分的 | 該当なし |

| エデンAI | LLM + その他のAIサービス | 広範囲 | 標準的なコントロール | 変動する | フォールバック/キャッシング | 部分的 | 該当なし |

| LiteLLM | DIY/セルフホストプロキシ | 多くのプロバイダー | 設定/キーの制限 | あなたのインフラ | 再試行/フォールバック | 該当なし | 該当なし |

| 統一 | 品質重視のチーム | マルチモデル | 標準APIセキュリティ | プラットフォーム分析 | 最適モデル選択 | 該当なし | 該当なし |

| Orq | オーケストレーション優先のチーム | 幅広いサポート | プラットフォーム制御 | プラットフォーム分析 | オーケストレーションフロー | 該当なし | 該当なし |

| Apigee / NGINX | 企業 / DIY | 持ち込み可 | ポリシー | アドオン / カスタム | カスタム | 該当なし | 該当なし |

価格 & TCO: 比較 実際の コスト (単価だけではなく)

生の $/1K トークン 実際の状況を隠します。TCOは変化します リトライ/フォールバック, レイテンシー (使用に影響を与える)、, プロバイダーのばらつき, 可観測性ストレージ, 、そして 評価実行. 透明なマーケットプレイスが役立ちます ルートを選択する コストとUXのバランスを取るために。.

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate)) + Observability_storage + Evaluation_tokens + Egress

- プロトタイプ(約10kトークン/日): 最適化する 初回トークンまでの時間 (Playground, quickstarts)。.

- 中規模(約2Mトークン/日): Marketplace-guided routing/failoverは削減できます 10–20% 一方で UXを改善しながら.

- スパイク型ワークロード: フェイルオーバー中のリトライによる効果的なトークンコストの増加を予期してください—そのための予算を確保する.

移行プレイブック: ShareAIへの移行

GitLab AI Gatewayから

ゲートウェイレベルのポリシーをその強みが発揮される場所に維持します。. ShareAIを追加 マーケットプレイスルーティング + 即時フェイルオーバーのために。パターン: ゲートウェイ 認証/ポリシー → モデルごとのShareAIルート → 測定 マーケットプレイス統計 → ポリシーを強化。.

OpenRouterから

モデル名をマッピングし、プロンプトの均等性を確認してから シャドウ10% トラフィックとランプ 25% → 50% → 100% レイテンシー/エラーバジェットが維持される限り。マーケットプレイスデータは プロバイダーの切り替え 簡単です。.

LiteLLMから

自己ホスト型プロキシを置き換える 本番環境で 運用したくないルート;LiteLLMを保持する 開発 必要に応じて。比較 運用オーバーヘッド 管理されたルーティングの利点と比較。.

Unify / Portkey / Orq / Kongから

定義する 機能の同等性 期待値(分析、ガードレール、オーケストレーション、プラグイン)。多くのチームはハイブリッドを運用:専門的な機能を最も強力な場所に保持;使用する シェアAI 用の 透明なプロバイダー選択を行います。 と フェイルオーバー.

開発者クイックスタート(コピー&ペースト)

以下を使用します OpenAI互換 サーフェスを使用します。置き換えてください YOUR_KEY あなたのShareAIキーに—取得する場所は APIキーを作成.

#!/usr/bin/env bash"

// JavaScript (Node 18+/Edge runtimes) — チャット補完;

次のステップ: プレイグラウンドを開く · APIキーを作成 · APIリファレンス

セキュリティ、プライバシー & コンプライアンスチェックリスト(ベンダー非依存)

- キーの取り扱い: 回転頻度; 最小スコープ; 環境分離。.

- データ保持: プロンプト/レスポンスが保存される場所、保存期間;削除のデフォルト設定。.

- PIIおよび機密コンテンツ: マスキング;アクセス制御;; 地域ルーティング データローカリティのために。.

- 可観測性: プロンプト/レスポンスのログ記録;フィルタリング/仮名化の能力;; トレースIDの伝播 一貫して。.

- インシデント対応: エスカレーションパスとプロバイダーのSLA。.

FAQ — GitLab AI Gatewayと他の競合他社の比較

GitLab AI GatewayとShareAI — マルチプロバイダールーティングにはどちらが適しているか?

ShareAI。. それは構築されています 使用ケース (価格、遅延、稼働時間、可用性、プロバイダータイプ)と スマートルーティング/フェイルオーバー 多くのプロバイダーにわたって。GitLab AI Gatewayは 出力ガバナンスである場合 (集中管理された認証情報、ポリシー、可観測性)。多くのチームが両方を使用。.

GitLab AI GatewayとOpenRouter — クイックなマルチモデルアクセスまたはゲートウェイ制御?

オープンルーター マルチモデルアクセスを迅速にします;; GitLab ポリシーと可観測性を集中管理します。また、もしあなたが 事前ルートの透明性 と 即時フェイルオーバー, シェアAI 複数プロバイダーへのアクセスを統合し、 マーケットプレイスビューを提供します および回復力のあるルーティング。.

GitLab AI GatewayとEden AI — 多くのAIサービスまたは出口制御?

エデンAI 複数のAIサービス(LLM、画像、TTS)を集約します。. GitLab 集中管理する ポリシー/資格情報. 用 透明な価格設定/遅延 多くのプロバイダーにわたって 即時フェイルオーバー, を選択し、 シェアAI.

GitLab AI GatewayとLiteLLM — 自己ホスト型プロキシまたは管理されたガバナンス?

LiteLLM あなたが運用するDIYプロキシです;; GitLab AI出力に対する管理されたガバナンス/可観測性です。プロキシを実行したくない場合 と 欲しい マーケットプレイス駆動のルーティングを希望する場合, を選択し、 シェアAI.

GitLab AI Gateway vs Portkey — ガードレールでどちらが強い?

両者ともガバナンス/可観測性を重視していますが、深さと使いやすさが異なります。主なニーズが 透明なプロバイダー選択 + フェイルオーバー, 、追加する シェアAI.

GitLab AI Gateway vs Unify — ベストモデル選択 vs ポリシー施行?

統一 評価駆動のモデル選択に焦点を当てています;; GitLab ポリシー/可観測性に焦点を当てています。多くのプロバイダーにわたる1つのAPIで ライブマーケットプレース統計, の場合、使用してください シェアAI.

GitLab AI Gateway vs Orq — オーケストレーション vs 出力?

Orq ワークフローのオーケストレーションを支援します。; GitLab 出力トラフィックを管理します。. シェアAI どちらかを補完します マーケットプレースルーティング.

GitLab AI Gateway vs Kong AI Gateway — 2つのゲートウェイ

両方ともゲートウェイ(ポリシー、プラグイン、分析)であり、マーケットプレイスではありません。多くのチームはゲートウェイを組み合わせて使用します。 シェアAI 用の 透明なマルチプロバイダーのルーティング と フェイルオーバー.

GitLab AI Gateway vs Traefik AI Gateway — 専門的なAIミドルウェアか、より広範なプラットフォームか?

Traefikの 薄いAIレイヤーと専門的なミドルウェアは シェアAI’のマーケットプレイスの透明性とよく合います;; GitLab GitLabエコシステム内でガバナンスを提供します。.

GitLab AI Gateway vs Apigee — API管理 vs AI特化型出力

アピジー は広範なAPI管理です; GitLab DevOpsフロー内でのAI特化型出力ガバナンスです。必要であれば プロバイダーに依存しないアクセス と 使用ケース, の場合、使用してください シェアAI.

GitLab AI Gateway vs NGINX — DIY 対 ターンキー

NGINX DIYフィルター/ポリシーを提供します;; GitLab パッケージ化されたレイヤーを提供します。カスタムスクリプトを避けるために と 取得 透明なプロバイダー選択を得るために, 、レイヤーを追加してください シェアAI.

OpenRouter vs Apache APISIX — マーケットプレイスの速度またはエッジポリシー?

オープンルーター モデル試行を加速します;; APISIX プログラム可能なゲートウェイです。また、あなたが望む場合 事前ルートの価格/遅延の透明性 と 即時フェイルオーバー, の場合、使用してください シェアAI.

LiteLLM vs OpenRouter — DIY プロキシまたはホスト型アグリゲーター?

LiteLLM セルフホスト型プロキシを提供します;; オープンルーター 集約をホストします。. シェアAI 追加します ライブマーケットプレイス統計 + フェイルオーバー そして返します 70% プロバイダーへの収益のコミュニティへの還元.

Kong vs Apache APISIX — エンタープライズプラグインまたはオープンソースエッジ?

1. 両方とも強力なゲートウェイです。もしあなたが望むなら 透明なプロバイダー選択を行います。 と マルチプロバイダーの回復力, 2. 、経路を通して シェアAI 3. ポリシーのためにゲートウェイを保持します。.

4. Portkey対Unify — ガードレール対品質重視の選択?

ポートキー 5. ガードレール/可観測性に傾倒します;; 統一 6. モデル品質選択に傾倒します。. シェアAI 7. 市場の透明性をもたらします 8. どちらのスタックにも。 と 耐障害性のあるルーティング 9. NGINX対Apache APISIX — 2つのDIYパス.

10. 両方ともエンジニアリング投資が必要です。もしあなたが委任したいなら

11. マルチプロバイダーのルーティング+フェイルオーバー 12. そしてエッジでポリシーを保持し、 13. gitlab-ai-gateway-alternatives-feature をレイヤーに追加します。 シェアAI.

次にShareAIを試してください

プレイグラウンドを開く · APIキーを作成する · モデルを閲覧 · ドキュメントを読む · リリースを見る · サインイン / サインアップ