ShareAIへようこそ、OpenAIのGPT-OSS

このページは日本語で英語から自動翻訳されました。翻訳が完全に正確でない場合があります。.

ShareAIは最新で最も強力なAIモデルをお届けすることに尽力しており、今日もそれを実現しています。.

数時間前、, OpenAI 革新的な GPT-OSS モデルをリリースし、すでにShareAIネットワーク内で使用を開始できます!

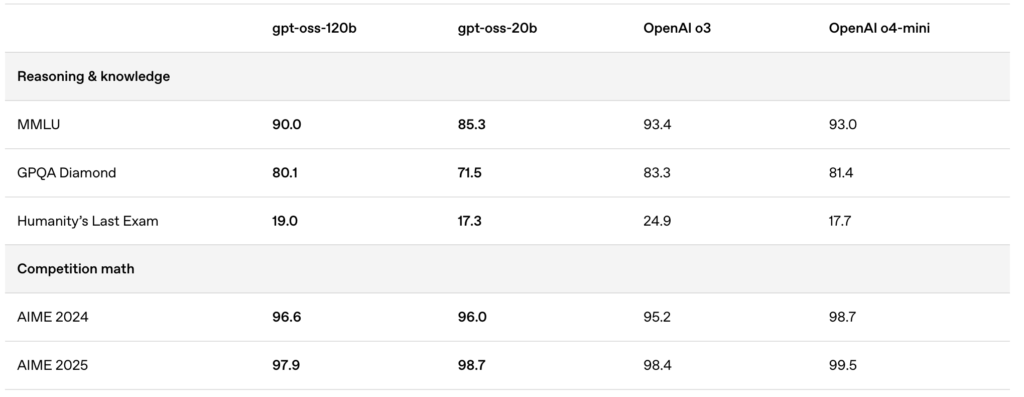

新しくリリースされたモデル—gpt-oss:20b と gpt-oss:120b—は、卓越したローカルチャット体験、強力な推論能力、そして高度な開発者シナリオへの対応を提供します。.

🚀 ShareAIでGPT-OSSを始めよう

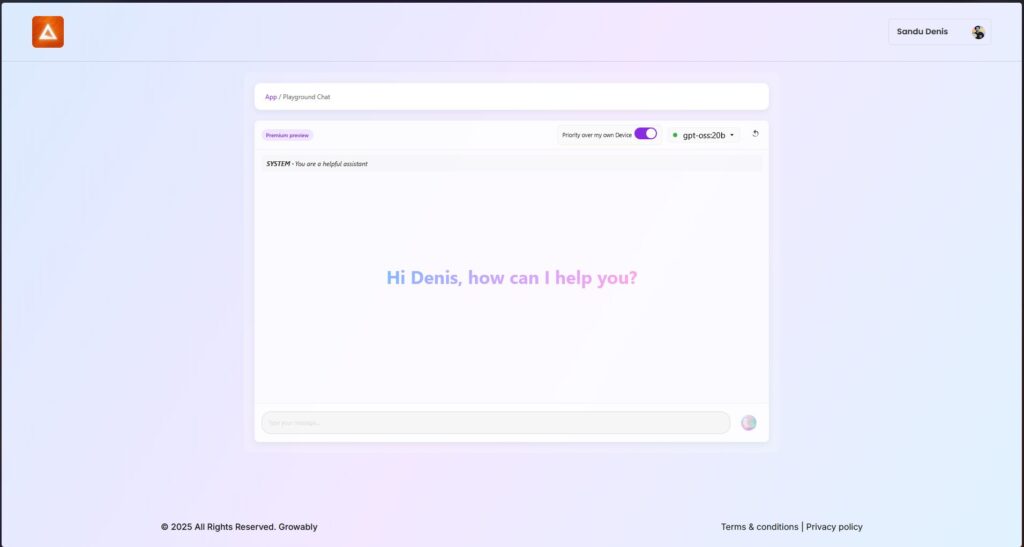

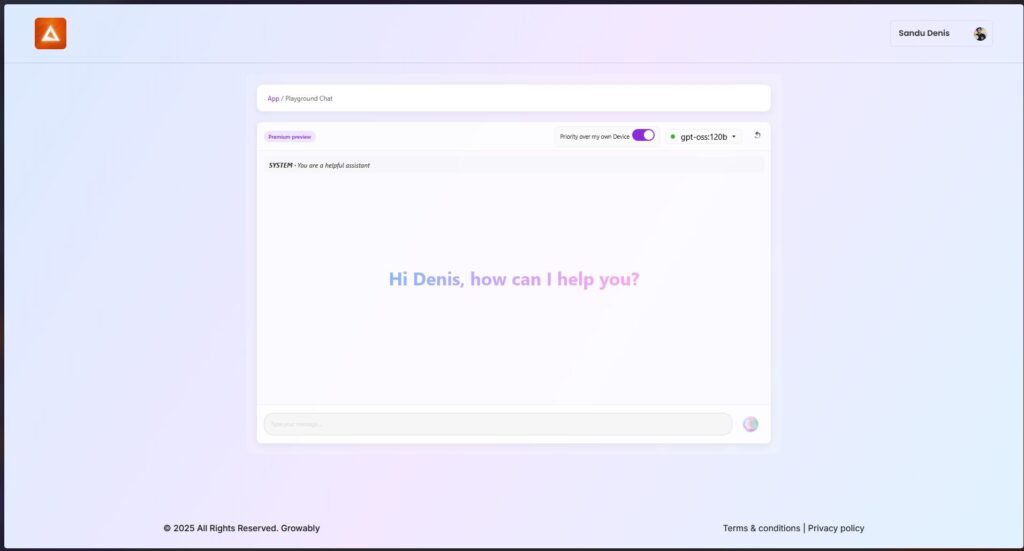

ShareAIのWindowsクライアント最新版を使用して、これらのモデルを今すぐ試すことができます。.

- Windows版ShareAIをダウンロード (リンク先のダウンロードページ)

インストール後、ShareAIアプリから直接GPT-OSSモデルを簡単にダウンロードして実行できます—複雑なセットアップや設定は不要です。.

✨ GPT-OSSの特徴ハイライト

GPT-OSSがAI駆動のワークフローに革命をもたらす理由はこちらです:

- エージェント機能:

関数呼び出し、ウェブブラウジング、Pythonツール呼び出し、構造化データ出力のための組み込み機能を活用できます。. - 完全な思考過程の透明性:

モデルの推論プロセスを明確に可視化し、デバッグを容易にし、生成結果への信頼を向上させます。. - 調整可能な推論レベル:

レイテンシーや複雑性のニーズに応じて、推論の努力(低、中、高)を簡単に調整できます。. - 微調整可能なアーキテクチャ:

特定のユースケースに合わせてパラメータ微調整でモデルを広範囲にカスタマイズできます。. - 許容的なApache 2.0ライセンス:

制限的なコピーレフトライセンスや特許リスクなしで自由に革新—商業展開や迅速な実験に最適です。.

🔥 MXFP4量子化で最適化

OpenAIはMXFP4量子化を導入し、GPT-OSSモデルのメモリ使用量を大幅に削減しました:

- MXFP4フォーマットの説明:

GPT-OSSモデルは、Mixture-of-Experts(MoE)重みを1パラメータあたりわずか4.25ビットに量子化する技術を利用しています。これらのMoE重みはモデル全体のパラメータの90%以上を占めており、量子化を非常に効率的にしています。. - 互換性の向上:

この最適化された量子化により可能になること:- モデルがスムーズに動作する gpt-oss:20b 16GBのメモリしかないマシンでも モデルが快適に収まる.

- モデルがスムーズに動作する gpt-oss:120b 単一の 80GB GPU上で.

ShareAIはこのMXFP4フォーマットをネイティブでサポートしています—追加の手順、変換、または手間は不要です。最新のエンジンアップデートには、MXFP4フォーマット専用に設計された新しいカーネルが含まれており、最高のパフォーマンスを保証します。.

📌 GPT-OSSモデルが現在利用可能:

GPT-OSS:20B

- 低遅延、専門的なタスク、またはローカル展開に最適です。.

- 控えめなハードウェア構成でも堅牢なパフォーマンスを提供します。.

GPT-OSS:120B

- 強力な推論、高度なエージェント機能、そして大規模な要求の厳しいタスクに適した多用途性を提供します。.

- より深い推論、高い精度、そして幅広いAIアプリケーションを必要とする開発者や企業に最適です。.

🛠️ 今日GPT-OSSを試してみてください

次世代AI機能を体験する準備はできていますか?

- ShareAI Windowsクライアントをダウンロード (ダウンロードページへのリンク)

- ドキュメントを見る (ユーザードキュメントまたはチュートリアルへのリンク)

続報をお待ちください—ShareAIはモデルライブラリを拡大し、AIプロジェクトをあらゆる段階で支援し続けます。.

プロンプトを楽しんでください! 🚀