AI Gateway vs Vercel AI Gateway: なぜShareAIのBYOIが勝つのか

ShareAI AIゲートウェイ vs Vercel AIゲートウェイ:それが何であるか、なぜ重要なのか、そしてShareAIがどのように異なるのか

AIゲートウェイ アプリとモデルベンダー、キー、クォータ、障害の混乱した世界との間の欠けている層になりつつあります。このガイドでは、AIゲートウェイとは何かを説明し、 Vercel AIゲートウェイ, を要約し、ShareAIのオープンネットワーク、70%プロバイダ支払い、BYOI(独自インフラ持ち込み)を使用した デバイス優先 により、コンプライアンス、弾力性、選択を必要とするチームのための異なる道を作り出します。.

AIゲートウェイとは何か(そしてなぜチームがそれを使用するのか)

AIゲートウェイは、アプリケーションと多くのモデルプロバイダの間に位置します。それは単一のエンドポイント、ポリシーベースのルーティング(コスト、遅延、コンプライアンス)、統一されたキーとレート制限管理、自動フェイルオーバー、エンドツーエンドの可観測性を提供します。プロダクションアプリ(エージェント、RAG、チャット、検索)において、ベンダーロックインを減らし、コードが1つのAPIに固定されるのを防ぎます。.

Vercel AIゲートウェイ:簡単な概要

Vercelは2025年5月20日にゲートウェイを発表し、1つのエンドポイントとAI SDKの背後で多くのモデルへのアクセスを統一しました。それはシンプルなモデル切り替え、フェイルオーバー、低遅延ルーティングを強調し、 独自キー持ち込み と独立した報道で言及されたトークンマークアップなしを特徴としています。元の投稿と要約を参照してください: Vercelブログ と InfoQサマリー.

Vercelが最適な場面: すでにVercel + AI SDKを標準化しているチームで、ログ、メトリクス、フェイルオーバーが組み込まれた洗練された単一ベンダーゲートウェイをそのエコシステム内で求めている場合。.

ShareAIのゲートウェイが異なる点

1) オープンネットワーク(「大手」推論ベンダーだけではない)

ShareAIは 人々が支えるAI APIです. 。資格のあるプロバイダー(コミュニティまたは企業)は誰でも参加できるため、中央集権的なクラウドに限定されません。それにより、より広範なモデル選択、専門的なハードウェア、地域的多様性が可能になります。オプションを比較するには モデルマーケットプレイス または新しいプロバイダーを募集するには プロバイダーガイド.

2) プロバイダーに優しい経済性(推論ごとに70%の支払い)

ShareAIはプロバイダーに支払います 各推論の70%を. 。稼働時間と品質へのインセンティブがネットワーク容量を拡大しつつ、価格を効率的に保ちます。プロバイダーはアイドルタイムまたは常時稼働を選択し、価格を設定し、さらにはNGOに一定割合を寄付することもできます。.

| 項目 | 値 |

|---|---|

| ユーザーに請求される価格 | $1.00 |

| プロバイダーに支払済み (70%) | $0.70 |

| ShareAI サービス & オーバーヘッド | $0.30 |

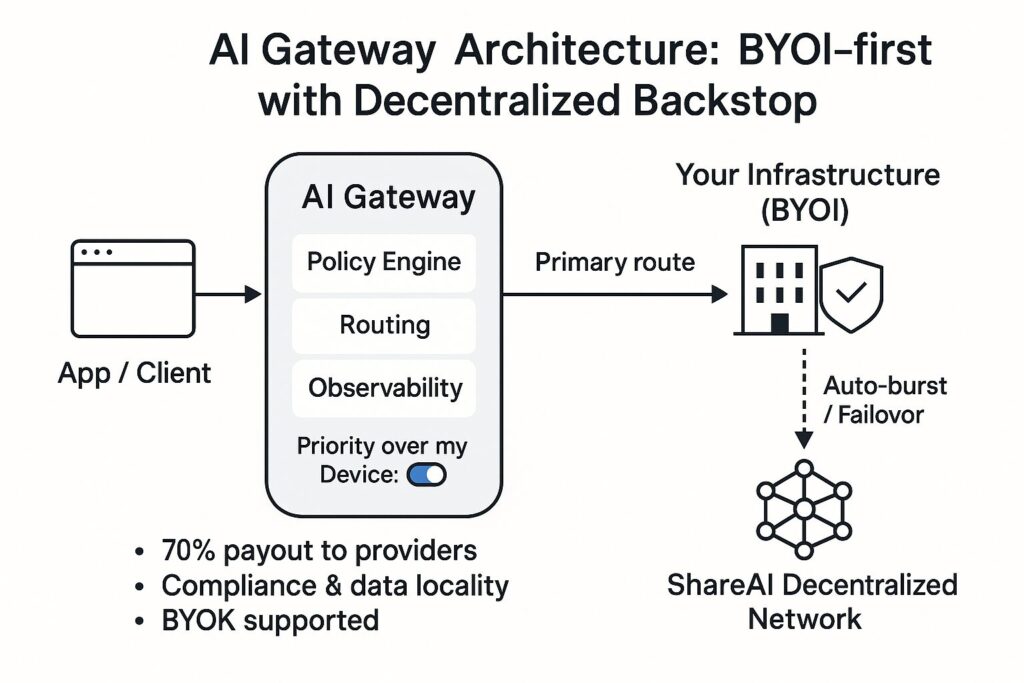

3) コンプライアンス優先ルーティングによるBYOI(「私のデバイスより優先」)

独自のインフラストラクチャを持ち込む(オンプレミスまたはクラウド)ことで、機密性の高いワークロードを管理下に置くことができます。 デバイス優先 トグルを使用すると、, あなたの インフラが最初に動作し、ShareAIは必要なヘッドルームを提供する場合のみバックストップとして機能します—グローバルロードバランサーのように動作します。これにより、データの局所性とコンプライアンスが簡素化され、弾力性が維持されます。.

私のデバイスより優先を有効化する(APIキーごと)—コンソールで APIキー ページを開き、アプリで使用されるキーに対してトグルを切り替えます。 デバイス優先 ONの場合、ShareAIはまず接続されたデバイスにルーティングし、適格なデバイスがない場合は分散ネットワークにリクエストがフォールバックします。 私のデバイスより優先ガイド および コンソールユーザーガイド.

4) 即時スケール + アイドル収益化

トラフィックが急増した際には、ウォームアップなしでShareAIの分散型ネットワークに突入します。インフラがアイドル状態のときには、ネットワークに容量を提供することで収益を得るオプションを選択できます。それは、 勝利 組織にとって(即時スケールとコンプライアンス)、 勝利 プロバイダーにとって(収益)、そして 勝利 ユーザーにとって(コスト/遅延に関する選択肢の増加)です。.

Vercel AI Gateway vs ShareAI: 並列比較

| 機能 | Vercel AIゲートウェイ | シェアAI |

|---|---|---|

| ネットワークの広がり | 主要ベンダーの多くのモデルに対応する単一エンドポイント(詳細). | オープンネットワーク:主要ベンダー に加えて 独立/コミュニティプロバイダー(モデルを閲覧). |

| BYOIとオンプレミスの優先順位 | ルーティング/信頼性に注力; SDK中心。BYOKがカバレッジで強調される (インフォQ). | BYOI優先。キーごとのトグル デバイス優先 インフラを最初のホップにする (仕組み). |

| フェイルオーバー | プロバイダー間の自動フェイルオーバー (インフォQ). | 多くのプロバイダー/地域にわたる分散型バックストップ; ポリシー駆動のオーバーフロー。. |

| 経済性 | BYOKとレポートでの0%トークンマークアップ (インフォQ). | 70%の支払い プロバイダーへ; 透明なマーケットプレイスのインセンティブ。. |

| 可観測性 | ログ、メトリクス、コスト追跡が組み込まれている。. | リクエストレベルのテレメトリ + マーケットプレイスのシグナル (レイテンシ、稼働時間、評判)。. |

| 開発者体験 | タイトなAI SDK統合;モデルを切り替えるための最小限のコード。. | REST/SDK、コンソールでのポリシーコントロール;クイックスタートは APIリファレンス. |

| 最適な適合 | 統合ゲートウェイ + SDK DXを求めるVercelネイティブスタック。. | コンプライアンス優先のBYOI、分散型の弾力性、プロバイダー収益を必要とするチーム。. |

ShareAIが内部でルーティングする方法

リクエストフロー: (1) ポリシーとキーのチェック — キーごとのトグルが最初のホップを決定します。(2) コンプライアンス優先のルーティング — クラスター/デバイスがオンラインでモデル適格の場合、リクエストを処理します。(3) ヘルス/レイテンシーチェックがパフォーマンスを継続的に監視します。(4) 分散型フォールバック — 必要に応じてShareAIのネットワークにオーバーフローします。.

プロバイダーのオンボーディングと品質: Windows/Ubuntu/macOS/Dockerインストーラーを使用してコミュニティまたは企業として参加;評判は稼働時間、レイテンシー、ベンチマーク階層を考慮します。プロバイダーは価格を管理し、SLOを満たすことで露出を得ます。詳細は プロバイダーガイド.

クイックスタート:ShareAIをAIゲートウェイとして使用

- APIキーを作成する コンソールで。.

- トグル デバイス優先 インフラが最初に実行される必要がある場合、そのキーをONにします。.

- リクエストを送信するには APIクイックスタート または、以下で試してください プレイグラウンド.

curl -X POST https://api.shareai.now/v1/chat/completions \"ここから、モデルを変更して モデル 識別子を切り替えます。レイテンシー、コスト、ルーティングを確認しながら コンソールユーザーガイド, 、その後、新しいリリースを探索してください リリース.

ShareAIをVercel AI Gatewayより選ぶべき場合(および選ばないべき場合)

ShareAIを選ぶべき場合 コンプライアンス優先のルーティングを備えたBYOIが必要な場合(デバイス優先)、トラフィック急増時の分散型弾力性、プロバイダー/組織の収益(70%の支払い、アイドルタイムの収益化)。.

Vercel AI Gatewayを選ぶべき場合 Vercelネイティブの体験が必要で、AI SDK、統合請求/観測性がそのプラットフォーム内にあり、シンプルなフェイルオーバーが組み込まれている場合(InfoQの要約).