ShareAI에 OpenAI의 GPT-OSS를 환영합니다

이 페이지는 한국어에서 영어를 사용하여 자동으로 번역되었습니다. 번역이 완벽하게 정확하지 않을 수 있습니다.

ShareAI는 최신의 가장 강력한 AI 모델을 제공하기 위해 노력하고 있으며, 오늘도 이를 실현하고 있습니다.

몇 시간 전에, OpenAI가 획기적인 GPT-OSS 모델을 출시했으며, 이제 ShareAI 네트워크에서 바로 사용할 수 있습니다!

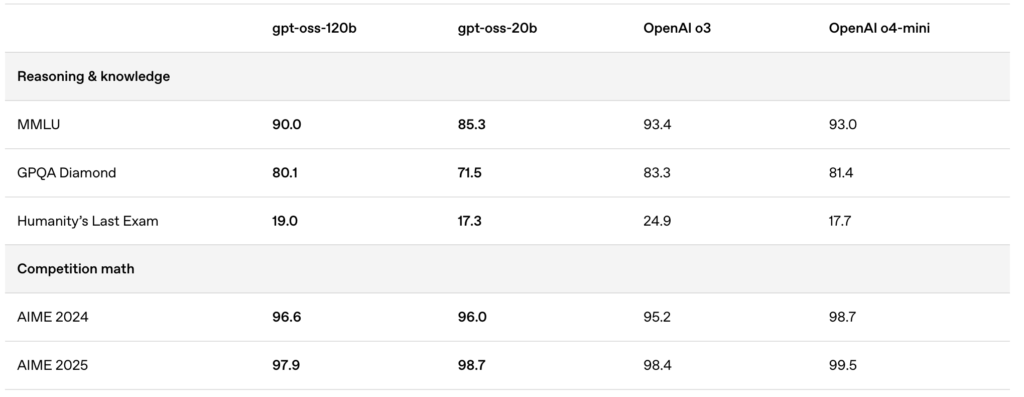

새로 출시된 모델—gpt-oss:20b 그리고 gpt-oss:120b—는 뛰어난 로컬 채팅 경험, 강력한 추론 능력, 그리고 고급 개발자 시나리오에 대한 향상된 지원을 제공합니다.

🚀 ShareAI에서 GPT-OSS 시작하기

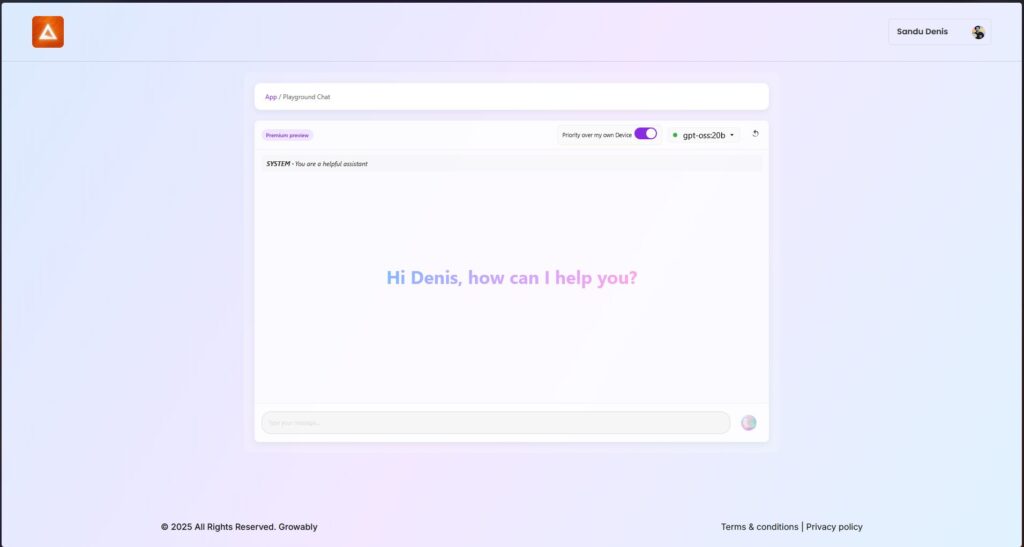

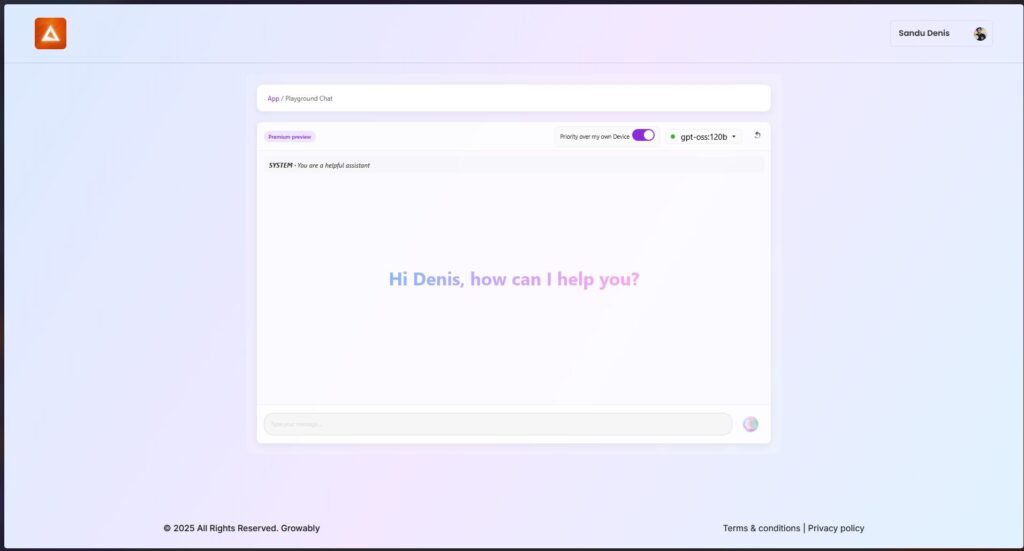

ShareAI의 최신 Windows 클라이언트를 사용하여 지금 바로 이 모델들을 시도해볼 수 있습니다.

- Windows용 ShareAI 다운로드 (다운로드 페이지 링크)

설치 후 ShareAI 앱에서 GPT-OSS 모델을 직접 다운로드하고 실행할 수 있습니다—복잡한 설정이나 구성은 필요하지 않습니다.

✨ GPT-OSS 기능 하이라이트

GPT-OSS가 AI 기반 워크플로우에 혁신을 가져오는 이유는 다음과 같습니다:

- 에이전트 기능:

함수 호출, 웹 브라우징, Python 도구 호출, 구조화된 데이터 출력에 대한 내장 기능을 활용하세요. - 전체 사고 과정 투명성:

모델의 추론 과정을 명확히 확인하여 디버깅을 쉽게 하고 생성된 결과에 대한 신뢰를 높일 수 있습니다. - 구성 가능한 추론 수준:

지연 시간과 복잡성 요구에 따라 추론 노력을 쉽게 조정하세요 (낮음, 중간, 높음). - 세밀하게 조정 가능한 아키텍처:

특정 사용 사례에 맞게 매개변수 세부 조정을 통해 모델을 광범위하게 사용자 정의하세요. - 허용적인 Apache 2.0 라이선스:

제한적인 카피레프트 라이선스나 특허 위험 없이 자유롭게 혁신하세요—상업적 배포와 빠른 실험에 적합합니다.

🔥 MXFP4 양자화로 최적화됨

OpenAI는 MXFP4 양자화를 도입하여 GPT-OSS 모델의 메모리 사용량을 크게 줄였습니다:

- MXFP4 형식 설명:

GPT-OSS 모델은 혼합 전문가(MoE) 가중치를 매개변수당 단 4.25비트로 양자화하는 기술을 활용합니다. 이러한 MoE 가중치는 전체 모델 매개변수의 90% 이상을 차지하며, 양자화를 매우 효율적으로 만듭니다. - 향상된 호환성:

이 최적화된 양자화는 다음을 가능하게 합니다:- 모델이 gpt-oss:20b 16GB 메모리만으로도 원활하게 실행될 수 있음 16GB 메모리.

- 모델이 gpt-oss:120b 모델이 단일 80GB GPU에 편안하게 적합함.

ShareAI는 이 MXFP4 형식을 기본적으로 지원합니다—추가 단계, 변환 또는 번거로움이 필요하지 않습니다. 최신 엔진 업데이트는 MXFP4 형식에 맞게 특별히 설계된 새로운 커널과 함께 제공되어 최상의 성능을 보장합니다.

📌 GPT-OSS 모델 지금 사용 가능:

GPT-OSS:20B

- 저지연, 전문화된 작업 또는 로컬 배포에 이상적입니다.

- 소규모 하드웨어 설정에서도 강력한 성능을 제공합니다.

GPT-OSS:120B

- 강력한 추론, 고급 에이전트 기능, 그리고 대규모로 요구되는 작업에 적합한 다재다능함을 제공합니다.

- 더 깊은 추론, 높은 정확도, 그리고 더 넓은 AI 응용 프로그램이 필요한 개발자와 기업에 적합합니다.

🛠️ 오늘 GPT-OSS를 사용해보세요

차세대 AI 기능을 경험할 준비가 되셨나요?

- ShareAI Windows 클라이언트를 다운로드하세요 (다운로드 페이지 링크)

- 문서 보기 (사용자 문서 또는 튜토리얼 링크)

계속 지켜봐 주세요—ShareAI는 모델 라이브러리를 확장하며, 여러분의 AI 프로젝트를 모든 단계에서 지원합니다.

즐거운 프롬프트 작성 되세요! 🚀