AI Gateway vs Vercel AI Gateway: ShareAI의 BYOI가 승리하는 이유

ShareAI AI Gateway vs Vercel AI Gateway: 그것이 무엇인지, 왜 중요한지, 그리고 ShareAI가 어떻게 다른지

AI 게이트웨이 앱과 모델 공급업체, 키, 할당량, 중단의 혼란스러운 세계 사이의 누락된 계층이 빠르게 되고 있습니다. 이 가이드는 AI 게이트웨이가 무엇인지 설명하고, Vercel AI 게이트웨이, 를 요약하며, ShareAI의 개방형 네트워크, 70% 공급업체 지급, BYOI(자체 인프라 사용)와 함께 내 장치 우선 준수, 탄력성, 선택이 필요한 팀을 위한 다른 경로를 만듭니다.

AI 게이트웨이란 무엇인가 (그리고 팀이 이를 사용하는 이유)

AI 게이트웨이는 애플리케이션과 여러 모델 공급업체 사이에 위치합니다. 단일 엔드포인트, 정책 기반 라우팅(비용, 지연 시간, 준수), 통합 키 및 속도 제한 관리, 자동 장애 조치, 엔드 투 엔드 관찰 가능성을 제공합니다. 프로덕션 앱(에이전트, RAG, 채팅, 검색)의 경우 공급업체 종속성을 줄이고 코드를 하나의 API에 고정시키지 않도록 합니다.

Vercel AI Gateway: 간단한 요약

Vercel은 2025년 5월 20일에 게이트웨이를 발표하여 하나의 엔드포인트와 AI SDK 뒤에 여러 모델에 대한 액세스를 통합했습니다. 간단한 모델 전환, 장애 조치, 저지연 라우팅을 강조하며, 자체 키 사용 및 독립적인 보도에서 언급된 토큰 마크업 없음이 특징입니다. 원본 게시물 및 요약을 참조하십시오: Vercel 블로그 그리고 InfoQ 요약.

Vercel이 가장 적합한 곳: 이미 Vercel + AI SDK를 표준화한 팀으로, 해당 생태계 내에서 로그, 메트릭 및 장애 조치가 내장된 세련된 단일 공급업체 게이트웨이를 원하는 경우.

ShareAI의 게이트웨이가 다른 점

1) 개방형 네트워크(“대형” 추론 공급업체만이 아님)

ShareAI는 사람 중심의 AI API입니다.. 자격을 갖춘 모든 공급업체(커뮤니티 또는 회사)가 참여할 수 있으므로 소수의 중앙 집중식 클라우드에 제한되지 않습니다. 이는 더 넓은 모델 선택, 전문 하드웨어 및 지역 다양성을 의미합니다. 옵션을 비교하려면 모델 마켓플레이스에서 또는 새 공급업체를 모집하려면 제공자 가이드.

2) 공급업체 친화적인 경제성(추론당 70% 지급)

ShareAI는 공급업체에게 모든 추론의 70%를 지급합니다.. 가동 시간 및 품질에 대한 인센티브는 네트워크 용량을 증가시키는 동시에 가격을 효율적으로 유지합니다. 공급업체는 유휴 시간 또는 항상 실행 상태로 운영할 수 있으며, 가격을 설정하고 심지어 NGO에 일정 비율을 기부할 수도 있습니다.

| 항목 | 값 |

|---|---|

| 사용자에게 청구된 가격 | $1.00 |

| 공급자에게 지급됨 (70%) | $0.70 |

| ShareAI 서비스 및 간접비 | $0.30 |

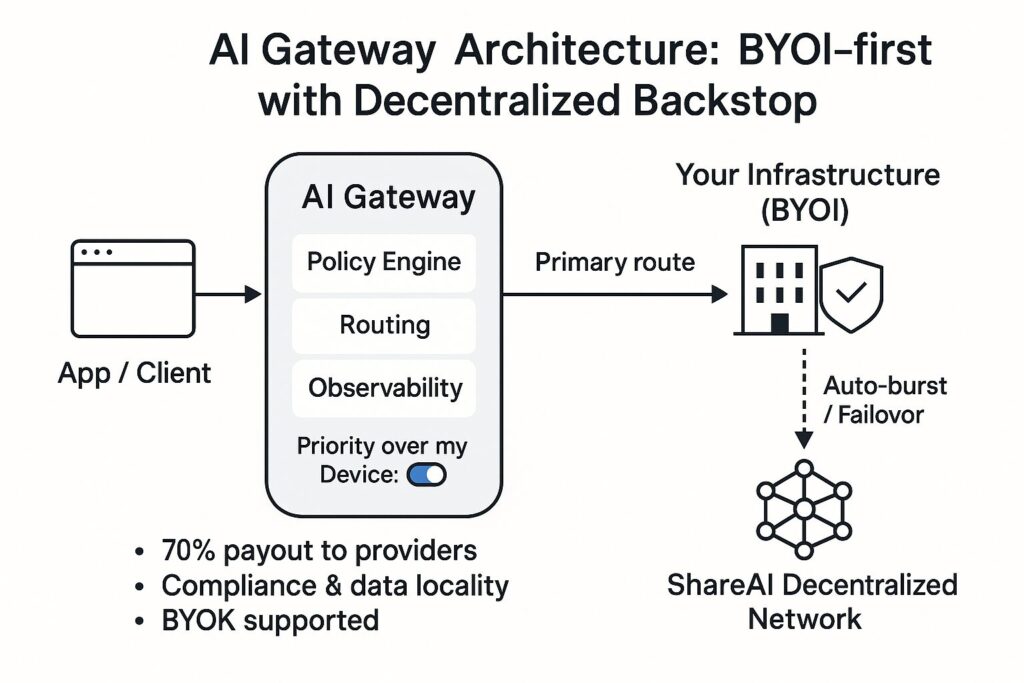

3) 준수 우선 라우팅을 사용하는 BYOI (“내 장치 우선”)

자체 인프라를 가져오세요(온프레미스 또는 클라우드) 및 민감한 작업을 귀하의 제어 하에 유지하세요. 내 장치 우선 토글을 사용하여, 귀하의 인프라가 먼저 실행됩니다; ShareAI는 여유 공간이 필요할 때만 백스톱 역할을 하며, 글로벌 로드 밸런서처럼 작동합니다. 이는 데이터 지역성과 준수를 간단하게 유지하면서 탄력성을 보존합니다.

내 장치 우선 활성화 (API 키별)— API 키 콘솔에서 페이지를 열고 내 장치 우선 귀하의 앱에서 사용하는 키에 대해 토글을 설정하세요. 활성화되면 ShareAI는 먼저 연결된 장치로 라우팅하며, 적합한 장치가 없을 경우 요청은 분산 네트워크로 전환됩니다. 내 장치 우선 가이드 및 콘솔 사용자 가이드를 참조하세요..

4) 즉각적인 확장 + 유휴 상태 수익화

트래픽이 급증하면 ShareAI의 분산 네트워크로 즉시 확장됩니다. 인프라가 유휴 상태일 때 네트워크에 용량을 기여하여 수익을 얻는 옵션을 선택할 수 있습니다. 조직에게는 즉각적인 확장과 규정 준수로 이익이 되고, 조직에게는 제공자에게는 수익으로 이익이 되며, 조직에게는 사용자에게는 비용/지연 시간에 대한 더 많은 선택권으로 이익이 됩니다.

Vercel AI Gateway vs ShareAI: 비교

| 기능 | Vercel AI 게이트웨이 | 공유AI |

|---|---|---|

| 네트워크 폭 | 주요 공급업체의 여러 모델에 대한 단일 엔드포인트 (세부 정보). | 오픈 네트워크: 주요 공급업체 및 독립/커뮤니티 제공업체 (모델 탐색). |

| BYOI 및 온프레미스 우선순위 | 라우팅/신뢰성 초점; SDK 중심. BYOK가 커버리지에서 강조됨 (인포큐). | BYOI 우선. 키별 토글 내 장치 우선 인프라를 첫 번째 홉으로 만듭니다 (작동 방식). |

| 장애 조치 | 공급자 간 자동 장애 조치 (인포큐). | 여러 공급자/지역에 걸친 분산 백스톱; 정책 기반 오버플로우. |

| 경제성 | BYOK와 0% 토큰 마크업 보고 포함 (인포큐). | 70% 지급 공급자에게; 투명한 마켓플레이스 인센티브. |

| 관측 가능성 | 로그, 메트릭, 비용 추적 내장. | 요청 수준의 텔레메트리 + 마켓플레이스 신호 (지연 시간, 가동 시간, 평판). |

| 개발자 경험 | 긴밀한 AI SDK 통합; 모델 전환을 위한 최소 코드. | REST/SDK, 콘솔에서 정책 제어; 빠른 시작 API 참조. |

| 최적의 적합성 | 통합 게이트웨이 + SDK DX를 원하는 Vercel-네이티브 스택. | 준수 우선 BYOI, 분산 탄력성, 제공자 수익이 필요한 팀. |

ShareAI가 내부적으로 라우팅하는 방법

요청 흐름: (1) 정책 및 키 확인 — 키별 토글이 첫 번째 홉을 결정합니다. (2) 준수 우선 라우팅 — 클러스터/디바이스가 온라인 상태이고 모델 적합한 경우 요청을 처리합니다. (3) 상태/지연 시간 확인은 성능을 지속적으로 모니터링합니다. (4) 분산 폴백 — 필요 시 ShareAI 네트워크로 오버플로우.

제공자 온보딩 및 품질: Windows/Ubuntu/macOS/Docker 설치 프로그램으로 커뮤니티 또는 회사로 가입; 평판은 가동 시간, 지연 시간 및 벤치마크 등급을 고려합니다. 제공자는 가격을 제어하고 SLO를 충족하여 노출을 얻습니다. 제공자 가이드.

빠른 시작: ShareAI를 AI 게이트웨이로 사용

- API 키 생성 콘솔에서.

- 토글 내 장치 우선 인프라가 먼저 실행되어야 하는 경우 해당 키에 대해 ON으로 설정하십시오.

- 요청을 보내세요 API 빠른 시작 또는 다음에서 시도해보세요 플레이그라운드.

curl -X POST https://api.shareai.now/v1/chat/completions \"여기에서 모델을 변경하여 모델 식별자를 바꾸세요. 지연 시간, 비용, 라우팅을 확인하세요 콘솔 사용자 가이드를 참조하세요., 그런 다음 새 릴리스를 탐색하세요 릴리스.

ShareAI를 Vercel AI Gateway 대신 선택해야 할 때 (그리고 선택하지 말아야 할 때)

ShareAI를 선택하세요 준수 우선 라우팅(BYOI)이 필요할 때내 장치 우선트래픽 급증을 위한 분산 탄력성, 제공자/조직 수익(70% 지급, 유휴 시간 수익화)을 원할 때.

Vercel AI Gateway를 선택하세요 AI SDK와 함께 Vercel 네이티브 경험, 해당 플랫폼 내 통합 청구/관찰성, 간단한 장애 조치가 포함된 경우InfoQ 요약).