Alternativas ao MLflow AI Gateway 2026: Melhores Alternativas

Atualizado em Fevereiro de 2026

Se você está pesquisando Alternativas ao MLflow AI Gateway, este guia orientado ao construtor esclarece o que é (e o que não é) o AI Gateway do MLflow, apresenta critérios de avaliação e compara as 10 melhores opções. Nós colocamos ShareAI em primeiro lugar para equipes que desejam uma API única para vários provedores, sinais transparentes de mercado (preço, latência, tempo de atividade, disponibilidade) antes do roteamento, failover instantâneo e economia impulsionada por pessoas (70% dos gastos vão para os provedores). Veja os conceitos oficiais de recursos na documentação do MLflow.

O que é (e o que não é) o MLflow AI Gateway

O que é. Uma camada de controle de saída de IA/LLM dentro do ecossistema MLflow. Centraliza credenciais e políticas, expõe uma superfície unificada para se comunicar com vários provedores de modelos e se integra aos fluxos de trabalho de experimento/rastreamento/avaliação do MLflow. Em resumo: governança e gerenciamento de tráfego para chamadas LLM.

O que não é. Um marketplace de modelos transparente que mostra preço ao vivo, latência, tempo de atividade e disponibilidade entre muitos provedores antes de você rotear. Gateways focam em controle e observabilidade. Marketplaces focam em escolha e economia de desempenho no nível de rota.

Conclusão: Se sua principal necessidade é roteamento agnóstico ao provedor com transparência pré-rota e failover instantâneo, combine ou substitua um gateway por ShareAI. Se sua principal necessidade é política organizacional centralizada e observabilidade, um gateway se encaixa nesse cenário.

Agregadores vs Gateways vs Plataformas de Agentes

- Agregadores de LLM (marketplaces). Uma API para muitos modelos/provedores com transparência pré-rota (preço, latência, tempo de atividade, disponibilidade, tipo de provedor), além de roteamento/failover inteligente. Bom para: experimentos mais rápidos, ajuste de custo/UX, troca de provedores sem reescritas.

- Gateways de IA. Governança na borda (credenciais, escopos, limites), cotas/limites de taxa e observabilidade. Você traz seus próprios provedores e contas. Bom para: segurança centralizada, auditabilidade, controle de saída.

- Plataformas de agentes/chatbots. UX empacotado (memória, ferramentas), canais e fluxos de trabalho da equipe—otimizados para assistentes de usuários finais em vez de agregação independente de provedores.

Como avaliamos as melhores alternativas ao MLflow AI Gateway

- Amplitude e neutralidade do modelo — proprietário + aberto; troca fácil; reescritas mínimas.

- Latência e resiliência — políticas de roteamento, tempos limite/retries, failover instantâneo.

- 2. Governança e segurança — gerenciamento de chaves, escopos, roteamento regional.

- Observabilidade 4. — logs/rastros e painéis de custo/latência.

- 5. Transparência de preços e TCO — comparar custos reais antes de você rotear.

- Experiência do desenvolvedor — documentação, SDKs, inícios rápidos; tempo até o primeiro token.

- 11. — se seus gastos — se seus gastos aumentam a oferta (incentivos para proprietários de GPU).

As 10 melhores alternativas ao MLflow AI Gateway

#1 — ShareAI (API de IA impulsionada por pessoas)

O que é. Uma API multi-provedor com um marketplace transparente e roteamento inteligente. Com uma integração, navegue por um grande catálogo de modelos e provedores, compare preço, latência, uptime, disponibilidade e tipo de provedor, e então roteie com failover instantâneo. A economia é impulsionada pelas pessoas: 70% de cada dólar vai para provedores (comunidade ou empresa) que mantêm os modelos online.

Por que é #1 aqui. Se você deseja agregação independente de provedores com transparência pré-roteamento e resiliência, ShareAI é a opção mais direta. Mantenha um gateway se precisar de políticas organizacionais; adicione ShareAI para roteamento guiado por marketplace.

- Uma API → 150+ modelos em vários provedores; sem reescritas, sem dependência. • Navegue Modelos

- Marketplace transparente: escolha por preço, latência, uptime, disponibilidade e tipo de provedor. • Experimente em Playground

- Resiliência por padrão: políticas de roteamento mais failover instantâneo.

- Economia justa: 70% do gasto vai para os provedores (comunidade ou empresa). • Criar Chave de API · Referência da API · Documentos · Lançamentos

Para provedores: ganhe mantendo os modelos online. Qualquer pessoa pode se tornar um provedor ShareAI—Comunidade ou Empresa. Integre-se via Windows, Ubuntu, macOS ou Docker. Contribua com rajadas de tempo ocioso ou opere continuamente. Escolha seu incentivo: Recompensas (dinheiro), Troca (tokens / AI Prosumer) ou Missão (doe % para ONGs). À medida que você escala, pode definir seus próprios preços de inferência e ganhar exposição preferencial. • Guia do Provedor · Painel do Provedor

#2 — Chave de Portal

O que é. Portal de IA com ênfase em observabilidade, limites de segurança e governança—popular entre equipes que precisam de controles e diagnósticos robustos.

Melhor para. Ambientes regulados/empresariais onde a profundidade da governança é a principal prioridade. Complementa o ShareAI quando você precisa de uma aplicação profunda de políticas, mas também deseja roteamento guiado por marketplace.

#3 — Gateway de IA Kong

O que é. Portal empresarial de IA/LLM—políticas/plugins, análises e observabilidade de borda para tráfego de IA. Um plano de controle em vez de um marketplace.

Melhor para. Política organizacional ampla, cotas e extensões baseadas em plugins para equipes heterogêneas.

#4 — OpenRouter

O que é. Uma API unificada sobre muitos modelos; ótimo para experimentação rápida em um amplo catálogo.

Melhor para. Acesso rápido a múltiplos modelos; complementa portais quando você precisa de escolha mais do que de política.

#5 — Eden AI

O que é. Agrega LLMs e capacidades mais amplas de IA (visão, tradução, TTS), com fallback/cache e agrupamento.

Melhor para. Equipes que precisam de múltiplas modalidades de IA em um só lugar com controles padrão.

#6 — LiteLLM

O que é. SDK leve em Python mais proxy auto-hospedável que utiliza uma interface compatível com OpenAI para muitos provedores.

Melhor para. Controle DIY quando você prefere operar o proxy por conta própria e ajustar tentativas/fallbacks.

#7 — Unify

O que é. Roteamento e avaliação orientados à qualidade para escolher melhores modelos por prompt.

Melhor para. Equipes orientadas por avaliação focando na qualidade da resposta e seleção específica ao prompt.

#8 — Orq AI

O que é. Plataforma de orquestração/colaboração que ajuda equipes a passar de experimentos para produção com fluxos de baixo código.

Melhor para. Construindo fluxos de trabalho e aplicativos LLM de múltiplas etapas onde não engenheiros colaboram com engenheiros.

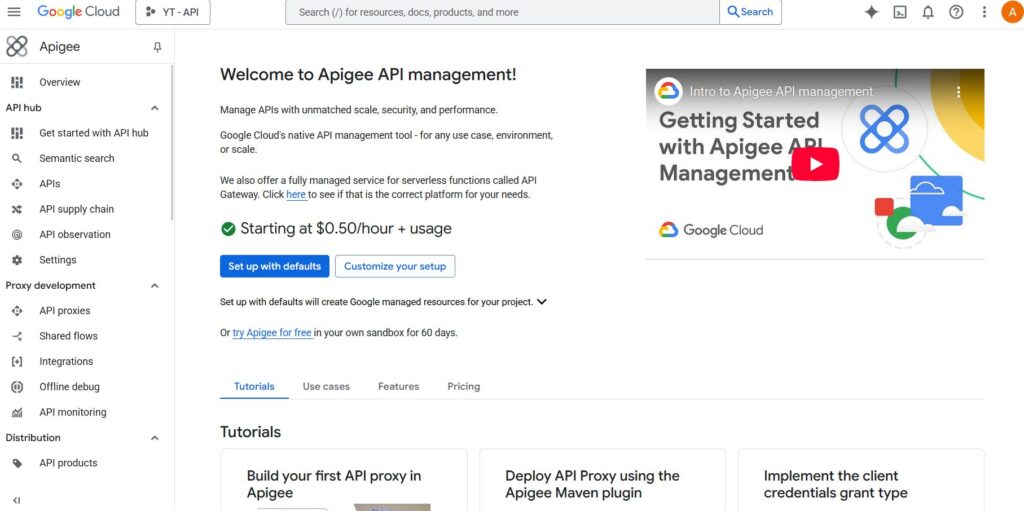

#9 — Apigee (com LLMs por trás)

O que é. Um gateway/gerenciamento de API maduro que você pode colocar na frente de provedores de LLM para aplicar políticas, chaves e cotas.

Melhor para. Empresas consolidando a governança de API sob um único guarda-chuva com controles familiares.

#10 — NGINX

O que é. Use o NGINX para construir roteamento personalizado, aplicação de tokens e caching para backends de LLM se preferir controle DIY.

Melhor para. Equipes com DNA de infraestrutura que desejam controle detalhado sem adotar um produto de IA separado.

MLflow AI Gateway vs ShareAI (resumo rápido)

Se você precisa de uma API única para vários provedores com preços/latência/tempo de atividade transparentes e failover instantâneo, escolha ShareAI. Se sua principal necessidade é governança de saída—credenciais centralizadas, aplicação de políticas e observabilidade—Portal de IA do MLflow se encaixa nesse cenário. Muitas equipes os combinam: gateway para política organizacional mais ShareAI para roteamento de marketplace.

Comparação rápida

| Plataforma | Quem atende | Amplitude do modelo | 2. Governança e segurança | Observabilidade | Roteamento / failover | Transparência do marketplace | Programa de provedores |

|---|---|---|---|---|---|---|---|

| ShareAI | Equipes de produto/plataforma que precisam de uma API e economia justa | 150+ modelos, muitos provedores | Chaves de API e controles por rota | Uso do console mais estatísticas do marketplace | Roteamento inteligente + failover instantâneo | Sim (preço, latência, tempo de atividade, disponibilidade, tipo de provedor) | Sim — fornecimento aberto; 70% para fornecedores |

| Portal de IA do MLflow | Equipes que desejam governança de saída | Provedores próprios | Credenciais/políticas centralizadas | Fluxos de trabalho nativos do MLflow | Roteamento condicional via configuração | Não (ferramenta de infraestrutura, não um marketplace) | n/d |

| Kong IA Gateway | Empresas que precisam de políticas em nível de gateway | BYO | Políticas/plugins fortes na borda | Análises | Proxy/plugins, tentativas | Não | n/d |

| Portkey | Equipes regulamentadas/empresariais | Amplo | Trilhos de proteção e governança | Rastreamentos profundos | Roteamento condicional | Parcial | n/d |

| OpenRouter | Desenvolvedores que desejam uma única chave | Catálogo amplo | Controles básicos de API | Lado do aplicativo | Alternativas | Parcial | n/d |

| Eden IA | Equipes que precisam de LLM + outras IA | Amplo | Controles padrão | Varia | Alternativas/cache | Parcial | n/d |

| LiteLLM | Proxy DIY/autohospedado | Muitos provedores | Limites de configuração/chave | Sua infraestrutura | Repetições/alternativas | n/d | n/d |

| Unificar | Equipes orientadas pela qualidade | Multi-modelo | Segurança padrão de API | Análises da plataforma | Seleção do melhor modelo | n/d | n/d |

| Orq | Equipes com foco em orquestração | Suporte amplo | Controles da plataforma | Análises da plataforma | Fluxos de orquestração | n/d | n/d |

| Apigee / NGINX | Empresas / DIY | BYO | Políticas | Complementos / personalizados | Personalizado | n/d | n/d |

Preços e TCO: compare custos reais (não apenas preços unitários)

O preço bruto por 1K tokens esconde o quadro real. O TCO muda com tentativas/recuos, latência (que afeta o uso e a paciência do usuário), variação do provedor, armazenamento de observabilidade e execuções de avaliação. Um mercado transparente ajuda você a escolher rotas que equilibram custo e UX.

Um modelo mental:

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))Protótipo (~10k tokens/dia). Otimize para o tempo até o primeiro token usando o Playground e os quickstarts. Escala média (~2M tokens/dia). O roteamento/failover guiado pelo marketplace pode reduzir 10–20% enquanto melhora o UX. Cargas de trabalho irregulares. Espere custos efetivos mais altos de tokens devido a tentativas durante o failover; planeje o orçamento para isso.

Guia de migração: movendo para ShareAI

Do MLflow AI Gateway → ShareAI

Mantenha as políticas no nível do gateway onde elas brilham; adicione o ShareAI para roteamento de mercado e failover instantâneo. Padrão: autenticação/política do gateway → rota ShareAI por modelo → medir estatísticas do mercado → apertar políticas.

De OpenRouter → ShareAI

Mapeie nomes de modelos, verifique a paridade de prompts, depois sombreie 10% do tráfego e aumente 25% → 50% → 100% conforme os orçamentos de latência/erro forem mantidos. Os dados do marketplace tornam as trocas de provedor diretas.

De LiteLLM → ShareAI

Substitua o proxy auto-hospedado em rotas de produção que você não deseja operar; mantenha o LiteLLM para desenvolvimento, se desejado. Compare a sobrecarga de operações com os benefícios do roteamento gerenciado.

De Unify / Portkey / Orq / Kong → ShareAI

Definir expectativas de paridade de recursos (análises, limites, orquestração, plugins). Muitas equipes operam de forma híbrida: mantenha recursos especializados onde são mais fortes; use ShareAI para escolha transparente de provedores e failover.

Início rápido para desenvolvedores (copiar-colar)

A superfície da API é compatível com OpenAI. Substitua SUA_CHAVE nos trechos abaixo. Crie uma chave aqui: Criar Chave de API. Veja a documentação: Referência da API and Página Inicial da Documentação.

#!/usr/bin/env bash"// JavaScript (fetch) — Node 18+/Edge runtimes;# Python — requestsLista de verificação de segurança, privacidade e conformidade (agnóstica ao fornecedor)

- Manipulação de chaves. Cadência de rotação; escopos mínimos; separação de ambientes.

- Retenção de dados. Onde os prompts/respostas são armazenados e por quanto tempo; padrões de redação.

- PII & conteúdo sensível. Mascaramento; controles de acesso; roteamento regional para localidade de dados.

- Observabilidade. Registro de prompts/respostas; capacidade de filtrar ou pseudonimizar; propagar IDs de rastreamento de forma consistente.

- Resposta a incidentes. Caminhos de escalonamento e SLAs de provedores.

# Pré-requisitos:

# pip install requests

CompartilharAI. # export SHAREAI_API_KEY="YOUR_KEY".

FAQ — MLflow AI Gateway vs outros concorrentes

OpenRouter torna o acesso a múltiplos modelos rápido; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? centraliza política/observabilidade. Se você também deseja transparência pré-rota e failover instantâneo, ShareAI combina acesso multi-provedor com uma visão de marketplace e roteamento resiliente.

Foi construído para transparência de mercado (preço, latência, uptime, disponibilidade, tipo de provedor) e roteamento inteligente/failover entre muitos provedores. MLflow AI Gateway é uma ferramenta de governança de saída (credenciais/política centralizadas; observabilidade). Muitas equipes usam ambos.

MLflow AI Gateway vs OpenRouter — acesso rápido a multi-modelos ou controles de gateway? ShareAI. MLflow.

MLflow AI Gateway vs Portkey — quem é mais forte em guardrails?

Ambos enfatizam governança e observabilidade; profundidade e ergonomia diferem. Se sua principal necessidade é escolha transparente de provedor e failover, adicione ShareAI para roteamento transparente entre múltiplos provedores e failover.

. Equipes que procuram por “alternativas ao Portkey” frequentemente preferem a história de mercado + roteamento do ShareAI.

Kong MLflow AI Gateway vs Traefik AI Gateway — dois gateways?; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? Ambos são gateways (políticas, plugins/middlewares, análises), não mercados. Muitas equipes combinam um gateway com ShareAI.

MLflow AI Gateway vs Kong AI Gateway — política empresarial ou workflows nativos do MLflow?

Eden IA agrega vários serviços de IA (LLM, imagem, TTS). MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? centraliza políticas/credenciais. Para preços/latência transparentes e failover instantâneo entre provedores, escolha ShareAI.

MLflow AI Gateway vs LiteLLM — proxy auto-hospedado ou governança gerenciada?

LiteLLM é um proxy DIY que você opera; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? fornece governança/observabilidade gerenciada para saída de IA. Se você prefere não executar um proxy e deseja roteamento orientado por marketplace, escolha ShareAI.

MLflow AI Gateway vs Unify — seleção do melhor modelo vs aplicação de políticas?

Unificar foca na seleção de modelo baseada em avaliação; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? foca em políticas/observabilidade. Para uma API sobre muitos provedores com estatísticas de marketplace ao vivo, use ShareAI.

MLflow AI Gateway vs Orq — orquestração vs saída?

Orq ajuda a orquestrar fluxos de trabalho; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? governa o tráfego de saída. ShareAI complementa qualquer um com roteamento de marketplace.

MLflow AI Gateway vs Apigee — gerenciamento de API vs saída específica de IA?

Apigee é gerenciamento amplo de API; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? é governança de saída focada em IA em um contexto MLflow. Para acesso agnóstico ao provedor com transparência de marketplace, use ShareAI.

MLflow AI Gateway vs NGINX — faça você mesmo vs solução pronta?

NGINX oferece filtros/políticas DIY; MLflow AI Gateway vs ShareAI — qual para roteamento multi-provedor? oferece uma camada empacotada com observabilidade compatível com MLflow. Para evitar Lua personalizada e ainda obter seleção transparente de provedores, adicione ShareAI.