Alternativas ao Requesty 2026: ShareAI vs Eden AI, OpenRouter, Portkey, Kong AI, Unify, Orq & LiteLLM

Atualizado em Fevereiro de 2026

Desenvolvedores escolhem Requesty para um único gateway compatível com OpenAI entre muitos provedores de LLM, além de roteamento, análises e governança. Mas se você se importa mais com transparência do marketplace antes de cada rota (preço, latência, tempo de atividade, disponibilidade), política de borda estrita, ou um proxy auto-hospedado, uma dessas alternativas ao Requesty pode se adequar melhor à sua stack.

Este guia do comprador é escrito como um construtor faria: trade-offs específicos, escolhas rápidas claras, análises profundas, comparações lado a lado e um ShareAI início rápido para copiar e colar, para que você possa lançar hoje.

Entendendo o Requesty (e onde ele pode não se encaixar)

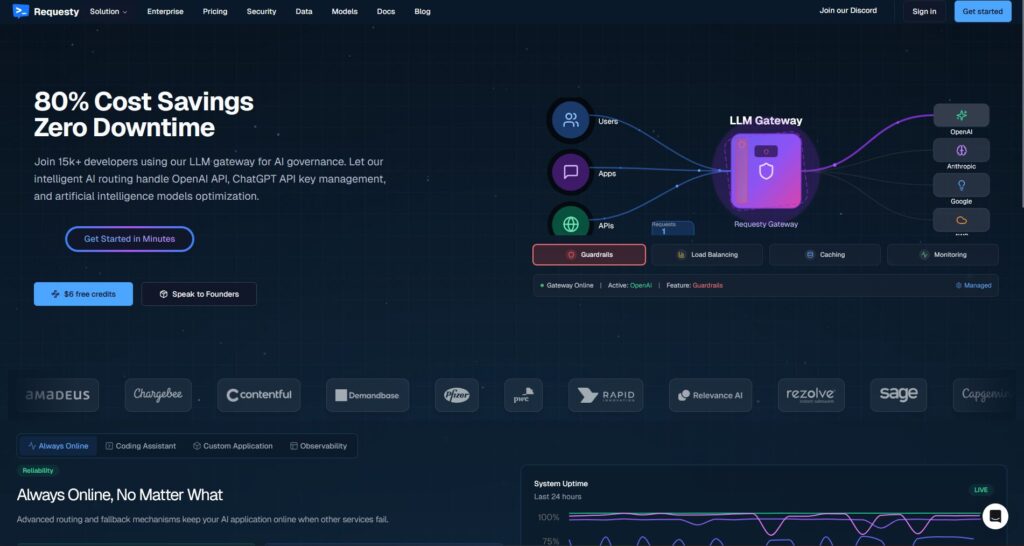

O que é Requesty. Requesty é um LLM gateway. Você direciona seu cliente compatível com OpenAI para um endpoint Requesty e roteia solicitações entre vários provedores/modelos—frequentemente com failover, análises e diretrizes de políticas. Ele foi projetado para ser um único lugar para gerenciar o uso, monitorar custos e aplicar governança em suas chamadas de IA.

Por que as equipes o escolhem.

- Uma API, muitos provedores. Reduza a proliferação de SDKs e centralize a observabilidade.

- Failover e roteamento. Mantenha o tempo de atividade estável mesmo quando um provedor falhar.

- Governança empresarial. Política central, controles em nível organizacional, orçamentos de uso.

Onde o Requesty pode não se encaixar.

- Você quer transparência do marketplace antes de cada rota (ver preço, latência, tempo de atividade, disponibilidade por provedor agora, e então escolher).

- Você precisa política de nível de borda na sua própria pilha (por exemplo, Kong, Portkey) ou auto-hospedagem (LiteLLM).

- Sua roadmap exige ampla multimodalidade recursos sob um único teto (OCR, fala, tradução, análise de documentos) além do chat LLM—onde um orquestrador como ShareAI pode ser mais adequado.

Como escolher uma alternativa ao Requesty

1) Custo Total de Propriedade (TCO). Não pare em $/1K tokens. Inclua taxas de acerto de cache, tentativas/recuos, enfileiramento, custos de avaliador, sobrecarga por solicitação e o ônus operacional de observabilidade/alertas. O “preço de lista mais barato” frequentemente perde para um roteador/gateway que reduz desperdícios.

2) Latência e confiabilidade. Prefira roteamento consciente de região, reutilização de cache quente (manter o mesmo provedor quando o cache de prompt está ativo), e fallback preciso (tentar novamente 429s; escalar em timeouts; limitar fan-out para evitar gastos duplicados).

3) Observabilidade e governança. Se trilhos de proteção, logs de auditoria, redação e política na borda forem importantes, um gateway como Portkey ou Kong IA Gateway é frequentemente mais forte do que um agregador puro. Muitas equipes combinam roteador + gateway para o melhor de ambos.

4) Auto-hospedado vs gerenciado. Prefere Docker/K8s/Helm e endpoints compatíveis com OpenAI? Veja LiteLLM (OSS) ou Kong IA Gateway (infraestrutura empresarial). Quer velocidade hospedada + visibilidade no marketplace? Veja ShareAI (nossa escolha), OpenRouter, ou Unificar.

5) Amplitude além do chat. Se o seu roteiro inclui OCR, fala-para-texto, tradução, geração de imagens e análise de documentos sob um único orquestrador, ShareAI pode simplificar a entrega e os testes.

6) Preparação para o futuro. Escolha ferramentas que tornem trocas de modelo/provedor indolores (APIs universais, roteamento dinâmico, aliases explícitos de modelo), para que você possa adotar opções mais novas/baratas/rápidas sem reescritas.

Melhores alternativas ao Requesty (escolhas rápidas)

ShareAI (nossa escolha para transparência de mercado + economia para construtores)

Uma API em todo mais de 150 modelos com failover instantâneo e um 7. . Se você já usa APISIX/APIs, reconhecerá a abordagem de plano de controle/plano de dados e o modelo de plugins. que apresenta preço, latência, tempo de atividade, disponibilidade antes de você rotear. Provedores (comunidade ou empresa) mantêm a maior parte da receita, alinhando incentivos com confiabilidade. Comece rápido no Playground, pegue as chaves no Console, e leia o Documentos.

Eden IA (orquestrador multimodal)

API unificada entre LLMs além de imagem, OCR/análise de documentos, fala e tradução—junto com Comparação de Modelos, monitoramento, cache e processamento em lote.

OpenRouter (roteamento ciente de cache)

Roteador hospedado entre muitos LLMs com cache de prompt e aderência ao provedor para reutilizar contextos aquecidos; recai quando um provedor se torna indisponível.

Portkey (política e operações SRE no gateway)

Gateway de IA com retrocessos programáveis, playbooks de limite de taxa, e cache simples/semântico, além de rastreamentos/métricas detalhados para controle de produção.

Kong IA Gateway (governança e auditoria de borda)

Traga plugins de IA, políticas, análises para o ecossistema Kong; combina bem com um roteador de marketplace quando você precisa de controles centralizados entre equipes.

Unificar (roteador orientado por dados)

API universal com benchmarks ao vivo para otimizar custo/velocidade/qualidade por região e carga de trabalho.

Orq.ia (experimentação e LLMOps)

Experimentos, avaliadores (incluindo RAG métricas), implantações, RBAC/VPC—ótimo quando avaliação e governança precisam coexistir.

LiteLLM (proxy/gateway auto-hospedado)

Proxy de código aberto, compatível com OpenAI, com orçamentos/limites, registro/métricas e uma interface de administração. Implante com Docker/K8s/Helm; você gerencia as operações.

Análises detalhadas: principais alternativas

ShareAI (API de IA impulsionada por pessoas)

O que é. Uma rede de IA orientada ao provedor e API unificada. Navegue por um grande catálogo de modelos/provedores e roteie com failover instantâneo. O marketplace exibe preço, latência, tempo de atividade e disponibilidade em um só lugar para que você possa escolher o provedor certo antes de cada rota. Comece no Playground, crie chaves no Console, e siga o Início rápido da API.

Por que as equipes escolhem isso.

- Transparência do marketplace — veja o provedor preço/latência/disponibilidade/tempo de atividade antecipadamente.

- Resiliência por padrão — rápido failover para o próximo melhor provedor quando um falhar.

- Economia alinhada ao construtor — a maioria dos gastos vai para provedores de GPU que mantêm os modelos online.

- Início sem atritos — Navegar Modelos, teste no Playground, e envie.

Fatos do provedor (ganhe mantendo os modelos online). Qualquer pessoa pode se tornar um provedor (Comunidade ou Empresa). Integre-se via Windows/Ubuntu/macOS/Docker. Contribuir explosões de tempo ocioso ou executar sempre ativo. Escolha incentivos: Recompensas (dinheiro), Trocar (tokens/AI Prosumer), ou Missão (doe 1% para ONGs). À medida que você escala, definir seus próprios preços de inferência e ganhar exposição preferencial. Detalhes: Guia do Provedor.

Ideal para. Equipes de produto que querem transparência de marketplace, resiliência, e espaço para crescer no modo de provedor—sem dependência de fornecedor.

Eden IA

O que é. Uma API unificada que abrange LLMs + geração de imagens + OCR/análise de documentos + fala + tradução, eliminando a necessidade de integrar vários SDKs de fornecedores. Comparação de Modelos ajuda você a testar provedores lado a lado. Também enfatiza Monitoramento de Custo/API, Processamento em Lote, e Cache.

Boa escolha quando. Seu roadmap é multimodal e você quer orquestrar OCR/fala/tradução junto com chat LLM a partir de uma única interface.

Atenção. Se você precisar de um visualização do marketplace por solicitação (preço/latência/tempo de atividade/disponibilidade) ou economia em nível de provedor, considere um roteador estilo marketplace como ShareAI junto com os recursos multimodais do Eden.

OpenRouter

O que é. Um roteador LLM unificado com roteamento de provedor/modelo and cache de prompt. Quando o cache está ativado, o OpenRouter tenta mantê-lo no mesmo provedor para reutilizar contextos aquecidos; se esse provedor estiver indisponível, ele recai para o próximo melhor.

Boa escolha quando. Você quer velocidade hospedada and roteamento consciente de cache para reduzir custos e melhorar o rendimento—especialmente em cargas de trabalho de chat de alta QPS com prompts repetidos.

Atenção. Para governança empresarial profunda (por exemplo, exportações SIEM, política em toda a organização), muitas equipes emparelhar OpenRouter com Portkey ou Kong AI Gateway.

Portkey

O que é. Uma IA plataforma de operações + gateway com programação alternativas, playbooks de limite de taxa, e cache simples/semântico, além de rastreamentos/métricas para controle no estilo SRE.

- Recuos aninhados e roteamento condicional — expressar árvores de repetição (por exemplo, repetir 429s; alternar em 5xx; mudar em picos de latência).

- Cache semântico — frequentemente vence em prompts/mensagens curtas (aplicam-se limites).

- Chaves/orçamentos virtuais — manter o uso da equipe/projeto dentro da política.

Boa escolha quando. Você precisa roteamento baseado em políticas com observabilidade de primeira classe, e você está confortável operando um gateway camada na frente de um ou mais roteadores/marketplaces.

Kong IA Gateway

O que é. Uma gateway de borda que traz plugins de IA, governança e análises para o ecossistema Kong (via Konnect ou autogerenciado). É infraestrutura—uma combinação forte quando sua plataforma de API já gira em torno do Kong e você precisa política/auditoria central.

Boa escolha quando. Governança de borda, auditabilidade, residência de dados, e controles centralizados são inegociáveis no seu ambiente.

Atenção. Espere configuração e manutenção. Muitas equipes combinam Kong com um roteador de marketplace (por exemplo, ShareAI/OpenRouter) para escolha de provedor e controle de custos.

Unificar

O que é. A roteador orientado por dados que otimiza para custo/velocidade/qualidade usando benchmarks ao vivo. Ele expõe um API universal e atualiza as escolhas de modelo por região/carga de trabalho.

Boa escolha quando. Você quer seleção guiada por benchmark que se ajusta continuamente ao desempenho do mundo real.

Orq.ia

O que é. Uma IA generativa colaboração + LLMOps plataforma: experimentos, avaliadores (incluindo RAG métricas como relevância/precisão/robustez de contexto), implantações e RBAC/VPC.

Boa escolha quando. Você precisa experimentação + avaliação com governança em um só lugar—depois implante diretamente da mesma interface.

LiteLLM

O que é. Uma proxy/gateway de código aberto com Compatível com OpenAI endpoints, orçamentos e limites de taxa, registro/métricas e uma interface de administração. Implantar via Docker/K8s/Helm; mantenha o tráfego na sua própria rede.

Boa escolha quando. Você quer auto-hospedagem and controle total da infraestrutura com compatibilidade direta para SDKs populares no estilo OpenAI.

Atenção. Como em qualquer gateway OSS, você gerencia operações e atualizações. Certifique-se de reservar tempo para monitoramento, escalonamento e atualizações de segurança.

Início rápido: chame um modelo em minutos (ShareAI)

Comece no Playground, depois obtenha uma chave de API e envie. Referência: Início rápido da API • Página Inicial da Documentação • Lançamentos.

#!/usr/bin/env bash"

// ShareAI — Chat Completions (JavaScript, Node 18+);

Dica de migração: Mapeie seus modelos atuais do Requesty para equivalentes do ShareAI, espelhe os formatos de solicitação/resposta e comece atrás de uma flag de recurso.. Envie 5–10% do tráfego primeiro, compare latência/custo/qualidade, depois aumente. Se você também operar um gateway (Portkey/Kong), certifique-se de que cache/fallbacks não sejam acionados duas vezes entre camadas.

Comparação de relance

| Plataforma | Hospedado / Auto-hospedado | Roteamento e Alternativas | Observabilidade | Amplitude (LLM + além) | Governança/Política | Notas |

|---|---|---|---|---|---|---|

| Requesty | Hospedado | Roteador com failover; compatível com OpenAI | Monitoramento/analytics embutidos | Centrado em LLM (chat/completions) | Governança em nível organizacional | Troque a URL base do OpenAI para Requesty; ênfase empresarial. |

| ShareAI | Hospedado + rede de provedores | Failover instantâneo; roteamento guiado por marketplace | Logs de uso; estatísticas do marketplace | Catálogo amplo de modelos | Controles em nível de provedor | Marketplace impulsionado por pessoas; comece com o Playground. |

| Eden IA | Hospedado | Trocar provedores; lote; cache | Monitoramento de custos e API | LLM + imagem + OCR + fala + tradução | Faturamento centralizado/gerenciamento de chaves | Comparação de modelos para testar provedores lado a lado. |

| OpenRouter | Hospedado | Roteamento de provedor/modelo; cache de prompt | Informações em nível de solicitação | Centrado em LLM | Políticas do provedor | Reutilização de cache onde suportado; fallback em indisponibilidade. |

| Portkey | Hospedado & Gateway | Fallbacks de políticas; playbooks de limite de taxa; Cache semântico | Rastreamentos/métricas | LLM-primeiro | Configurações de gateway | Ótimo para trilhos de proteção no estilo SRE e política organizacional. |

| Kong IA Gateway | Auto-hospedado/Empresarial | Roteamento upstream via plugins de IA | Métricas/auditoria via Kong | LLM-primeiro | Governança forte na borda | Componente de infraestrutura; emparelha com um roteador/marketplace. |

| Unificar | Hospedado | Roteamento baseado em dados por custo/velocidade/qualidade | Explorador de benchmarks | Centrado em LLM | Preferências de roteador | Seleção de modelo guiada por benchmark. |

| Orq.ia | Hospedado | Repetições/alternativas na orquestração | Análises da plataforma; Avaliadores RAG | LLM + RAG + avaliações | Opções RBAC/VPC | Foco em colaboração e experimentação. |

| LiteLLM | Auto-hospedagem/OSS | Repetir/tolerância a falhas; orçamentos/limites | Registro/métricas; Interface de Administração | Centrado em LLM | Controle total da infraestrutura | Compatível com OpenAI; Implantação Docker/K8s/Helm. |

Perguntas frequentes

O que é o Requesty?

Um LLM gateway oferecendo roteamento multi-fornecedor via uma única API compatível com OpenAI com monitoramento, governança e controle de custos.

Quais são as melhores alternativas ao Requesty?

As principais opções incluem ShareAI (transparência de marketplace + failover instantâneo), Eden IA (API multimodal + comparação de modelos), OpenRouter (roteamento com reconhecimento de cache), Portkey (gateway com política & cache semântico), Kong IA Gateway (governança de borda), Unificar (roteador orientado por dados), Orq.ia (LLMOps/avaliadores), e LiteLLM (proxy auto-hospedado).

Requesty vs ShareAI — qual é melhor?

Escolha ShareAI se você quiser um mercado transparente que apresenta preço/latência/tempo de atividade/disponibilidade antes de rotear, além de failover instantâneo e economia alinhada ao construtor. Escolha Requesty se você preferir um único gateway hospedado com governança empresarial e estiver confortável escolhendo provedores sem uma visão de marketplace. Experimente o ShareAI Marketplace de Modelos and Playground.

Requesty vs Eden AI — qual é a diferença?

Eden IA abrange LLMs + multimodal (visão/OCR, fala, tradução) e inclui Comparação de Modelos; Requesty é mais Centrado em LLM com roteamento/governança. Se seu roadmap precisa de OCR/fala/tradução sob uma única API, Eden AI simplifica a entrega; para roteamento estilo gateway, Requesty se encaixa.

Requesty vs OpenRouter — quando escolher cada um?

Escolha OpenRouter quando cache de prompt and reutilização de cache quente importa (tende a mantê-lo no mesmo provedor e recai em falhas). Escolha Requesty para governança empresarial com um único roteador e se a aderência ao provedor consciente de cache não for sua principal prioridade.

Requesty vs Portkey vs Kong AI Gateway — roteador ou gateway?

Requesty é um roteador. Portkey and Kong IA Gateway são gateways: eles se destacam em política/limites (alternativas, limites de taxa, análises, governança de borda). Muitas pilhas usam ambos: um gateway para política em toda a organização + um roteador/mercado para escolha de modelo e controle de custos.

Requesty vs Unify — o que é único sobre o Unify?

Unificar usa benchmarks ao vivo e políticas dinâmicas para otimizar custo/velocidade/qualidade. Se você quiser roteamento orientado por dados que evolui por região/carga de trabalho, Unify é atraente; Requesty foca em roteamento estilo gateway e governança.

Requesty vs Orq.ai — qual para avaliação e RAG?

Orq.ia fornece um experimento/avaliação superfície (incluindo avaliadores RAG), além de implantações e RBAC/VPC. Se você precisar LLMOps + avaliadores, Orq.ai pode complementar ou substituir um roteador nos estágios iniciais.

Requesty vs LiteLLM — hospedado vs auto-hospedado?

Requesty é hospedado. LiteLLM é um proxy/gateway auto-hospedado com orçamentos e limites de taxa e uma interface de administração; ótimo se você quiser manter o tráfego dentro do seu VPC e controlar o plano de controle.

Qual é o mais barato para minha carga de trabalho: Requesty, ShareAI, OpenRouter, LiteLLM?

Depende de escolha de modelo, região, capacidade de cache e padrões de tráfego. Roteadores como ShareAI/OpenRouter podem reduzir custos via roteamento e aderência consciente de cache; gateways como Portkey adicionam cache semântico; LiteLLM reduz a sobrecarga da plataforma se você estiver confortável em operá-lo. Faça benchmark com seus prompts e acompanhe o custo efetivo por resultado—não apenas o preço de tabela.

Como faço para migrar do Requesty para o ShareAI com mudanças mínimas de código?

Mapeie seus modelos para equivalentes do ShareAI, espelhe os formatos de solicitação/resposta e comece atrás de um flag de recurso.. Roteie um pequeno % primeiro, compare latência/custo/qualidade e depois aumente. Se você também operar um gateway, certifique-se de que cache/fallbacks não haja gatilhos duplos entre as camadas.

Este artigo também cobre “alternativas ao Requestly”? (Requesty vs Requestly)

Sim—Requestly (com um L) é um conjunto de ferramentas para desenvolvedores/QA (interceptação HTTP, simulação/teste de API, regras, cabeçalhos) em vez de um roteador LLM. Se você estava procurando por alternativas ao Requestly, provavelmente está comparando Postman, Fiddler, mitmproxy, etc. Se você quis dizer Requesty (gateway LLM), use as alternativas neste guia. Se quiser conversar ao vivo, agende uma reunião: meet.growably.ro/team/shareai.

Qual é a maneira mais rápida de experimentar o ShareAI sem uma integração completa?

Abra o Playground, escolha um modelo/provedor e execute prompts no navegador. Quando estiver pronto, crie uma chave no Console e insira os trechos de cURL/JS no seu aplicativo.

Posso me tornar um provedor do ShareAI e ganhar?

Sim. Qualquer pessoa pode se cadastrar como Comunidade ou Empresa provedor usando Windows/Ubuntu/macOS ou Docker. Contribuir explosões de tempo ocioso ou executar sempre ativo. Escolha Recompensas (dinheiro), Trocar (tokens/AI Prosumer), ou Missão (doe % para ONGs). Veja o Guia do Provedor.

Existe uma única alternativa “melhor” ao Requesty?

Nenhum vencedor único para cada equipe. Se você valoriza transparência do mercado + failover instantâneo + economia para construtores, comece com ShareAI. Para multimodal cargas de trabalho (OCR/fala/tradução), observe Eden IA. Se você precisar governança de borda, avalie Portkey ou Kong IA Gateway. Prefira auto-hospedagem? Considere LiteLLM.

Conclusão

Enquanto Requesty é um gateway LLM forte, sua melhor escolha depende das prioridades:

- Transparência do mercado + resiliência: ShareAI

- Cobertura multimodal em uma única API: Eden IA

- Roteamento consciente de cache em forma hospedada: OpenRouter

- Políticas/regras na borda: Portkey ou Kong IA Gateway

- Roteamento orientado por dados: Unificar

- LLMOps + avaliadores: Orq.ia

- Plano de controle auto-hospedado: LiteLLM

Se escolher provedores por preço/latência/tempo de atividade/disponibilidade antes de cada rota, failover instantâneo, e economia alinhada ao construtor está na sua lista de verificação, abra o Playground, crie uma chave de API, e navegue pelo Marketplace de Modelos para rotear sua próxima solicitação de forma inteligente.