Alternative MLflow AI Gateway 2026: Cele mai bune alternative

Actualizat februarie 2026

Dacă cercetați Alternative pentru MLflow AI Gateway, acest ghid orientat către constructor clarifică ce este (și ce nu este) MLflow AI Gateway, stabilește criterii de evaluare și compară cele mai bune 10 opțiuni. Noi plasăm ShareAI pe primul loc pentru echipele care doresc un API unic pentru mulți furnizori, semnale transparente de piață (preț, latență, disponibilitate, uptime) înainte de rutare, failover instant și economie bazată pe oameni (70% din cheltuieli merg către furnizori). Vezi conceptele oficiale ale funcțiilor în documentația MLflow.

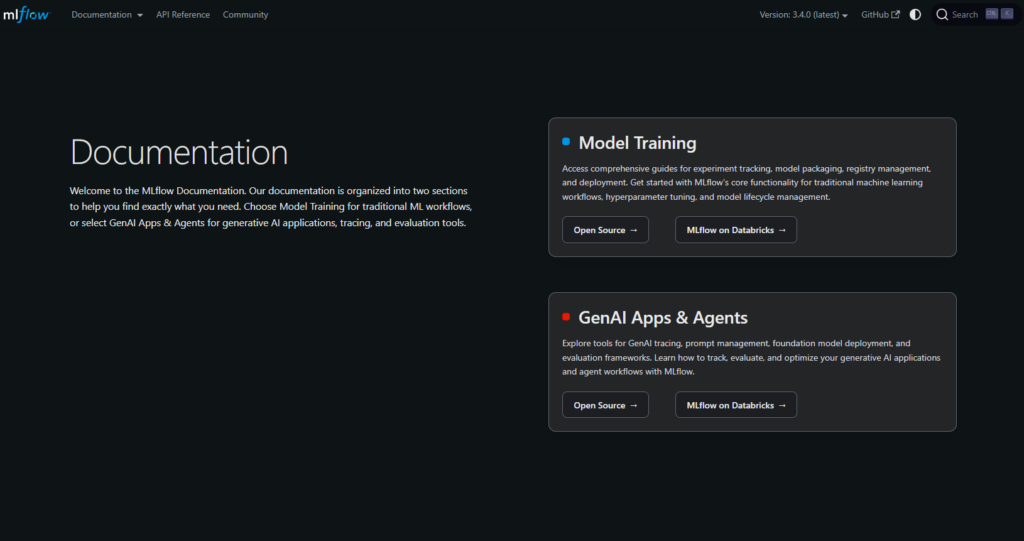

Ce este (și ce nu este) MLflow AI Gateway

Ce este. Un strat de control egress AI/LLM în cadrul ecosistemului MLflow. Centralizează acreditările și politicile, expune o suprafață unificată pentru a comunica cu mai mulți furnizori de modele și se integrează în fluxurile de experimentare/urmărire/evaluare ale MLflow. Pe scurt: guvernanță și gestionarea traficului pentru apelurile LLM.

Ce nu este. O piață de modele transparentă care arată prețul live, latența, uptime-ul și disponibilitatea pentru mulți furnizori înainte de rutare. Gateway-urile se concentrează pe control și observabilitate. Piețele se concentrează pe alegere și economia performanței la nivel de rută.

Concluzie: Dacă cerința ta principală este rutarea independentă de furnizor cu transparență înainte de rutare și failover instant, combină sau înlocuiește un gateway cu ShareAI. Dacă cerința ta principală este politica centralizată a organizației și observabilitatea, un gateway se potrivește acestui scop.

Agregatori vs Gateway-uri vs Platforme de agenți

- Agregatori LLM (piețe). Un API unic pentru multe modele/furnizori cu transparență înainte de rutare (preț, latență, uptime, disponibilitate, tip de furnizor), plus rutare inteligentă/failover. Bun pentru: experimente mai rapide, ajustare cost/UX, schimbarea furnizorilor fără rescrieri.

- Gateway-uri AI. Guvernanță la margine (credite, scopuri, limite de siguranță), cote/limite de rată și observabilitate. Tu aduci propriii furnizori și conturi. Bun pentru: securitate centralizată, auditabilitate, control egress.

- Platforme de agenți/chatbot. UX ambalat (memorie, instrumente), canale și fluxuri de lucru ale echipei—optimizate pentru asistenți de utilizatori finali mai degrabă decât pentru agregare neutră față de furnizor.

Cum am evaluat cele mai bune alternative pentru MLflow AI Gateway

- Lățimea și neutralitatea modelului — proprietar + deschis; comutare ușoară; rescrieri minime.

- Latență și reziliență — politici de rutare, timeout-uri/reîncercări, failover instantaneu.

- Guvernanță și securitate — gestionarea cheilor, domenii, rutare regională.

- Observabilitate — jurnale/urme și tablouri de bord pentru costuri/latente.

- Transparența prețurilor și TCO — compară costurile reale înainte să rutezi.

- Experiența dezvoltatorului — documentație, SDK-uri, quickstarts; timp-până-la-primul-token.

- Comunitate și economie — dacă cheltuielile tale cresc oferta (stimulente pentru deținătorii de GPU-uri).

Top 10 alternative pentru MLflow AI Gateway

#1 — ShareAI (API AI alimentat de oameni)

Ce este. O API multi-furnizor cu o piață transparentă și rutare inteligentă. Cu o singură integrare, navighează într-un catalog mare de modele și furnizori, compară prețul, latența, timpul de funcționare, disponibilitatea și tipul de furnizor, apoi rutează cu failover instantaneu. Economia este alimentată de oameni: 70% din fiecare dolar merge către furnizori (comunitate sau companie) care mențin modelele online.

De ce este #1 aici. Dacă dorești o agregare neutră față de furnizor cu transparență pre-rutare și reziliență, ShareAI este cea mai potrivită alegere. Păstrează un gateway dacă ai nevoie de politici la nivel de organizație; adaugă ShareAI pentru rutare ghidată de piață.

- O API → 150+ modele de la mulți furnizori; fără rescrieri, fără blocare. • Navighează Modele

- Piață transparentă: alege după preț, latență, timp de funcționare, disponibilitate și tip de furnizor. • Încearcă-l în Loc de joacă

- Reziliență implicită: politici de rutare plus failover instantaneu.

- Economie echitabilă: 70% din cheltuieli merge către furnizori (comunitate sau companie). • Creează Cheie API · Referință API · Documentație · Lansări

Pentru furnizori: câștigați menținând modelele online. Oricine poate deveni furnizor ShareAI—Comunitate sau Companie. Înregistrați-vă prin Windows, Ubuntu, macOS sau Docker. Contribuiți cu explozii de timp inactiv sau rulați mereu activ. Alegeți-vă stimulentul: Recompense (bani), Schimb (token-uri / AI Prosumer) sau Misiune (donați un % către ONG-uri). Pe măsură ce scalați, puteți seta propriile prețuri de inferență și obțineți expunere preferențială. • Ghidul Furnizorului · Panoul de control al furnizorului

#2 — Portcheie

Ce este. Poartă AI care pune accent pe observabilitate, măsuri de protecție și guvernanță—populară printre echipele care au nevoie de controale și diagnosticări puternice.

Cel mai potrivit pentru. Medii reglementate/enterprise unde profunzimea guvernanței este prioritatea principală. Completează ShareAI atunci când aveți nevoie de aplicarea profundă a politicilor, dar doriți și rutare ghidată de piață.

#3 — Poarta AI Kong

Ce este. Poartă AI/LLM enterprise—politici/plugin-uri, analize și observabilitate la margine pentru traficul AI. Un plan de control mai degrabă decât o piață.

Cel mai potrivit pentru. Politică la nivel de organizație, cote și extensii bazate pe plugin-uri pentru echipe eterogene.

#4 — OpenRouter

Ce este. Un API unificat peste multe modele; excelent pentru experimentare rapidă într-un catalog larg.

Cel mai potrivit pentru. Acces rapid la modele multiple; completează porțile atunci când aveți nevoie de alegere mai mult decât de politică.

#5 — Eden AI

Ce este. Agregă LLM-uri plus capacități AI mai largi (viziune, traducere, TTS), cu soluții de rezervă/cache și grupare.

Cel mai potrivit pentru. Echipe care au nevoie de mai multe modalități AI într-un singur loc cu controale standard.

#6 — LiteLLM

Ce este. SDK Python ușor plus proxy auto-găzduibil care utilizează o interfață compatibilă cu OpenAI pentru mulți furnizori.

Cel mai potrivit pentru. Control DIY atunci când preferați să operați proxy-ul singur și să ajustați retry-urile/soluțiile de rezervă.

#7 — Unify

Ce este. Rutare și evaluare orientată spre calitate pentru a alege modele mai bune pentru fiecare solicitare.

Cel mai potrivit pentru. Echipe orientate spre evaluare, axate pe calitatea răspunsului și selecția specifică promptului.

#8 — Orq AI

Ce este. Platformă de orchestrare/colaborare care ajută echipele să treacă de la experimente la producție cu fluxuri low-code.

Cel mai potrivit pentru. Construirea de fluxuri de lucru și aplicații LLM multi-pas unde non-inginerii colaborează cu inginerii.

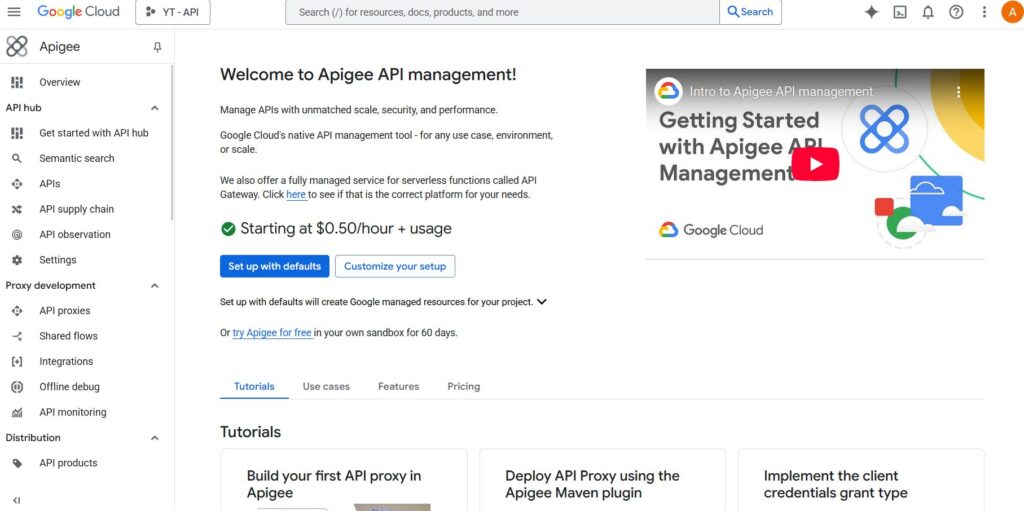

#9 — Apigee (cu LLM-uri în spate)

Ce este. O soluție matură de gestionare/pasarelă API pe care o poți plasa în fața furnizorilor LLM pentru a aplica politici, chei și cote.

Cel mai potrivit pentru. Întreprinderi care consolidează guvernarea API sub o singură umbrelă cu controale familiare.

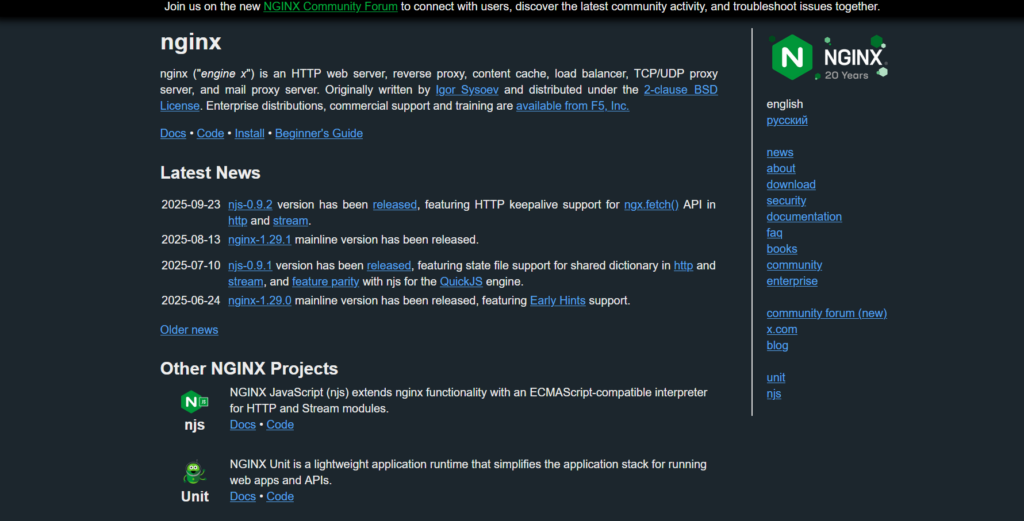

#10 — NGINX

Ce este. Utilizează NGINX pentru a construi rutare personalizată, aplicarea token-urilor și cache pentru backend-urile LLM dacă preferi control DIY.

Cel mai potrivit pentru. Echipe cu ADN de infrastructură care doresc control detaliat fără a adopta un produs AI separat.

MLflow AI Gateway vs ShareAI (rezumat rapid)

Dacă aveți nevoie de un API unic pentru mulți furnizori cu prețuri/latență/uptime transparente și failover instant, alegeți ShareAI. Dacă cerința principală este guvernanța egress—acreditări centralizate, aplicarea politicilor și observabilitate—Poarta AI MLflow se potrivește în acest caz. Multe echipe le combină: gateway pentru politica organizației plus ShareAI pentru rutarea pieței.

Comparație rapidă

| Platformă | Cui îi servește | Lățimea modelului | Guvernanță și securitate | Observabilitate | Rutare / failover | Transparența pieței | Programul furnizorului |

|---|---|---|---|---|---|---|---|

| ShareAI | Echipe de produs/platformă care au nevoie de un API și economie echitabilă | Peste 150 de modele, mulți furnizori | Chei API & controale per rută | Utilizarea consolei plus statistici de piață | Rutare inteligentă + failover instant | Da (preț, latență, timp de funcționare, disponibilitate, tip de furnizor) | Da — ofertă deschisă; 70% către furnizori |

| Poarta AI MLflow | Echipe care doresc guvernare egress | Furnizori BYO | Acreditive/politici centralizate | Fluxuri de lucru native MLflow | Rutare condiționată prin configurare | Nu (instrument de infrastructură, nu o piață) | n/a |

| Kong AI Gateway | Întreprinderi care au nevoie de politici la nivel de gateway | BYO | Politici/pluginuri puternice de margine | Analitică | Proxy/pluginuri, reîncercări | Nu | n/a |

| Portkey | Echipe reglementate/enterprise | Larg | Balustrade de protecție și guvernanță | Urmăriri profunde | Rutare condiționată | Parțial | n/a |

| OpenRouter | Dezvoltatori care doresc o singură cheie | Catalog larg | Controale API de bază | Partea aplicației | Soluții de rezervă | Parțial | n/a |

| Eden AI | Echipele care au nevoie de LLM + altă AI | Larg | Controale standard | Variază | Soluții de rezervă/cache | Parțial | n/a |

| LiteLLM | Proxy DIY/autogăzduit | Mulți furnizori | Limite de configurare/cheie | Infrastructura ta | Retrageri/soluții de rezervă | n/a | n/a |

| Unifică | Echipe orientate spre calitate | Multi-model | Securitate API standard | Analitică platformă | Selecție cel mai bun model | n/a | n/a |

| Orq | Echipe orientate spre orchestrare | Suport larg | Controale ale platformei | Analitică platformă | Fluxuri de orchestrare | n/a | n/a |

| Apigee / NGINX | Întreprinderi / DIY | BYO | Politici | Add-ons / personalizat | Personalizat | n/a | n/a |

Prețuri și TCO: comparați costurile reale (nu doar prețurile unitare)

Prețul brut per 1K de tokeni ascunde imaginea reală. TCO se schimbă cu reîncercări/fallback-uri, latență (care afectează utilizarea și răbdarea utilizatorului), variația furnizorului, stocarea observabilității și rulările de evaluare. O piață transparentă te ajută să alegi rute care echilibrează costul și UX.

Un model mental:

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))Prototip (~10k tokeni/zi). Optimizează pentru timpul până la primul token folosind Loc de joacă și quickstarts. Scară medie (~2M tokeni/zi). Rutarea/failover ghidată de piață poate reduce 10–20% în timp ce îmbunătățește UX. Sarcini de lucru fluctuante. Așteptați costuri mai mari efective pe token din cauza încercărilor repetate în timpul failover-ului; planificați bugetul pentru acestea.

Ghid de migrare: trecerea la ShareAI

De la MLflow AI Gateway → ShareAI

Păstrează politicile la nivel de gateway acolo unde excelează; adaugă ShareAI pentru rutare pe piață și failover instant. Model: autentificare/politică gateway → rută ShareAI per model → măsoară statisticile pieței → înăsprește politicile.

De la OpenRouter → ShareAI

Mapați numele modelelor, verificați paritatea promptului, apoi direcționați 10% din trafic și creșteți 25% → 50% → 100% pe măsură ce bugetele de latență/eroare sunt respectate. Datele pieței fac schimburile de furnizori simple.

De la LiteLLM → ShareAI

Înlocuiește proxy-ul găzduit intern pe rutele de producție pe care nu dorești să le operezi; păstrează LiteLLM pentru dezvoltare dacă este dorit. Compară costurile operaționale cu beneficiile rutării gestionate.

De la Unify / Portkey / Orq / Kong → ShareAI

Definiți așteptările de paritate a funcțiilor (analitice, măsuri de siguranță, orchestrare, pluginuri). Multe echipe rulează hibrid: păstrați funcțiile specializate acolo unde sunt cele mai puternice; utilizați ShareAI pentru alegerea transparentă a furnizorului și failover.

Ghid rapid pentru dezvoltatori (copy-paste)

Suprafața API este compatibilă cu OpenAI. Înlocuiți CHEIA_TA în fragmentele de mai jos. Creați o cheie aici: Creează Cheie API. Consultați documentația: Referință API și Docs Acasă.

#!/usr/bin/env bash"// JavaScript (fetch) — Node 18+/Edge runtimes;# Python — requestsLista de verificare pentru securitate, confidențialitate și conformitate (independentă de furnizor)

- Gestionarea cheilor. Ritmul rotației; domenii minime; separarea mediului.

- Păstrarea datelor. Unde sunt stocate solicitările/răspunsurile și pentru cât timp; setările implicite de redactare.

- PII & conținut sensibil. Mascare; controale de acces; rutare regională pentru localitatea datelor.

- Observabilitate. Jurnalizarea solicitărilor/răspunsurilor; capacitatea de a filtra sau pseudonimiza; propagarea consecventă a ID-urilor de urmărire.

- Răspuns la incidente. Căi de escaladare și SLA-uri ale furnizorilor.

# Prereqs:

# pip install requests

ShareAI. # export SHAREAI_API_KEY="YOUR_KEY".

FAQ — MLflow AI Gateway vs alți competitori

OpenRouter face accesul la modele multiple rapid; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? centralizează politica/observabilitatea. Dacă dorești, de asemenea, transparență pre-rutare și failover instant, ShareAI combină accesul multi-furnizor cu o vedere de piață și rutare rezilientă.

Este construit pentru transparența pieței (preț, latență, disponibilitate, uptime, tip de furnizor) și rutare inteligentă/failover între mulți furnizori. MLflow AI Gateway este un instrument de guvernanță egress (credite/politici centralizate; observabilitate). Multe echipe folosesc ambele.

MLflow AI Gateway vs OpenRouter — acces rapid multi-model sau controale gateway? ShareAI. MLflow.

MLflow AI Gateway vs Portkey — cine este mai puternic pe măsuri de protecție?

Ambele pun accent pe guvernanță și observabilitate; profunzimea și ergonomia diferă. Dacă nevoia principală este alegerea transparentă a furnizorului și failover, adăugați ShareAI pentru rutare multi-furnizor transparentă și failover.

. Echipele care caută „alternative Portkey” preferă adesea povestea pieței + rutării ShareAI.

Kong MLflow AI Gateway vs Traefik AI Gateway — două gateway-uri?; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? Ambele sunt gateway-uri (politici, pluginuri/middleware-uri, analitică), nu piețe. Multe echipe combină un gateway cu ShareAI.

MLflow AI Gateway vs Kong AI Gateway — politici enterprise sau fluxuri de lucru native MLflow?

Eden AI agregă mai multe servicii AI (LLM, imagine, TTS). MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? centralizează politicile/credibilitățile. Pentru prețuri/latente transparente și failover instantaneu între furnizori, alege ShareAI.

MLflow AI Gateway vs LiteLLM — proxy auto-găzduit sau guvernanță gestionată?

LiteLLM este un proxy DIY pe care îl operezi; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? oferă guvernanță gestionată/observabilitate pentru ieșirea AI. Dacă preferi să nu rulezi un proxy și dorești rutare bazată pe piață, alege ShareAI.

MLflow AI Gateway vs Unify — selecția celui mai bun model vs aplicarea politicilor?

Unifică se concentrează pe selecția modelului bazată pe evaluare; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? se concentrează pe politici/observabilitate. Pentru un API peste mulți furnizori cu statistici live de piață, folosește ShareAI.

MLflow AI Gateway vs Orq — orchestrare vs ieșire?

Orq ajută la orchestrarea fluxurilor de lucru; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? gestionează traficul de ieșire. ShareAI completează oricare cu rutare prin piață.

MLflow AI Gateway vs Apigee — gestionarea API-urilor vs ieșirea specifică AI?

Apigee este o gestionare amplă a API-urilor; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? este guvernanță de ieșire axată pe AI într-un context MLflow. Pentru acces independent de furnizor cu transparență de piață, folosește ShareAI.

MLflow AI Gateway vs NGINX — DIY vs soluție la cheie?

NGINX oferă filtre/politici DIY; MLflow AI Gateway vs ShareAI — care pentru rutare multi-provider? oferă un strat ambalat cu observabilitate prietenoasă cu MLflow. Pentru a evita Lua personalizat și totuși a obține selecție transparentă a furnizorilor, integrează ShareAI.