Alternative RouteLLM 2026: Când să alegi ShareAI (și ce altceva să iei în considerare)

Actualizat februarie 2026

Dezvoltatorii aleg RouteLLM pentru a direcționa solicitările către modele mai ieftine, vizând o calitate aproape de GPT-4—mai ales pentru sarcini de tip benchmark unde un router învățat poate reduce cu încredere. Dar dacă vă pasă mai mult de transparența pieței înainte de fiecare rută (preț live, latență, disponibilitate, uptime), failover instantaneu între mai mulți furnizori, politici de margine și audit, sau un proxy/gateway auto-găzduit, una dintre aceste alternative RouteLLM poate fi mai potrivită pentru stack-ul tău.

Acest ghid al cumpărătorului este scris ca un constructor: compromisuri specifice, alegeri rapide, analize detaliate, comparații alăturate și un ShareAI quickstart copy-paste pentru a putea livra astăzi.

Înțelegerea RouteLLM (și unde poate să nu se potrivească)

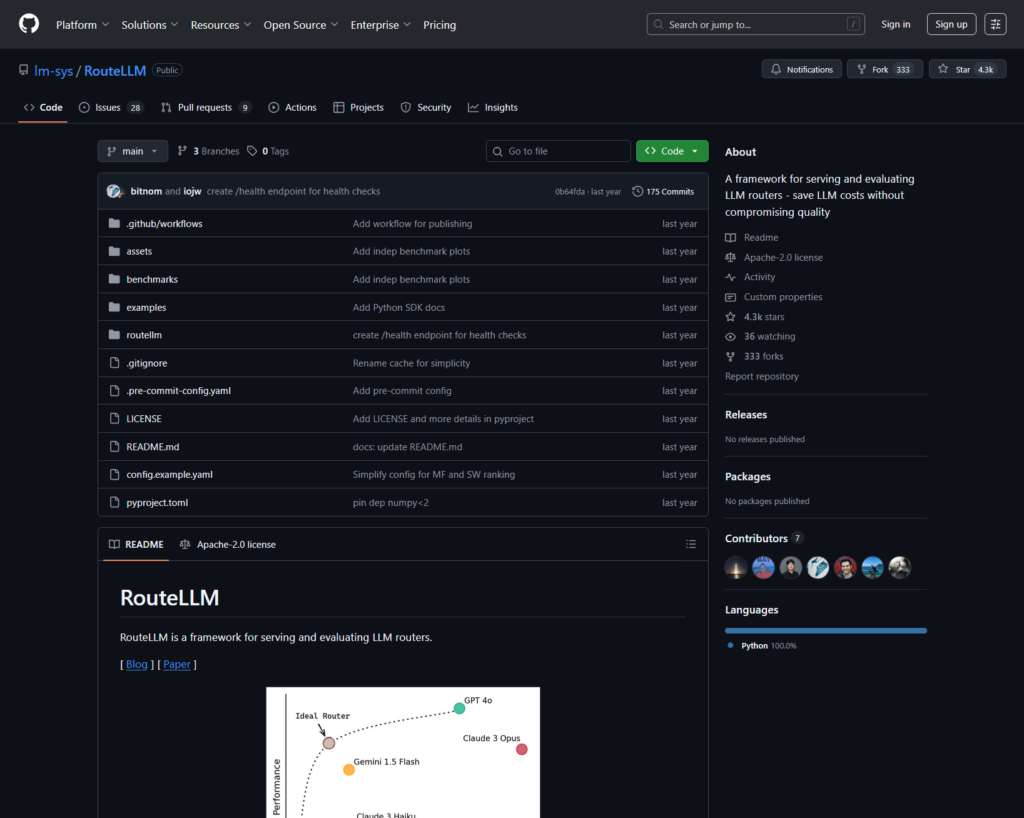

Ce este RouteLLM. RouteLLM este un cadru open-source pentru servirea și evaluarea routerelor LLM. Oferă un client/server compatibil OpenAI și livrează modele de rutare antrenate care pot direcționa interogări mai simple către modele mai ieftine—raportat ca reducere de cost de până la 85%, menținând ~95% din performanța GPT-4 pe benchmark-uri comune (de exemplu, MT-Bench).

De ce echipele îl aleg.

- Rutare sensibilă la costuri cu politici susținute de cercetare.

- Open source și extensibil în Python.

- Compatibil cu OpenAI cale către rutare de probă fără rescrieri grele ale SDK.

Unde RouteLLM poate să nu se potrivească.

- Vrei transparența pieței live (preț, latență, disponibilitate, uptime) înainte de fiecare rută—nu doar o politică învățată.

- Ai nevoie failover multi-furnizor

- Planul tău de dezvoltare acoperă API-uri multimodale precum OCR, vorbire, traducere și analiză de documente sub același acoperiș.

Cum să alegi o alternativă RouteLLM

- Costul Total de Proprietate (TCO). Nu te opri la $/1K tokeni. Ia în considerare ratele de accesare cache, reîncercările/fallback-urile, coada, costurile evaluatorului și povara operațională a jurnalelor/alertelor. Routerele și gateway-urile conștiente de cache cu cache semantic pot face ca un “preț de listă mai scump” să fie mai ieftin în practică.

- Latență și fiabilitate. Favorizează rutarea conștientă de regiune, fidelitatea față de furnizor atunci când cache-ul este cald și fallback-uri precise (reîncercare 429s, escaladare la timeout-uri). Routerele găzduite care te mențin pe același furnizor pentru contexte calde și fac fallback când un furnizor are probleme tind să câștige.

- Observabilitate și guvernanță. Dacă sunt importante balustradele de protecție, redactarea, jurnalele de audit și politica la margine, un gateway AI (Portkey sau Kong AI Gateway) este de obicei mai puternic decât un router pur. Multe echipe combină router + gateway.

- Auto-găzduit vs. gestionat. Preferi Docker/K8s/Helm și un proxy compatibil cu OpenAI? Încearcă LiteLLM. Vrei viteză găzduită + vizibilitate pe piață? Ia în considerare ShareAI sau OpenRouter.

- Lărgime dincolo de chat. Dacă ai nevoie de OCR, vorbire, traducere sau analiză de documente alături de chat LLM, un orchestrator multimodal precum Eden AI ajută.

- Rutare bazată pe date. Dacă preferați benchmark-uri live pentru a ghida costul/viteza/calitatea pe regiune sau sarcină, evaluați Unify.

Cele mai bune alternative RouteLLM (alegeri rapide)

ShareAI (alegerea noastră pentru transparența pieței + economia constructorului)

Un API pentru un catalog mare de modele/furnizori cu failover instant și o piață care evidențiază prețul, latența, timpul de funcționare, disponibilitatea înainte de a ruta. Începeți rapid în Loc de joacă, ia cheile în Consolă, navigați Documentație, și comparați opțiunile în Modele.

Eden AI (orchestrator multimodal)

API unificat pentru LLM-uri plus imagine, OCR/parsing documente, vorbire și traducere—alături de comparația modelelor, monitorizare, caching și procesare în loturi.

OpenRouter (rutare conștientă de cache)

Router găzduit pentru multe LLM-uri cu caching de prompturi și aderență la furnizor pentru reutilizarea contextelor calde; revine la alt furnizor când unul nu este disponibil.

Portkey (politici & operațiuni SRE la gateway)

Gateway AI cu fallback-uri programabile, playbook-uri de limitare a ratei și cache semantic—plus urme/metrice detaliate pentru controlul producției.

Kong AI Gateway (guvernanță la margine & audit)

Aduce pluginuri AI, politici și analize în ecosistemul Kong; o potrivire puternică atunci când aveți nevoie de controale centralizate la margine între echipe.

Unificare (router bazat pe date)

API universal cu benchmark-uri live pentru optimizarea costului/vitezei/calității pe regiune și sarcină de lucru.

Orq.ai (experimentare și LLMOps)

Experimente, evaluatori (inclusiv metrici RAG), implementări și RBAC/VPC—excelent atunci când evaluarea și guvernanța trebuie să coexiste.

LiteLLM (proxy/gateway auto-găzduit)

Proxy open-source, compatibil cu OpenAI, cu bugete/limite, jurnalizare/metrici și o interfață de administrare. Implementați cu Docker/K8s/Helm; dețineți operațiunile.

Analize aprofundate: alternativele de top RouteLLM

ShareAI (API AI alimentat de oameni)

Ce este. O rețea AI orientată către furnizori și un API unificat. Răsfoiți un catalog mare de modele/furnizori și rutați cu failover instantaneu. Piața afișează prețul, latența, disponibilitatea și timpul de funcționare într-un singur loc, astfel încât să puteți alege furnizorul potrivit înainte de fiecare rută. Începeți în Loc de joacă, creați chei în Consolă, și urmați ghidul rapid API în Documentație. Răsfoiți Piața de Modele.

- Transparența pieței — vedeți prețul/latența/timpul de funcționare/disponibilitatea din start.

- Reziliență implicită — failover rapid către următorul cel mai bun furnizor când unul are probleme.

- Economie aliniată constructorilor — majoritatea cheltuielilor merg către furnizorii de GPU care mențin modelele online.

- Început fără fricțiuni — testați în Playground, apoi livrați.

Fapte despre furnizori (câștigă menținând modelele online). Oricine poate deveni furnizor (Comunitate sau Companie). Înscrieți-vă prin Windows/Ubuntu/macOS sau Docker. Contribuiți cu explozii de timp liber sau rulați mereu activ. Alegeți stimulente: Recompense (bani), Schimb (tokenuri/AI Prosumer) sau Misiune (donați % către ONG-uri). Vedeți Ghidul Furnizorului sau deschideți Panoul de control al furnizorului.

Ideal pentru. Echipele de produs care doresc transparență în piață, reziliență și spațiu pentru a crește în modul furnizor—fără blocare de furnizor.

Eden AI

Ce este. Un API unificat care acoperă LLM-uri + generare de imagini + OCR/analiza documentelor + vorbire + traducere, astfel încât să nu fie nevoie să combinați mai multe SDK-uri de furnizor. De asemenea, subliniază comparația modelelor, monitorizarea și gruparea.

Potrivire bună când. Planul dvs. este multimodal și doriți să orchestrați OCR/vorbire/traducere alături de chat-ul LLM.

Atenționări. Dacă ai nevoie de vizualizare piață pe cerere (preț/latenta/timp de funcționare/disponibilitate) sau economia la nivel de furnizor, asociați un router de piață precum ShareAI.

OpenRouter

Ce este. Un router LLM unificat cu rutare de furnizor/model și 3. cache pentru prompturi. Cu caching activat, OpenRouter tinde să vă mențină pe același furnizor pentru a reutiliza contexte calde; dacă acel furnizor nu este disponibil, revine la altul. De asemenea, acceptă sugestii de strategie (de exemplu, ponderare pe preț).

Potrivire bună când. Doriți viteză găzduită și rutare conștientă de cache pentru a reduce costurile și a îmbunătăți debitul—mai ales în sarcinile de lucru de chat cu QPS ridicat și solicitări repetate.

Atenționări. Pentru guvernanță profundă la nivel de întreprindere (exporturi SIEM, politici la nivel de organizație), multe echipe asociază OpenRouter cu Portkey sau Kong AI Gateway.

Portkey

Ce este. Un gateway AI cu soluții de rezervă programabile, playbook-uri de limitare a ratei și cache simplu/semantic, plus urme/metrice pentru control în stil SRE. Cache-ul semantic este deosebit de util pentru solicitări/mesaje scurte atunci când pragurile de similitudine sunt bine ajustate.

Potrivire bună când. Aveți nevoie de rutare bazată pe politici cu observabilitate de primă clasă și sunteți confortabil să operați un strat de gateway în fața unuia sau mai multor routere/piețe.

Kong AI Gateway

Ce este. Un gateway de margine care aduce pluginuri AI, politici și analize în ecosistemul Kong (prin Konnect sau autogestionat). Dacă platforma dvs. API se concentrează deja pe Kong și aveți nevoie de politici/audit centralizat, aceasta este o opțiune puternică.

Potrivire bună când. Guvernanța la margine, auditabilitatea, rezidența datelor și controalele centralizate sunt indispensabile în mediul dvs.

Unifică

Ce este. Un router bazat pe date care optimizează costul/viteza/calitatea folosind benchmark-uri live, ajustându-se în funcție de regiune și sarcină de lucru.

Potrivire bună când. Doriți o selecție ghidată de benchmark-uri care se adaptează continuu la performanța din lumea reală.

Orq.ai

Ce este. O platformă de colaborare AI generativă + LLMOps: experimente, evaluatori (inclusiv metrici RAG), implementări și RBAC/VPC. Excelent atunci când evaluarea și guvernanța trebuie să coexiste.

Potrivire bună când. Ai nevoie de experimentare + evaluare cu guvernanță într-un singur loc—apoi implementează direct de pe aceeași suprafață.

LiteLLM

Ce este. Un proxy/gateway open-source cu endpoint-uri compatibile OpenAI, bugete & limite de rată, logare/metrici și o interfață de administrare. Implementare prin Docker/K8s/Helm; păstrează traficul în propria rețea.

Potrivire bună când. Vrei găzduire proprie și control complet asupra infrastructurii cu compatibilitate simplă pentru SDK-uri populare în stil OpenAI.

Atenționări. Ca în cazul oricărui gateway OSS, deții operațiunile și actualizările.

Start rapid: apelați un model în câteva minute (ShareAI)

Începeți în Loc de joacă, apoi obține o cheie API și livrează. Referințe: API-ul rapid • Docs Acasă • Lansări.

#!/usr/bin/env bash"

// ShareAI — Completări Chat (JavaScript, Node 18+);

Sfat pentru migrare. Mapează modelele selectate RouteLLM curente la echivalentele ShareAI, oglindește formele cererii/răspunsului și începe în spatele unui flag de funcționalitate. Trimite mai întâi 5–10% din trafic, compară latența/costul/calitatea, apoi crește treptat. Dacă rulezi și un gateway (Portkey/Kong), asigură-te că cache-ul/fallback-urile nu se declanșează dublu între straturi.

Comparație dintr-o privire

| Platformă | Găzduit / Auto-găzduit | Rutare & Fallback-uri | Observabilitate | Diversitate (LLM + dincolo) | Guvernanță / Politică | Note |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Router învățat; client/server compatibil OpenAI | CLI/loguri; focus pe cercetare | Centrat pe LLM | Politică prin infrastructura ta | Excelent pentru economii de cost la nivel de cercetare; adu propriile controale edge. |

| ShareAI | Găzduit + rețea de furnizori | Failover instant; selecție ghidată de piață | Jurnale de utilizare; statistici marketplace | Catalog larg de modele | Controale la nivel de furnizor | Piață alimentată de oameni; începe cu Loc de joacă și Modele. |

| Eden AI | Găzduit | Schimbă furnizorii; lot; caching | Monitorizare costuri și API | LLM + imagine + OCR + vorbire + traducere | Facturare centrală/gestionare chei | Orchestrator multimodal. |

| OpenRouter | Găzduit | Rutare furnizor/model; cache pentru solicitări; persistența furnizorului | Informații la nivel de cerere | Centrat pe LLM | Politici ale furnizorilor | Reutilizare cache; revenire în caz de indisponibilitate. |

| Portkey | Gateway găzduit | Politici de revenire; playbook-uri de limitare a ratei; cache semantic | Urmăriri/metrici | LLM-prim | Configurații gateway | Ghidaje în stil SRE. |

| Kong AI Gateway | Auto-găzduit/Enterprise | Rutare upstream prin pluginuri AI | Metrici/audit prin Kong | LLM-prim | Guvernanță puternică la margine | Componentă infrastructură; se asociază cu routere/piețe. |

| Unifică | Găzduit | Rutare bazată pe date în funcție de cost/viteză/calitate | Explorator de benchmark | Centrat pe LLM | Politici de rutare | Selecție ghidată de benchmark-uri. |

| Orq.ai | Găzduit | Retrageri/rezerve în orchestrare | Analitică de platformă; evaluatori RAG | LLM + RAG + evaluări | Opțiuni RBAC/VPC | Accent pe colaborare și experimentare. |

| LiteLLM | Auto-găzduire/OSS | Reîncercare/revenire; bugete/limite | Jurnalizare/metrici; Interfață Admin | Centrat pe LLM | Control complet al infrastructurii | Compatibil cu OpenAI; Implementare Docker/K8s/Helm. |

Întrebări frecvente: RouteLLM vs. restul

RouteLLM vs ShareAI — care este mai bun?

Alege ShareAI dacă dorești o piață transparentă care să evidențieze preț/latenta/timp de funcționare/disponibilitate înainte de fiecare rută, plus failover instantaneu și economie aliniată constructorului. Alege RouteLLM dacă preferi un router bazat pe cercetare, învățat și ești confortabil să operezi infrastructura în jurul acestuia (gateway-uri, logare, audit). Începe cu Loc de joacă și Piața de Modele.

RouteLLM vs Eden AI — care este diferența?

Eden AI acoperă LLM-uri și multimodal (viziune/OCR, vorbire, traducere) cu comparație și monitorizare. RouteLLM se concentrează pe rutare învățată pentru LLM-uri. Dacă planul tău necesită OCR/vorbire/traducere sub un singur API, Eden AI simplifică livrarea; dacă cercetarea rutării este prioritară, RouteLLM se potrivește. Combină cu ShareAI când dorești transparență pe piață per cerere.

RouteLLM vs OpenRouter — când să alegi fiecare?

Alege OpenRouter când 3. cache pentru prompturi și reutilizarea cache-ului cald contează (tinde să te mențină pe același furnizor și revine în caz de întreruperi). Alege RouteLLM pentru politici învățate pe care le operezi singur. Multe stack-uri combină OpenRouter cu un gateway pentru politică/observabilitate—și încă folosesc ShareAI când doresc transparență pe piață înainte de fiecare rută.

RouteLLM vs Portkey — router sau gateway?

RouteLLM este un router. Portkey este un poartă: excelează la politică/limite (manuale de fallback, cache semantic) și urme/metrice detaliate. Multe echipe folosesc ambele: un gateway pentru politică la nivel de organizație + un router/piață pentru alegerea modelului și controlul costurilor. ShareAI se potrivește bine aici când dorești vizibilitate pe piață înainte de rută.

RouteLLM vs Kong AI Gateway — cine are nevoie de care?

Alege Kong AI Gateway când guvernanța la margine (politică/audit centralizat, rezidența datelor) este nenegociabil. Păstrează RouteLLM în spatele acestuia dacă încă dorești rutare învățată pentru preț/perf. Folosește ShareAI alături de când vrei să alegi furnizorii după preț/latenta/timp de funcționare/disponibilitate înainte de fiecare rută.

RouteLLM vs Unify — ce este unic la Unify?

Unifică folosește benchmark-uri live și politici dinamice pentru a optimiza pentru cost/viteză/calitate. Dacă vrei o selecție bazată pe date care evoluează în funcție de regiune/sarcină de lucru, Unify este convingător; RouteLLM se concentrează pe modele de rutare învățate pe care le găzduiești. Folosește ShareAI când preferi să alegi furnizorii cu o vedere de piață și failover instantaneu.

RouteLLM vs Orq.ai — care pentru evaluare și RAG?

Orq.ai oferă o suprafață de experimentare/evaluare (inclusiv evaluatori RAG), plus implementări și RBAC/VPC. Dacă ai nevoie de LLMOps + evaluatori, Orq.ai poate completa sau înlocui un router pur la început. Adu ShareAI când vrei alegerea furnizorilor cu transparență de piață și reziliență în producție.

RouteLLM vs LiteLLM — găzduit vs auto-găzduit?

RouteLLM este logica de rutare OSS; LiteLLM este un proxy/gateway compatibil cu OpenAI cu bugete, limite de rată și o interfață de administrare—excelent dacă vrei să păstrezi traficul în interiorul VPC-ului tău și să deții planul de control. Echipele combină adesea LiteLLM pentru auto-găzduire cu ShareAI pentru vizibilitatea pieței și failover instantaneu între furnizori.

Care este cel mai ieftin pentru sarcina mea de lucru: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Depinde de alegerea modelului, regiune, cacheabilitate și tiparele de trafic. Routere precum ShareAI/OpenRouter pot reduce costurile prin rutare și persistență conștientă de cache; gateway-uri precum Portkey adaugă caching semantic; LiteLLM reduce supraîncărcarea platformei dacă ești confortabil să o operezi. Testează cu infrastructura solicitări și urmăresc costul efectiv per rezultat—nu doar prețul de listă.

Ce este RouteLLM?

Un framework open-source pentru servirea și evaluarea routerelor LLM; include routere antrenate și căi compatibile cu OpenAI; adesea menționat pentru reducerea semnificativă a costurilor, menținând în același timp o calitate apropiată de GPT-4 pe sarcini similare cu MT-Bench.

Care este cea mai rapidă modalitate de a încerca ShareAI fără o integrare completă?

Deschideți Loc de joacă, alege un model/furnizor și rulează solicitări în browser. Când ești gata, creează o cheie și inserează fragmentele cURL/JS de mai sus în aplicația ta.

Pot deveni un furnizor ShareAI și câștiga?

Da. Oricine se poate înscrie ca Comunitate sau Companie furnizor folosind Windows/Ubuntu/macOS sau Docker. Contribuie cu explozii de timp inactiv sau rulați mereu activ. Alege stimulente: Recompense (bani), Schimb (tokenuri/AI Prosumer), sau Misiune (donați % către ONG-uri). Vedeți Ghidul Furnizorului sau deschideți Panoul de control al furnizorului.

Concluzie

În timp ce RouteLLM este un router OSS puternic, cea mai bună alegere depinde de priorități:

- Transparența pieței + reziliență: ShareAI

- Acoperire multimodală sub un singur API: Eden AI

- Rutare conștientă de cache în formă găzduită: OpenRouter

- Politici/reguli de protecție la margine: Portkey sau Kong AI Gateway

- Rutare bazată pe date: Unifică

- LLMOps + evaluatori: Orq.ai

- Plan de control auto-găzduit: LiteLLM

Dacă preț/latenta/timp de funcționare/disponibilitate înainte de fiecare rută, failover instantaneu, și economie aliniată constructorului sunt pe lista dvs. de verificare, deschideți Loc de joacă, creați o cheie API, și navigați prin Piața de Modele pentru a direcționa următoarea cerere într-un mod inteligent.