Bine ați venit GPT-OSS de la OpenAI pe ShareAI

ShareAI este dedicat să vă aducă cele mai recente și mai puternice modele AI—și o facem din nou astăzi.

Acum câteva ore, OpenAI a lansat revoluționarul său GPT-OSS modele, și deja puteți începe să le utilizați în rețeaua ShareAI!

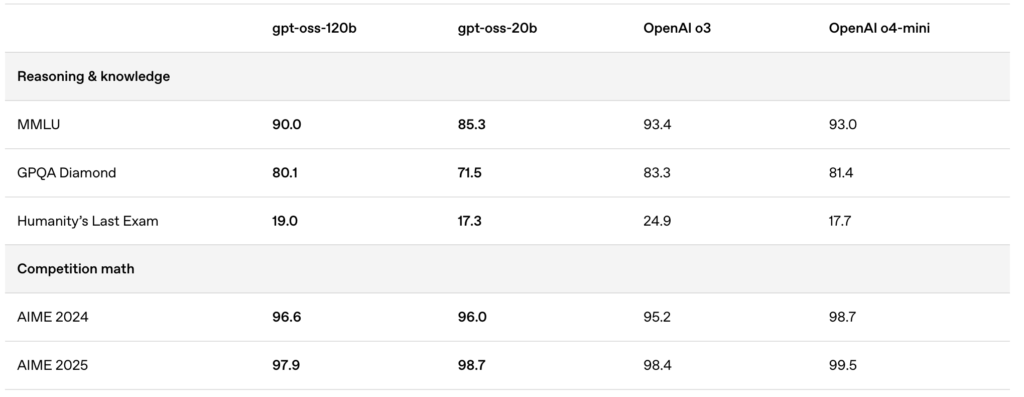

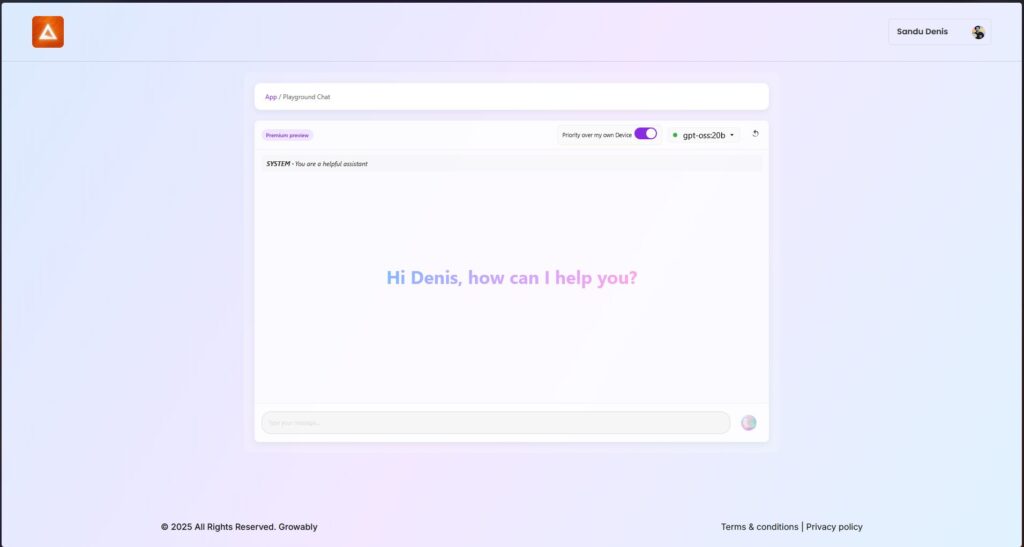

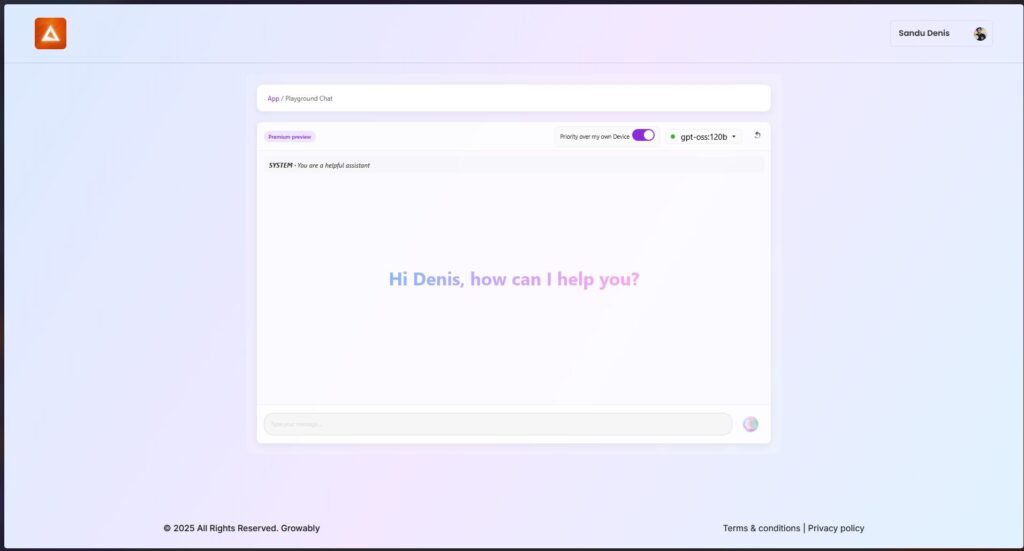

Modelele lansate recent—gpt-oss:20b și gpt-oss:120b—oferă experiențe locale de chat excepționale, capacități puternice de raționament și suport îmbunătățit pentru scenarii avansate de dezvoltare.

🚀 Începeți cu GPT-OSS pe ShareAI

Puteți încerca aceste modele chiar acum folosind cea mai recentă versiune a clientului ShareAI pentru Windows.

- Descărcați ShareAI pentru Windows (link către pagina de descărcare)

După instalare, puteți descărca și rula cu ușurință modelele GPT-OSS direct din aplicația ShareAI—fără configurații sau setări complicate necesare.

✨ Repere ale funcțiilor GPT-OSS

Iată de ce GPT-OSS este revoluționar pentru fluxurile de lucru bazate pe AI:

- Capacități agentice:

Profitați de funcțiile integrate pentru apelarea funcțiilor, navigarea pe web, apelurile de instrumente Python și ieșirile de date structurate. - Transparență completă a lanțului de gândire:

Obțineți vizibilitate clară asupra procesului de raționament al modelului, facilitând depanarea și sporind încrederea în rezultatele generate. - Niveluri de raționament configurabile:

Ajustați cu ușurință efortul de raționament (scăzut, mediu, ridicat) în funcție de nevoile dvs. de latență și complexitate. - Arhitectură ajustabilă:

Personalizați extensiv modelele cu ajustarea parametrilor pentru cazuri de utilizare specifice. - Licență permisivă Apache 2.0:

Inovați liber fără licențe copyleft restrictive sau riscuri de brevet—perfect pentru implementări comerciale și experimentare rapidă.

🔥 Optimizat cu cuantificare MXFP4

OpenAI a introdus cuantificarea MXFP4, reducând semnificativ amprenta de memorie a modelelor GPT-OSS:

- Formatul MXFP4 Explicat:

Modelele GPT-OSS utilizează o tehnică de cuantizare în care greutățile Mixture-of-Experts (MoE) sunt cuantizate la doar 4,25 biți per parametru. Aceste greutăți MoE reprezintă peste 90% din totalul parametrilor modelului, făcând cuantizarea extrem de eficientă. - Compatibilitate Îmbunătățită:

Această cuantizare optimizată permite:- Modelului gpt-oss:20b să ruleze fără probleme pe mașini cu doar 16GB memorie.

- Modelului gpt-oss:120b Modelului să se încadreze confortabil pe un singur GPU de 80GB.

ShareAI suportă acest format MXFP4 nativ—fără pași suplimentari, conversii sau complicații necesare. Ultima noastră actualizare a motorului vine cu nuclee dezvoltate special pentru formatul MXFP4, asigurând performanță maximă.

📌 Modele GPT-OSS Disponibile Acum:

GPT-OSS:20B

- Ideal pentru sarcini specializate, cu latență redusă sau implementări locale.

- Oferă performanță robustă chiar și pe configurații hardware modeste.

GPT-OSS:120B

- Oferă raționament puternic, capabilități agentice avansate și versatilitate potrivită pentru sarcini solicitante la scară largă.

- Perfect pentru dezvoltatori și întreprinderi care necesită raționament mai profund, acuratețe mai mare și aplicații AI mai extinse.

🛠️ Încearcă GPT-OSS astăzi

Pregătit să experimentezi capabilitățile AI de generație următoare?

- Descarcă Clientul Windows ShareAI (link către pagina de descărcare)

- Vizualizează Documentația (link către documentația utilizatorului sau tutoriale)

Rămâi conectat—ShareAI continuă să extindă biblioteca noastră de modele, oferind putere proiectelor tale AI la fiecare pas.

Prompting fericit! 🚀