Альтернативы Requesty 2026: ShareAI против Eden AI, OpenRouter, Portkey, Kong AI, Unify, Orq и LiteLLM

Обновлено Февраль 2026

Разработчики выбирают Запросы для единого шлюза, совместимого с OpenAI, между многими поставщиками LLM, а также маршрутизации, аналитики и управления. Но если вам важнее прозрачность рынка перед каждым маршрутом (цена, задержка, время безотказной работы, доступность), строгая политика на границе, или прокси-сервер с самостоятельным размещением, один из этих альтернатив Requesty может лучше подойти для вашего стека.

Этот гид для покупателей написан так, как это сделал бы разработчик: конкретные компромиссы, четкие быстрые рекомендации, глубокие погружения, сравнения бок о бок и копирование-вставка ShareAI быстрого старта, чтобы вы могли начать уже сегодня.

Понимание Requesty (и где он может не подойти)

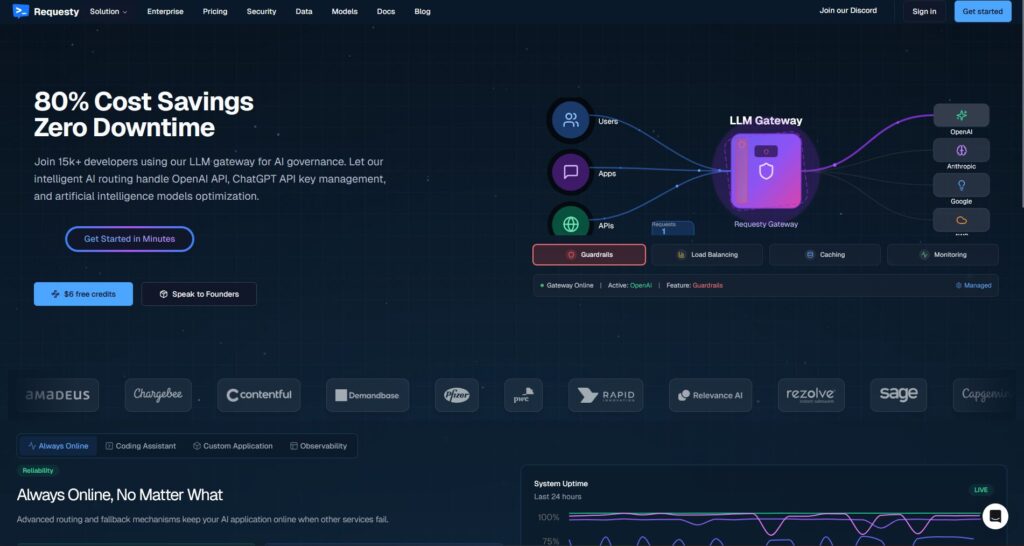

Что такое Requesty. Requesty — это LLM шлюз. Вы направляете свой клиент, совместимый с OpenAI, на конечную точку Requesty и маршрутизируете запросы через нескольких провайдеров/моделей — часто с резервированием, аналитикой и политиками безопасности. Это разработано как единое место для управления использованием, мониторинга затрат и обеспечения соблюдения правил в ваших AI-запросах.

Почему команды выбирают его.

- Один API, множество провайдеров. Сократите разрастание SDK и централизуйте наблюдаемость.

- Резервирование и маршрутизация. Поддерживайте стабильное время работы, даже если провайдер дает сбой.

- Корпоративное управление. Центральная политика, контроль на уровне организации, бюджеты использования.

Где Requesty может не подойти.

- Вы хотите прозрачность рынка перед каждым маршрутом (см. цену, задержку, время работы, доступность по каждому провайдеру прямо сейчас, затем выберите).

- Вам нужно политика уровня edge в вашем собственном стеке (например, Kong, Portkey) или самостоятельный хостинг (LiteLLM).

- Ваш дорожная карта требует широких мультимодальных функций под одной крышей (OCR, речь, перевод, анализ документов) за пределами чата LLM — где оркестратор, такой как ShareAI, может подойти лучше.

Как выбрать альтернативу Requesty

1) Общая стоимость владения (TCO). Не останавливайтесь на $/1K токенах. Включите показатели попадания в кэш, повторные попытки/резервные варианты, очереди, затраты на оценку, накладные расходы на запрос, и операционную нагрузку наблюдаемости/оповещений. “Самая низкая цена” часто проигрывает маршрутизатору/шлюзу, который снижает потери.

2) Задержка и надежность. Отдавайте предпочтение маршрутизации с учетом региона, повторное использование теплого кеша (придерживайтесь одного и того же провайдера, когда активен кеш запросов), и точные резервные механизмы (повторная попытка при 429; эскалация при таймаутах; ограничение фан-аута, чтобы избежать дублирующих затрат).

3) Наблюдаемость и управление. Если защитные ограждения, журналы аудита, редактирование и политика на границе важны, шлюз, такой как Portkey или Kong AI Gateway часто сильнее, чем чистый агрегатор. Многие команды сочетают маршрутизатор + шлюз для достижения наилучшего результата.

4) Самостоятельный хостинг против управляемого. Предпочитаете Docker/K8s/Helm и совместимые с OpenAI конечные точки? Смотрите LiteLLM (OSS) или Kong AI Gateway (инфраструктура предприятия). Хотите хостинговую скорость + видимость на рынке? Смотрите ShareAI (наш выбор), OpenRouter, или Унифицировать.

5) Широта за пределами чата. Если ваш план включает OCR, преобразование речи в текст, перевод, генерацию изображений и разбор документов под одним оркестратором, ShareAI это может упростить доставку и тестирование.

6) Защита на будущее. Выбирайте инструменты, которые делают замену моделей/поставщиков безболезненной (универсальные API, динамическая маршрутизация, явные псевдонимы моделей), чтобы вы могли использовать новые/дешевые/быстрые варианты без переписывания.

Лучшие альтернативы Requesty (быстрый выбор)

ShareAI (наш выбор за прозрачность рынка + экономику для разработчиков)

Один API через 150+ моделей с мгновенным переключением при сбое и маркетплейс который отображает цену, задержку, время безотказной работы, доступность перед маршрутизацией. Поставщики (сообщество или компания) сохраняют большая часть дохода, согласование стимулов с надежностью. Начните быстро в Песочница, возьмите ключи в Консоли, и прочитайте Документация.

Eden AI (мультимодальный оркестратор)

Унифицированный API для LLM плюс изображение, OCR/разбор документов, речь и перевод — наряду с Сравнение моделей, мониторинг, кэширование и пакетная обработка.

OpenRouter (маршрутизация с учетом кэша)

Хостинг маршрутизатора для многих LLM с кэширование запросов и привязка к провайдеру для повторного использования теплых контекстов; возвращается, если провайдер становится недоступным.

Portkey (политика и SRE операции на шлюзе)

AI-шлюз с программируемыми резервными механизмами, ограничение скорости плейбуков, и простой/семантический кэш, плюс подробные трассировки/метрики для управления производством.

Kong AI Gateway (управление и аудит на границе)

Принесите AI плагины, политики, аналитика в экосистему Kong; хорошо сочетается с маршрутизатором на маркетплейсе, когда вам нужны централизованные средства управления для команд.

Унифицировать (маршрутизатор, основанный на данных)

Универсальный API с живыми эталонными тестами для оптимизации стоимости/скорости/качества по регионам и нагрузке.

Orq.ai (эксперименты и LLMOps)

Эксперименты, оценщики (включая RAG метрики), развертывания, RBAC/VPC—отлично, когда оценка и управление должны сосуществовать.

LiteLLM (самостоятельно размещаемый прокси/шлюз)

Прокси с открытым исходным кодом, совместимый с OpenAI бюджеты/лимиты, журналирование/метрики и интерфейс администратора. Развертывание с Docker/K8s/Helm; вы управляете операциями.

Подробный обзор: лучшие альтернативы

ShareAI (API искусственного интеллекта, управляемый людьми)

Что это. Сеть искусственного интеллекта, ориентированная на провайдеров, и унифицированный API. Просматривайте большой каталог моделей/провайдеров и маршрутизируйте с мгновенное переключение. Торговая площадка отображает цену, задержку, время безотказной работы и доступность в одном месте, чтобы вы могли выбрать подходящего провайдера перед каждым маршрутом. Начните в Песочница, создайте ключи в Консоли, и следуйте быстрому старту API.

Почему команды выбирают его.

- Прозрачность на рынке — смотрите провайдера ценой/задержкой/временем работы/доступностью заранее.

- Устойчивость по умолчанию — быстро резервированием к следующему лучшему провайдеру, когда один дает сбой.

- Экономика, ориентированная на разработчиков — большая часть расходов идет провайдерам GPU, которые поддерживают модели онлайн.

- Беспрепятственный старт — Просмотреть модели, тестируйте в Песочница, и отправка.

Факты о провайдерах (зарабатывают, поддерживая модели онлайн). Любой может стать провайдером (сообщество или компания). Подключение через Windows/Ubuntu/macOS/Docker. Внести вклад bursts времени простоя или запуск всегда включен. Выберите стимулы: Награды (деньги), Обмен (токены/AI Prosumer), или Миссия (пожертвовать % НПО). По мере масштабирования, установить свои собственные цены на вывод и получать привилегированное размещение. Подробности: Руководство для провайдера.

Идеально для. Команды разработчиков, которые хотят прозрачностью рынка, устойчивость, и пространство для роста в режим провайдера — без привязки к поставщику.

Eden AI

Что это. Унифицированный API, который охватывает LLMs + генерацию изображений + OCR/разбор документов + речь + перевод, устраняя необходимость объединять несколько SDK поставщиков. Сравнение моделей помогает тестировать провайдеров бок о бок. Он также подчеркивает Мониторинг стоимости/API, Пакетная обработка, и Кэширование.

Хорошо подходит, когда. Ваш план развития мультимодальный и вы хотите организовать OCR/речь/перевод вместе с LLM-чатом с одной поверхности.

Предупреждения. Если вам нужен просмотр торговой площадки по запросу (цена/задержка/время безотказной работы/доступность) или экономика на уровне провайдера, рассмотрите маршрутизатор в стиле торговой площадки, такой как ShareAI наряду с мультимодальными функциями Eden.

OpenRouter

Что это. Унифицированный маршрутизатор LLM с маршрутизацией провайдера/модели и кэширование запросов. Когда кэширование включено, OpenRouter пытается оставить вас на том же провайдере для повторного использования теплых контекстов; если этот провайдер недоступен, он переключается на следующий лучший.

Хорошо подходит, когда. Вы хотите размещенная скорость и маршрутизация с учетом кэша для снижения затрат и повышения пропускной способности — особенно в чатах с высокой QPS и повторяющимися запросами.

Предупреждения. Для глубокого корпоративного управления (например, экспорт SIEM, политика на уровне организации), многие команды объедините OpenRouter с Portkey или Kong AI Gateway.

Portkey

Что это. Искусственный интеллект платформа операций + шлюз с программируемыми резервные варианты, ограничение скорости плейбуков, и простой/семантический кэш, плюс трассировки/метрики для управления в стиле SRE.

- Вложенные резервные варианты и условная маршрутизация — выражайте деревья повторных попыток (например, повтор 429; переключение на 5xx; переход при всплесках задержки).

- Семантический кэш — часто выигрывает на коротких подсказках/сообщениях (действуют ограничения).

- Виртуальные ключи/бюджеты — сохраняйте использование команды/проекта в рамках политики.

Хорошо подходит, когда. Вам нужно маршрутизация, основанная на политике с первоклассной наблюдаемостью, и вам комфортно управлять шлюз слой перед одним или несколькими маршрутизаторами/маркетплейсами.

Kong AI Gateway

Что это. Открытый пограничный шлюз который приносит AI плагины, управление и аналитику в экосистему Kong (через Konnect или самостоятельное управление). Это инфраструктура — отличный выбор, если ваша платформа API уже построена вокруг Kong, и вам нужно централизованная политика/аудит.

Хорошо подходит, когда. Пограничное управление, возможность аудита, локализация данных, и централизованные элементы управления являются обязательными в вашей среде.

Предупреждения. Ожидайте настройки и обслуживания. Многие команды сочетают Kong с маршрутизатором маркетплейса (например, ShareAI/OpenRouter) для выбора провайдера и контроля затрат.

Унифицировать

Что это. A маршрутизатор, основанный на данных которая оптимизирует стоимость/скорость/качество использование живыми эталонными тестами. Он предоставляет универсальный API и обновляет выбор моделей по регионам/нагрузке.

Хорошо подходит, когда. Вы хотите выбор, основанный на тестировании который постоянно адаптируется к реальной производительности.

Orq.ai

Что это. Генеративный ИИ сотрудничество + LLMOps платформа: эксперименты, оценщики (включая RAG метрики, такие как релевантность контекста/точность/устойчивость), развертывания и РБАК/VPC.

Хорошо подходит, когда. Вам нужно эксперименты + оценка с управлением в одном месте — затем развертывание непосредственно с той же поверхности.

LiteLLM

Что это. Открытый прокси/шлюз с открытым исходным кодом с Совместимый с OpenAI конечные точки, бюджеты и ограничения скорости, журналирование/метрики и интерфейс администратора. Развертывание через Docker/K8s/Helm; сохраняйте трафик в своей сети.

Хорошо подходит, когда. Вы хотите самостоятельный хостинг и полный контроль инфраструктуры с простой совместимостью для популярных SDK в стиле OpenAI.

Предупреждения. Как и в любом шлюзе с открытым исходным кодом, вы управляете операциями и обновлениями. Убедитесь, что вы выделили время на мониторинг, масштабирование и обновления безопасности.

Быстрый старт: вызов модели за минуты (ShareAI)

Начните в Песочница, затем получите ключ API и отправьте. Ссылка: быстрому старту API • Главная страница документации • Релизы.

#!/usr/bin/env bash"

// ShareAI — Завершения чатов (JavaScript, Node 18+);

Совет по миграции: Сопоставьте ваши текущие модели Requesty с эквивалентами ShareAI, отразите формы запросов/ответов и начните за флагом функции. Отправьте 5–10% трафика сначала, сравните задержку/стоимость/качество, затем увеличьте. Если вы также используете шлюз (Portkey/Kong), убедитесь, что кэширование/резервирование не вызывают двойное срабатывание между слоями.

Сравнение с первого взгляда

| Платформа | Хостинг / Самостоятельный хостинг | Маршрутизация и резервные варианты | Наблюдаемость | Широта (LLM + за его пределами) | Управление/Политика | Заметки |

|---|---|---|---|---|---|---|

| Запросы | Хостинг | Маршрутизатор с резервированием; совместим с OpenAI | Встроенный мониторинг/аналитика | Ориентирован на LLM (чат/завершения) | Управление на уровне организации | Замените базовый URL OpenAI на Requesty; акцент на корпоративные нужды. |

| ShareAI | Хостинг + сеть провайдеров | Мгновенное переключение; маршрутизации, управляемой рынком | Журналы использования; статистика торговой площадки; | Широкий каталог моделей | Управление на уровне провайдера; | Торговая площадка, управляемая людьми; начните с Песочница. |

| Eden AI | Хостинг | Переключение провайдеров; пакетная обработка; кэширование; | Мониторинг стоимости и API; | LLM + изображение + OCR + речь + перевод; | Центральное выставление счетов/управление ключами | Сравнение моделей для тестирования провайдеров бок о бок;. |

| OpenRouter | Хостинг | Маршрутизация провайдеров/моделей; кэширование запросов | Информация на уровне запросов; | Ориентированность на LLM | Политики провайдеров; | Повторное использование кэша, где поддерживается; резервное решение при недоступности;. |

| Portkey | Хостинг и шлюз | Резервные политики; инструкции по ограничению скорости; семантический кэш; | Трассировки/метрики | LLM-первый | Конфигурации шлюза; | Отлично подходит для защитных механизмов в стиле SRE и политики организации. |

| Kong AI Gateway | Самостоятельный хостинг/Корпоративное решение | Маршрутизация вверх по потоку через AI плагины | Метрики/аудит через Kong | LLM-первый | Сильное управление на границе | Компонент инфраструктуры; сочетается с маршрутизатором/рынком. |

| Унифицировать | Хостинг | Маршрутизация, основанная на данных по стоимости/скорости/качеству | Исследователь эталонов | Ориентированность на LLM | Предпочтения маршрутизатора | Выбор модели, основанный на сравнительном анализе. |

| Orq.ai | Хостинг | Повторные попытки/резервные варианты в оркестрации | Аналитика платформы; Оценщики RAG | LLM + RAG + оценки | Опции RBAC/VPC | Фокус на сотрудничество и эксперименты. |

| LiteLLM | Самостоятельный хостинг/OSS | Повтор/резерв; бюджеты/лимиты | Логирование/метрики; Административный интерфейс | Ориентированность на LLM | Полный контроль инфраструктуры | Совместимость с OpenAI; Развертывание Docker/K8s/Helm. |

Часто задаваемые вопросы

Что такое Requesty?

LLM шлюз предлагающий маршрутизацию с несколькими провайдерами через единый совместимый с OpenAI API с мониторингом, управлением и контролем затрат.

Какие лучшие альтернативы Requesty?

Лучшие варианты включают ShareAI (прозрачность рынка + мгновенное переключение), Eden AI (мультимодальный API + сравнение моделей), OpenRouter (маршрутизация с учетом кэша), Portkey (шлюз с политикой и семантическим кэшем), Kong AI Gateway (управление на уровне сети), Унифицировать (маршрутизатор, основанный на данных), Orq.ai (LLMOps/оценщики), и LiteLLM (самостоятельно размещаемый прокси).

Requesty против ShareAI — что лучше?

Выберите ShareAI если вы хотите прозрачный рынок который отображает цену/задержку/время безотказной работы/доступность перед маршрутизацией, плюс мгновенное переключение при сбое и экономику, ориентированную на разработчиков. Выберите Запросы если вы предпочитаете единый размещенный шлюз с корпоративным управлением и вам удобно выбирать провайдеров без обзора на рынке. Попробуйте ShareAI Маркетплейсе моделей и Песочница.

Requesty против Eden AI — в чем разница?

Eden AI охватывает LLMs + мультимодальный (визуальный/OCR, речь, перевод) и включает Сравнение моделей; Запросы является более Ориентированность на LLM с маршрутизацией/управлением. Если вашему плану требуется OCR/речь/перевод под одним API, Eden AI упрощает доставку; для маршрутизации в стиле шлюза подходит Requesty.

Requesty против OpenRouter — когда выбрать каждый?

Выберите OpenRouter когда кэширование запросов и повторное использование теплого кэша имеет значение (это склонно удерживать вас на одном провайдере и возвращаться к сбоям). Выберите Запросы для корпоративного управления с одним маршрутизатором, если привязка кэш-осведомленного провайдера не является вашим главным приоритетом.

Requesty vs Portkey vs Kong AI Gateway — маршрутизатор или шлюз?

Запросы является маршрутизатором. Portkey и Kong AI Gateway являются шлюзами: они превосходны в политике/ограничениях (резервные копии, ограничения скорости, аналитика, управление на краю). Многие стеки используют как: шлюз для политики на уровне организации + маршрутизатор/рынок для выбора модели и контроля затрат.

Requesty vs Unify — что уникального в Unify?

Унифицировать использует живыми эталонными тестами и динамические политики для оптимизации затрат/скорости/качества. Если вы хотите маршрутизацию, основанную на данных который развивается в зависимости от региона/нагрузки, Unify привлекателен; Requesty сосредоточен на маршрутизации и управлении в стиле шлюза.

Requesty против Orq.ai — что выбрать для оценки и RAG?

Orq.ai предоставляет эксперименты/оценку поверхность (включая оценщики RAG), плюс развертывания и RBAC/VPC. Если вам нужно LLMOps + оценщики, Orq.ai может дополнить или заменить маршрутизатор на ранних этапах.

Requesty против LiteLLM — размещенный или самоуправляемый?

Запросы размещен. LiteLLM является самоуправляемый прокси/шлюз с бюджеты и ограничения скорости и интерфейс администратора; отлично, если вы хотите сохранить трафик внутри вашего VPC и владеть плоскостью управления.

Что дешевле для моей нагрузки: Requesty, ShareAI, OpenRouter, LiteLLM?

Это зависит от выбора модели, региона, кэшируемости и шаблонов трафика. Маршрутизаторы, такие как ShareAI/OpenRouter могут снизить затраты через маршрутизацию и учет кэширования; шлюзы, такие как Portkey добавляют семантическое кэширование; LiteLLM уменьшают накладные расходы платформы, если вы готовы их использовать. Тестируйте с вашими запросами и отслеживайте эффективную стоимость за результат—а не только цену в списке.

Как мне перейти с Requesty на ShareAI с минимальными изменениями кода?

Сопоставьте ваши модели с эквивалентами ShareAI, отразите формы запросов/ответов и начните за флагом функции. Сначала направьте небольшой %, сравните задержку/стоимость/качество, затем увеличьте. Если вы также используете шлюз, убедитесь, что кэширование/резервирование не происходит двойного срабатывания между уровнями.

Эта статья также охватывает “альтернативы Requestly”? (Requesty vs Requestly)

Да—Requestly (с L) является набором инструментов для разработчиков/QA (перехват HTTP, имитация/тестирование API, правила, заголовки), а не маршрутизатором LLM. Если вы искали альтернативы Requestly, вы, вероятно, сравниваете Postman, Fiddler, mitmproxy, и т.д. Если вы имели в виду Запросы (шлюз LLM), используйте альтернативы в этом руководстве. Если вы хотите пообщаться вживую, назначьте встречу: meet.growably.ro/team/shareai.

Какой самый быстрый способ попробовать ShareAI без полной интеграции?

Могу ли я стать поставщиком ShareAI и зарабатывать?

Да. Любой может зарегистрироваться как Сообщество или Компания поставщик, используя Windows/Ubuntu/macOS или Docker. Внести вклад bursts времени простоя или запуск всегда включен. Выберите Награды (деньги), Обмен (токены/AI Prosumer), или Миссия (пожертвуйте % НПО). Смотрите Руководство для провайдера.

Существует ли единая “лучшая” альтернатива Requesty?

Нет единого победителя для каждой команды. Если вы цените прозрачность рынка + мгновенное переключение + экономику разработчиков, начните с ShareAI. Для мультимодальный рабочие нагрузки (OCR/речь/перевод), посмотрите на Eden AI. Если вам нужно управление на периферии, оцените Portkey или Kong AI Gateway. Предпочитайте самостоятельный хостинг? Рассмотрите LiteLLM.

Заключение

Пока Запросы является сильным шлюзом LLM, ваш лучший выбор зависит от приоритетов:

- Прозрачность рынка + устойчивость: ShareAI

- Мультимодальное покрытие через один API: Eden AI

- Маршрутизация с учетом кэша в размещенной форме: OpenRouter

- Политика/ограничения на периферии: Portkey или Kong AI Gateway

- Маршрутизация, основанная на данных: Унифицировать

- LLMOps + оценщики: Orq.ai

- Самостоятельно размещаемая плоскость управления: LiteLLM

Если выбираете провайдеров по цена/задержка/время работы/доступность перед каждым маршрутом, мгновенное переключение, и экономика, согласованная с разработчиком находятся в вашем контрольном списке, откройте Песочница, создайте ключ API, и просмотрите Маркетплейсе моделей чтобы направить ваш следующий запрос умным способом.