RouteLLM Альтернативы 2026: Когда выбрать ShareAI (и что еще учитывать)

Обновлено Февраль 2026

Разработчики выбирают RouteLLM для маршрутизации запросов к более дешевым моделям с целью достижения качества, близкого к GPT-4 — особенно для задач, похожих на бенчмарки, где обученный маршрутизатор может уверенно переключаться на более простые модели. Но если вам важнее прозрачность рынка перед каждым маршрутом (текущая цена, задержка, время безотказной работы, доступность), мгновенное переключение между несколькими провайдерами, политика на границе и аудит, или самоуправляемый прокси/шлюз, один из этих альтернативы RouteLLM может лучше подойти для вашего стека.

Этот гид для покупателей написан так, как его написал бы разработчик: конкретные компромиссы, быстрые рекомендации, глубокие погружения, сравнительные обзоры и готовый к копированию и вставке ShareAI quickstart, чтобы вы могли начать работу уже сегодня.

Понимание RouteLLM (и где он может не подойти)

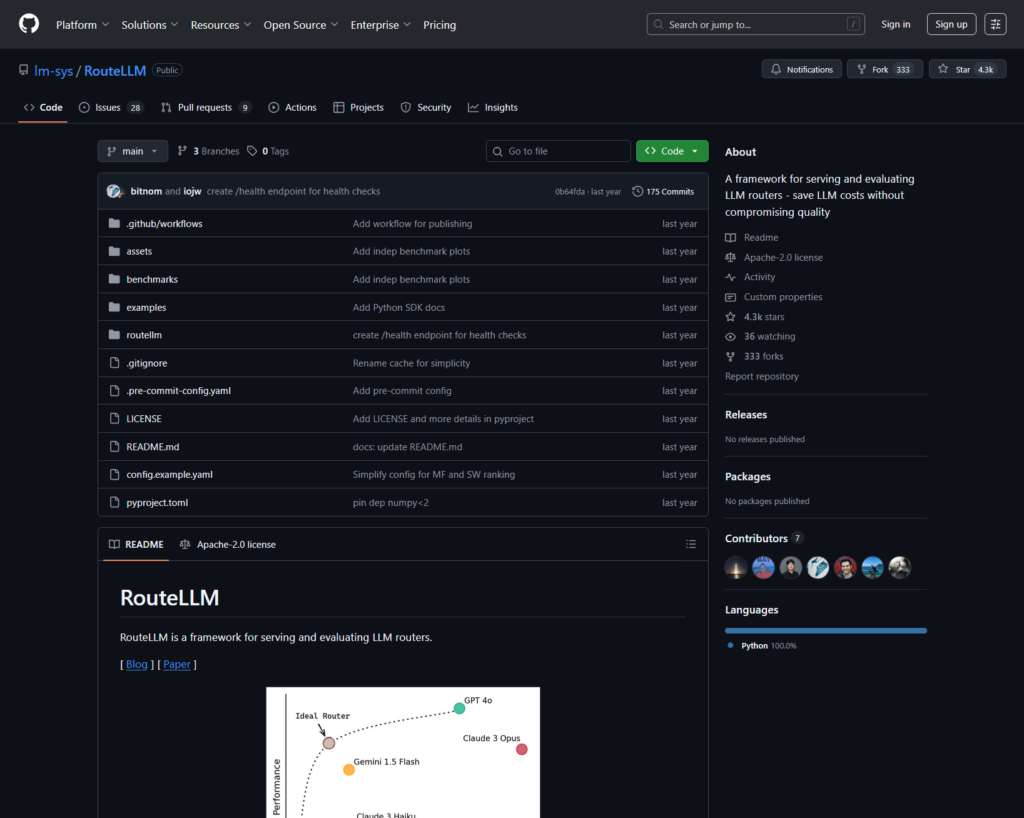

Что такое RouteLLM. RouteLLM — это фреймворк с открытым исходным кодом для обслуживания и оценки маршрутизаторов LLM. Он предлагает клиент/сервер, совместимый с OpenAI, и включает обученные модели маршрутизации, которые могут направлять более простые запросы к более дешевым моделям — сообщается о снижении затрат до 85% при сохранении ~95% производительности GPT-4 на общих бенчмарках (например, MT-Bench).

Почему команды выбирают его.

- Маршрутизация с учетом затрат с политиками, основанными на исследованиях.

- Открытый исходный код и расширяемость на Python.

- Совместимый с OpenAI путь к пробной маршрутизации без значительных переписок SDK.

Где RouteLLM может не подойти.

- Вы хотите прозрачность живого рынка (цена, задержка, время безотказной работы, доступность) перед каждым маршрутом — не только изученная политика.

- Вам нужно отказоустойчивость с несколькими провайдерами

- Ваш план охватывает мультимодальные API такие как OCR, речь, перевод и разбор документов под одной крышей.

Как выбрать альтернативу RouteLLM

- Общая стоимость владения (TCO). Не останавливайтесь на $/1K токенов. Учитывайте частоту попаданий в кэш, повторные попытки/резервные варианты, очереди, затраты на оценку и операционные нагрузки от логов/оповещений. Маршрутизаторы и шлюзы с учетом кэша и семантическим кэшем могут сделать “более высокую цену в списке” дешевле на практике.

- Задержка и надежность. Отдавайте предпочтение маршрутизации с учетом региона, привязке к провайдеру при разогретом кэше и точным резервным вариантам (повторная попытка 429, эскалация при таймаутах). Хостинговые маршрутизаторы, которые оставляют вас на том же провайдере для разогретых контекстов и переключаются при сбоях провайдера, как правило, выигрывают.

- Наблюдаемость и управление. Если важны защитные меры, редактирование, журналы аудита и политика на границе, то AI-шлюз (Portkey или Kong AI Gateway) обычно сильнее, чем просто маршрутизатор. Многие команды используют комбинацию маршрутизатора и шлюза.

- Самостоятельный хостинг против управляемого. Предпочитаете Docker/K8s/Helm и прокси, совместимый с OpenAI? Попробуйте LiteLLM. Хотите хостинговую скорость + видимость рынка? Рассмотрите ShareAI или OpenRouter.

- Широта за пределами чата. Если вам нужны OCR, речь, перевод или разбор документов вместе с LLM-чатом, мультимодальный оркестратор, такой как Eden AI, поможет.

- Маршрутизация на основе данных. Если вы предпочитаете живые тесты для управления стоимостью/скоростью/качеством по регионам или нагрузке, оцените Unify.

Лучшие альтернативы RouteLLM (быстрый выбор)

ShareAI (наш выбор для прозрачности рынка + экономики разработчиков)

Один API для большого каталога моделей/поставщиков с мгновенным переключением и рынком, который отображает цену, задержку, время безотказной работы, доступность перед маршрутизацией. Начните быстро в Песочница, возьмите ключи в Консоли, просмотрите Документация, и сравните варианты в Модели.

Eden AI (мультимодальный оркестратор)

Унифицированный API для LLM плюс изображение, OCR/разбор документов, речь и перевод — наряду с сравнением моделей, мониторингом, кэшированием и пакетной обработкой.

OpenRouter (маршрутизация с учетом кэша)

Хостинг маршрутизатора для многих LLM с кэшированием запросов и привязкой к поставщику для повторного использования теплых контекстов; переключается, если поставщик недоступен.

Portkey (политика и операции SRE на шлюзе)

AI-шлюз с программируемыми резервными механизмами, сценариями ограничения скорости и семантическим кэшем — плюс подробные трассировки/метрики для управления производством.

Kong AI Gateway (управление на краю и аудит)

Принесите AI плагины, политику и аналитику в экосистему Kong; идеально подходит, когда вам нужны централизованные edge-контроли для команд.

Unify (маршрутизатор на основе данных)

Универсальный API с живыми тестами для оптимизации стоимости/скорости/качества по регионам и нагрузке.

Orq.ai (эксперименты и LLMOps)

Эксперименты, оценщики (включая метрики RAG), развертывания и RBAC/VPC — отлично, когда оценка и управление должны сосуществовать.

LiteLLM (самостоятельно размещенный прокси/шлюз)

Прокси с открытым исходным кодом, совместимый с OpenAI, с бюджетами/лимитами, логированием/метриками и интерфейсом администратора. Развертывайте с помощью Docker/K8s/Helm; вы управляете операциями.

Глубокое погружение: лучшие альтернативы RouteLLM

ShareAI (API искусственного интеллекта, управляемый людьми)

Что это. Сеть AI с приоритетом провайдера и унифицированный API. Просматривайте большой каталог моделей/провайдеров и маршрутизируйте с мгновенным переключением при сбоях. Маркетплейс отображает цену, задержку, время работы и доступность в одном месте, чтобы вы могли выбрать подходящего провайдера перед каждым маршрутом. Начните в Песочница, создайте ключи в Консоли, и следуйте быстрому старту API в Документация. Просмотрите Маркетплейсе моделей.

- Прозрачность на рынке — смотрите цену/задержку/время работы/доступность заранее.

- Устойчивость по умолчанию — быстрое переключение на следующего лучшего провайдера, когда один дает сбой.

- Экономика, ориентированная на разработчиков — большая часть расходов идет провайдерам GPU, которые поддерживают модели онлайн.

- Беспрепятственный старт — тестируйте в Playground, затем отправляйте.

Факты о провайдерах (зарабатывают, поддерживая модели онлайн). Любой может стать провайдером (сообщество или компания). Подключайтесь через Windows/Ubuntu/macOS или Docker. Вносите всплески в режиме простоя или работайте постоянно. Выбирайте стимулы: Награды (деньги), Обмен (токены/AI Prosumer) или Миссия (пожертвуйте % НПО). Смотрите Руководство для провайдера или откройте Панель управления провайдера.

Идеально для. Команды по разработке продуктов, которые хотят прозрачности на рынке, устойчивости и возможности перейти в режим поставщика — без привязки к конкретному поставщику.

Eden AI

Что это. Унифицированный API, охватывающий LLM, генерацию изображений, OCR/разбор документов, речь и перевод, чтобы вам не пришлось объединять несколько SDK от разных поставщиков. Также акцентируется внимание на сравнении моделей, мониторинге и пакетной обработке.

Хорошо подходит, когда. Ваш план развития мультимодальный, и вы хотите организовать OCR/речь/перевод вместе с LLM-чатом.

Предупреждения. Если вам нужен просмотр торговой площадки по запросу (цена/задержка/время безотказной работы/доступность) или экономика на уровне поставщика, используйте маршрутизатор маркетплейса, такой как ShareAI.

OpenRouter

Что это. Унифицированный маршрутизатор LLM с маршрутизацией на уровне поставщика/модели. кэширование запросов. С включенным кэшированием OpenRouter, как правило, сохраняет использование одного и того же поставщика для повторного использования теплых контекстов; если этот поставщик недоступен, происходит переключение. Также поддерживаются подсказки стратегии (например, взвешивание по цене).

Хорошо подходит, когда. Вы хотите хостинговую скорость и маршрутизацию с учетом кэша, чтобы сократить затраты и улучшить пропускную способность — особенно в высоконагруженных чатах с повторяющимися запросами.

Предупреждения. Для глубокой корпоративной управляемости (экспорт SIEM, политика на уровне организации) многие команды используют OpenRouter вместе с Portkey или Kong AI Gateway.

Portkey

Что это. Шлюз AI с программируемыми резервными механизмами, плейбуками ограничения скорости и простым/семантическим кэшем, а также трассировками/метриками для управления в стиле SRE. Семантический кэш особенно полезен для коротких запросов/сообщений при хорошо настроенных порогах сходства.

Хорошо подходит, когда. Вам нужна маршрутизация, основанная на политике, с первоклассной наблюдаемостью, и вы готовы управлять уровнем шлюза перед одним или несколькими маршрутизаторами/маркетплейсами.

Kong AI Gateway

Что это. Пограничный шлюз, который интегрирует AI-плагины, политику и аналитику в экосистему Kong (через Konnect или самостоятельное управление). Если ваша API-платформа уже построена вокруг Kong и вам нужны централизованная политика/аудит, это отличный выбор.

Хорошо подходит, когда. Управление на границе, возможность аудита, локализация данных и централизованный контроль являются обязательными в вашей среде.

Унифицировать

Что это. Маршрутизатор, основанный на данных, который оптимизирует стоимость/скорость/качество, используя живые эталонные тесты, адаптируясь по регионам и нагрузке.

Хорошо подходит, когда. Вы хотите выбор, основанный на эталонных тестах, который постоянно адаптируется к реальной производительности.

Orq.ai

Что это. Платформа для совместной работы с генеративным ИИ + LLMOps: эксперименты, оценщики (включая метрики RAG), развертывания и RBAC/VPC. Отлично подходит, когда оценка и управление должны быть объединены.

Хорошо подходит, когда. Вам нужны эксперименты + оценка с управлением в одном месте — затем развертывание непосредственно с той же поверхности.

LiteLLM

Что это. Прокси/шлюз с открытым исходным кодом с совместимыми с OpenAI конечными точками, бюджетами и ограничениями скорости, логированием/метриками и интерфейсом администратора. Развертывание через Docker/K8s/Helm; сохраняйте трафик в своей сети.

Хорошо подходит, когда. Вы хотите самостоятельный хостинг и полный контроль над инфраструктурой с простой совместимостью для популярных SDK в стиле OpenAI.

Предупреждения. Как и в случае с любым шлюзом с открытым исходным кодом, вы управляете операциями и обновлениями.

Быстрый старт: вызов модели за минуты (ShareAI)

Начните в Песочница, затем получите ключ API и отправляйте. Ссылки: быстрому старту API • Главная страница документации • Релизы.

#!/usr/bin/env bash"

// ShareAI — Завершение чатов (JavaScript, Node 18+);

Совет по миграции. Сопоставьте текущие модели, выбранные в RouteLLM, с эквивалентами ShareAI, отразите формы запросов/ответов и начните за фичер-флагом. Сначала отправьте 5–10% трафика, сравните задержку/стоимость/качество, затем увеличьте. Если вы также используете шлюз (Portkey/Kong), убедитесь, что кэширование/резервирование не срабатывают дважды между слоями.

Сравнение с первого взгляда

| Платформа | Хостинг / Самостоятельный хостинг | Маршрутизация и резервные варианты | Наблюдаемость | Широта (LLM + за его пределами) | Управление / Политика | Заметки |

|---|---|---|---|---|---|---|

| RouteLLM | ОСС | Обученный маршрутизатор; клиент/сервер, совместимый с OpenAI | CLI/логи; исследовательский фокус | Ориентированность на LLM | Политика через вашу инфраструктуру | Отлично подходит для экономии на уровне исследований; используйте свои собственные средства управления на границе. |

| ShareAI | Хостинг + сеть провайдеров | Мгновенное переключение; выбор, основанный на рекомендациях из маркетплейса | Журналы использования; статистика торговой площадки; | Широкий каталог моделей | Управление на уровне провайдера; | Рынок, управляемый людьми; начните с Песочница и Модели. |

| Eden AI | Хостинг | Переключение провайдеров; пакетная обработка; кэширование; | Мониторинг стоимости и API; | LLM + изображение + OCR + речь + перевод; | Центральное выставление счетов/управление ключами | Мультимодальный оркестратор. |

| OpenRouter | Хостинг | Маршрутизация провайдера/модели; кэширование запросов; привязка к провайдеру | Информация на уровне запросов; | Ориентированность на LLM | Политики провайдеров; | Повторное использование кэша; резервное решение при недоступности. |

| Portkey | Хостинг-шлюз | Резервные политики; плейбуки ограничения скорости; семантический кэш | Трассировки/метрики | LLM-первый | Конфигурации шлюза; | Ограничения в стиле SRE. |

| Kong AI Gateway | Самостоятельный хостинг/Корпоративное решение | Маршрутизация вверх по потоку через AI плагины | Метрики/аудит через Kong | LLM-первый | Сильное управление на границе | Инфраструктурный компонент; работает в паре с маршрутизаторами/рынками. |

| Унифицировать | Хостинг | Маршрутизация на основе данных по стоимости/скорости/качеству | Исследователь эталонов | Ориентированность на LLM | Политики маршрутизатора | Выбор на основе тестов производительности. |

| Orq.ai | Хостинг | Повторные попытки/резервные варианты в оркестрации | Аналитика платформы; оценщики RAG | LLM + RAG + оценки | Опции RBAC/VPC | Фокус на сотрудничество и эксперименты. |

| LiteLLM | Самостоятельный хостинг/OSS | Повтор/резерв; бюджеты/лимиты | Логирование/метрики; Административный интерфейс | Ориентированность на LLM | Полный контроль инфраструктуры | Совместимость с OpenAI; Развертывание Docker/K8s/Helm. |

Часто задаваемые вопросы: RouteLLM против остальных

RouteLLM против ShareAI — что лучше?

Выберите ShareAI если вы хотите прозрачный рынок, который показывает ценой/задержкой/временем работы/доступностью перед каждым маршрутом, плюс мгновенное переключение и экономика, ориентированная на разработчиков. Выберите RouteLLM если вы предпочитаете исследовательский подход, обученный маршрутизатор и вам комфортно управлять инфраструктурой вокруг него (шлюзы, логирование, аудит). Начните с Песочница и Маркетплейсе моделей.

RouteLLM против Eden AI — в чем разница?

Eden AI охватывает LLM и мультимодальный (визуальный/OCR, речь, перевод) с сравнением и мониторингом. RouteLLM фокусируется на обученном маршрутизации для LLM. Если вашему плану требуется OCR/речь/перевод под одним API, Eden AI упрощает доставку; если приоритетом является исследование маршрутизации, RouteLLM подходит. Используйте ShareAI, когда вам нужна прозрачность на рынке для каждого запроса.

RouteLLM против OpenRouter — когда выбрать каждый?

Выберите OpenRouter когда кэширование запросов и повторное использование теплого кэша имеют значение (это обычно удерживает вас на одном провайдере и возвращается при сбоях). Выберите RouteLLM для обученных политик, которые вы управляете самостоятельно. Многие стеки сочетают OpenRouter со шлюзом для политики/наблюдаемости — и все еще используют ShareAI, когда им нужна прозрачность на рынке перед каждым маршрутом.

RouteLLM против Portkey — маршрутизатор или шлюз?

RouteLLM является маршрутизатором. Portkey является шлюз: он превосходен в политике/ограничениях (резервные сценарии, семантический кэш) и детализированных трассировках/метриках. Многие команды используют оба: шлюз для политики на уровне организации + маршрутизатор/рынок для выбора модели и контроля затрат. ShareAI хорошо сочетается здесь, когда вам нужна видимость рынка перед маршрутом.

RouteLLM против Kong AI Gateway — кому что нужно?

Выберите Kong AI Gateway когда управление на периферии (централизованная политика/аудит, резидентность данных) является обязательным. Сохраните RouteLLM за ним, если вы все еще хотите обученную маршрутизацию для цены/производительности. Используйте ShareAI наряду с тем, когда вы хотите выбирать провайдеров по ценой/задержкой/временем работы/доступностью перед каждым маршрутом.

RouteLLM vs Unify — что уникального в Unify?

Унифицировать использует живые бенчмарки и динамические политики для оптимизации стоимость/скорость/качество. Если вам нужен выбор, основанный на данных, который адаптируется по регионам/нагрузке, Unify привлекателен; RouteLLM фокусируется на обученных моделях маршрутизации, которые вы размещаете. Используйте ShareAI когда вы предпочитаете выбирать провайдеров с видом на рынок и мгновенным переключением.

RouteLLM vs Orq.ai — что для оценки и RAG?

Orq.ai предоставляет поверхность для экспериментов/оценки (включая оценщики RAG), плюс развертывания и RBAC/VPC. Если вам нужны LLMOps + оценщики, Orq.ai может дополнить или заменить чистый маршрутизатор на раннем этапе. Используйте ShareAI когда вы хотите выбора провайдеров с прозрачностью рынка и устойчивостью в производстве.

RouteLLM vs LiteLLM — размещенный vs самостоятельно размещенный?

RouteLLM это логика маршрутизации с открытым исходным кодом; LiteLLM это прокси/шлюз, совместимый с OpenAI, с бюджетами, ограничениями скорости и интерфейсом администратора — отлично, если вы хотите сохранить трафик внутри вашего VPC и владеть плоскостью управления. Команды часто комбинируют LiteLLM для самостоятельного размещения с ShareAI для видимости рынка и мгновенного переключения между провайдерами.

Что дешевле для моей нагрузки: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Это зависит от выбора модели, региона, кэшируемости и шаблонов трафика. Маршрутизаторы, такие как ShareAI/OpenRouter могут снизить затраты через маршрутизацию и учет кэширования; шлюзы, такие как Portkey добавляют семантическое кэширование; LiteLLM уменьшают накладные расходы платформы, если вы готовы их использовать. Тестируйте с ваша подсказки и отслеживание эффективную стоимость за результат—а не только цену в списке.

Что такое RouteLLM?

Открытая платформа для обслуживания и оценки маршрутизаторов LLM; включает обученные маршрутизаторы и пути, совместимые с OpenAI; часто упоминается как способ значительного снижения затрат при сохранении качества, близкого к GPT-4, на задачах, подобных MT-Bench.

Какой самый быстрый способ попробовать ShareAI без полной интеграции?

Откройте Песочница, выберите модель/поставщика и запускайте подсказки в браузере. Когда будете готовы, создайте ключ и вставьте приведенные выше фрагменты cURL/JS в ваше приложение.

Могу ли я стать поставщиком ShareAI и зарабатывать?

Да. Любой может зарегистрироваться как Сообщество или Компания поставщик, использующий Windows/Ubuntu/macOS или Docker. Внесите вклад в периоды простоя или запускайте всегда включен. Выберите стимулы: Награды (деньги), Обмен (токены/AI Prosumer), или Миссия (пожертвуйте % НПО). Смотрите Руководство для провайдера или откройте Панель управления провайдера.

Заключение

Пока RouteLLM это мощный маршрутизатор с открытым исходным кодом, ваш лучший выбор зависит от приоритетов:

- Прозрачность рынка + устойчивость: ShareAI

- Мультимодальное покрытие через один API: Eden AI

- Маршрутизация с учетом кэша в размещенной форме: OpenRouter

- Политика/ограничения на периферии: Portkey или Kong AI Gateway

- Маршрутизация, основанная на данных: Унифицировать

- LLMOps + оценщики: Orq.ai

- Самостоятельно размещаемая плоскость управления: LiteLLM

Если ценой/задержкой/временем работы/доступностью перед каждым маршрутом, мгновенное переключение, и экономика, согласованная с разработчиком находятся в вашем контрольном списке, откройте Песочница, создайте ключ API, и просмотрите Маркетплейсе моделей чтобы направить ваш следующий запрос умным способом.