ทางเลือกของ Requesty 2026: ShareAI เทียบกับ Eden AI, OpenRouter, Portkey, Kong AI, Unify, Orq & LiteLLM

อัปเดต กุมภาพันธ์ 2026

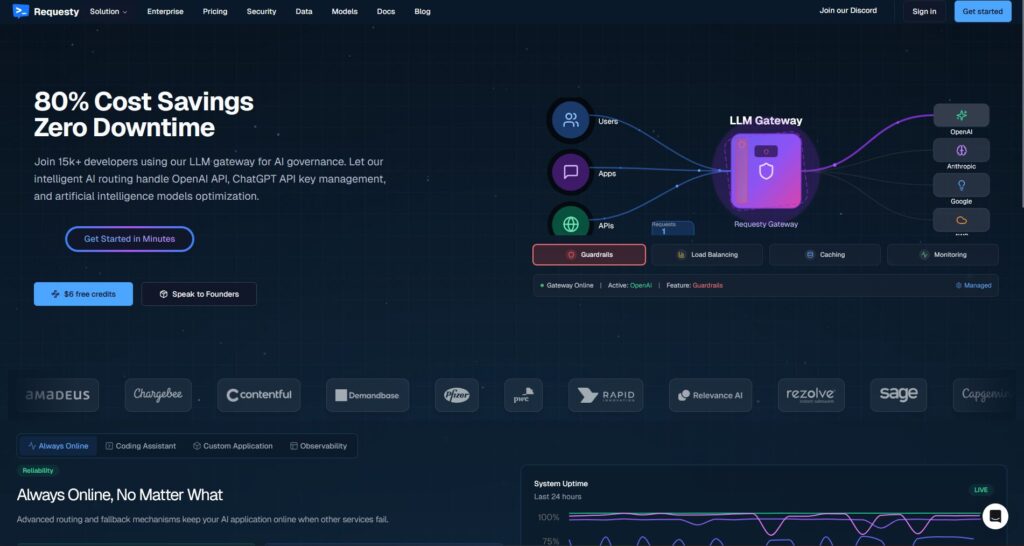

นักพัฒนาซอฟต์แวร์เลือก คำขอ สำหรับเกตเวย์เดียวที่เข้ากันได้กับ OpenAI ครอบคลุมผู้ให้บริการ LLM หลายราย รวมถึงการกำหนดเส้นทาง การวิเคราะห์ และการกำกับดูแล แต่ถ้าคุณให้ความสำคัญกับ ความโปร่งใสของตลาดก่อนแต่ละเส้นทาง (ราคา, ความหน่วง, เวลาทำงาน, ความพร้อมใช้งาน), นโยบายขอบที่เข้มงวด, หรือ พร็อกซีที่โฮสต์เอง, หนึ่งใน ตัวเลือกแทน Requesty อาจเหมาะกับสแต็กของคุณมากกว่า.

คู่มือการซื้อฉบับนี้เขียนเหมือนที่ผู้สร้างจะเขียน: การแลกเปลี่ยนที่เฉพาะเจาะจง, ตัวเลือกที่ชัดเจน, การเจาะลึก, การเปรียบเทียบแบบเคียงข้างกัน, และการคัดลอก-วาง แชร์เอไอ เริ่มต้นอย่างรวดเร็วเพื่อให้คุณสามารถส่งมอบได้วันนี้.

ทำความเข้าใจ Requesty (และที่ที่อาจไม่เหมาะสม)

Requesty คืออะไร. Requesty เป็น LLM เกตเวย์. คุณชี้ไคลเอนต์ที่เข้ากันได้กับ OpenAI ของคุณไปยังปลายทาง Requesty และกำหนดเส้นทางคำขอผ่านผู้ให้บริการ/โมเดลหลายราย—มักจะมีการสำรองข้อมูล, การวิเคราะห์, และการป้องกันนโยบาย มันถูกออกแบบมาให้เป็น สถานที่เดียว เพื่อจัดการการใช้งาน, ตรวจสอบค่าใช้จ่าย, และบังคับใช้การกำกับดูแลในคำขอ AI ของคุณ.

ทำไมทีมถึงเลือกมัน.

- API เดียว, ผู้ให้บริการหลายราย. ลดการกระจายตัวของ SDK และรวมการสังเกตการณ์.

- การสำรองข้อมูล & การกำหนดเส้นทาง. รักษาเวลาทำงานให้คงที่แม้ผู้ให้บริการมีปัญหา.

- การกำกับดูแลระดับองค์กร. นโยบายกลาง, การควบคุมระดับองค์กร, งบประมาณการใช้งาน.

ที่ที่ Requesty อาจไม่เหมาะสม.

- คุณต้องการ ความโปร่งใสของตลาดก่อนแต่ละเส้นทาง (ดูราคา, ความหน่วง, เวลาทำงาน, ความพร้อมใช้งานต่อผู้ให้บริการในขณะนี้, แล้วเลือก).

- คุณต้องการ นโยบายระดับขอบ ในสแต็กของคุณเอง (เช่น Kong, Portkey) หรือ โฮสต์ด้วยตัวเอง (LiteLLM).

- แผนงานของคุณต้องการ คุณสมบัติแบบมัลติโหมดที่หลากหลาย ภายใต้หลังคาเดียว (OCR, การพูด, การแปล, การแยกวิเคราะห์เอกสาร) เกินกว่าการสนทนา LLM—ซึ่งตัวจัดการอย่าง ShareAI อาจเหมาะสมกว่า.

วิธีเลือกทางเลือกแทน Requesty

1) ต้นทุนรวมของการเป็นเจ้าของ (TCO). อย่าหยุดที่ $/1K โทเค็น รวมถึง อัตราการเข้าถึงแคช, การลองใหม่/การสำรอง, การจัดคิว, ต้นทุนผู้ประเมิน, ค่าใช้จ่ายต่อคำขอ, และภาระงานของการสังเกตการณ์/การแจ้งเตือน “ราคาที่ถูกที่สุดในรายการ” มักจะแพ้ให้กับเราเตอร์/เกตเวย์ที่ลดของเสีย.

2) ความหน่วงและความน่าเชื่อถือ. ให้ความสำคัญกับ การกำหนดเส้นทางที่รับรู้ภูมิภาค, การใช้งานแคชที่อุ่น (ยึดติดกับผู้ให้บริการเดียวกันเมื่อมีการใช้งานแคชคำสั่ง), และการสำรองข้อมูลที่แม่นยำ (ลองใหม่เมื่อเจอ 429; เพิ่มระดับเมื่อหมดเวลา; จำกัดการกระจายเพื่อหลีกเลี่ยงการใช้จ่ายซ้ำซ้อน).

3) การสังเกตการณ์ & การกำกับดูแล. หากมีรั้วป้องกัน, บันทึกการตรวจสอบ, การลบข้อมูล, และ นโยบายที่ขอบ มีความสำคัญ, เกตเวย์เช่น พอร์ทคีย์ หรือ คอง AI เกตเวย์ มักจะแข็งแกร่งกว่าการรวมตัวแบบบริสุทธิ์. หลายทีมจับคู่ ตัวกำหนดเส้นทาง + เกตเวย์ เพื่อให้ได้สิ่งที่ดีที่สุดของทั้งสอง.

4) โฮสต์เอง vs บริการที่จัดการ. ชอบ Docker/K8s/Helm และจุดเชื่อมต่อที่เข้ากันได้กับ OpenAI? ดู LiteLLM (OSS) หรือ คอง AI เกตเวย์ (โครงสร้างพื้นฐานระดับองค์กร). ต้องการ ความเร็วที่โฮสต์ + การมองเห็นในตลาด? ดู แชร์เอไอ (ตัวเลือกของเรา), OpenRouter, หรือ รวมเป็นหนึ่ง.

5) ความกว้างขวางเกินกว่าการแชท. หากแผนงานของคุณรวมถึง OCR, การแปลงเสียงเป็นข้อความ, การแปลภาษา, การสร้างภาพ, และการแยกวิเคราะห์เอกสารภายใต้ผู้จัดการเดียว, แชร์เอไอ สามารถทำให้การส่งมอบและการทดสอบง่ายขึ้น.

6) การเตรียมพร้อมสำหรับอนาคต. เลือกเครื่องมือที่ทำให้ การเปลี่ยนแปลงโมเดล/ผู้ให้บริการเป็นเรื่องง่าย (API สากล, การกำหนดเส้นทางแบบไดนามิก, ชื่อโมเดลที่ชัดเจน) เพื่อให้คุณสามารถนำตัวเลือกใหม่กว่า/ถูกกว่า/เร็วกว่าไปใช้ได้โดยไม่ต้องเขียนใหม่.

ทางเลือกที่ดีที่สุดสำหรับ Requesty (ตัวเลือกด่วน)

แชร์เอไอ (ตัวเลือกของเราสำหรับความโปร่งใสของตลาด + เศรษฐศาสตร์ของผู้สร้าง)

API เดียวทั่ว โมเดลกว่า 150+ พร้อมการสำรองข้อมูลทันทีและ ตลาด ที่แสดง ราคา, ความหน่วง, ความพร้อมใช้งาน, การให้บริการ ก่อนที่คุณจะกำหนดเส้นทาง. ผู้ให้บริการ (ชุมชนหรือบริษัท) รักษา รายได้ส่วนใหญ่, จัดแนวแรงจูงใจกับความน่าเชื่อถือ เริ่มต้นอย่างรวดเร็วใน สนามเด็กเล่น, คว้ากุญแจใน คอนโซล, และอ่าน เอกสาร.

อีเดน AI (ผู้ประสานงานหลายรูปแบบ)

API แบบรวมสำหรับ LLMs รวมถึง ภาพ, การแยกข้อความ/เอกสาร, เสียง, และการแปล—พร้อมกับ การเปรียบเทียบโมเดล, การตรวจสอบ, การแคช, และการประมวลผลแบบแบทช์.

OpenRouter (การกำหนดเส้นทางที่รับรู้การแคช)

ตัวกำหนดเส้นทางที่โฮสต์ใน LLMs หลายตัวพร้อม การแคชคำสั่ง และความยึดติดกับผู้ให้บริการเพื่อใช้บริบทที่อุ่นแล้วซ้ำ; กลับไปใช้เมื่อผู้ให้บริการไม่พร้อมใช้งาน.

พอร์ทคีย์ (นโยบาย & การดำเนินงาน SRE ที่เกตเวย์)

เกตเวย์ AI พร้อม การสำรองที่ตั้งโปรแกรมได้, playbooks การจำกัดอัตรา, และ แคชแบบง่าย/เชิงความหมาย, พร้อมด้วยการติดตาม/เมตริกอย่างละเอียดสำหรับการควบคุมการผลิต.

คอง AI เกตเวย์ (การกำกับดูแลและการตรวจสอบขอบเขต)

นำ ปลั๊กอิน AI, นโยบาย, การวิเคราะห์ มาสู่ระบบนิเวศของ Kong; เข้ากันได้ดีกับตัวจัดเส้นทางตลาดเมื่อคุณต้องการการควบคุมแบบรวมศูนย์ข้ามทีม.

รวมเป็นหนึ่ง (ตัวจัดเส้นทางที่ขับเคลื่อนด้วยข้อมูล)

API สากลพร้อม การวัดผลแบบสด เพื่อเพิ่มประสิทธิภาพต้นทุน/ความเร็ว/คุณภาพตามภูมิภาคและปริมาณงาน.

ออร์ค.ai (การทดลองและ LLMOps)

การทดลอง, ตัวประเมินผล (รวมถึง RAG เมตริก), การปรับใช้, RBAC/VPC—เหมาะอย่างยิ่งเมื่อการประเมินและการกำกับดูแลต้องอยู่ร่วมกัน.

LiteLLM (พร็อกซี/เกตเวย์ที่โฮสต์ด้วยตัวเอง)

โพร็อกซีแบบโอเพ่นซอร์สที่เข้ากันได้กับ OpenAI พร้อมด้วย งบประมาณ/ข้อจำกัด, การบันทึก/เมตริก และอินเทอร์เฟซผู้ดูแลระบบ (Admin UI) ติดตั้งด้วย Docker/K8s/Helm; คุณเป็นเจ้าของการดำเนินงาน.

การเจาะลึก: ทางเลือกยอดนิยม

ShareAI (API AI ที่ขับเคลื่อนโดยผู้คน)

มันคืออะไร. เครือข่าย AI ที่เน้นผู้ให้บริการเป็นหลักและ API แบบรวมศูนย์ เรียกดูแคตตาล็อกขนาดใหญ่ของโมเดล/ผู้ให้บริการและกำหนดเส้นทางด้วย การเปลี่ยนไปใช้ระบบสำรองทันที. ตลาดจะแสดง ราคา, ความหน่วง, ความพร้อมใช้งาน และความเสถียร ในที่เดียวเพื่อให้คุณ เลือกผู้ให้บริการที่เหมาะสมก่อนแต่ละเส้นทาง. เริ่มต้นใน สนามเด็กเล่น, สร้างคีย์ใน คอนโซล, และทำตาม การเริ่มต้นใช้งาน API.

ทำไมทีมถึงเลือกใช้.

- ความโปร่งใสของตลาด — ดูผู้ให้บริการ ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน ล่วงหน้า.

- ความยืดหยุ่นโดยค่าเริ่มต้น — รวดเร็ว การสำรองข้อมูล ไปยังผู้ให้บริการที่ดีที่สุดถัดไปเมื่อมีปัญหาเกิดขึ้น.

- เศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง — ส่วนใหญ่ของการใช้จ่ายจะไหลไปยังผู้ให้บริการ GPU ที่รักษาโมเดลให้ออนไลน์.

- การเริ่มต้นที่ไร้แรงเสียดทาน — เรียกดูโมเดล, ทดสอบใน สนามเด็กเล่น, และจัดส่ง.

ข้อเท็จจริงของผู้ให้บริการ (รับรายได้โดยการรักษาโมเดลให้ออนไลน์). ใครๆ ก็สามารถเป็นผู้ให้บริการได้ (ชุมชนหรือบริษัท) เข้าร่วมผ่าน Windows/Ubuntu/macOS/Docker. มีส่วนร่วม การประมวลผลในช่วงเวลาว่าง หรือรัน เปิดใช้งานตลอดเวลา. เลือกแรงจูงใจ: รางวัล (เงิน), แลกเปลี่ยน (โทเค็น/AI Prosumer), หรือ ภารกิจ (บริจาค % ให้กับ NGOs) เมื่อคุณขยายตัว, ตั้งราคาการประมวลผลของคุณเอง และได้รับ การเปิดเผยที่เป็นพิเศษ. รายละเอียด: คู่มือผู้ให้บริการ.

เหมาะสำหรับ. ทีมผลิตภัณฑ์ที่ต้องการ ความโปร่งใสของตลาด, ความยืดหยุ่น, และ พื้นที่สำหรับการเติบโต สู่โหมดผู้ให้บริการ—โดยไม่มีการล็อกอินจากผู้ขาย.

อีเดน AI

มันคืออะไร. API ที่รวมเป็นหนึ่งเดียวที่ครอบคลุม LLMs + การสร้างภาพ + OCR/การแยกวิเคราะห์เอกสาร + เสียง + การแปล, ช่วยลดความจำเป็นในการรวม SDK จากผู้ขายหลายราย. การเปรียบเทียบโมเดล ช่วยให้คุณทดสอบผู้ให้บริการแบบเคียงข้างกัน นอกจากนี้ยังเน้น การตรวจสอบต้นทุน/API, การประมวลผลแบบแบทช์, และ การแคช.

เหมาะสมเมื่อ. แผนงานของคุณคือ มัลติโหมด และคุณต้องการจัดการ OCR/เสียง/การแปลควบคู่ไปกับการสนทนา LLM จากพื้นผิวเดียว.

สิ่งที่ควรระวัง. หากคุณต้องการ มุมมองตลาดต่อคำขอ (ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน) หรือเศรษฐศาสตร์ระดับผู้ให้บริการ พิจารณาเราเตอร์แบบตลาด เช่น แชร์เอไอ พร้อมกับคุณสมบัติหลายรูปแบบของ Eden.

OpenRouter

มันคืออะไร. เราเตอร์ LLM แบบรวม การกำหนดเส้นทางผู้ให้บริการ/โมเดล และ การแคชคำสั่ง. เมื่อเปิดใช้งานการแคช OpenRouter จะพยายามให้คุณอยู่กับ ผู้ให้บริการเดียวกัน เพื่อใช้บริบทที่อุ่นซ้ำ; หากผู้ให้บริการนั้นไม่พร้อมใช้งาน จะเปลี่ยนไป ผู้ให้บริการที่ดีที่สุดถัดไป.

เหมาะสมเมื่อ. คุณต้องการ ความเร็วที่โฮสต์ และ การกำหนดเส้นทางที่รับรู้การแคช เพื่อลดต้นทุนและปรับปรุงปริมาณงาน—โดยเฉพาะในงานแชทที่มี QPS สูงพร้อมคำถามซ้ำ.

สิ่งที่ควรระวัง. สำหรับการกำกับดูแล ระดับองค์กรที่ลึกซึ้ง (เช่น การส่งออก SIEM, นโยบายทั่วทั้งองค์กร), หลายทีม จับคู่ OpenRouter กับ Portkey หรือ Kong AI Gateway.

พอร์ทคีย์

มันคืออะไร. ปัญญาประดิษฐ์ (AI) แพลตฟอร์มปฏิบัติการ + เกตเวย์ พร้อมด้วยการตั้งโปรแกรมได้ ตัวเลือกสำรอง, playbooks การจำกัดอัตรา, และ แคชแบบง่าย/เชิงความหมาย, รวมถึง การติดตาม/เมตริก สำหรับการควบคุมแบบ SRE.

- การสำรองซ้อนกัน & การกำหนดเส้นทางตามเงื่อนไข — แสดงต้นไม้การลองใหม่ (เช่น ลองใหม่ 429; สลับเมื่อ 5xx; เปลี่ยนเมื่อมีการเพิ่มขึ้นของความหน่วงเวลา).

- แคชเชิงความหมาย — มักจะชนะในข้อความ/ข้อความสั้น ๆ (มีข้อจำกัด).

- กุญแจ/งบประมาณเสมือน — รักษาการใช้งานทีม/โครงการให้อยู่ในนโยบาย.

เหมาะสมเมื่อ. คุณต้องการ การกำหนดเส้นทางตามนโยบาย พร้อมด้วยการสังเกตการณ์ระดับสูงสุด และคุณรู้สึกสบายใจในการดำเนินการ เกตเวย์ ชั้นที่อยู่ด้านหน้าของเราเตอร์/ตลาดกลางหนึ่งตัวหรือมากกว่า.

คอง AI เกตเวย์

มันคืออะไร. หนึ่ง เกตเวย์ขอบ ที่นำ ปลั๊กอิน AI, การกำกับดูแล, และการวิเคราะห์ เข้าสู่ระบบนิเวศของ Kong (ผ่าน Konnect หรือการจัดการด้วยตัวเอง) มันคือโครงสร้างพื้นฐาน—เหมาะสมอย่างยิ่งเมื่อแพลตฟอร์ม API ของคุณหมุนรอบ Kong อยู่แล้วและคุณต้องการ นโยบาย/การตรวจสอบส่วนกลาง.

เหมาะสมเมื่อ. การกำกับดูแลขอบ, การตรวจสอบได้, การอยู่อาศัยของข้อมูล, และ การควบคุมแบบรวมศูนย์ เป็นสิ่งที่ไม่สามารถต่อรองได้ในสภาพแวดล้อมของคุณ.

สิ่งที่ควรระวัง. คาดหวัง การตั้งค่าและการบำรุงรักษา. หลายทีม จับคู่ Kong กับเราเตอร์ตลาดกลาง (เช่น ShareAI/OpenRouter) สำหรับการเลือกผู้ให้บริการและการควบคุมค่าใช้จ่าย.

รวมเป็นหนึ่ง

มันคืออะไร. A เราเตอร์ที่ขับเคลื่อนด้วยข้อมูล ที่ปรับให้เหมาะสมสำหรับ ต้นทุน/ความเร็ว/คุณภาพ การใช้ การวัดผลแบบสด. มันเปิดเผย API สากล และอัปเดตตัวเลือกโมเดลตามภูมิภาค/ภาระงาน.

เหมาะสมเมื่อ. คุณต้องการ การเลือกโดยใช้การวัดประสิทธิภาพเป็นแนวทาง ที่ปรับเปลี่ยนตามประสิทธิภาพในโลกจริงอย่างต่อเนื่อง.

ออร์ค.ai

มันคืออะไร. AI เชิงสร้างสรรค์ การทำงานร่วมกัน + LLMOps แพลตฟอร์ม: การทดลอง, การประเมินผล (รวมถึง RAG เมตริก เช่น ความเกี่ยวข้องของบริบท/ความถูกต้อง/ความทนทาน), การปรับใช้, และ RBAC/VPC.

เหมาะสมเมื่อ. คุณต้องการ การทดลอง + การประเมินผล พร้อมการกำกับดูแลในที่เดียว—จากนั้นปรับใช้โดยตรงจากพื้นผิวเดียวกัน.

LiteLLM

มันคืออะไร. หนึ่ง พร็อกซี/เกตเวย์แบบโอเพ่นซอร์ส ด้วย เข้ากันได้กับ OpenAI จุดเชื่อมต่อ, งบประมาณ & ขีดจำกัดอัตรา, การบันทึก/เมตริก และ UI สำหรับผู้ดูแลระบบ. ใช้งานผ่าน Docker/K8s/Helm; เก็บทราฟฟิกไว้ในเครือข่ายของคุณเอง.

เหมาะสมเมื่อ. คุณต้องการ โฮสต์ด้วยตัวเอง และ การควบคุมโครงสร้างพื้นฐานทั้งหมด พร้อมความเข้ากันได้ง่ายสำหรับ SDK สไตล์ OpenAI ที่ได้รับความนิยม.

สิ่งที่ควรระวัง. เช่นเดียวกับเกตเวย์ OSS ใดๆ, คุณเป็นเจ้าของการดำเนินงานและการอัปเกรด. ตรวจสอบให้แน่ใจว่าคุณจัดสรรเวลาในการตรวจสอบ, การปรับขนาด, และการอัปเดตความปลอดภัย.

เริ่มต้นอย่างรวดเร็ว: เรียกใช้งานโมเดลในไม่กี่นาที (ShareAI)

เริ่มต้นใน สนามเด็กเล่น, จากนั้นรับ API key และส่งออก. อ้างอิง: การเริ่มต้นใช้งาน API • หน้าเอกสาร • การเปิดตัว.

#!/usr/bin/env bash"

// ShareAI — การทำงานร่วมกันของแชท (JavaScript, Node 18+);

เคล็ดลับการย้ายข้อมูล: แมปโมเดล Requesty ปัจจุบันของคุณไปยังโมเดลที่เทียบเท่าของ ShareAI, สะท้อนรูปร่างคำขอ/การตอบกลับ, และเริ่มต้นหลัง ธงคุณสมบัติ. ส่งทราฟฟิก 5–10% ก่อน, เปรียบเทียบ ความหน่วง/ต้นทุน/คุณภาพ, แล้วค่อยเพิ่มขึ้น หากคุณใช้งานเกตเวย์ (Portkey/Kong) ด้วย, ตรวจสอบให้แน่ใจว่า การแคช/การสำรองข้อมูล ไม่ทำงานซ้ำซ้อนในแต่ละเลเยอร์.

การเปรียบเทียบในพริบตา

| แพลตฟอร์ม | โฮสต์ / โฮสต์ด้วยตัวเอง | การกำหนดเส้นทาง & การสำรองข้อมูล | การสังเกตการณ์ | ความหลากหลาย (LLM + อื่น ๆ) | การกำกับดูแล/นโยบาย | หมายเหตุ |

|---|---|---|---|---|---|---|

| คำขอ | โฮสต์ | เราเตอร์พร้อมการสำรองข้อมูล; เข้ากันได้กับ OpenAI | การตรวจสอบ/การวิเคราะห์ในตัว | เน้น LLM (แชท/การทำงานร่วมกัน) | การกำกับดูแลระดับองค์กร | เปลี่ยน URL พื้นฐานของ OpenAI เป็น Requesty; เน้นองค์กร. |

| แชร์เอไอ | โฮสต์ + เครือข่ายผู้ให้บริการ | การสลับระบบสำรองทันที; การกำหนดเส้นทางที่แนะนำโดยตลาด | บันทึกการใช้งาน; สถิติของตลาด | แคตตาล็อกโมเดลที่หลากหลาย | การควบคุมในระดับผู้ให้บริการ | ตลาดที่ขับเคลื่อนด้วยผู้คน; เริ่มต้นด้วย สนามเด็กเล่น. |

| อีเดน AI | โฮสต์ | สลับผู้ให้บริการ; แบตช์; การแคช | การตรวจสอบค่าใช้จ่ายและ API | LLM + ภาพ + OCR + เสียง + การแปล | การเรียกเก็บเงินแบบรวมศูนย์/การจัดการคีย์ | การเปรียบเทียบโมเดลเพื่อทดสอบผู้ให้บริการแบบเคียงข้างกัน. |

| OpenRouter | โฮสต์ | การกำหนดเส้นทางผู้ให้บริการ/โมเดล; การแคชคำสั่ง | ข้อมูลในระดับคำขอ | เน้น LLM | นโยบายของผู้ให้บริการ | การใช้แคชซ้ำเมื่อรองรับ; การสำรองเมื่อไม่พร้อมใช้งาน. |

| พอร์ทคีย์ | โฮสต์ & เกตเวย์ | การสำรองนโยบาย; คู่มือการจำกัดอัตรา; แคชเชิงความหมาย | การติดตาม/เมตริก | LLM-มาก่อน | การกำหนดค่าประตูทางเข้า | เหมาะสำหรับการตั้งค่าการ์ดเรลแบบ SRE และนโยบายองค์กร. |

| คอง AI เกตเวย์ | โฮสต์เอง/องค์กร | การกำหนดเส้นทางต้นน้ำผ่านปลั๊กอิน AI | เมตริก/การตรวจสอบผ่าน Kong | LLM-มาก่อน | การกำกับดูแลขอบที่แข็งแกร่ง | ส่วนประกอบโครงสร้างพื้นฐาน; จับคู่กับเราเตอร์/ตลาด. |

| รวมเป็นหนึ่ง | โฮสต์ | การกำหนดเส้นทางที่ขับเคลื่อนด้วยข้อมูล โดยต้นทุน/ความเร็ว/คุณภาพ | ตัวสำรวจเกณฑ์มาตรฐาน | เน้น LLM | การตั้งค่าความชอบของเราเตอร์ | การเลือกโมเดลโดยใช้เกณฑ์มาตรฐานเป็นแนวทาง. |

| ออร์ค.ai | โฮสต์ | การลองใหม่/การสำรองในกระบวนการจัดการ | การวิเคราะห์แพลตฟอร์ม; ผู้ประเมิน RAG | LLM + RAG + การประเมิน | ตัวเลือก RBAC/VPC | มุ่งเน้นการทำงานร่วมกันและการทดลอง. |

| LiteLLM | โฮสต์เอง/OSS | การลองใหม่/การสำรอง; งบประมาณ/ขีดจำกัด | การบันทึก/ตัวชี้วัด; ส่วนติดต่อผู้ดูแลระบบ | เน้น LLM | การควบคุมโครงสร้างพื้นฐานทั้งหมด | เข้ากันได้กับ OpenAI; การปรับใช้ Docker/K8s/Helm. |

คำถามที่พบบ่อย

Requesty คืออะไร?

เป็น LLM เกตเวย์ ที่ให้บริการการกำหนดเส้นทางหลายผู้ให้บริการผ่าน API ที่เข้ากันได้กับ OpenAI พร้อมการตรวจสอบ การกำกับดูแล และการควบคุมค่าใช้จ่าย.

ทางเลือกที่ดีที่สุดสำหรับ Requesty คืออะไร?

ตัวเลือกยอดนิยมได้แก่ แชร์เอไอ (ความโปร่งใสของตลาด + การสำรองฉับพลัน), อีเดน AI (API หลายรูปแบบ + การเปรียบเทียบโมเดล), OpenRouter (การกำหนดเส้นทางที่รับรู้แคช), พอร์ทคีย์ (เกตเวย์พร้อมนโยบาย & แคชเชิงความหมาย), คอง AI เกตเวย์ (การกำกับดูแลขอบ), รวมเป็นหนึ่ง (ตัวกำหนดเส้นทางที่ขับเคลื่อนด้วยข้อมูล), ออร์ค.ai (LLMOps/ผู้ประเมิน), และ LiteLLM (พร็อกซีที่โฮสต์เอง).

Requesty กับ ShareAI — อันไหนดีกว่า?

เลือก แชร์เอไอ หากคุณต้องการ ตลาดที่โปร่งใส ที่แสดง ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งานก่อนที่คุณจะกำหนดเส้นทาง, พร้อมทั้งการสำรองข้อมูลทันทีและเศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง. เลือก คำขอ หากคุณชอบเกตเวย์ที่โฮสต์เดียวพร้อมการกำกับดูแลระดับองค์กรและคุณสบายใจกับการเลือกผู้ให้บริการโดยไม่มีมุมมองตลาด. ลองใช้ ShareAI’s ตลาดโมเดล และ สนามเด็กเล่น.

Requesty กับ Eden AI — มีความแตกต่างอย่างไร?

อีเดน AI ครอบคลุม LLMs + มัลติโหมด (วิสัยทัศน์/OCR, เสียง, การแปล) และรวมถึง การเปรียบเทียบโมเดล; คำขอ มีความ เน้น LLM มากขึ้นด้วยการกำหนดเส้นทาง/การกำกับดูแล. หากแผนงานของคุณต้องการ OCR/เสียง/การแปลภายใต้ API เดียว, Eden AI ทำให้การส่งมอบง่ายขึ้น; สำหรับการกำหนดเส้นทางแบบเกตเวย์, Requesty เหมาะสม.

Requesty กับ OpenRouter — ควรเลือกอันไหนในแต่ละกรณี?

เลือก OpenRouter เมื่อไหร่ การแคชคำสั่ง และ การใช้แคชที่อุ่นซ้ำ เรื่อง (มันมีแนวโน้มที่จะทำให้คุณอยู่กับผู้ให้บริการเดิมและกลับไปยังผู้ให้บริการในกรณีที่เกิดปัญหา). เลือก คำขอ สำหรับการกำกับดูแลองค์กรด้วยเราเตอร์เดียวและหากความสำคัญของคุณไม่ใช่การยึดติดกับผู้ให้บริการที่รับรู้แคช.

Requesty vs Portkey vs Kong AI Gateway — เราเตอร์หรือเกตเวย์?

คำขอ เป็นเราเตอร์. พอร์ทคีย์ และ คอง AI เกตเวย์ คือ เกตเวย์: พวกเขาโดดเด่นใน นโยบาย/ข้อกำหนด (การสำรองข้อมูล, การจำกัดอัตรา, การวิเคราะห์, การกำกับดูแลขอบเขต). สแต็กหลายตัวใช้ ทั้งสอง: เกตเวย์สำหรับนโยบายทั่วทั้งองค์กร + เราเตอร์/ตลาดสำหรับการเลือกโมเดลและการควบคุมต้นทุน.

Requesty vs Unify — อะไรที่ทำให้ Unify มีเอกลักษณ์?

รวมเป็นหนึ่ง ใช้ การวัดผลแบบสด และนโยบายแบบไดนามิกเพื่อปรับให้เหมาะสมสำหรับต้นทุน/ความเร็ว/คุณภาพ. หากคุณต้องการ การกำหนดเส้นทางที่ขับเคลื่อนด้วยข้อมูล ที่พัฒนาไปตามภูมิภาค/ปริมาณงาน, Unify น่าสนใจ; Requesty มุ่งเน้นไปที่การกำหนดเส้นทางและการกำกับดูแลแบบเกตเวย์.

Requesty vs Orq.ai — อันไหนสำหรับการประเมินผล & RAG?

ออร์ค.ai ให้บริการ การทดลอง/การประเมินผล พื้นผิว (รวมถึงผู้ประเมิน RAG), พร้อมการปรับใช้และ RBAC/VPC หากคุณต้องการ LLMOps + ผู้ประเมิน, Orq.ai อาจเสริมหรือแทนที่ตัวกำหนดเส้นทางในช่วงเริ่มต้น.

Requesty vs LiteLLM — โฮสต์หรือโฮสต์เอง?

คำขอ เป็นแบบโฮสต์. LiteLLM เป็น พร็อกซี/เกตเวย์แบบโฮสต์เอง ด้วย งบประมาณ & ขีดจำกัดอัตรา และ UI สำหรับผู้ดูแลระบบ; ดีมากหากคุณต้องการเก็บทราฟฟิกไว้ใน VPC ของคุณและควบคุมแผนการควบคุม.

อันไหนถูกที่สุดสำหรับปริมาณงานของฉัน: Requesty, ShareAI, OpenRouter, LiteLLM?

มันขึ้นอยู่กับ การเลือกโมเดล, ภูมิภาค, ความสามารถในการแคช, และรูปแบบการรับส่งข้อมูล. เราเตอร์เช่น ShareAI/OpenRouter สามารถลดค่าใช้จ่ายผ่านการกำหนดเส้นทางและความคงตัวที่รับรู้แคช; เกตเวย์เช่น พอร์ทคีย์ เพิ่ม การแคชเชิงความหมาย; LiteLLM ลดภาระของแพลตฟอร์มหากคุณสะดวกที่จะดำเนินการมัน เปรียบเทียบกับ คำสั่งของคุณ และติดตาม ต้นทุนต่อผลลัพธ์ที่มีประสิทธิภาพ—ไม่ใช่แค่ราคาที่ระบุไว้.

ฉันจะย้ายจาก Requesty ไปยัง ShareAI ด้วยการเปลี่ยนแปลงโค้ดให้น้อยที่สุดได้อย่างไร?

แมปโมเดลของคุณกับโมเดลที่เทียบเท่าของ ShareAI, สะท้อนรูปแบบคำขอ/การตอบกลับ, และเริ่มต้นหลัง ธงคุณสมบัติ. กำหนดเส้นทาง % ขนาดเล็กก่อน, เปรียบเทียบความหน่วง/ต้นทุน/คุณภาพ, แล้วค่อยเพิ่มขึ้น หากคุณยังดำเนินการเกตเวย์, ตรวจสอบให้แน่ใจว่า การแคช/การสำรองข้อมูล ไม่เกิดการกระตุ้นซ้ำระหว่างชั้น.

บทความนี้ครอบคลุม “ทางเลือกของ Requestly” ด้วยหรือไม่? (Requesty vs Requestly)

ใช่—Requestly (พร้อมกับ L) เป็น ชุดเครื่องมือสำหรับนักพัฒนา/QA (การสกัดกั้น HTTP, การจำลอง/ทดสอบ API, กฎ, ส่วนหัว) มากกว่าจะเป็น ตัวจัดการเส้นทาง LLM. หากคุณกำลังค้นหา ทางเลือกของ Requestly, คุณอาจกำลังเปรียบเทียบ Postman, Fiddler, mitmproxy, เป็นต้น หากคุณหมายถึง คำขอ (LLM gateway), ใช้ทางเลือกในคู่มือนี้ หากคุณต้องการสนทนาแบบสด ให้จองการประชุม: meet.growably.ro/team/shareai.

วิธีที่เร็วที่สุดในการลองใช้ ShareAI โดยไม่ต้องมีการผสานรวมเต็มรูปแบบคืออะไร?

เปิด สนามเด็กเล่น, เลือกรุ่น/ผู้ให้บริการ และรันคำสั่งในเบราว์เซอร์ เมื่อพร้อมแล้ว ให้สร้างคีย์ใน คอนโซล และวางโค้ด cURL/JS ลงในแอปของคุณ.

ฉันสามารถเป็นผู้ให้บริการ ShareAI และสร้างรายได้ได้หรือไม่?

ได้ ทุกคนสามารถเข้าร่วมเป็น ชุมชน หรือ บริษัท ผู้ให้บริการโดยใช้ Windows/Ubuntu/macOS หรือ ด็อกเกอร์. มีส่วนร่วม การประมวลผลในช่วงเวลาว่าง หรือรัน เปิดใช้งานตลอดเวลา. เลือก รางวัล (เงิน), แลกเปลี่ยน (โทเค็น/AI Prosumer), หรือ ภารกิจ (บริจาค % ให้กับองค์กรไม่แสวงหาผลกำไร) ดู คู่มือผู้ให้บริการ.

มีทางเลือก “Requesty” ที่ดีที่สุดเพียงหนึ่งเดียวหรือไม่?

ไม่มีผู้ชนะเพียงหนึ่งเดียว สำหรับทุกทีม หากคุณให้ความสำคัญกับ ความโปร่งใสของตลาด + การสำรองข้อมูลทันที + เศรษฐศาสตร์ของผู้สร้าง, เริ่มต้นด้วย แชร์เอไอ. สำหรับ มัลติโหมด เวิร์กโหลด (OCR/คำพูด/การแปล), ดูที่ อีเดน AI. หากคุณต้องการ การกำกับดูแลที่ขอบ, ประเมิน พอร์ทคีย์ หรือ คอง AI เกตเวย์. ชอบ โฮสต์ด้วยตัวเอง? พิจารณา LiteLLM.

บทสรุป

ในขณะที่ คำขอ เป็นเกตเวย์ LLM ที่แข็งแกร่ง, ตัวเลือกที่ดีที่สุดของคุณขึ้นอยู่กับลำดับความสำคัญ:

- ความโปร่งใสของตลาด + ความยืดหยุ่น: แชร์เอไอ

- การครอบคลุมหลายรูปแบบภายใต้ API เดียว: อีเดน AI

- การกำหนดเส้นทางที่คำนึงถึงแคชในรูปแบบโฮสต์: OpenRouter

- นโยบาย/ข้อกำหนดที่ขอบ: พอร์ทคีย์ หรือ คอง AI เกตเวย์

- การกำหนดเส้นทางที่ขับเคลื่อนด้วยข้อมูล: รวมเป็นหนึ่ง

- LLMOps + ผู้ประเมิน: ออร์ค.ai

- แผงควบคุมแบบโฮสต์เอง: LiteLLM

หากเลือกผู้ให้บริการโดย ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งานก่อนแต่ละเส้นทาง, การเปลี่ยนไปใช้ระบบสำรองทันที, และ เศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง อยู่ในรายการตรวจสอบของคุณ ให้เปิด สนามเด็กเล่น, สร้างคีย์ API, และเรียกดู ตลาดโมเดล เพื่อกำหนดเส้นทางคำขอถัดไปของคุณอย่างชาญฉลาด.