ทางเลือก Orq AI Proxy 2026: 10 อันดับแรก

อัปเดต กุมภาพันธ์ 2026

หากคุณกำลังค้นคว้า ทางเลือกของ Orq AI Proxy, คู่มือนี้แสดงภาพรวมเหมือนที่ผู้สร้างจะทำ เราจะกำหนดอย่างรวดเร็วว่า Orq อยู่ตรงไหน (พร็อกซีที่เน้นการจัดการที่ช่วยทีมย้ายจากการทดลองไปสู่การผลิตด้วยกระบวนการที่ร่วมมือกัน) จากนั้นเปรียบเทียบ 10 ทางเลือกที่ดีที่สุด ในด้านการรวมข้อมูล, เกตเวย์, และการจัดการ เราวาง แชร์เอไอ อันดับแรกสำหรับทีมที่ต้องการ API เดียวที่ครอบคลุมผู้ให้บริการหลายราย, สัญญาณตลาดที่โปร่งใส (ราคา, ความหน่วง, เวลาทำงาน, ความพร้อมใช้งาน, ประเภทผู้ให้บริการ) ก่อนการกำหนดเส้นทาง, การเปลี่ยนไปใช้ระบบสำรองทันที, และ เศรษฐศาสตร์ที่ขับเคลื่อนด้วยคน (ผู้ให้บริการ—ชุมชนหรือบริษัท—ได้รับรายได้ส่วนใหญ่เมื่อพวกเขารักษาโมเดลให้ออนไลน์).

Orq AI Proxy คืออะไร (และไม่ใช่อะไร)

Orq AI Proxy อยู่ใน แพลตฟอร์มที่เน้นการจัดการเป็นหลัก มันเน้น การทำงานร่วมกัน, กระบวนการ, และการนำต้นแบบไปสู่การผลิต. คุณจะพบเครื่องมือสำหรับการประสานงานงานหลายขั้นตอน, การวิเคราะห์เกี่ยวกับการทำงาน, และพร็อกซีที่ทำให้ทีมสามารถส่งงานได้ง่ายขึ้น ซึ่งแตกต่างจาก ตลาดโมเดลที่โปร่งใส: การมองเห็นก่อนการกำหนดเส้นทางใน ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน ผ่าน ผู้ให้บริการหลายราย—รวมถึง การกำหนดเส้นทางอัจฉริยะและการแก้ไขข้อผิดพลาดทันที—คือที่ที่ API หลายผู้ให้บริการเช่น แชร์เอไอ โดดเด่น.

สรุป:

- การจัดการแบบลำดับแรก (Orq): ส่งเวิร์กโฟลว์, จัดการการทำงาน, ร่วมมือ—มีประโยชน์หากความต้องการหลักของคุณคือเครื่องมือการไหล.

- ตลาดกลางแบบลำดับแรก (ShareAI): เลือก ผู้ให้บริการ/โมเดลที่เหมาะสมที่สุด ด้วย สัญญาณสด และ ความยืดหยุ่นอัตโนมัติ—มีประโยชน์หากความต้องการหลักของคุณคือ การกำหนดเส้นทางข้ามผู้ให้บริการ โดยไม่มีการล็อกอิน.

ตัวรวบรวม vs. เกตเวย์ vs. แพลตฟอร์มการจัดการ

ตัวรวบรวม LLM (เช่น ShareAI, OpenRouter, Eden AI): API เดียวที่ครอบคลุมผู้ให้บริการ/โมเดลหลายราย ด้วย ShareAI คุณสามารถ เปรียบเทียบราคา, ความหน่วง, ความพร้อมใช้งาน, ประเภทผู้ให้บริการก่อนการกำหนดเส้นทาง, จากนั้น เปลี่ยนไปยังผู้ให้บริการอื่นได้ทันที หากผู้ให้บริการลดคุณภาพลง.

เกตเวย์ AI (เช่น Kong, Portkey, Traefik, Apigee, NGINX): นโยบาย/การกำกับดูแล ที่ขอบ (ข้อมูลรับรองแบบรวมศูนย์, WAF/ข้อจำกัดอัตรา/รางป้องกัน), บวก การสังเกตการณ์. โดยปกติคุณ นำผู้ให้บริการของคุณเองมาใช้.

แพลตฟอร์มการจัดการ (เช่น Orq, Unify; LiteLLM หากเป็นพร็อกซีแบบโฮสต์เอง): มุ่งเน้นที่ กระบวนการ, เครื่องมือ, และบางครั้ง การเลือกคุณภาพ—ช่วยให้ทีมจัดโครงสร้างคำสั่ง, เครื่องมือ, และการประเมินผล.

ใช้ร่วมกันเมื่อมีประโยชน์: หลายทีม เก็บเกตเวย์ไว้สำหรับนโยบายทั่วทั้งองค์กร ในขณะที่ การกำหนดเส้นทางผ่าน ShareAI เพื่อความโปร่งใสและความยืดหยุ่นของตลาด.

วิธีที่เราประเมินทางเลือกที่ดีที่สุดสำหรับ Orq AI Proxy

- ความหลากหลายและความเป็นกลางของโมเดล: เป็นกรรมสิทธิ์ + เปิด; ง่ายต่อการเปลี่ยน; การเขียนซ้ำให้น้อยที่สุด.

- ความหน่วงและความยืดหยุ่น: นโยบายการกำหนดเส้นทาง, การหมดเวลา/การลองใหม่, การเปลี่ยนไปใช้ระบบสำรองทันที.

- การกำกับดูแลและความปลอดภัย: การจัดการคีย์, ขอบเขต, การกำหนดเส้นทางตามภูมิภาค.

- การสังเกตการณ์: บันทึก/การติดตามและแดชบอร์ดต้นทุน/ความหน่วง.

- ความโปร่งใสด้านการกำหนดราคา & TCO: ดู ต้นทุนจริง/การแลกเปลี่ยน UX ก่อนที่คุณจะกำหนดเส้นทาง.

- ประสบการณ์ของนักพัฒนา: เอกสาร, SDKs, quickstarts; เวลาสำหรับโทเค็นแรก.

- ชุมชน & เศรษฐศาสตร์: การใช้จ่ายของคุณช่วยเพิ่มอุปทาน (แรงจูงใจสำหรับเจ้าของ/ผู้ให้บริการ GPU) หรือไม่?

10 อันดับทางเลือก Orq AI Proxy

#1 — ShareAI (API AI ที่ขับเคลื่อนโดยผู้คน)

มันคืออะไร. A API หลายผู้ให้บริการ พร้อมกับ ตลาดที่โปร่งใส และ การกำหนดเส้นทางอัจฉริยะ. ด้วยการผสานรวมเพียงครั้งเดียว, เรียกดู แคตตาล็อกขนาดใหญ่ของโมเดลและผู้ให้บริการ, เปรียบเทียบ ราคา, ความหน่วง, ความพร้อมใช้งาน, ประเภทผู้ให้บริการ, และ กำหนดเส้นทางด้วยการสำรองข้อมูลทันที. เศรษฐศาสตร์ขับเคลื่อนโดยผู้คน: ผู้ให้บริการ (ชุมชนหรือบริษัท) ได้รับรายได้ส่วนใหญ่จากการใช้จ่าย เมื่อพวกเขาเก็บโมเดลออนไลน์.

ทำไมมันถึงเป็น #1 ที่นี่. หากคุณต้องการ การรวมแบบไม่ยึดติดกับผู้ให้บริการ ด้วย ความโปร่งใสก่อนการกำหนดเส้นทาง และ ความยืดหยุ่น, ShareAI เป็นตัวเลือกที่ตรงที่สุด เก็บเกตเวย์ไว้หากคุณต้องการนโยบายระดับองค์กร; เพิ่ม แชร์เอไอ สำหรับการกำหนดเส้นทางที่แนะนำโดยตลาดและการเพิ่มเวลาทำงาน/ลดความหน่วง.

- API เดียว → โมเดลกว่า 150+ จากผู้ให้บริการหลายราย; ไม่ต้องเขียนใหม่ ไม่มีการผูกมัด.

- ตลาดที่โปร่งใส: เลือกโดย ราคา, ความหน่วง, ความพร้อมใช้งาน, ประเภทผู้ให้บริการ.

- ความยืดหยุ่นโดยค่าเริ่มต้น: นโยบายการกำหนดเส้นทาง + การเปลี่ยนไปใช้ระบบสำรองทันที.

- เศรษฐศาสตร์ที่เป็นธรรม: ขับเคลื่อนโดยผู้คน—ผู้ให้บริการได้รับรายได้ เมื่อพวกเขาเก็บโมเดลให้พร้อมใช้งาน.

ลิงก์ด่วน:

สำหรับผู้ให้บริการ: รับรายได้โดยการรักษาโมเดลออนไลน์

ใครๆ ก็สามารถเป็นผู้ให้บริการ ShareAI ได้—ชุมชน หรือ บริษัท. เข้าร่วมผ่าน Windows, Ubuntu, macOS, หรือ Docker. มีส่วนร่วม การประมวลผลในช่วงเวลาว่าง หรือรัน เปิดใช้งานตลอดเวลา. เลือกรางวัลของคุณ: รางวัล (เงิน), แลกเปลี่ยน (โทเค็น/AI Prosumer), หรือ ภารกิจ (บริจาค % ให้กับ NGOs) เมื่อคุณขยายตัว, ตั้งราคาการประมวลผลของคุณเอง และได้รับ การเปิดเผยที่เป็นพิเศษ.

#2 — OpenRouter

มันคืออะไร. A API แบบรวม ครอบคลุมหลายโมเดล; เหมาะสำหรับการทดลองอย่างรวดเร็วในแคตตาล็อกที่หลากหลาย.

เมื่อไหร่ควรเลือก. หากคุณต้องการเข้าถึงโมเดลที่หลากหลายอย่างรวดเร็วด้วยการตั้งค่าที่น้อยที่สุด.

เปรียบเทียบกับ ShareAI. ShareAI เพิ่ม ความโปร่งใสของตลาดก่อนการกำหนดเส้นทาง และ การเปลี่ยนไปใช้ระบบสำรองทันที ข้ามผู้ให้บริการหลายราย.

#3 — พอร์ทคีย์

มันคืออะไร. หนึ่ง เกตเวย์ AI เน้นย้ำ การสังเกตการณ์, การป้องกัน, และการกำกับดูแล.

เมื่อไหร่ควรเลือก. สภาพแวดล้อมที่มีการควบคุมซึ่งต้องการการควบคุมนโยบาย/รั้วป้องกันอย่างลึกซึ้ง.

เปรียบเทียบกับ ShareAI. ShareAI มุ่งเน้นที่ การกำหนดเส้นทางหลายผู้ให้บริการ + ความโปร่งใสของตลาด; จับคู่กับเกตเวย์หากคุณต้องการนโยบายทั่วทั้งองค์กร.

#4 — เกตเวย์ Kong AI

มันคืออะไร. หนึ่ง เกตเวย์สำหรับองค์กร: นโยบาย/ปลั๊กอิน, การวิเคราะห์, และการกำกับดูแลขอบเขตสำหรับทราฟฟิก AI.

เมื่อไหร่ควรเลือก. หากองค์กรของคุณใช้งาน Kong อยู่แล้วหรือจำเป็นต้องมีการกำกับดูแล API ที่สมบูรณ์.

เปรียบเทียบกับ ShareAI. เพิ่ม ShareAI สำหรับ การเลือกผู้ให้บริการที่โปร่งใส และ การสำรองข้อมูล; เก็บ Kong ไว้สำหรับ แผงควบคุม.

#5 — อีเดนเอไอ

มันคืออะไร. หนึ่ง ตัวรวบรวม สำหรับ LLMs และบริการ AI ที่กว้างขึ้น (การมองเห็น, TTS, การแปลภาษา).

เมื่อไหร่ควรเลือก. หากคุณต้องการ AI หลายรูปแบบอยู่เบื้องหลังคีย์เดียว.

เปรียบเทียบกับ ShareAI. ShareAI เชี่ยวชาญใน ความโปร่งใสของตลาด สำหรับ การกำหนดเส้นทางโมเดล ข้ามผู้ให้บริการ.

#6 — LiteLLM

มันคืออะไร. A SDK น้ำหนักเบา + พร็อกซีที่สามารถโฮสต์เองได้ ที่รองรับอินเทอร์เฟซที่เข้ากันได้กับ OpenAI สำหรับผู้ให้บริการหลายราย.

เมื่อไหร่ควรเลือก. ทีม DIY ที่ต้องการพร็อกซีในพื้นที่ที่พวกเขาดำเนินการเอง.

เปรียบเทียบกับ ShareAI. ShareAI คือ การจัดการ ด้วย ข้อมูลตลาด และ การสำรองข้อมูล; เก็บ LiteLLM สำหรับการพัฒนาหากต้องการ.

#7 — Unify

มันคืออะไร. การเลือกที่มุ่งเน้นคุณภาพ และการประเมินเพื่อเลือกโมเดลที่ดีกว่าสำหรับแต่ละคำสั่ง.

เมื่อไหร่ควรเลือก. หากคุณต้องการ การกำหนดเส้นทางที่ขับเคลื่อนด้วยการประเมิน.

เปรียบเทียบกับ ShareAI. ShareAI เพิ่ม สัญญาณตลาดสด และ การเปลี่ยนไปใช้ระบบสำรองทันที ข้ามผู้ให้บริการหลายราย.

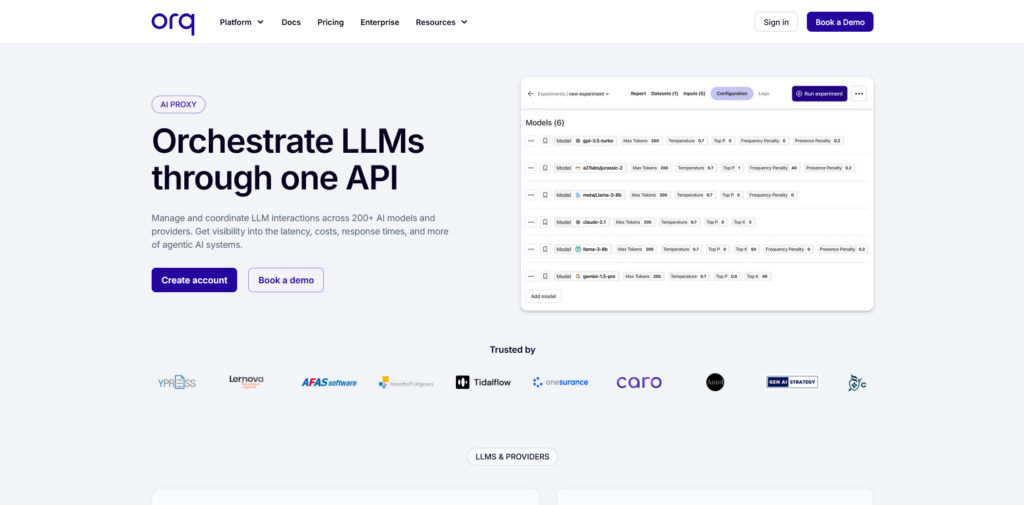

#8 — Orq (แพลตฟอร์ม)

มันคืออะไร. การจัดการ/การทำงานร่วมกัน แพลตฟอร์มที่ช่วยทีมย้ายจากการทดลองไปสู่การผลิตด้วย โฟลว์แบบโค้ดต่ำ.

เมื่อไหร่ควรเลือก. หากความต้องการหลักของคุณคือ การจัดการกระบวนการทำงาน และการทำงานร่วมกันของทีม.

เปรียบเทียบกับ ShareAI. ShareAI คือ การกำหนดเส้นทางที่ไม่ขึ้นกับผู้ให้บริการ ด้วย ความโปร่งใสก่อนการกำหนดเส้นทาง และ การสำรองข้อมูล; หลายทีม จับคู่ Orq กับ ShareAI.

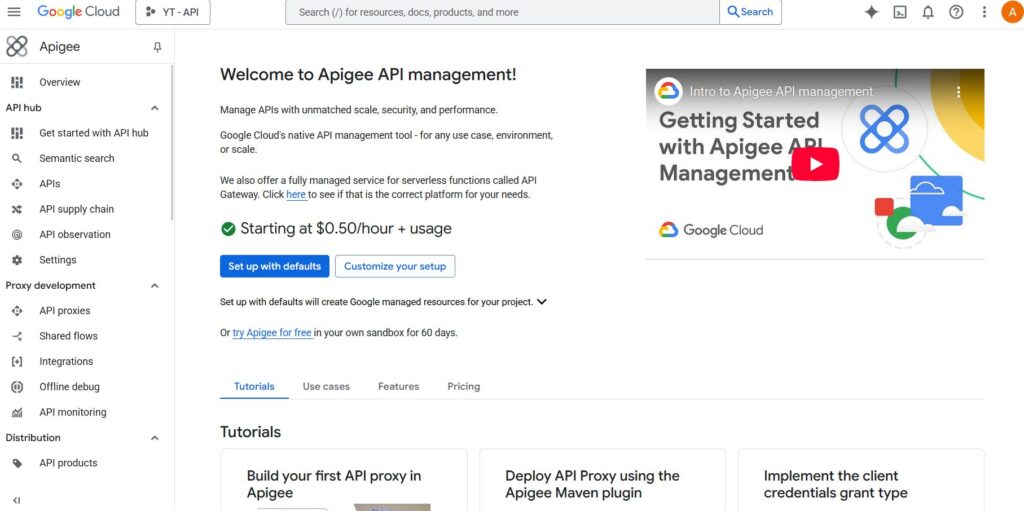

#9 — Apigee (พร้อม LLM backends)

มันคืออะไร. A การจัดการ API ที่มีความสมบูรณ์ แพลตฟอร์มที่คุณสามารถวางไว้หน้าผู้ให้บริการ LLM เพื่อใช้ นโยบาย, คีย์, โควตา.

เมื่อไหร่ควรเลือก. องค์กรระดับองค์กรที่มาตรฐานบน Apigee สำหรับการควบคุม API.

เปรียบเทียบกับ ShareAI. เพิ่ม ShareAI เพื่อรับ การเลือกผู้ให้บริการที่โปร่งใส และ การเปลี่ยนไปใช้ระบบสำรองทันที.

#10 — NGINX (DIY)

มันคืออะไร. A ขอบเขตที่คุณทำเอง: เผยแพร่เส้นทาง, การบังคับใช้โทเค็น, การแคชด้วยตรรกะที่กำหนดเอง.

เมื่อไหร่ควรเลือก. หากคุณชอบ ทำเองทั้งหมด และมีแบนด์วิดท์สำหรับการดำเนินงาน.

เปรียบเทียบกับ ShareAI. การจับคู่กับ ShareAI ช่วยหลีกเลี่ยงตรรกะเฉพาะสำหรับ การเลือกผู้ให้บริการ และ การสำรองข้อมูล.

Orq AI Proxy กับ ShareAI (ดูอย่างรวดเร็ว)

หากคุณต้องการ API เดียวสำหรับผู้ให้บริการหลายราย ด้วย ราคาที่โปร่งใส/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน และ การเปลี่ยนไปใช้ระบบสำรองทันที, เลือก แชร์เอไอ. หากความต้องการสูงสุดของคุณคือ การจัดการและการทำงานร่วมกัน—กระบวนการ, งานหลายขั้นตอน, และการผลิตที่เน้นทีม—Orq เหมาะสมกับเส้นทางนั้น ทีมงานหลายทีม จับคู่พวกเขา: การจัดการภายใน Orq + การกำหนดเส้นทางที่แนะนำโดยตลาดใน ShareAI.

การเปรียบเทียบอย่างรวดเร็ว

| แพลตฟอร์ม | ใครที่มันให้บริการ | ความกว้างของโมเดล | การกำกับดูแล & ความปลอดภัย | การสังเกตการณ์ | การกำหนดเส้นทาง / การสำรองข้อมูล | ความโปร่งใสของตลาด | โปรแกรมผู้ให้บริการ |

|---|---|---|---|---|---|---|---|

| แชร์เอไอ | ทีมผลิตภัณฑ์/แพลตฟอร์มที่ต้องการ API เดียว + เศรษฐศาสตร์ที่เป็นธรรม | โมเดลกว่า 150+, ผู้ให้บริการหลายราย | คีย์ API & การควบคุมต่อเส้นทาง | การใช้งานคอนโซล + สถิติของตลาด | การกำหนดเส้นทางอัจฉริยะ + การสลับสำรองทันที | ราคา, ความหน่วง, ความพร้อมใช้งาน, ประเภทผู้ให้บริการ | ใช่—ซัพพลายแบบเปิด; ผู้ให้บริการได้รับ |

| Orq (พร็อกซี) | ทีมที่เน้นการจัดการระบบ | การสนับสนุนที่กว้างขวางผ่านโฟลว์ | การควบคุมแพลตฟอร์ม | รันการวิเคราะห์ | เน้นการจัดการประสานงาน | ไม่ใช่ตลาดกลาง | ไม่มี |

| OpenRouter | นักพัฒนาที่ต้องการคีย์เดียว | แคตตาล็อกที่กว้าง | การควบคุม API ขั้นพื้นฐาน | ฝั่งแอป | การสำรองข้อมูล | บางส่วน | ไม่มี |

| พอร์ทคีย์ | ทีมที่มีการควบคุม/องค์กร | กว้าง | รั้วป้องกัน & การกำกับดูแล | การติดตามเชิงลึก | การกำหนดเส้นทางตามเงื่อนไข | บางส่วน | ไม่มี |

| คอง AI เกตเวย์ | องค์กรที่ต้องการนโยบายเกตเวย์ | นำมาเอง | นโยบาย/ปลั๊กอินที่แข็งแกร่ง | การวิเคราะห์ | พร็อกซี/ปลั๊กอิน, การลองใหม่ | ไม่ (เครื่องมือโครงสร้างพื้นฐาน) | ไม่มี |

| อีเดน AI | ทีมที่ต้องการ LLM + บริการ AI อื่น ๆ | กว้าง | การควบคุมมาตรฐาน | แตกต่างกัน | การสำรองข้อมูล/การแคช | บางส่วน | ไม่มี |

| LiteLLM | ทำเอง/โฮสต์พร็อกซีด้วยตัวเอง | ผู้ให้บริการหลายราย | การกำหนดค่า/ข้อจำกัดของคีย์ | โครงสร้างพื้นฐานของคุณ | การลองใหม่/การสำรองข้อมูล | ไม่มี | ไม่มี |

| รวมเป็นหนึ่ง | ทีมที่มุ่งเน้นคุณภาพ | หลายโมเดล | ความปลอดภัย API มาตรฐาน | การวิเคราะห์แพลตฟอร์ม | การเลือกโมเดลที่ดีที่สุด | ไม่มี | ไม่มี |

| Apigee / NGINX | องค์กร / DIY | นำมาเอง | นโยบาย | ส่วนเสริม / กำหนดเอง | กำหนดเอง | ไม่มี | ไม่มี |

การกำหนดราคา & TCO: เปรียบเทียบต้นทุนจริง (ไม่ใช่แค่ราคาต่อหน่วย)

ดิบ $/1K tokens ซ่อนภาพจริง. ต้นทุนรวมในการเป็นเจ้าของ (TCO) เปลี่ยนแปลงด้วย การลองใหม่/การสำรองข้อมูล, ความหน่วง (ซึ่งส่งผลต่อการใช้งานของผู้ใช้ปลายทาง), ความแปรปรวนของผู้ให้บริการ, การจัดเก็บข้อมูลการสังเกตการณ์, และ การประเมินผลการทำงาน. หนึ่ง ตลาดที่โปร่งใส ช่วยให้คุณเลือก เส้นทาง ที่สมดุล ค่าใช้จ่าย และ UX.

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))

- ต้นแบบ (~10k tokens/วัน): ปรับให้เหมาะสมสำหรับ เวลาในการรับโทเค็นครั้งแรก (Playground, quickstarts).

- ขนาดกลาง (~2M tokens/วัน): การกำหนดเส้นทางที่นำโดยตลาดกลาง + การสำรองข้อมูล สามารถตัดแต่งได้ 10–20% ในขณะที่ปรับปรุง UX.

- งานที่มีความแปรปรวนสูง: คาดหวังสูงขึ้น มีประสิทธิภาพ ค่าใช้จ่ายโทเค็นจากการลองใหม่ระหว่างการเปลี่ยนไปใช้ระบบสำรอง; งบประมาณ สำหรับมัน.

คู่มือการย้าย: การย้ายไปยัง ShareAI

จาก Orq

เก็บการจัดการของ Orq ไว้ในจุดที่มันโดดเด่น; เพิ่ม ShareAI สำหรับ การกำหนดเส้นทางที่ไม่ขึ้นกับผู้ให้บริการ และ การเลือกที่โปร่งใส. รูปแบบ: การจัดการ → เส้นทาง ShareAI ต่อโมเดล → สังเกตสถิติของตลาด → เข้มงวดนโยบาย.

จาก OpenRouter

จับคู่ชื่อโมเดล, ตรวจสอบความเท่าเทียมของคำสั่ง, จากนั้น เงา 10% ของการจราจรและการเพิ่มขึ้น 25% → 50% → 100% เมื่อความล่าช้า/งบประมาณข้อผิดพลาดยังคงอยู่ ข้อมูลตลาดทำให้ การเปลี่ยนผู้ให้บริการ ตรงไปตรงมา.

จาก LiteLLM

แทนที่พร็อกซีที่โฮสต์เองบนเส้นทางการผลิตที่คุณไม่ต้องการดำเนินการ; เก็บ LiteLLM สำหรับการพัฒนาหากต้องการ เปรียบเทียบ ภาระงานด้านปฏิบัติการ เทียบกับ. ประโยชน์ของการจัดการเส้นทาง.

จาก Unify / Portkey / Kong / Traefik / Apigee / NGINX

กำหนดความคาดหวังของความเท่าเทียมของฟีเจอร์ (การวิเคราะห์, การป้องกัน, การจัดการ, ปลั๊กอิน) หลายทีมดำเนินการแบบไฮบริด: รักษาฟีเจอร์เฉพาะที่ที่พวกเขาแข็งแกร่งที่สุด; ใช้ แชร์เอไอ สำหรับ การเลือกผู้ให้บริการที่โปร่งใส + การเปลี่ยนไปใช้ระบบสำรอง.

การเริ่มต้นอย่างรวดเร็วสำหรับนักพัฒนา (คัดลอก-วาง)

ต่อไปนี้ใช้ พื้นผิวที่เข้ากันได้กับ OpenAI. แทนที่ YOUR_KEY ด้วยคีย์ ShareAI ของคุณ—รับได้ที่ สร้างคีย์ API.

#!/usr/bin/env bash"// JavaScript (fetch) — Node 18+/Edge runtimes;รายการตรวจสอบด้านความปลอดภัย ความเป็นส่วนตัว และการปฏิบัติตามข้อกำหนด (ไม่ขึ้นกับผู้ให้บริการ)

- การจัดการคีย์: ความถี่ในการหมุน; ขอบเขตขั้นต่ำ; การแยกสภาพแวดล้อม.

- การเก็บรักษาข้อมูล: ที่ที่เก็บคำถาม/คำตอบ และนานแค่ไหน; การตั้งค่าการลบข้อมูลเริ่มต้น.

- PII & เนื้อหาที่ละเอียดอ่อน: การปิดบัง; การควบคุมการเข้าถึง; การกำหนดเส้นทางตามภูมิภาค สำหรับการตั้งถิ่นฐานข้อมูลในท้องถิ่น.

- การสังเกตการณ์: การบันทึกคำถาม/คำตอบ; ความสามารถในการ กรองหรือทำให้เป็นนามแฝง; เผยแพร่ Trace IDs อย่างสม่ำเสมอ.

- การตอบสนองต่อเหตุการณ์: เส้นทางการยกระดับและ SLA ของผู้ให้บริการ.

FAQ — Orq AI Proxy กับคู่แข่งอื่น ๆ

Orq AI Proxy กับ ShareAI — อันไหนเหมาะสำหรับการกำหนดเส้นทางหลายผู้ให้บริการ?

แชร์เอไอ. มันถูกสร้างขึ้นสำหรับ ความโปร่งใสของตลาด (ราคา, ความหน่วง, เวลาทำงาน, ความพร้อมใช้งาน, ประเภทผู้ให้บริการ) และ การกำหนดเส้นทางอัจฉริยะ/การสำรองข้อมูล ข้ามผู้ให้บริการหลายราย. Orq มุ่งเน้นไปที่ การจัดการและการทำงานร่วมกัน. หลายทีมดำเนินการ Orq + ShareAI ร่วมกัน.

Orq AI Proxy กับ OpenRouter — การเข้าถึงหลายโมเดลอย่างรวดเร็วหรือความโปร่งใสของตลาด?

OpenRouter ทำให้ การเข้าถึงหลายโมเดล รวดเร็ว; แชร์เอไอ ชั้นใน ความโปร่งใสก่อนการกำหนดเส้นทาง และ การเปลี่ยนไปใช้ระบบสำรองทันที ข้ามผู้ให้บริการ.

Orq AI Proxy กับ Portkey — การป้องกัน/การกำกับดูแลหรือการกำหนดเส้นทางตลาด?

Portkey เน้น การกำกับดูแล & การสังเกตการณ์. หากคุณต้องการ การเลือกผู้ให้บริการที่โปร่งใส และ การสำรองข้อมูล ด้วย API เดียว, เลือก แชร์เอไอ (และคุณยังสามารถเก็บเกตเวย์ไว้ได้).

Orq AI Proxy กับ Kong AI Gateway — การควบคุมเกตเวย์หรือการมองเห็นตลาด?

Kong รวมศูนย์ นโยบาย/ปลั๊กอิน; แชร์เอไอ ให้ การกำหนดเส้นทางที่ไม่ขึ้นกับผู้ให้บริการ ด้วย สถิติของตลาดแบบเรียลไทม์—มักจับคู่กัน.

Orq AI Proxy เทียบกับ Traefik AI Gateway — ชั้น AI บางหรือการกำหนดเส้นทางตลาด?

ชั้น AI ของ Traefik เพิ่ม มิดเดิลแวร์เฉพาะ AI และ การสังเกตการณ์ที่เป็นมิตรกับ OTel. สำหรับ การเลือกผู้ให้บริการที่โปร่งใส และ การเปลี่ยนไปใช้ระบบสำรองทันที, ใช้ แชร์เอไอ.

Orq AI Proxy เทียบกับ Eden AI — บริการ AI หลายอย่างหรือความเป็นกลางของผู้ให้บริการ?

Eden รวมบริการ AI หลายอย่าง. แชร์เอไอ มุ่งเน้นไปที่ การกำหนดเส้นทางโมเดลที่เป็นกลาง ด้วย ความโปร่งใสก่อนการกำหนดเส้นทาง.

Orq AI Proxy เทียบกับ LiteLLM — โพร็อกซีโฮสต์เองหรือการจัดการตลาด?

LiteLLM คือ ทำเอง; แชร์เอไอ คือ การจัดการ ด้วย ข้อมูลตลาด และ การสำรองข้อมูล. เก็บ LiteLLM ไว้สำหรับการพัฒนาหากคุณต้องการ.

Orq AI Proxy เทียบกับ Unify — การเลือกโมเดลที่ขับเคลื่อนด้วยการประเมินหรือการกำหนดเส้นทางตลาด?

Unify เน้นไปที่ การประเมินคุณภาพ; แชร์เอไอ เพิ่ม สัญญาณราคาสด/ความหน่วง/เวลาทำงาน และ การเปลี่ยนไปใช้ระบบสำรองทันที ข้ามผู้ให้บริการ.

Orq AI Proxy กับ Apigee — การจัดการ API หรือการกำหนดเส้นทางที่ไม่ขึ้นกับผู้ให้บริการ?

Apigee คือ การจัดการ API ที่ครอบคลุม. แชร์เอไอ มี การกำหนดเส้นทางแบบโปร่งใสและรองรับหลายผู้ให้บริการ คุณสามารถวาง ไว้ด้านหลัง เกตเวย์ของคุณ.

Orq AI Proxy กับ NGINX — ขอบเขต DIY หรือการกำหนดเส้นทางแบบจัดการ?

NGINX มี ตัวกรอง/นโยบายแบบ DIY. แชร์เอไอ หลีกเลี่ยงตรรกะที่กำหนดเองสำหรับ การเลือกผู้ให้บริการ และ การสำรองข้อมูล.

Orq AI Proxy กับ Apache APISIX — ระบบนิเวศปลั๊กอินหรือความโปร่งใสของตลาด?

APISIX นำเสนอ เกตเวย์ที่เต็มไปด้วยปลั๊กอิน. แชร์เอไอ นำเสนอ การมองเห็นผู้ให้บริการ/โมเดลก่อนการกำหนดเส้นทาง และ การกำหนดเส้นทางที่มีความยืดหยุ่น. ใช้ทั้งสองอย่างถ้าคุณต้องการ นโยบายที่ขอบ และ การเข้าถึงผู้ให้บริการหลายรายอย่างโปร่งใส.