ตัวเลือกแทน RouteLLM Alternatives 2026: เมื่อควรเลือก ShareAI (และสิ่งอื่นที่ควรพิจารณา)

อัปเดต กุมภาพันธ์ 2026

นักพัฒนาซอฟต์แวร์เลือก เส้นทางLLM เพื่อกำหนดเส้นทางคำสั่งไปยังโมเดลที่มีราคาถูกกว่าในขณะที่ยังคงคุณภาพใกล้เคียง GPT-4—โดยเฉพาะสำหรับงานที่คล้ายกับการทดสอบมาตรฐานที่ตัวกำหนดเส้นทางที่เรียนรู้สามารถลดระดับได้อย่างมั่นใจ แต่ถ้าคุณให้ความสำคัญกับ ความโปร่งใสของตลาดก่อนแต่ละเส้นทาง (ราคาสด, ความหน่วงเวลา, ความพร้อมใช้งาน, การเข้าถึง), การเปลี่ยนเส้นทางทันทีระหว่างผู้ให้บริการหลายราย, นโยบายขอบและการตรวจสอบ, หรือ พร็อกซี/เกตเวย์แบบโฮสต์เอง, หนึ่งใน ทางเลือกของ RouteLLM อาจเหมาะกับสแต็กของคุณมากกว่า.

คู่มือสำหรับผู้ซื้อฉบับนี้เขียนเหมือนที่ผู้สร้างจะเขียน: การแลกเปลี่ยนเฉพาะ, ตัวเลือกที่รวดเร็ว, การเจาะลึก, การเปรียบเทียบแบบเคียงข้างกัน, และการเริ่มต้นใช้งาน ShareAI แบบคัดลอกและวางเพื่อให้คุณสามารถเริ่มต้นใช้งานได้ทันที.

การทำความเข้าใจ RouteLLM (และที่ที่มันอาจไม่เหมาะสม)

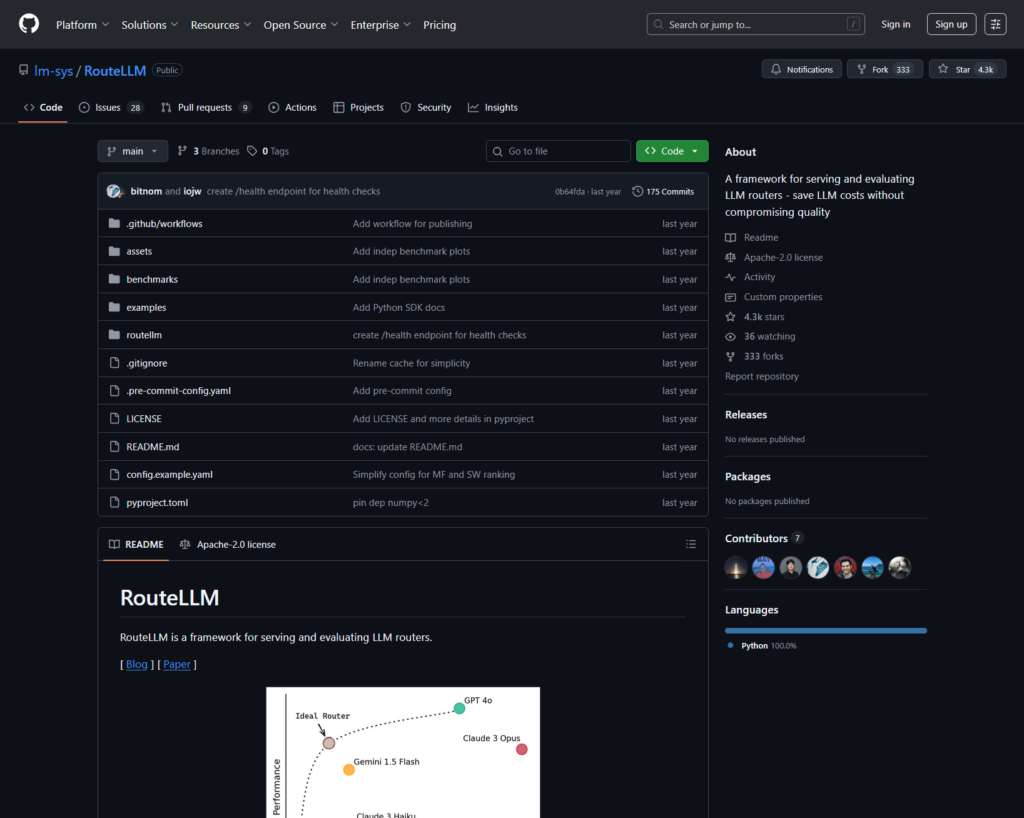

RouteLLM คืออะไร. RouteLLM เป็นเฟรมเวิร์กโอเพ่นซอร์สสำหรับการให้บริการและการประเมินตัวกำหนดเส้นทาง LLM มันมีไคลเอนต์/เซิร์ฟเวอร์ที่เข้ากันได้กับ OpenAI และจัดส่งโมเดลการกำหนดเส้นทางที่ได้รับการฝึกฝนซึ่งสามารถกำหนดเส้นทางคำถามที่ง่ายกว่าไปยังโมเดลที่มีราคาถูกกว่า—รายงานว่าลดต้นทุนได้ถึง 85% ในขณะที่ยังคงประสิทธิภาพ ~95% ของ GPT-4 ในการทดสอบมาตรฐานทั่วไป (เช่น MT-Bench).

ทำไมทีมถึงเลือกมัน.

- การกำหนดเส้นทางที่คำนึงถึงต้นทุน ด้วยนโยบายที่ได้รับการสนับสนุนจากการวิจัย.

- โอเพ่นซอร์ส และสามารถขยายได้ใน Python.

- เข้ากันได้กับ OpenAI เส้นทางสู่การทดลองการกำหนดเส้นทางโดยไม่ต้องเขียน SDK ใหม่อย่างหนัก.

สถานที่ที่ RouteLLM อาจไม่เหมาะสม.

- คุณต้องการ ความโปร่งใสของตลาดสด (ราคา, ความหน่วงเวลา, ความพร้อมใช้งาน, การเข้าถึง) ก่อนแต่ละเส้นทาง—ไม่ใช่แค่การเรียนรู้เชิงนโยบาย.

- คุณต้องการ การสำรองข้อมูลหลายผู้ให้บริการ

- แผนงานของคุณครอบคลุม API หลายรูปแบบ เช่น OCR, การพูด, การแปลภาษา และการแยกวิเคราะห์เอกสารในที่เดียว.

วิธีเลือกทางเลือก RouteLLM

- ต้นทุนรวมในการเป็นเจ้าของ (TCO). อย่าหยุดที่ $/1K tokens นับอัตราการเข้าถึงแคช, การลองใหม่/การสำรอง, การจัดคิว, ค่าใช้จ่ายของผู้ประเมิน และภาระงานของบันทึก/การแจ้งเตือน ตัวจัดการเส้นทางและเกตเวย์ที่รับรู้แคชพร้อมแคชเชิงความหมายสามารถทำให้ “ราคาที่แพงกว่าในรายการ” ถูกลงในทางปฏิบัติ.

- ความหน่วงและความน่าเชื่อถือ. เลือกการจัดเส้นทางที่รับรู้ภูมิภาค, ความยึดติดกับผู้ให้บริการเมื่อแคชอุ่น และการสำรองที่แม่นยำ (ลองใหม่ 429s, เพิ่มระดับเมื่อหมดเวลา) ตัวจัดการเส้นทางที่โฮสต์ซึ่งทำให้คุณอยู่กับผู้ให้บริการเดียวกันสำหรับบริบทที่อุ่นและสำรองเมื่อผู้ให้บริการมีปัญหามักจะชนะ.

- การสังเกตและการกำกับดูแล. หากรั้วป้องกัน, การลบข้อมูล, บันทึกการตรวจสอบ และนโยบายที่ขอบมีความสำคัญ เกตเวย์ AI (Portkey หรือ Kong AI Gateway) มักจะแข็งแกร่งกว่าตัวจัดการเส้นทางเพียงอย่างเดียว หลายทีมจับคู่ตัวจัดการเส้นทาง + เกตเวย์.

- โฮสต์เอง vs. การจัดการ. ชอบ Docker/K8s/Helm และพร็อกซีที่เข้ากันได้กับ OpenAI? ลอง LiteLLM ต้องการความเร็วที่โฮสต์ + การมองเห็นตลาด? พิจารณา ShareAI หรือ OpenRouter.

- ความหลากหลายเกินกว่าการแชท. หากคุณต้องการ OCR, การพูด, การแปลภาษา หรือการแยกวิเคราะห์เอกสารควบคู่กับการสนทนา LLM ตัวจัดการหลายรูปแบบเช่น Eden AI จะช่วยได้.

- การกำหนดเส้นทางด้วยข้อมูล. หากคุณชอบการวัดผลแบบสดเพื่อกำหนดต้นทุน/ความเร็ว/คุณภาพตามภูมิภาคหรือปริมาณงาน ให้ประเมิน Unify.

ทางเลือกที่ดีที่สุดสำหรับ RouteLLM (ตัวเลือกด่วน)

ShareAI (ตัวเลือกของเราสำหรับความโปร่งใสในตลาด + เศรษฐศาสตร์ของผู้สร้าง)

API เดียวสำหรับแคตตาล็อกขนาดใหญ่ของโมเดล/ผู้ให้บริการพร้อมการสำรองข้อมูลทันทีและตลาดที่แสดง ราคา, ความหน่วง, ความพร้อมใช้งาน, การให้บริการ ก่อนที่คุณจะกำหนดเส้นทาง เริ่มต้นอย่างรวดเร็วใน สนามเด็กเล่น, คว้ากุญแจใน คอนโซล, เรียกดู เอกสาร, และเปรียบเทียบตัวเลือกใน โมเดล.

Eden AI (ตัวจัดการแบบมัลติโหมด)

API แบบรวมสำหรับ LLMs รวมถึง รูปภาพ, การแยกข้อความ/เอกสาร, เสียง และการแปล—พร้อมกับการเปรียบเทียบโมเดล, การตรวจสอบ, การแคช, และการประมวลผลแบบแบตช์.

OpenRouter (การกำหนดเส้นทางที่รับรู้การแคช)

ตัวกำหนดเส้นทางที่โฮสต์ใน LLMs หลายตัวพร้อมการแคชคำสั่งและการยึดติดกับผู้ให้บริการเพื่อใช้บริบทที่อุ่นแล้วซ้ำ; สำรองข้อมูลเมื่อผู้ให้บริการไม่พร้อมใช้งาน.

Portkey (นโยบาย & การดำเนินงาน SRE ที่เกตเวย์)

เกตเวย์ AI พร้อมการสำรองข้อมูลที่ตั้งโปรแกรมได้, คู่มือจำกัดอัตรา, และการแคชเชิงความหมาย—รวมถึงการติดตาม/เมตริกโดยละเอียดสำหรับการควบคุมการผลิต.

Kong AI Gateway (การกำกับดูแลและการตรวจสอบที่ขอบ)

นำปลั๊กอิน AI นโยบาย และการวิเคราะห์เข้าสู่ระบบนิเวศของ Kong; เหมาะสมอย่างยิ่งเมื่อคุณต้องการการควบคุมขอบแบบรวมศูนย์ในทีมต่างๆ.

รวมเป็นหนึ่งเดียว (เราเตอร์ที่ขับเคลื่อนด้วยข้อมูล)

API สากลพร้อมเกณฑ์มาตรฐานสดเพื่อเพิ่มประสิทธิภาพต้นทุน/ความเร็ว/คุณภาพตามภูมิภาคและภาระงาน.

Orq.ai (การทดลองและ LLMOps)

การทดลอง ผู้ประเมิน (รวมถึงเมตริก RAG) การปรับใช้ และ RBAC/VPC—เหมาะอย่างยิ่งเมื่อการประเมินและการกำกับดูแลต้องอยู่ร่วมกัน.

LiteLLM (พร็อกซี/เกตเวย์ที่โฮสต์เอง)

พร็อกซีโอเพ่นซอร์สที่เข้ากันได้กับ OpenAI พร้อมงบประมาณ/ขีดจำกัด การบันทึก/เมตริก และ UI สำหรับผู้ดูแลระบบ ปรับใช้ด้วย Docker/K8s/Helm; คุณเป็นเจ้าของการดำเนินงาน.

เจาะลึก: ทางเลือก RouteLLM ชั้นนำ

ShareAI (API AI ที่ขับเคลื่อนโดยผู้คน)

มันคืออะไร. เครือข่าย AI ที่เน้นผู้ให้บริการเป็นอันดับแรกและ API ที่รวมเป็นหนึ่งเดียว เรียกดูแคตตาล็อกขนาดใหญ่ของโมเดล/ผู้ให้บริการและกำหนดเส้นทางด้วยการสำรองข้อมูลทันที ตลาดแสดงราคา ความหน่วง เวลาให้บริการ และความพร้อมใช้งานในที่เดียวเพื่อให้คุณสามารถเลือกผู้ให้บริการที่เหมาะสมก่อนแต่ละเส้นทาง เริ่มต้นใน สนามเด็กเล่น, สร้างคีย์ใน คอนโซล, และทำตามการเริ่มต้นใช้งาน API อย่างรวดเร็วใน เอกสาร. เรียกดู ตลาดโมเดล.

- ความโปร่งใสของตลาด — ดูราคา/ความหน่วง/เวลาให้บริการ/ความพร้อมใช้งานล่วงหน้า.

- ความยืดหยุ่นโดยค่าเริ่มต้น — การสำรองข้อมูลอย่างรวดเร็วไปยังผู้ให้บริการที่ดีที่สุดถัดไปเมื่อเกิดปัญหา.

- เศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง — ส่วนใหญ่ของการใช้จ่ายจะไหลไปยังผู้ให้บริการ GPU ที่รักษาโมเดลให้ออนไลน์.

- การเริ่มต้นที่ไร้แรงเสียดทาน — ทดสอบใน Playground แล้วส่งออก.

ข้อเท็จจริงของผู้ให้บริการ (รับรายได้โดยการรักษาโมเดลให้ออนไลน์). ใครๆ ก็สามารถเป็นผู้ให้บริการได้ (ชุมชนหรือบริษัท) เข้าร่วมผ่าน Windows/Ubuntu/macOS หรือ Docker มีส่วนร่วมในช่วงเวลาว่างหรือทำงานตลอดเวลา เลือกแรงจูงใจ: รางวัล (เงิน) การแลกเปลี่ยน (โทเค็น/AI Prosumer) หรือภารกิจ (บริจาค % ให้กับ NGOs) ดู คู่มือผู้ให้บริการ หรือเปิด แดชบอร์ดผู้ให้บริการ.

เหมาะสำหรับ. ทีมผลิตภัณฑ์ที่ต้องการความโปร่งใสในตลาด ความยืดหยุ่น และพื้นที่สำหรับการเติบโตเข้าสู่โหมดผู้ให้บริการ—โดยไม่ต้องผูกขาดกับผู้ขายรายใดรายหนึ่ง.

อีเดน AI

มันคืออะไร. API แบบรวมที่ครอบคลุม LLMs + การสร้างภาพ + OCR/การแยกวิเคราะห์เอกสาร + การพูด + การแปล เพื่อที่คุณจะไม่ต้องรวม SDK จากผู้ขายหลายราย นอกจากนี้ยังเน้นการเปรียบเทียบโมเดล การตรวจสอบ และการจัดกลุ่ม.

เหมาะสมเมื่อ. แผนงานของคุณเป็นแบบมัลติโหมดและคุณต้องการจัดการ OCR/การพูด/การแปลควบคู่ไปกับการสนทนา LLM.

สิ่งที่ควรระวัง. หากคุณต้องการ มุมมองตลาดต่อคำขอ (ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน) หรือเศรษฐศาสตร์ระดับผู้ให้บริการ จับคู่กับตัวจัดเส้นทางตลาดเช่น ShareAI.

OpenRouter

มันคืออะไร. ตัวจัดเส้นทาง LLM แบบรวมที่มีการจัดเส้นทางผู้ให้บริการ/โมเดล การแคชคำสั่ง. ด้วยการเปิดใช้งานการแคช OpenRouter มักจะทำให้คุณอยู่กับผู้ให้บริการเดิมเพื่อใช้บริบทที่อุ่นไว้ซ้ำ หากผู้ให้บริการนั้นไม่พร้อมใช้งาน ระบบจะเปลี่ยนไปใช้ตัวเลือกสำรอง นอกจากนี้ยังรองรับคำแนะนำกลยุทธ์ (เช่น การถ่วงน้ำหนักราคา).

เหมาะสมเมื่อ. คุณต้องการความเร็วที่โฮสต์และการจัดเส้นทางที่รับรู้การแคชเพื่อลดต้นทุนและปรับปรุงปริมาณงาน—โดยเฉพาะในงานสนทนาที่มี QPS สูงพร้อมคำถามซ้ำ.

สิ่งที่ควรระวัง. สำหรับการกำกับดูแลองค์กรเชิงลึก (การส่งออก SIEM นโยบายทั่วทั้งองค์กร) หลายทีมจับคู่ OpenRouter กับ Portkey หรือ Kong AI Gateway.

พอร์ทคีย์

มันคืออะไร. เกตเวย์ AI ที่มีการตั้งค่าตัวเลือกสำรองแบบโปรแกรมได้ คู่มือจำกัดอัตรา และแคชแบบง่าย/เชิงความหมาย พร้อมการติดตาม/เมตริกสำหรับการควบคุมแบบ SRE แคชเชิงความหมายมีประโยชน์อย่างยิ่งสำหรับคำถาม/ข้อความสั้น ๆ เมื่อมีการปรับเกณฑ์ความคล้ายคลึงกันอย่างเหมาะสม.

เหมาะสมเมื่อ. คุณต้องการการจัดเส้นทางที่ขับเคลื่อนด้วยนโยบายพร้อมการสังเกตการณ์ระดับสูง และคุณสะดวกที่จะดำเนินการชั้นเกตเวย์ที่อยู่หน้าตัวจัดเส้นทาง/ตลาดหนึ่งหรือมากกว่า.

คอง AI เกตเวย์

มันคืออะไร. เกตเวย์ขอบที่นำปลั๊กอิน AI นโยบาย และการวิเคราะห์เข้าสู่ระบบนิเวศของ Kong (ผ่าน Konnect หรือการจัดการด้วยตนเอง) หากแพลตฟอร์ม API ของคุณหมุนรอบ Kong อยู่แล้วและคุณต้องการนโยบาย/การตรวจสอบส่วนกลาง นี่เป็นตัวเลือกที่เหมาะสม.

เหมาะสมเมื่อ. การกำกับดูแลขอบ การตรวจสอบ ความเป็นส่วนตัวของข้อมูล และการควบคุมแบบรวมศูนย์เป็นสิ่งที่ไม่สามารถต่อรองได้ในสภาพแวดล้อมของคุณ.

รวมเป็นหนึ่ง

มันคืออะไร. ตัวจัดเส้นทางที่ขับเคลื่อนด้วยข้อมูลซึ่งปรับปรุงต้นทุน/ความเร็ว/คุณภาพโดยใช้เกณฑ์มาตรฐานแบบสด ปรับเปลี่ยนตามภูมิภาคและปริมาณงาน.

เหมาะสมเมื่อ. คุณต้องการการเลือกที่แนะนำโดยเกณฑ์มาตรฐานซึ่งปรับตัวอย่างต่อเนื่องตามประสิทธิภาพในโลกจริง.

ออร์ค.ai

มันคืออะไร. แพลตฟอร์มความร่วมมือ AI เชิงสร้างสรรค์ + LLMOps: การทดลอง ผู้ประเมิน (รวมถึงเมตริก RAG) การปรับใช้ และ RBAC/VPC เหมาะอย่างยิ่งเมื่อการประเมินและการกำกับดูแลต้องอยู่ร่วมกัน.

เหมาะสมเมื่อ. คุณต้องการการทดลอง + การประเมินผลพร้อมกับการกำกับดูแลในที่เดียว—จากนั้นปรับใช้โดยตรงจากพื้นผิวเดียวกัน.

LiteLLM

มันคืออะไร. พร็อกซี/เกตเวย์โอเพ่นซอร์สที่มีจุดเชื่อมต่อที่เข้ากันได้กับ OpenAI, งบประมาณ & ขีดจำกัดอัตรา, การบันทึก/เมตริก และ UI สำหรับผู้ดูแลระบบ ปรับใช้ผ่าน Docker/K8s/Helm; เก็บทราฟฟิกไว้ในเครือข่ายของคุณเอง.

เหมาะสมเมื่อ. คุณต้องการโฮสต์เองและควบคุมโครงสร้างพื้นฐานทั้งหมดด้วยความเข้ากันได้ที่ตรงไปตรงมาสำหรับ SDK สไตล์ OpenAI ยอดนิยม.

สิ่งที่ควรระวัง. เช่นเดียวกับเกตเวย์ OSS ใด ๆ คุณเป็นเจ้าของการดำเนินงานและการอัปเกรด.

เริ่มต้นอย่างรวดเร็ว: เรียกใช้งานโมเดลในไม่กี่นาที (ShareAI)

เริ่มต้นใน สนามเด็กเล่น, จากนั้นรับคีย์ API และส่งออก อ้างอิง: การเริ่มต้นใช้งาน API • หน้าเอกสาร • การเปิดตัว.

#!/usr/bin/env bash"

// ShareAI — การเติมข้อความแชท (JavaScript, Node 18+);

เคล็ดลับการย้ายข้อมูล. แมปโมเดล RouteLLM ที่คุณเลือกในปัจจุบันไปยังโมเดลที่เทียบเท่าของ ShareAI, สะท้อนรูปร่างคำขอ/การตอบกลับ และเริ่มต้นด้วยฟีเจอร์แฟล็ก ส่งทราฟฟิก 5–10% ก่อน, เปรียบเทียบความหน่วง/ต้นทุน/คุณภาพ จากนั้นเพิ่มขึ้น หากคุณใช้เกตเวย์ (Portkey/Kong) ตรวจสอบให้แน่ใจว่าการแคช/การสำรองข้อมูลไม่ทำงานซ้ำระหว่างเลเยอร์.

การเปรียบเทียบในพริบตา

| แพลตฟอร์ม | โฮสต์ / โฮสต์ด้วยตัวเอง | การกำหนดเส้นทาง & การสำรองข้อมูล | การสังเกตการณ์ | ความหลากหลาย (LLM + อื่น ๆ) | การกำกับดูแล / นโยบาย | หมายเหตุ |

|---|---|---|---|---|---|---|

| เส้นทางLLM | โอเอสเอส | เราเตอร์ที่เรียนรู้; ไคลเอนต์/เซิร์ฟเวอร์ที่เข้ากันได้กับ OpenAI | CLI/บันทึก; เน้นการวิจัย | เน้น LLM | นโยบายผ่านโครงสร้างพื้นฐานของคุณ | เหมาะสำหรับการประหยัดต้นทุนระดับการวิจัย; นำการควบคุมขอบของคุณมาเอง. |

| แชร์เอไอ | โฮสต์ + เครือข่ายผู้ให้บริการ | การสำรองข้อมูลทันที; การเลือกที่แนะนำโดยตลาด | บันทึกการใช้งาน; สถิติของตลาด | แคตตาล็อกโมเดลที่หลากหลาย | การควบคุมในระดับผู้ให้บริการ | ตลาดที่ขับเคลื่อนด้วยผู้คน; เริ่มต้นด้วย สนามเด็กเล่น และ โมเดล. |

| อีเดน AI | โฮสต์ | สลับผู้ให้บริการ; แบตช์; การแคช | การตรวจสอบค่าใช้จ่ายและ API | LLM + ภาพ + OCR + เสียง + การแปล | การเรียกเก็บเงินแบบรวมศูนย์/การจัดการคีย์ | ผู้ประสานงานหลายรูปแบบ. |

| OpenRouter | โฮสต์ | การกำหนดเส้นทางผู้ให้บริการ/โมเดล; การแคชคำสั่ง; ความยึดติดของผู้ให้บริการ | ข้อมูลในระดับคำขอ | เน้น LLM | นโยบายของผู้ให้บริการ | การใช้แคชซ้ำ; การสำรองเมื่อไม่สามารถใช้งานได้. |

| พอร์ทคีย์ | เกตเวย์ที่โฮสต์ | การสำรองนโยบาย; คู่มือจำกัดอัตรา; แคชเชิงความหมาย | การติดตาม/เมตริก | LLM-มาก่อน | การกำหนดค่าประตูทางเข้า | ราวกั้นแบบ SRE. |

| คอง AI เกตเวย์ | โฮสต์เอง/องค์กร | การกำหนดเส้นทางต้นน้ำผ่านปลั๊กอิน AI | เมตริก/การตรวจสอบผ่าน Kong | LLM-มาก่อน | การกำกับดูแลขอบที่แข็งแกร่ง | ส่วนประกอบโครงสร้างพื้นฐาน; จับคู่กับเราเตอร์/ตลาด. |

| รวมเป็นหนึ่ง | โฮสต์ | การกำหนดเส้นทางด้วยข้อมูลโดยต้นทุน/ความเร็ว/คุณภาพ | ตัวสำรวจเกณฑ์มาตรฐาน | เน้น LLM | นโยบายเราเตอร์ | การเลือกโดยใช้เกณฑ์มาตรฐานเป็นแนวทาง. |

| ออร์ค.ai | โฮสต์ | การลองใหม่/การสำรองในกระบวนการจัดการ | การวิเคราะห์แพลตฟอร์ม; ผู้ประเมิน RAG | LLM + RAG + การประเมิน | ตัวเลือก RBAC/VPC | มุ่งเน้นการทำงานร่วมกันและการทดลอง. |

| LiteLLM | โฮสต์เอง/OSS | การลองใหม่/การสำรอง; งบประมาณ/ขีดจำกัด | การบันทึก/ตัวชี้วัด; ส่วนติดต่อผู้ดูแลระบบ | เน้น LLM | การควบคุมโครงสร้างพื้นฐานทั้งหมด | เข้ากันได้กับ OpenAI; การปรับใช้ Docker/K8s/Helm. |

คำถามที่พบบ่อย: RouteLLM กับที่อื่นๆ

RouteLLM กับ ShareAI — อันไหนดีกว่า?

เลือก แชร์เอไอ หากคุณต้องการตลาดที่โปร่งใสที่แสดงออกมา ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน ก่อนแต่ละเส้นทาง, บวก การเปลี่ยนไปใช้ระบบสำรองทันที และเศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง เลือก เส้นทางLLM หากคุณชอบการวิจัยที่ขับเคลื่อนด้วยข้อมูล, ตัวกำหนดเส้นทางที่เรียนรู้ได้ และคุณสบายใจที่จะดำเนินการโครงสร้างพื้นฐานรอบๆ มัน (เกตเวย์, การบันทึก, การตรวจสอบ) เริ่มต้นด้วย สนามเด็กเล่น และ ตลาดโมเดล.

RouteLLM กับ Eden AI — มีความแตกต่างอย่างไร?

อีเดน AI ครอบคลุม LLMs และ มัลติโหมด (วิสัยทัศน์/OCR, เสียง, การแปล) พร้อมการเปรียบเทียบและการตรวจสอบ. เส้นทางLLM มุ่งเน้นไปที่การกำหนดเส้นทางที่เรียนรู้ได้สำหรับ LLMs หากแผนงานของคุณต้องการ OCR/เสียง/การแปลภายใต้ API เดียว Eden AI ทำให้การส่งมอบง่ายขึ้น; หากการวิจัยการกำหนดเส้นทางเป็นสิ่งสำคัญ RouteLLM เหมาะสม จับคู่กับ ShareAI เมื่อคุณต้องการความโปร่งใสของตลาดต่อคำขอ.

RouteLLM กับ OpenRouter — ควรเลือกเมื่อใด?

เลือก OpenRouter เมื่อไหร่ การแคชคำสั่ง และการใช้แคชที่อุ่นซ้ำมีความสำคัญ (มันมักจะทำให้คุณอยู่กับผู้ให้บริการเดียวกัน และกลับไปใช้ในกรณีที่เกิดปัญหา) เลือก เส้นทางLLM สำหรับนโยบายที่เรียนรู้ได้ที่คุณดำเนินการเอง สแต็กหลายตัวจับคู่ OpenRouter กับเกตเวย์สำหรับนโยบาย/การสังเกตการณ์—และยังคงใช้ ShareAI เมื่อพวกเขาต้องการความโปร่งใสของตลาดก่อนแต่ละเส้นทาง.

RouteLLM กับ Portkey — ตัวกำหนดเส้นทางหรือเกตเวย์?

เส้นทางLLM เป็นเราเตอร์. พอร์ทคีย์ เป็น เกตเวย์: มันยอดเยี่ยมในด้านนโยบาย/การป้องกัน (คู่มือการสำรอง, แคชเชิงความหมาย) และการติดตาม/เมตริกที่ละเอียด ทีมงานหลายทีมใช้ทั้งสองอย่าง: เกตเวย์สำหรับนโยบายทั่วทั้งองค์กร + ตัวกำหนดเส้นทาง/ตลาดสำหรับการเลือกโมเดลและการควบคุมต้นทุน ShareAI จับคู่ได้ดีที่นี่เมื่อคุณต้องการการมองเห็นตลาดก่อนเส้นทาง.

RouteLLM กับ Kong AI Gateway — ใครต้องการอะไร?

เลือก คอง AI เกตเวย์ เมื่อไหร่ การกำกับดูแลที่ขอบ (นโยบาย/การตรวจสอบแบบรวมศูนย์, การอยู่อาศัยของข้อมูล) เป็นสิ่งที่ไม่สามารถต่อรองได้ เก็บ เส้นทางLLM ไว้ข้างหลังมันหากคุณยังต้องการการกำหนดเส้นทางที่เรียนรู้ได้สำหรับราคา/ประสิทธิภาพ ใช้ แชร์เอไอ ควบคู่ไปกับเมื่อคุณต้องการเลือกผู้ให้บริการโดย ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน ก่อนแต่ละเส้นทาง.

RouteLLM vs Unify — อะไรที่ทำให้ Unify มีเอกลักษณ์?

รวมเป็นหนึ่ง ใช้การวัดผลสดและนโยบายแบบไดนามิกเพื่อปรับให้เหมาะสมสำหรับ ต้นทุน/ความเร็ว/คุณภาพ. หากคุณต้องการการเลือกที่ขับเคลื่อนด้วยข้อมูลที่พัฒนาไปตามภูมิภาค/ภาระงาน Unify น่าสนใจ; เส้นทางLLM มุ่งเน้นไปที่โมเดลการกำหนดเส้นทางที่เรียนรู้ซึ่งคุณโฮสต์ ใช้ แชร์เอไอ เมื่อคุณต้องการเลือกผู้ให้บริการด้วยมุมมองตลาดและการสำรองข้อมูลทันที.

RouteLLM vs Orq.ai — อันไหนสำหรับการประเมินผล & RAG?

ออร์ค.ai ให้พื้นผิวสำหรับการทดลอง/การประเมินผล (รวมถึงผู้ประเมิน RAG) พร้อมการปรับใช้และ RBAC/VPC หากคุณต้องการ LLMOps + ผู้ประเมิน Orq.ai อาจเสริมหรือแทนที่ตัวกำหนดเส้นทางแบบบริสุทธิ์ในช่วงแรก นำ แชร์เอไอ เมื่อคุณต้องการตัวเลือกผู้ให้บริการพร้อมความโปร่งใสในตลาดและความยืดหยุ่นในการผลิต.

RouteLLM vs LiteLLM — โฮสต์หรือโฮสต์เอง?

เส้นทางLLM เป็นตรรกะการกำหนดเส้นทาง OSS; LiteLLM เป็นพร็อกซี/เกตเวย์ที่เข้ากันได้กับ OpenAI พร้อมงบประมาณ ขีดจำกัดอัตรา และ UI ผู้ดูแลระบบ—เหมาะมากหากคุณต้องการเก็บทราฟฟิกไว้ใน VPC ของคุณและควบคุมแผนควบคุม ทีมงานมักจะรวม LiteLLM สำหรับการโฮสต์เองกับ แชร์เอไอ เพื่อความโปร่งใสในตลาดและการสำรองข้อมูลทันทีระหว่างผู้ให้บริการ.

อันไหนถูกที่สุดสำหรับภาระงานของฉัน: RouteLLM, ShareAI, OpenRouter, LiteLLM?

ขึ้นอยู่กับการเลือกโมเดล, ภูมิภาค, ความสามารถในการแคช, และรูปแบบการจราจร. เราเตอร์เช่น ShareAI/OpenRouter สามารถลดค่าใช้จ่ายผ่านการกำหนดเส้นทางและความคงตัวที่รับรู้แคช; เกตเวย์เช่น พอร์ทคีย์ เพิ่มการแคชเชิงความหมาย; LiteLLM ลดภาระของแพลตฟอร์มหากคุณสะดวกที่จะดำเนินการมัน เปรียบเทียบกับ โครงสร้างพื้นฐานของคุณ พร้อมคำแนะนำและติดตาม ต้นทุนต่อผลลัพธ์ที่มีประสิทธิภาพ—ไม่ใช่แค่ราคาที่ระบุไว้.

RouteLLM คืออะไร?

เฟรมเวิร์กโอเพ่นซอร์สสำหรับการให้บริการและประเมินเราเตอร์ LLM; มาพร้อมเราเตอร์ที่ผ่านการฝึกอบรมและเส้นทางที่เข้ากันได้กับ OpenAI; มักถูกกล่าวถึงว่าเป็นการลดต้นทุนอย่างมากในขณะที่ยังคงคุณภาพใกล้เคียง GPT-4 ในงานที่คล้าย MT-Bench.

วิธีที่เร็วที่สุดในการลองใช้ ShareAI โดยไม่ต้องมีการผสานรวมเต็มรูปแบบคืออะไร?

เปิด สนามเด็กเล่น, เลือกโมเดล/ผู้ให้บริการ และรันคำแนะนำในเบราว์เซอร์. เมื่อพร้อม, สร้างคีย์ และวางโค้ด cURL/JS ด้านบนลงในแอปของคุณ.

ฉันสามารถเป็นผู้ให้บริการ ShareAI และสร้างรายได้ได้หรือไม่?

ได้ ทุกคนสามารถเข้าร่วมเป็น ชุมชน หรือ บริษัท ผู้ให้บริการโดยใช้ Windows/Ubuntu/macOS หรือ Docker. มีส่วนร่วม เวลาว่าง การระเบิดหรือการทำงาน เปิดใช้งานตลอดเวลา. เลือกแรงจูงใจ: รางวัล (เงิน), แลกเปลี่ยน (โทเค็น/AI Prosumer), หรือ ภารกิจ (บริจาค % ให้กับองค์กรไม่แสวงหาผลกำไร) ดู คู่มือผู้ให้บริการ หรือเปิด แดชบอร์ดผู้ให้บริการ.

บทสรุป

ในขณะที่ เส้นทางLLM เป็นเราเตอร์ OSS ที่แข็งแกร่ง, ตัวเลือกที่ดีที่สุดของคุณขึ้นอยู่กับลำดับความสำคัญ:

- ความโปร่งใสของตลาด + ความยืดหยุ่น: แชร์เอไอ

- การครอบคลุมหลายรูปแบบภายใต้ API เดียว: อีเดน AI

- การกำหนดเส้นทางที่คำนึงถึงแคชในรูปแบบโฮสต์: OpenRouter

- นโยบาย/ข้อกำหนดที่ขอบ: Portkey หรือ Kong AI Gateway

- การกำหนดเส้นทางที่ขับเคลื่อนด้วยข้อมูล: รวมเป็นหนึ่ง

- LLMOps + ผู้ประเมิน: ออร์ค.ai

- แผงควบคุมแบบโฮสต์เอง: LiteLLM

หาก ราคา/ความหน่วง/เวลาทำงาน/ความพร้อมใช้งาน ก่อนแต่ละเส้นทาง, การเปลี่ยนไปใช้ระบบสำรองทันที, และ เศรษฐศาสตร์ที่สอดคล้องกับผู้สร้าง อยู่ในรายการตรวจสอบของคุณ ให้เปิด สนามเด็กเล่น, สร้างคีย์ API, และเรียกดู ตลาดโมเดล เพื่อกำหนดเส้นทางคำขอถัดไปของคุณอย่างชาญฉลาด.