Mga Alternatibo sa MLflow AI Gateway 2026: Pinakamahusay na Mga Alternatibo

Na-update Pebrero 2026

Kung ikaw ay nagsasaliksik mga alternatibo sa MLflow AI Gateway, ang gabay na ito na nakatuon sa tagabuo ay nagpapaliwanag kung ano ang MLflow’s AI Gateway (at hindi), inilalatag ang mga pamantayan sa pagsusuri, at inihahambing ang 10 pinakamahusay na opsyon. Inilalagay namin IbahagiAI una para sa mga koponan na nais ng isang API sa maraming provider, malinaw na signal ng marketplace (presyo, latency, uptime, availability) bago mag-routing, instant failover, at ekonomiyang pinapatakbo ng tao (70% ng gastusin ay napupunta sa mga provider). Tingnan ang opisyal na mga konsepto ng tampok sa dokumentasyon ng MLflow.

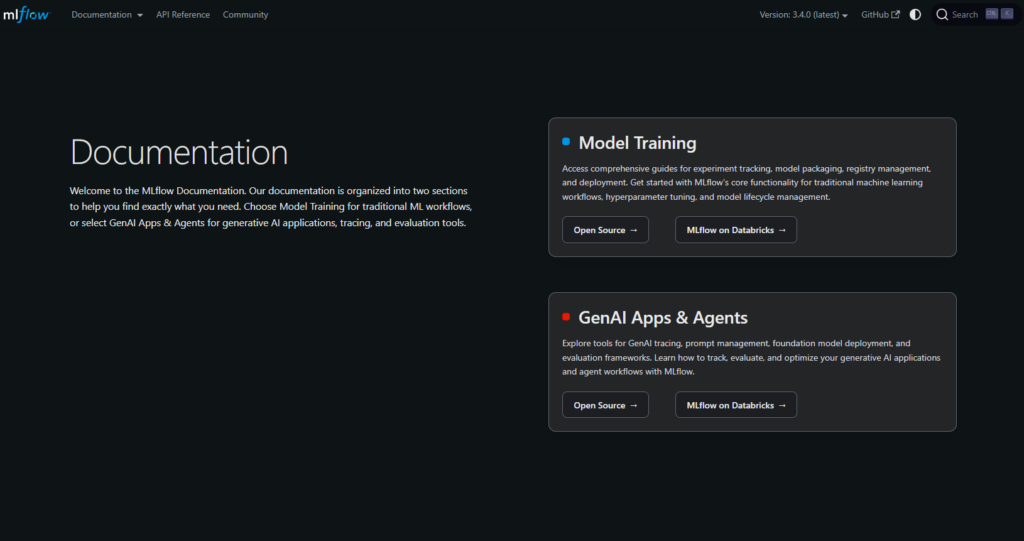

Ano ang MLflow AI Gateway (at hindi)

Ano ito. Isang AI/LLM egress control layer sa loob ng ekosistem ng MLflow. Pinagsasama-sama nito ang mga kredensyal at patakaran, nagbibigay ng isang pinag-isang interface upang makipag-usap sa maraming model provider, at ikinakabit sa mga workflow ng eksperimento/trace/eval ng MLflow. Sa madaling salita: pamamahala at pamamahala ng trapiko para sa mga tawag sa LLM.

Ano ang hindi nito. Isang transparent na model marketplace na nagpapakita ng live na presyo, latency, uptime, at availability sa maraming provider bago ka mag-routing. Ang mga gateway ay nakatuon sa kontrol at observability. Ang mga marketplace ay nakatuon sa pagpili at ekonomiya ng performance sa antas ng ruta.

Pangunahing punto: Kung ang iyong pangunahing pangangailangan ay provider-agnostic routing na may pre-route transparency at instant failover, ipares o palitan ang isang gateway gamit ang IbahagiAI. Kung ang iyong pangunahing pangangailangan ay centralized org policy at observability, ang isang gateway ay angkop sa lane na iyon.

Mga Aggregator vs Gateways vs Agent platforms

- Mga aggregator ng LLM (mga pamilihan). Isang API sa maraming modelo/provider na may pre-route transparency (presyo, latency, uptime, availability, uri ng provider), kasama ang smart routing/failover. Maganda para sa: mas mabilis na eksperimento, cost/UX tuning, pagpapalit ng provider nang walang rewrites.

- Mga AI gateway. Pamamahala sa gilid (mga kredensyal, saklaw, guardrails), mga quota/mga limitasyon sa rate, at observability. Dalhin mo ang sarili mong mga provider at account. Maganda para sa: sentralisadong seguridad, auditability, kontrol sa egress.

- Mga platform ng ahente/chatbot. Naka-package na UX (memorya, mga tool), mga channel, at mga workflow ng koponan—na-optimize para sa mga end-user na assistant kaysa sa provider-agnostic na pagsasama-sama.

Paano namin sinuri ang pinakamahusay na mga alternatibo sa MLflow AI Gateway

- Lawak ng modelo at neutralidad — proprietary + bukas; madaling pagpapalit; minimal na muling pagsulat.

- Latency at katatagan — mga patakaran sa pag-route, mga timeout/retries, instant failover.

- Pamamahala at seguridad — paghawak ng key, mga saklaw, regional routing.

- Pagmamasid — mga log/traces at mga dashboard ng gastos/latency.

- Kalinawan sa pagpepresyo at TCO — ihambing ang tunay na mga gastos bago ka mag-route.

- Karanasan ng developer — mga dokumento, SDKs, quickstarts; oras-sa-unang-token.

- Komunidad at ekonomiya — kung ang iyong paggastos ay nagpapalago ng supply (mga insentibo para sa mga may-ari ng GPU).

Nangungunang 10 alternatibo sa MLflow AI Gateway

#1 — ShareAI (People-Powered AI API)

Ano ito. Isang multi-provider na API na may transparent na marketplace at matalinong pag-route. Sa isang integrasyon, mag-browse ng malaking katalogo ng mga modelo at provider, ihambing ang presyo, latency, uptime, availability, at uri ng provider, pagkatapos ay mag-route gamit ang instant failover. Ang ekonomiya ay pinapatakbo ng tao: 70% ng bawat dolyar ay dumadaloy sa mga provider (komunidad o kumpanya) na nagpapanatili ng mga modelo online.

Bakit ito ang #1 dito. Kung gusto mo ng provider-agnostic na pagsasama-sama na may pre-route transparency at resilience, ang ShareAI ang pinaka-direktang akma. Panatilihin ang isang gateway kung kailangan mo ng mga patakaran sa buong organisasyon; idagdag ang ShareAI para sa marketplace-guided na pag-route.

- Isang API → 150+ modelo sa iba't ibang provider; walang rewrites, walang lock-in. • Mag-browse Mga Modelo

- Transparenteng marketplace: pumili batay sa presyo, latency, uptime, availability, at uri ng provider. • Subukan ito sa Palaruan

- Resilience bilang default: routing policies kasama ang instant failover.

- Makatarungang ekonomiya: 70% ng gastusin ay napupunta sa mga provider (komunidad o kumpanya). • Gumawa ng API Key · Sanggunian ng API · Mga Dokumento · Mga Paglabas

Para sa mga provider: kumita sa pamamagitan ng pagpapanatili ng mga modelo online. Kahit sino ay maaaring maging ShareAI provider—Komunidad o Kumpanya. Mag onboard gamit ang Windows, Ubuntu, macOS, o Docker. Mag-ambag ng idle-time bursts o magpatakbo ng always-on. Pumili ng iyong insentibo: Rewards (pera), Exchange (tokens / AI Prosumer), o Mission (mag-donate ng 1% sa NGOs). Habang lumalaki, maaari mong itakda ang iyong sariling inference prices at makakuha ng preferential exposure. • Gabay sa Provider · Dashboard ng Provider

#2 — Portkey

Ano ito. AI gateway na nagbibigay-diin sa observability, guardrails, at governance—sikat sa mga team na nangangailangan ng matibay na kontrol at diagnostics.

Pinakamahusay para sa. Regulated/enterprise environments kung saan ang lalim ng governance ang pangunahing prioridad. Kumplemento sa ShareAI kapag kailangan mo ng malalim na policy enforcement ngunit nais mo rin ng marketplace-guided routing.

#3 — Kong AI Gateway

Ano ito. Enterprise AI/LLM gateway—policies/plugins, analytics, at edge observability para sa AI traffic. Isang control plane sa halip na isang marketplace.

Pinakamahusay para sa. Org-wide policy, quotas, at plugin-driven extensions sa iba't ibang heterogeneous teams.

#4 — OpenRouter

Ano ito. Isang unified API sa maraming modelo; mahusay para sa mabilis na eksperimento sa malawak na katalogo.

Pinakamahusay para sa. Mabilis na multi-model access; kumplemento sa gateways kapag mas kailangan mo ang pagpipilian kaysa sa policy.

#5 — Eden AI

Ano ito. Pinagsasama ang LLMs kasama ang mas malawak na AI capabilities (vision, translation, TTS), na may fallbacks/caching at batching.

Pinakamahusay para sa. Mga team na nangangailangan ng maraming AI modalities sa isang lugar na may standard na kontrol.

#6 — LiteLLM

Ano ito. Magaan na Python SDK plus self-hostable proxy na gumagamit ng OpenAI-compatible interface sa maraming provider.

Pinakamahusay para sa. DIY na kontrol kapag mas gusto mong patakbuhin ang proxy nang sarili at i-tune ang retries/fallbacks.

#7 — Unify

Ano ito. Routing na nakatuon sa kalidad at pagsusuri upang pumili ng mas mahusay na modelo bawat prompt.

Pinakamahusay para sa. Mga team na nakatuon sa pagsusuri na nakatuon sa kalidad ng tugon at prompt-specific na pagpili.

#8 — Orq AI

Ano ito. Platform ng orkestrasyon/kolaborasyon na tumutulong sa mga team na lumipat mula sa eksperimento patungo sa produksyon gamit ang low-code flows.

Pinakamahusay para sa. Pagbuo ng workflows at multi-step LLM apps kung saan ang mga non-engineers ay nakikipagtulungan sa mga engineers.

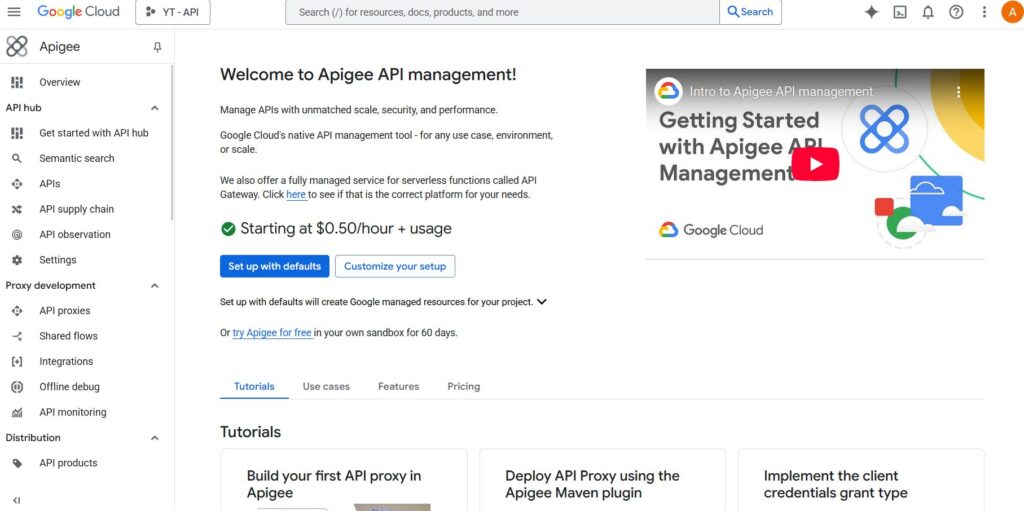

#9 — Apigee (na may LLMs sa likod nito)

Ano ito. Isang mature na API management/gateway na maaari mong ilagay sa harap ng mga LLM provider upang mag-aplay ng mga polisiya, keys, at quotas.

Pinakamahusay para sa. Mga enterprise na pinagsasama-sama ang API governance sa ilalim ng isang payong na may pamilyar na kontrol.

#10 — NGINX

Ano ito. Gamitin ang NGINX upang bumuo ng custom routing, token enforcement, at caching para sa LLM backends kung mas gusto mo ang DIY control.

Pinakamahusay para sa. Mga team na may infra DNA na nais ng mas detalyadong kontrol nang hindi gumagamit ng hiwalay na AI product.

MLflow AI Gateway vs ShareAI (mabilisang pagtingin)

Kung kailangan mo ng isang API sa maraming provider na may transparent na presyo/latency/uptime at instant failover, piliin IbahagiAI. Kung ang pangunahing pangangailangan mo ay egress governance—centralized credentials, policy enforcement, at observability—MLflow AI Gateway angkop sa lane na iyon. Maraming team ang pinagsasama sila: gateway para sa org policy plus ShareAI para sa marketplace routing.

Mabilis na paghahambing

| Plataporma | Sino ang pinaglilingkuran nito | Lawak ng modelo | Pamamahala at seguridad | Pagmamasid | Pag-route / failover | Transparency ng marketplace | Programa ng provider |

|---|---|---|---|---|---|---|---|

| IbahagiAI | Mga product/platform team na nangangailangan ng isang API at patas na ekonomiya | 150+ modelo, maraming provider | Mga susi ng API at mga kontrol sa bawat ruta | Paggamit ng console kasama ang mga istatistika ng marketplace | Matalinong pag-ruta + agarang failover | Oo (presyo, latency, uptime, availability, uri ng provider) | Oo — bukas na supply; 70% sa mga provider |

| MLflow AI Gateway | Mga team na nagnanais ng egress governance | BYO na mga provider | Sentralisadong mga kredensyal/patakaran | Mga workflow na MLflow-native | Conditional routing sa pamamagitan ng config | Hindi (infra tool, hindi isang marketplace) | wala/n/a |

| Kong AI Gateway | Mga negosyo na nangangailangan ng gateway-level na polisiya | BYO | Malalakas na edge na polisiya/plugin | Analitika | Proxy/plugin, mga retries | Hindi | wala/n/a |

| Portkey | Mga regulated/enterprise na koponan | Malawak | Guardrails at pamamahala | Malalalim na bakas | Kondisyunal na pag-ruruta | Bahagya | wala/n/a |

| OpenRouter | Mga developer na nais ng isang susi | Malawak na katalogo | Pangunahing mga kontrol sa API | Panig-app | Mga fallback | Bahagya | wala/n/a |

| Eden AI | Mga team na nangangailangan ng LLM + iba pang AI | Malawak | Karaniwang mga kontrol | Nag-iiba | Mga fallback/caching | Bahagya | wala/n/a |

| LiteLLM | DIY/sariling-host na proxy | Maraming provider | Mga limitasyon sa config/key | Iyong infra | Mga retries/fallback | wala/n/a | wala/n/a |

| Pag-isahin | Mga team na nakatuon sa kalidad | Multi-model | Karaniwang seguridad ng API | Analytics ng platform | Pinakamahusay na pagpili ng modelo | wala/n/a | wala/n/a |

| Orq | Mga koponan na inuuna ang orkestrasyon | Malawak na suporta | Mga kontrol ng plataporma | Analytics ng platform | Daloy ng orkestrasyon | wala/n/a | wala/n/a |

| Apigee / NGINX | Mga negosyo / DIY | BYO | Mga patakaran | Mga add-on / pasadyang | Pasadyang | wala/n/a | wala/n/a |

Pagpepresyo at TCO: ihambing ang tunay na mga gastos (hindi lamang mga unit price)

Ang hilaw na presyo bawat 1K tokens ay nagtatago ng tunay na larawan. Ang TCO ay nagbabago sa mga retries/fallbacks, latency (na nakakaapekto sa paggamit at pasensya ng user), pagkakaiba ng provider, imbakan ng observability, at mga evaluation run. Ang isang transparent na marketplace ay tumutulong sa iyo na pumili ng mga ruta na nagbabalanse ng gastos at UX.

Isang mental na modelo:

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))Prototype (~10k tokens/araw). I-optimize para sa time-to-first-token gamit ang Palaruan at mga quickstarts. Mid-scale (~2M tokens/araw). Ang routing/failover na ginagabayan ng Marketplace ay maaaring magbawas ng 10–20% habang pinapabuti ang UX. Mga spiky workload. Asahan ang mas mataas na epektibong gastos sa token mula sa mga retries sa panahon ng failover; maglaan ng badyet para dito.

Gabay sa Migration: paglipat sa ShareAI

Mula sa MLflow AI Gateway → ShareAI

Panatilihin ang mga patakaran sa antas ng gateway kung saan sila mahusay; idagdag ang ShareAI para sa marketplace routing at instant failover. Pattern: gateway auth/policy → ShareAI route bawat modelo → sukatin ang mga istatistika ng marketplace → higpitan ang mga patakaran.

Mula sa OpenRouter → ShareAI

I-map ang mga pangalan ng modelo, i-verify ang prompt parity, pagkatapos ay i-shadow ang 10% ng trapiko at i-ramp ang 25% → 50% → 100% habang ang latency/error budgets ay nananatili. Ginagawang simple ng data ng marketplace ang pagpapalit ng provider.

Mula sa LiteLLM → ShareAI

Palitan ang self-hosted proxy sa mga production route na ayaw mong patakbuhin; panatilihin ang LiteLLM para sa dev kung nais. Ihambing ang ops overhead laban sa mga benepisyo ng managed routing.

Mula sa Unify / Portkey / Orq / Kong → ShareAI

Tukuyin ang mga inaasahan sa feature-parity (analytics, guardrails, orchestration, plugins). Maraming team ang nagpapatakbo ng hybrid: panatilihin ang mga espesyal na tampok kung saan sila pinakamalakas; gamitin ang ShareAI para sa transparent na pagpili ng provider at failover.

Mabilisang simula para sa developer (copy-paste)

Ang API surface ay OpenAI-compatible. Palitan IYONG_SUSI sa mga snippet sa ibaba. Gumawa ng key dito: Gumawa ng API Key. Tingnan ang mga dokumento: Sanggunian ng API at Docs Tahanan.

#!/usr/bin/env bash"// JavaScript (fetch) — Node 18+/Edge runtimes;# Python — requestsChecklist para sa seguridad, privacy & pagsunod (vendor-agnostic)

- Pangangasiwa ng key. Rotation cadence; minimal scopes; paghihiwalay ng environment.

- Pagpapanatili ng data. Kung saan iniimbak ang mga prompt/response at kung gaano katagal; mga default ng redaction.

- PII at sensitibong nilalaman. Masking; mga kontrol sa pag-access; regional routing para sa lokalidad ng data.

- Obserbabilidad. Pag-log ng prompt/response; kakayahang mag-filter o mag-pseudonymize; pare-parehong pagpapalaganap ng trace IDs.

- Pagtugon sa insidente. Mga landas ng eskalasyon at mga SLA ng provider.

FAQ — MLflow AI Gateway vs ibang mga kakumpitensya

MLflow AI Gateway vs ShareAI — alin para sa multi-provider routing?

IbahagiAI. Ito ay ginawa para sa transparency ng marketplace (presyo, latency, uptime, availability, uri ng provider) at matalinong routing/failover sa maraming provider. Ang MLflow AI Gateway ay isang egress governance tool (sentralisadong credentials/patakaran; obserbabilidad). Maraming mga koponan ang gumagamit ng pareho.

MLflow AI Gateway vs OpenRouter — mabilis na multi-model access o gateway controls?

OpenRouter ginagawang mabilis ang multi-model access; MLflow sentralisado ang patakaran/obserbabilidad. Kung gusto mo rin ng transparency bago ang ruta at instant failover, IbahagiAI pinagsasama ang multi-provider access sa isang marketplace view at matibay na routing.

MLflow AI Gateway vs Portkey — sino ang mas malakas sa guardrails?

Parehong binibigyang-diin ang pamamahala at obserbabilidad; nagkakaiba sa lalim at ergonomiya. Kung ang pangunahing pangangailangan mo ay transparent na pagpili ng provider at failover, idagdag IbahagiAI. Ang mga koponan na naghahanap ng “Portkey alternatives” ay madalas na mas gusto ang marketplace + routing story ng ShareAI.

MLflow AI Gateway vs Traefik AI Gateway — dalawang gateways?

Parehong gateways (mga patakaran, plugins/middlewares, analytics), hindi marketplaces. Maraming koponan ang nagpapareha ng gateway sa IbahagiAI para sa transparent na multi-provider routing at failover.

MLflow AI Gateway vs Kong AI Gateway — enterprise policy o MLflow-native workflows?

Kong nag-aalok ng mature na enterprise policies/plugins; MLflow angkop para sa MLflow-centric workflows. Para sa transparency ng marketplace at instant failover sa iba't ibang provider, gamitin IbahagiAI.

MLflow AI Gateway vs Eden AI — maraming AI services o egress control?

Eden AI pinagsasama-sama ang ilang AI services (LLM, imahe, TTS). MLflow sentralisado ang policy/credentials. Para sa transparent na pagpepresyo/latency at instant failover sa iba't ibang provider, piliin IbahagiAI.

MLflow AI Gateway vs LiteLLM — self-host proxy o managed governance?

LiteLLM isang DIY proxy na ikaw ang nagpapatakbo; MLflow nagbibigay ng managed governance/observability para sa AI egress. Kung ayaw mong magpatakbo ng proxy at nais mo ng marketplace-driven routing, piliin IbahagiAI.

MLflow AI Gateway vs Unify — pagpili ng pinakamahusay na modelo vs pagpapatupad ng patakaran?

Pag-isahin nakatuon sa evaluation-driven model selection; MLflow nakatuon sa policy/observability. Para sa isang API sa maraming provider na may live marketplace stats, gamitin IbahagiAI.

MLflow AI Gateway vs Orq — orkestrasyon vs egress?

Orq tumutulong sa pag-orkestra ng mga workflow; MLflow namamahala sa egress na trapiko. IbahagiAI kumplemento sa alinman gamit ang marketplace routing.

MLflow AI Gateway vs Apigee — pamamahala ng API vs AI-specific na egress?

Apigee ay malawak na pamamahala ng API; MLflow ay AI-focused egress governance sa konteksto ng MLflow. Para sa provider-agnostic access na may transparency ng marketplace, gamitin IbahagiAI.

MLflow AI Gateway vs NGINX — DIY vs handa na?

NGINX nag-aalok ng DIY na mga filter/patakaran; MLflow nag-aalok ng isang nakapaketeng layer na may MLflow-friendly na observability. Upang maiwasan ang custom na Lua at makuha pa rin ang transparent na pagpili ng provider, mag-layer sa IbahagiAI.