Mga Alternatibo sa RouteLLM 2026: Kailan Pumili ng ShareAI (at Ano Pa ang Dapat Isaalang-alang)

Na-update Pebrero 2026

Pinipili ng mga developer RouteLLM upang i-route ang mga prompt sa mas murang mga modelo habang tinatarget ang halos–GPT-4 na kalidad—lalo na para sa mga benchmark-like na gawain kung saan ang isang natutunang router ay maaaring kumpiyansang mag-downshift. Ngunit kung mas mahalaga sa iyo ang transparency ng marketplace bago ang bawat ruta (live na presyo, latency, uptime, availability), instant failover sa iba't ibang provider, edge policy at audit, o isang self-hosted proxy/gateway, isa sa mga Mga alternatibo sa RouteLLM ay maaaring mas angkop sa iyong stack.

Ang gabay ng mamimili na ito ay isinulat tulad ng isang tagabuo: tiyak na mga trade-off, mabilis na pagpili, malalim na pagsusuri, side-by-side na paghahambing, at isang copy-paste na ShareAI quickstart upang maipadala mo ito ngayon.

Pag-unawa sa RouteLLM (at kung saan maaaring hindi ito angkop)

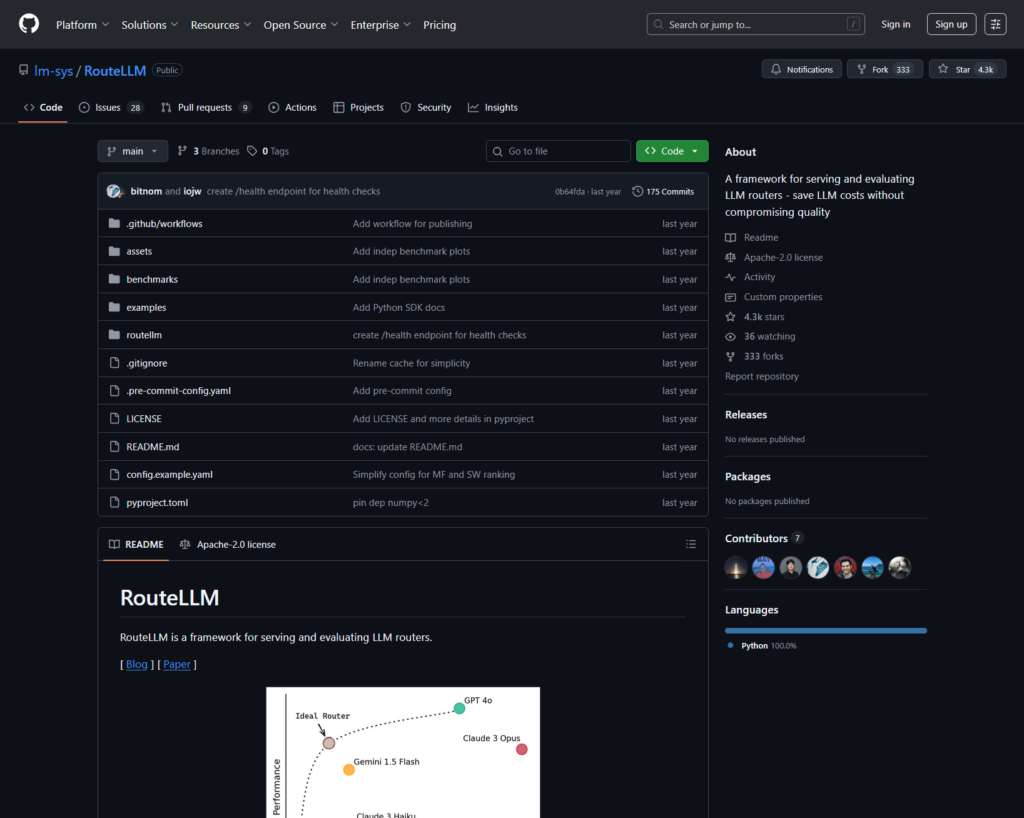

Ano ang RouteLLM. Ang RouteLLM ay isang open-source na framework para sa pag-serve at pagsusuri ng mga LLM router. Nag-aalok ito ng drop-in na OpenAI-compatible na client/server at nagdadala ng mga sinanay na routing model na maaaring mag-route ng mas simpleng mga query sa mas murang mga modelo—iniulat na hanggang sa 85% na pagbawas sa gastos habang pinapanatili ang ~95% ng GPT-4 na performance sa mga karaniwang benchmark (hal., MT-Bench).

Bakit ito pinipili ng mga team.

- Cost-aware na routing na may mga patakaran na suportado ng pananaliksik.

- Bukas na pinagmulan at extensible sa Python.

- Tugma sa OpenAI landas sa trial routing nang walang mabibigat na SDK rewrites.

Kung saan maaaring hindi angkop ang RouteLLM.

- Gusto mo live na transparency ng marketplace (presyo, latency, uptime, availability) bago ang bawat ruta—hindi lamang isang natutunang patakaran.

- Kailangan mo multi-provider failover

- Saklaw ng iyong roadmap multimodal na mga API tulad ng OCR, pagsasalita, pagsasalin, at pag-parse ng dokumento sa ilalim ng isang bubong.

Paano pumili ng alternatibo sa RouteLLM

- Kabuuang Gastos ng Pagmamay-ari (TCO). Huwag tumigil sa $/1K tokens. Bilangin ang cache hit rates, retries/fallbacks, queueing, evaluator costs, at ang ops burden ng logs/alerts. Ang mga cache-aware routers at gateways na may semantic cache ay maaaring gawing mas mura sa praktika ang “mas mahal na list price.”.

- Latency at pagiging maaasahan. Paboran ang routing na may kamalayan sa rehiyon, provider stickiness kapag mainit ang cache, at tumpak na fallbacks (retry 429s, escalate sa timeouts). Ang mga hosted routers na pinapanatili ka sa parehong provider para sa mainit na mga context at bumabawi kapag may problema ang provider ay karaniwang nananalo.

- Observability at pamamahala. Kung mahalaga ang guardrails, redaction, audit logs, at patakaran sa gilid, ang AI gateway (Portkey o Kong AI Gateway) ay karaniwang mas malakas kaysa sa purong router lamang. Maraming koponan ang nagpa-pair ng router + gateway.

- Self-host vs. managed. Mas gusto ang Docker/K8s/Helm at isang proxy na compatible sa OpenAI? Subukan ang LiteLLM. Gusto ng hosted speed + visibility ng marketplace? Isaalang-alang ang ShareAI o OpenRouter.

- Lawak lampas sa chat. Kung kailangan mo ng OCR, pagsasalita, pagsasalin, o pag-parse ng dokumento kasabay ng LLM chat, ang isang multimodal orchestrator tulad ng Eden AI ay nakakatulong.

- Routing na nakabatay sa datos. Kung mas gusto mo ang live benchmarks upang gabayan ang gastos/bilis/kalidad ayon sa rehiyon o workload, suriin ang Unify.

Pinakamahusay na mga alternatibo sa RouteLLM (mabilisang pagpili)

ShareAI (ang aming pinili para sa transparency ng marketplace + ekonomiya ng tagabuo)

Isang API sa isang malaking katalogo ng mga modelo/provider na may instant failover at isang marketplace na nagpapakita ng presyo, latency, uptime, availability bago ka mag-route. Magsimula nang mabilis sa Palaruan, kunin ang mga susi sa Konsol, mag-browse Mga Dokumento, at ihambing ang mga opsyon sa Mga Modelo.

Eden AI (multimodal na tagapag-ayos)

Unified API sa iba't ibang LLMs kasama imahe, OCR/doc parsing, pagsasalita, at pagsasalin—kasama ang paghahambing ng modelo, pagmamanman, caching, at batch processing.

OpenRouter (cache-aware na pagruruta)

Hosted router sa maraming LLMs na may prompt caching at provider stickiness upang muling magamit ang warm contexts; bumabagsak kapag hindi available ang isang provider.

Portkey (policy & SRE ops sa gateway)

AI gateway na may programmable fallbacks, rate-limit playbooks, at semantic cache—kasama ang detalyadong traces/metrics para sa kontrol ng produksyon.

Kong AI Gateway (pamamahala at pag-audit sa gilid)

Dalhin ang mga AI plugin, patakaran, at analytics sa Kong ecosystem; isang malakas na tugma kapag kailangan mo ng sentralisadong edge controls sa iba't ibang koponan.

Pag-isahin (data-driven router)

Universal API na may live benchmarks upang i-optimize ang gastos/bilis/kalidad ayon sa rehiyon at workload.

Orq.ai (eksperimentasyon at LLMOps)

Mga eksperimento, mga evaluator (kasama ang RAG metrics), mga deployment, at RBAC/VPC—magaling kapag kailangang magsama ang pagsusuri at pamamahala.

LiteLLM (self-hosted proxy/gateway)

Open-source, OpenAI-compatible proxy na may mga budget/limitasyon, logging/metrics, at isang Admin UI. I-deploy gamit ang Docker/K8s/Helm; ikaw ang may hawak ng operasyon.

Malalimang pagsusuri: mga nangungunang alternatibo sa RouteLLM

ShareAI (API ng AI na Pinapagana ng Tao)

Ano ito. Isang provider-first AI network at pinag-isang API. Mag-browse ng malaking katalogo ng mga modelo/provider at mag-route na may instant failover. Ang marketplace ay nagpapakita ng presyo, latency, uptime, at availability sa isang lugar upang mapili mo ang tamang provider bago ang bawat ruta. Simulan sa Palaruan, lumikha ng mga key sa Konsol, at sundan ang API quickstart sa Mga Dokumento. Mag-browse sa Pamilihan ng Modelo.

- Transparency ng marketplace — tingnan ang presyo/latency/uptime/availability nang maaga.

- Katatagan-sa-default — mabilis na failover sa susunod na pinakamahusay na provider kapag may isang blip.

- Ekonomiya na nakahanay sa tagabuo — karamihan ng gastusin ay napupunta sa mga provider ng GPU na nagpapanatili ng mga modelo online.

- Walang hadlang na simula — subukan sa Playground, pagkatapos ay ipadala.

Katotohanan ng provider (kumita sa pamamagitan ng pagpapanatili ng mga modelo online). Ang sinuman ay maaaring maging isang provider (Komunidad o Kumpanya). Mag-onboard gamit ang Windows/Ubuntu/macOS o Docker. Mag-ambag ng idle-time bursts o magpatakbo ng palaging naka-on. Pumili ng mga insentibo: Rewards (pera), Exchange (tokens/AI Prosumer), o Mission (mag-donate ng % sa mga NGO). Tingnan ang Gabay sa Provider o buksan ang Dashboard ng Provider.

Perpekto para sa. Mga koponan ng produkto na nais ang transparency ng marketplace, katatagan, at espasyo upang lumago sa mode ng provider—nang walang vendor lock-in.

Eden AI

Ano ito. Isang unified API na sumasaklaw sa LLMs + pagbuo ng imahe + OCR/pagsusuri ng dokumento + pagsasalita + pagsasalin upang hindi mo na kailangang magtahi ng maraming vendor SDKs. Binibigyang-diin din nila ang paghahambing ng modelo, pagsubaybay, at batching.

Magandang akma kapag. Ang iyong roadmap ay multimodal at nais mong i-orchestrate ang OCR/pagsasalita/pagsasalin kasabay ng LLM chat.

Mga dapat bantayan. Kung kailangan mo ng tanawin ng marketplace bawat kahilingan (presyo/latency/uptime/availability) o ekonomiya sa antas ng provider, ipares ang isang marketplace router tulad ng ShareAI.

OpenRouter

Ano ito. Isang unified LLM router na may provider/model routing at pag-cache ng prompt. Sa caching na naka-enable, ang OpenRouter ay may tendensiyang panatilihin ka sa parehong provider upang magamit muli ang warm contexts; kung ang provider na iyon ay hindi magagamit, ito ay bumabagsak. Sinusuportahan din nito ang mga strategy hints (hal., price-weighted).

Magandang akma kapag. Nais mo ng hosted speed at cache-aware routing upang mabawasan ang gastos at mapabuti ang throughput—lalo na sa mga high-QPS chat workloads na may mga ulit-ulit na prompt.

Mga dapat bantayan. Para sa malalim na enterprise governance (SIEM exports, org-wide policy), maraming koponan ang nagpapareha ng OpenRouter sa Portkey o Kong AI Gateway.

Portkey

Ano ito. Isang AI gateway na may programmable fallbacks, rate-limit playbooks, at simple/semantic cache, kasama ang traces/metrics para sa SRE-style control. Ang semantic cache ay partikular na kapaki-pakinabang para sa mga maikling prompt/mensahe kapag ang mga similarity thresholds ay mahusay na na-tune.

Magandang akma kapag. Kailangan mo ng policy-driven routing na may first-class observability, at komportable kang mag-operate ng gateway layer sa harap ng isa o higit pang routers/marketplaces.

Kong AI Gateway

Ano ito. Isang edge gateway na nagdadala ng AI plugins, policy, at analytics sa ecosystem ng Kong (sa pamamagitan ng Konnect o self-managed). Kung ang iyong API platform ay umiikot na sa paligid ng Kong at kailangan mo ng central policy/audit, ito ay isang malakas na akma.

Magandang akma kapag. Ang edge governance, auditability, data residency, at centralized controls ay hindi maaaring ikompromiso sa iyong kapaligiran.

Pag-isahin

Ano ito. Isang data-driven router na nag-o-optimize ng gastos/bilis/kalidad gamit ang live benchmarks, ina-adjust ayon sa rehiyon at workload.

Magandang akma kapag. Nais mo ng benchmark-guided selection na patuloy na umaangkop sa real-world performance.

Orq.ai

Ano ito. Isang generative AI collaboration + LLMOps platform: mga eksperimento, mga evaluator (kabilang ang RAG metrics), mga deployment, at RBAC/VPC. Mahusay kapag ang pagsusuri at pamamahala ay kailangang magkasama.

Magandang akma kapag. Kailangan mo ng eksperimento + pagsusuri sa pamamahala sa isang lugar—pagkatapos ay i-deploy nang direkta mula sa parehong surface.

LiteLLM

Ano ito. Isang open-source proxy/gateway na may OpenAI-compatible endpoints, budgets & rate limits, logging/metrics, at Admin UI. I-deploy gamit ang Docker/K8s/Helm; panatilihin ang traffic sa iyong sariling network.

Magandang akma kapag. Gusto mo ng self-hosting at buong kontrol sa infra na may simpleng compatibility para sa mga sikat na OpenAI-style SDKs.

Mga dapat bantayan. Tulad ng anumang OSS gateway, ikaw ang may-ari ng operasyon at mga upgrade.

Mabilisang pagsisimula: tawagan ang isang modelo sa loob ng ilang minuto (ShareAI)

Magsimula sa Palaruan, pagkatapos kunin ang isang API key at ipadala. Mga Sanggunian: Mabilis na pagsisimula ng API • Docs Tahanan • Mga Paglabas.

#!/usr/bin/env bash"

// ShareAI — Chat Completions (JavaScript, Node 18+);

Tip sa Migration. I-map ang iyong kasalukuyang RouteLLM-selected models sa ShareAI equivalents, i-mirror ang request/response shapes, at magsimula sa likod ng isang feature flag. Magpadala ng 5–10% ng traffic muna, ihambing ang latency/cost/quality, pagkatapos ay mag-ramp. Kung nagpapatakbo ka rin ng gateway (Portkey/Kong), tiyakin na ang caching/fallbacks ay hindi mag-double-trigger sa pagitan ng mga layer.

Paghahambing sa isang tingin

| Plataporma | Naka-host / Sariling-host | Pag-route at Mga Pagbagsak | Pagmamasid | Lawak (LLM + higit pa) | Pamamahala / Patakaran | Mga Tala |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Natutunang router; kliyente/server na tugma sa OpenAI | CLI/logs; pokus sa pananaliksik | LLM-sentriko | Patakaran sa pamamagitan ng iyong infra | Mahusay para sa mga research-grade cost-savers; dalhin ang iyong sariling edge controls. |

| IbahagiAI | Hosted + network ng provider | Agarang failover; pagpili na ginagabayan ng marketplace | Mga log ng paggamit; mga istatistika ng marketplace | Malawak na katalogo ng modelo | Mga kontrol sa antas ng provider | Marketplace na Pinapagana ng Tao; magsimula sa Palaruan at Mga Modelo. |

| Eden AI | Naka-host | Lumipat ng mga provider; batch; caching | Pagsubaybay sa Gastos at API | LLM + imahe + OCR + pagsasalita + pagsasalin | Sentralisadong pagsingil/pamamahala ng susi | Multimodal na tagapag-ayos. |

| OpenRouter | Naka-host | Pag-ruta ng provider/model; pag-cache ng prompt; katapatan sa provider | Impormasyon sa antas ng kahilingan | LLM-sentriko | Mga patakaran ng provider | Muling paggamit ng cache; fallback kapag hindi magagamit. |

| Portkey | Hosted Gateway | Mga fallback ng patakaran; mga playbook ng rate-limit; semantic cache | Mga trace/metric | LLM-una | Mga configuration ng gateway | Mga guardrail na istilo ng SRE. |

| Kong AI Gateway | Sariling-host/Enterprise | Upstream routing gamit ang AI plugins | Metrics/audit gamit ang Kong | LLM-una | Malakas na pamamahala sa edge | Komponent ng Infra; pares sa mga router/marketplace. |

| Pag-isahin | Naka-host | Pag-ruta na nakabatay sa data ayon sa gastos/bilis/kalidad | Tagapagsiyasat ng benchmark | LLM-sentriko | Mga patakaran ng router | Pagpili na ginagabayan ng benchmark. |

| Orq.ai | Naka-host | Mga retries/fallbacks sa orkestrasyon | Analytics ng platform; mga evaluator ng RAG | LLM + RAG + evals | Mga opsyon sa RBAC/VPC | Pokus sa kolaborasyon at eksperimento. |

| LiteLLM | Sariling-host/OSS | Subukang muli/pagbagsak; mga badyet/mga limitasyon | Pag-log/mga sukatan; Admin UI | LLM-sentriko | Buong kontrol sa infra | Tugma sa OpenAI; Docker/K8s/Helm deploy. |

FAQs: RouteLLM vs. ang iba pa

RouteLLM vs ShareAI — alin ang mas mabuti?

Pumili IbahagiAI kung gusto mo ng transparent na marketplace na nagpapakita presyo/latency/uptime/availability bago ang bawat ruta, dagdag pa agarang failover at ekonomiya na nakahanay sa tagabuo. Piliin RouteLLM kung mas gusto mo ang isang research-driven, natutunang router at komportable kang magpatakbo ng infra sa paligid nito (gateways, logging, audit). Magsimula sa Palaruan at Pamilihan ng Modelo.

RouteLLM vs Eden AI — ano ang pagkakaiba?

Eden AI sumasaklaw sa LLMs at multimodal (vision/OCR, speech, translation) na may paghahambing at pagsubaybay. RouteLLM nakatuon sa natutunang routing para sa LLMs. Kung ang iyong roadmap ay nangangailangan ng OCR/speech/translation sa ilalim ng isang API, pinapasimple ng Eden AI ang paghahatid; kung ang routing research ang prayoridad, angkop ang RouteLLM. Ipares sa ShareAI kapag gusto mo ng transparency ng marketplace sa bawat kahilingan.

RouteLLM vs OpenRouter — kailan pipiliin ang bawat isa?

Pumili OpenRouter kailan pag-cache ng prompt at mahalaga ang reuse ng warm-cache (may tendensiyang panatilihin ka sa parehong provider, at bumabawi sa mga outage). Piliin RouteLLM para sa natutunang mga polisiya na ikaw mismo ang nagpapatakbo. Maraming stack ang nagpapareha ng OpenRouter sa isang gateway para sa polisiya/observability—at ginagamit pa rin ang ShareAI kapag gusto nila ng transparency ng marketplace bago ang bawat ruta.

RouteLLM vs Portkey — router o gateway?

RouteLLM ay isang router. Portkey ay isang tarangkahan: mahusay ito sa polisiya/guardrails (fallback playbooks, semantic cache) at detalyadong traces/metrics. Maraming team ang nagpapatakbo ng pareho: isang gateway para sa polisiya ng buong organisasyon + isang router/marketplace para sa pagpili ng modelo at kontrol sa gastos. Ang ShareAI ay mahusay na ipares dito kapag gusto mo ng visibility ng marketplace bago ang ruta.

RouteLLM vs Kong AI Gateway — sino ang nangangailangan ng alin?

Pumili Kong AI Gateway kailan pamamahala sa gilid (sentralisadong polisiya/audit, data residency) ay hindi maaaring tawaran. Panatilihin RouteLLM sa likod nito kung gusto mo pa rin ng natutunang routing para sa presyo/performance. Gamitin IbahagiAI kasabay kapag gusto mong pumili ng mga provider sa pamamagitan ng presyo/latency/uptime/availability bago ang bawat ruta.

RouteLLM vs Unify — ano ang kakaiba tungkol sa Unify?

Pag-isahin gumagamit ng live benchmarks at dynamic policies upang i-optimize para sa gastos/bilis/kalidad. Kung gusto mo ng data-driven na pagpili na nagbabago ayon sa rehiyon/workload, ang Unify ay kapani-paniwala; RouteLLM nakatuon sa mga natutunang routing model na ikaw ang nagho-host. Gamitin IbahagiAI kapag mas gusto mong pumili ng mga provider na may marketplace view at instant failover.

RouteLLM vs Orq.ai — alin para sa evaluation & RAG?

Orq.ai nagbibigay ng experimentation/evaluation surface (kasama ang mga RAG evaluator), plus deployments at RBAC/VPC. Kung kailangan mo ng LLMOps + evaluators, maaaring magkomplement o palitan ng Orq.ai ang isang purong router sa simula. Dalhin IbahagiAI kapag gusto mo ng pagpili ng provider na may marketplace transparency at resilience sa production.

RouteLLM vs LiteLLM — naka-host vs self-hosted?

RouteLLM ay OSS routing logic; LiteLLM ay isang OpenAI-compatible proxy/gateway na may budgets, rate limits, at isang Admin UI—magaling kung gusto mong panatilihin ang traffic sa loob ng iyong VPC at kontrolin ang control plane. Madalas na pinagsasama ng mga team ang LiteLLM para sa self-hosting kasama ang IbahagiAI para sa marketplace visibility at instant failover sa mga provider.

Alin ang pinakamura para sa aking workload: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Depende ito sa pagpili ng modelo, rehiyon, cacheability, at mga pattern ng trapiko. Mga router tulad ng ShareAI/OpenRouter maaaring magpababa ng gastos sa pamamagitan ng routing at cache-aware stickiness; mga gateway tulad ng Portkey magdagdag ng semantic caching; LiteLLM nagpapababa ng overhead ng platform kung komportable kang patakbuhin ito. Benchmark gamit ang ang iyong mga prompt at subaybayan epektibong gastos bawat resulta—hindi lamang ang listahan ng presyo.

Ano ang RouteLLM?

Isang open-source na framework para sa pagserbisyo at pagsusuri ng mga LLM router; naglalaman ng mga sinanay na router at mga landas na compatible sa OpenAI; madalas na binabanggit na makabuluhang nagpapababa ng gastos habang pinapanatili ang kalidad na malapit sa GPT-4 sa mga gawain tulad ng MT-Bench.

Ano ang pinakamabilis na paraan upang subukan ang ShareAI nang walang buong integrasyon?

Buksan ang Palaruan, pumili ng modelo/provider, at patakbuhin ang mga prompt sa browser. Kapag handa na, lumikha ng isang key at ilagay ang mga cURL/JS snippet sa itaas sa iyong app.

Maaari ba akong maging tagapagbigay ng ShareAI at kumita?

Oo. Sinuman ay maaaring mag-onboard bilang Komunidad or Kumpanya provider gamit ang Windows/Ubuntu/macOS o Docker. Mag-ambag idle-time bursts o magpatakbo laging-naka-on. Pumili ng mga insentibo: Mga Gantimpala (pera), Palitan (mga token/AI Prosumer), o Misyon (mag-donate ng % sa mga NGO). Tingnan ang Gabay sa Provider o buksan ang Dashboard ng Provider.

Konklusyon

Habang RouteLLM ay isang malakas na OSS router, ang iyong pinakamahusay na pagpipilian ay nakadepende sa mga prayoridad:

- Transparency ng Marketplace + katatagan: IbahagiAI

- Multimodal na saklaw sa ilalim ng isang API: Eden AI

- Routing na may kamalayan sa cache sa naka-host na anyo: OpenRouter

- Patakaran/mga guardrail sa gilid: Portkey o Kong AI Gateway

- Routing na nakabatay sa data: Pag-isahin

- LLMOps + mga tagasuri: Orq.ai

- Self-hosted na control plane: LiteLLM

Kung presyo/latency/uptime/availability bago ang bawat ruta, agarang failover, at ekonomiyang nakahanay sa tagabuo ay nasa iyong checklist, buksan ang Palaruan, lumikha ng API key, at mag-browse sa Pamilihan ng Modelo upang i-route ang iyong susunod na kahilingan sa matalinong paraan.