AI Gateway vs Vercel AI Gateway: Bakit Panalo ang BYOI ng ShareAI

ShareAI AI Gateway vs Vercel AI Gateway: Ano Ito, Bakit Ito Mahalaga, at Paano Naiiba ang ShareAI

AI Gateway ay mabilis na nagiging nawawalang layer sa pagitan ng mga app at magulong mundo ng mga vendor ng modelo, mga susi, mga quota, at mga outage. Ang gabay na ito ay nagpapaliwanag kung ano ang AI gateway, nagbubuod ng Vercel AI Gateway, at ipinapakita kung paano ang bukas na network ng ShareAI, 70% provider payouts, at BYOI (Bring Your Own Infrastructure) na may Prayoridad sa aking Device lumikha ng ibang landas para sa mga team na nangangailangan ng pagsunod, elasticity, at pagpipilian.

Ano ang AI Gateway (at bakit ginagamit ito ng mga team)

Ang AI gateway ay nakaposisyon sa pagitan ng iyong application at maraming provider ng modelo. Nag-aalok ito ng isang endpoint, policy-based routing (gastos, latency, pagsunod), unified key at rate-limit management, automatic failover, at end-to-end observability. Para sa mga production app (agents, RAG, chat, search) binabawasan nito ang vendor lock-in at pinapanatili ang iyong code mula sa hardwiring sa isang API.

Vercel AI Gateway: ang mabilisang pagkuha

Inanunsyo ng Vercel ang gateway nito noong Mayo 20, 2025 upang pag-isahin ang access sa maraming modelo sa likod ng isang endpoint at ang AI SDK. Binibigyang-diin nito ang simpleng paglipat ng modelo, failover, at low-latency routing, na may dalhin-ang-sariling-susi at walang token markup na binanggit sa independiyenteng coverage. Tingnan ang orihinal na post at recap: Vercel blog at Buod ng InfoQ.

Kung saan pinakamahusay na angkop ang Vercel: mga team na naka-standardize na sa Vercel + AI SDK na nais ng isang makintab, single-vendor gateway sa loob ng ekosistem na iyon na may built-in na logs, metrics, at failover.

Paano naiiba ang Gateway ng ShareAI

1) Bukas na network (hindi lamang “malalaking” inference vendors)

Ang ShareAI ay ang people-powered AI API. Anumang kwalipikadong provider (komunidad o kumpanya) ay maaaring lumahok, kaya’t hindi ka limitado sa iilang sentralisadong ulap. Nangangahulugan ito ng mas malawak na pagpipilian ng modelo, espesyal na hardware, at rehiyonal na pagkakaiba-iba. Ihambing ang mga opsyon sa Pamilihan ng Modelo o mag-recruit ng mga bagong provider sa pamamagitan ng Gabay sa Provider.

2) Ekonomiyang kaaya-aya sa provider (70% bayad kada inference)

Binabayaran ng ShareAI ang mga provider 70% ng bawat inference. Ang mga insentibo para sa uptime at kalidad ay nagpapalago ng kapasidad ng network habang pinapanatili ang pagiging epektibo ng presyo. Maaaring magpatakbo ang mga provider ng idle-time o always-on, magtakda ng mga presyo, at kahit mag-donate ng porsyento sa mga NGO.

| Item | Halaga |

|---|---|

| Presyo na sinisingil sa user | $1.00 |

| Binayaran sa provider (70%) | $0.70 |

| Serbisyo at overhead ng ShareAI | $0.30 |

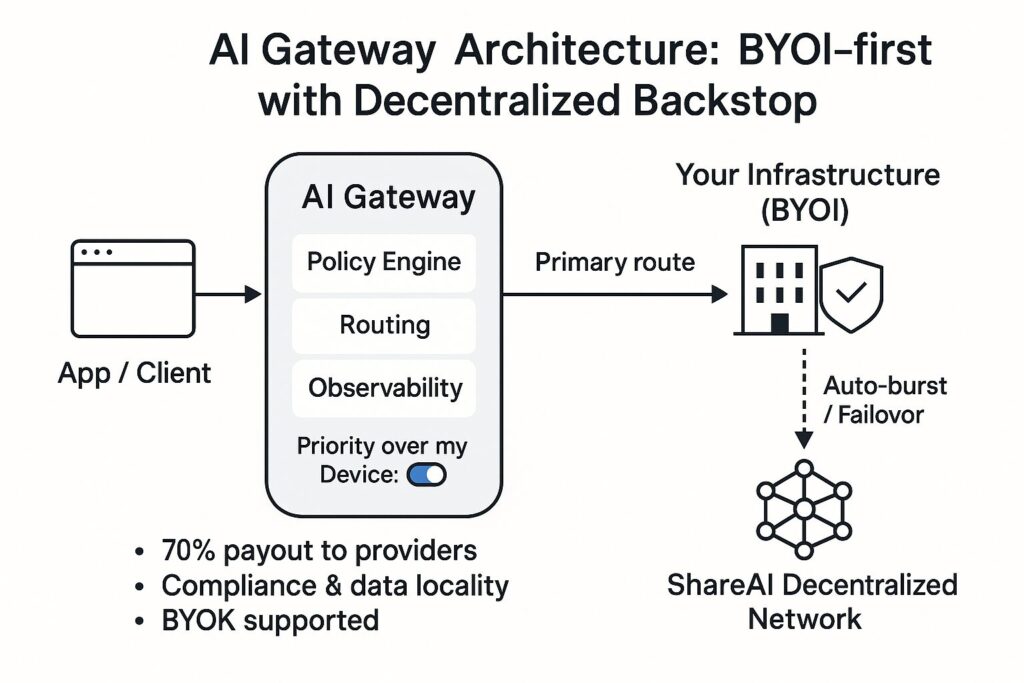

3) BYOI na may compliance-priority routing (“Prayoridad sa aking Device”)

Dalhin ang iyong sariling imprastraktura (on-prem o cloud) at panatilihin ang sensitibong mga workload sa ilalim ng iyong kontrol. Sa Prayoridad sa aking Device toggle, ang iyong imprastraktura ay unang tumatakbo; ang ShareAI ay sumusuporta lamang kapag kailangan mo ng karagdagang kapasidad—kumikilos bilang isang global load balancer. Pinapanatili nitong simple ang data locality at pagsunod habang pinapanatili ang elasticity.

Paganahin ang Prayoridad sa aking Device (bawat API key)—buksan ang API Key pahina sa Console at i-toggle Prayoridad sa aking Device para sa key na ginagamit ng iyong app. Kapag NAKA-ON, ang ShareAI ay nagre-route muna sa iyong mga nakakonektang device; kapag walang kwalipikado, ang mga kahilingan ay babalik sa decentralized network. Tingnan ang Prayoridad sa aking Device na gabay at ang Gabay ng Gumagamit ng Console.

4) Agarang sukat + idle na monetization

Kapag tumaas ang trapiko, bumubulusok ka sa decentralized network ng ShareAI nang walang warm-up. Kapag idle ang iyong infra, maaari kang mag-opt-in upang kumita sa pamamagitan ng pagbibigay ng kapasidad pabalik sa network. Ito ay isang panalo para sa mga organisasyon (agarang sukat at pagsunod), isang panalo para sa mga provider (kita), at isang panalo para sa mga user (mas maraming pagpipilian sa gastos/latency).

Vercel AI Gateway vs ShareAI: magkatabi

| Kakayahan | Vercel AI Gateway | IbahagiAI |

|---|---|---|

| Lawak ng network | Isang endpoint para sa maraming modelo sa mga pangunahing vendor (mga detalye). | Bukas na network: mga pangunahing vendor kasama mga independyente/pangkomunidad na provider (mag-browse ng mga modelo). |

| BYOI at prayoridad sa on-prem | Pokus sa routing/maaasahan; SDK-sentriko. BYOK itinampok sa saklaw (InfoQ). | BYOI-una. Per-key toggle Prayoridad sa aking Device ginagawang unang hop ang iyong infra (paano ito gumagana). |

| Failover | Awtomatikong failover sa iba't ibang provider (InfoQ). | Desentralisadong backstop sa maraming provider/rehiyon; overflow na pinapatakbo ng patakaran. |

| Ekonomiya | BYOK na may 0% markup ng token sa pag-uulat (InfoQ). | 70% payout sa mga provider; malinaw na insentibo ng marketplace. |

| Pagmamasid | Logs, metrics, pagsubaybay sa gastos na naka-embed. | Telemetry sa antas ng kahilingan + mga signal ng marketplace (latency, uptime, reputasyon). |

| Karanasan ng developer | Mahigpit na integrasyon ng AI SDK; minimal na code para magpalit ng mga modelo. | REST/SDKs, mga kontrol sa patakaran sa Console; mabilisang simula sa Sanggunian ng API. |

| Pinakamainam na akma | Mga Vercel-native stack na nais ng pinagsamang gateway + SDK DX. | Mga koponan na nangangailangan ng compliance-priority BYOI, decentralized elasticity, at kita ng provider. |

Paano nagra-route ang ShareAI sa ilalim ng hood

Daloy ng kahilingan: (1) Suriin ang patakaran at susi — ang per-key toggle ang nagtatakda ng iyong unang hakbang. (2) Compliance-priority routing — kung ang iyong cluster/device ay online at model-eligible, ito ang maglilingkod sa kahilingan. (3) Ang mga pagsusuri sa kalusugan/latency ay patuloy na nagmo-monitor ng performance. (4) Decentralized fallback — overflow sa network ng ShareAI kapag kinakailangan.

Onboarding ng provider at kalidad: sumali bilang Community o Company gamit ang Windows/Ubuntu/macOS/Docker installers; isinasaalang-alang ng reputasyon ang uptime, latency, at benchmark tiers. Kinokontrol ng mga provider ang pagpepresyo at nakakakuha ng exposure sa pamamagitan ng pagtugon sa mga SLO. Tingnan ang Gabay sa Provider.

Mabilisang simula: gamitin ang ShareAI bilang iyong AI Gateway

- Gumawa ng API key sa Console.

- I-toggle Prayoridad sa aking Device ON para sa susi na iyon kung ang iyong infra ay kailangang mauna.

- Magpadala ng kahilingan gamit ang Mabilis na pagsisimula ng API o subukan ito sa Palaruan.

curl -X POST https://api.shareai.now/v1/chat/completions \"Mula rito, palitan ang mga modelo sa pamamagitan ng pagbabago ng modelo identifier. Panoorin ang latency, gastos, at routing sa Gabay ng Gumagamit ng Console, pagkatapos tuklasin ang mga bagong release sa Mga Paglabas.

Kailan pipiliin ang ShareAI kaysa sa Vercel AI Gateway (at kailan hindi)

Piliin ang ShareAI kung kailangan mo ng BYOI na may routing na nakatuon sa pagsunod sa regulasyon (Prayoridad sa aking Device), decentralized elasticity para sa traffic spikes, at kita ng provider/org (70% payout, idle-time monetization).

Piliin ang Vercel AI Gateway kung gusto mo ng Vercel-native na karanasan gamit ang AI SDK, pinagsamang billing/observability sa loob ng platform na iyon, at simpleng failover na naka-embed (Recap ng InfoQ).