Pinakamahusay na Moonshot AI Kimi K2.5 na alternatibo para sa mga startup at developer sa 2026 (at kung paano mabilis na magpalit ng mga modelo gamit ang isang ShareAI gateway)

Moonshot AI’s Kimi K2.5 ay isa sa mga release na agad na nagbabago ng vibe sa mga open models: multimodal, agentic, long-context, at tunay na kapaki-pakinabang para sa mga workflow ng “tunay na trabaho”. Kung ikaw ay nagsasaliksik ng mga alternatibo sa Kimi K2.5, malamang hindi mo kinukwestyon ang kapangyarihan nito—ang kinukwestyon mo ay ang akma nito.

Ang pinakamahusay na alternatibo ay nakadepende sa kung ano ang iyong ipinapadala: isang coding agent, isang long-document analyst, isang tool-using research bot, o isang production feature kung saan mas mahalaga ang pagiging maaasahan at predictability ng gastos kaysa sa raw specs. At dahil ang pagpepresyo at kalidad ng modelo ay maaaring mabilis magbago, ang pangmatagalang panalo ay panatilihing ang iyong produkto ay model-switchable—hindi naka-lock sa isang vendor o modelo lamang.

Ang gabay na ito ay sumasaklaw sa pinakamalalakas na alternatibo sa Kimi K2.5 para sa mga startup at developer, kasama kung paano madaling magpalit ng mga modelo gamit ang isang AI gateway tulad ng IbahagiAI.

Mabilisang paghahambing ng mga alternatibo sa Kimi K2.5

Narito ang isang praktikal na maikling listahan, inayos batay sa karaniwang pangangailangan ng mga team sa produksyon. Isipin ito bilang iyong “subukan muna ang mga ito” na mapa.

| Opsyon | Pinakamahusay para sa | Bakit pinipili ito ng mga team kaysa sa Kimi K2.5 | Mga tradeoff |

|---|---|---|---|

| DeepSeek-V3.2 | Pangangatwiran + mga ahente sa mas mababang badyet | Pokus sa pangangatwiran muna na may mga mode na kaaya-aya sa ahente | Kailangan mo pa rin ng mga pagsusuri; nag-iiba ang pag-uugali depende sa configuration |

| GLM-4.7 | Mga daloy ng trabaho ng ahente + pagbuo ng UI | Malakas na “spec → UI” na mga hilig at pagiging maaasahan ng multi-step na daloy ng trabaho | Nag-iiba ang pagiging mature ng ecosystem depende sa stack/provider |

| Devstral 2 | Mga ahente ng code / mga daloy ng trabaho ng SWE | Dalubhasa para sa mga gawain sa software engineering na may kamalayan sa repo | Mas makitid na pokus kaysa sa mga modelong generalist |

| Claude Opus 4.5 | Pangangatwiran na may mataas na pusta + pag-coding | Premium na pagiging maaasahan at malakas na pagganap para sa kritikal na trabaho | Mas mataas na gastos; mga limitasyon ng saradong modelo |

| Grok 4.1 Mabilis | Malawak na konteksto + pagtawag ng tool | Dinisenyo para sa ultra-habang konteksto at mga kasangkapan ng ahente | Saradong modelo; maaaring magbago ang estilo/boses na akma |

| ShareAI (gateway) | Nanatiling modelo-agnostiko | Isang API para sa maraming modelo; palitan ang mga modelo nang walang muling pagsulat | Hindi isang modelo mismo—isang layer ng imprastraktura |

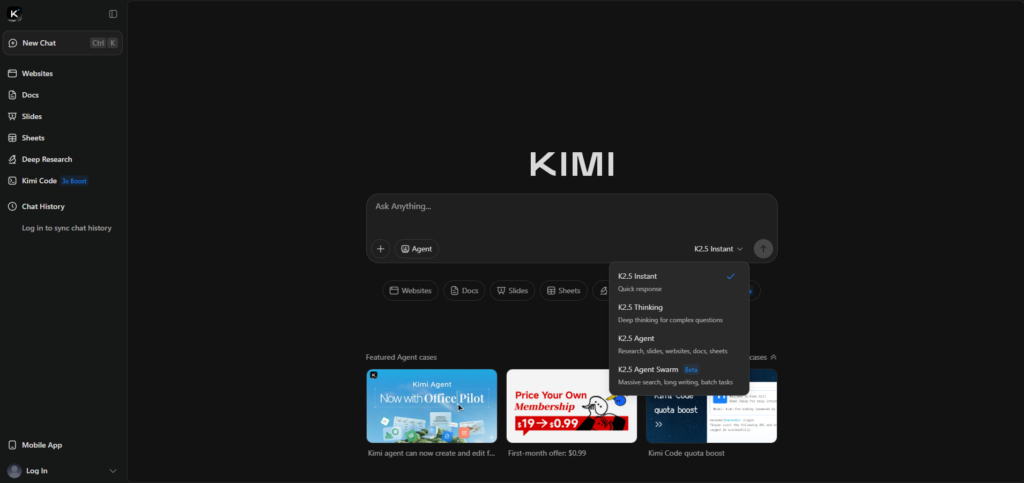

Ano ang Kimi K2.5 ng Moonshot AI?

Ang Kimi K2.5 ay isang pangunahing modelo mula sa Moonshot AI, na ibinebenta bilang “open source,” na may diin sa multimodal na pangangatwiran at agentic na pagpapatupad. Ang opisyal na pahina ng paglabas ay nagtatampok ng multimodal na input (kasama ang video) at “Agent Swarm” na istilo ng parallelization para sa mga kumplikadong gawain.

Kung nais mo ang opisyal na listahan ng tampok at konteksto ng paglabas, magsimula dito: Kimi K2.5 (Moonshot AI).

Bakit naghahanap ang mga tao ng alternatibo sa Kimi K2.5

Karamihan sa mga koponan ay hindi lumilipat dahil “masama” ang Kimi. Lumilipat sila dahil nagbabago ang mga limitasyon kapag lumipat mula demo patungo sa produksyon.

- Kailangan mo ng pinakamahusay na pagiging maaasahan sa pag-coding para sa mga pagbabago sa maraming file, pag-aayos ng bug, o mga workflow na may kamalayan sa repo.

- Kailangan mo ng malaking konteksto (mga kontrata, mga knowledge base, mga repos) nang walang marupok na mga estratehiya sa paghahati.

- Gusto mo ng mas mababang pagkakaiba-iba para sa mga kritikal, nakaharap sa customer, o mga workflow na may regulasyon.

- Ayaw mo ng pagkakakulong—gusto mong panatilihin ang leverage kapag nagbabago ang presyo, limitasyon, o kalidad.

Mga alternatibong open-weight (pinakamataas na kontrol)

DeepSeek-V3.2 (pangangatwiran + mga workflow ng ahente)

Ang DeepSeek-V3.2 ay isang malakas na pagpipilian kapag gusto mo ng isang “reasoning-first” na modelo para sa mga teknikal na gawain at mga pipeline ng ahente, lalo na kung sensitibo ka sa gastos. Madalas itong ginagamit bilang isang maaasahang modelo para sa pang-araw-araw na structured na pag-iisip at mga pattern ng paggamit ng tool.

Sanggunian: Mga tala ng paglabas ng DeepSeek API.

GLM-4.7 (mga workflow ng ahente + pagbuo ng UI)

Sulit subukan ang GLM-4.7 kung ang iyong produkto ay may kaugnayan sa “visual-to-code” at workflow execution angle ni Kimi. Madalas itong sinusuri ng mga koponan para sa multi-step na pag-uugali ng ahente at pagiging maaasahan ng pagbuo ng UI/front-end.

Sanggunian: Mga dokumento ng GLM-4.7.

Devstral 2 (mga ahente sa software engineering)

Kung ang iyong pangunahing pangangailangan ay end-to-end software engineering—multi-file edits, repo navigation, test fixing—ang Devstral 2 ay nakaposisyon bilang isang espesyalista. Ito ay isang malakas na alternatibo sa Kimi K2.5 kapag ang “coding agent” ang pangunahing trabaho, hindi multimodal generalism.

Sanggunian: Anunsyo ng Mistral Devstral 2.

Mga saradong modelo (frontier performance + enterprise posture)

Claude Opus 4.5 (mataas na antas ng pangangatwiran/pag-code)

Ang Claude Opus 4.5 ay isang karaniwang pagpipilian na “magbayad para sa pagiging maaasahan” kapag mas mahalaga ang tamang resulta kaysa sa gastos. Kung ang iyong workload ay sensitibo sa banayad na mga error sa pangangatwiran o mga pagkakamali sa pag-code, isa ito sa pinakamalakas na premium na alternatibo sa Moonshot AI’s Kimi K2.5.

Sanggunian: Anthropic: Claude Opus 4.5.

Malawak na konteksto + mga alternatibo sa real-time na tool

Grok 4.1 Mabilis (ultra-habang konteksto + mga kasangkapan)

Ang Grok 4.1 Fast ay kapansin-pansin sa isang dahilan: ito ay binuo sa paligid ng napakahabang konteksto at agent tooling. Kung mayroon kang “basahin muna ang lahat” na mga workflow (malalaking repos, malalaking set ng dokumento), maaari itong maging isang nakakahikayat na alternatibong kategorya upang subukan kasabay ng Kimi K2.5.

Sanggunian: xAI: Grok 4.1 Mabilis.

Ang “cheat code” ng startup: huwag ipusta ang produkto sa isang modelo

Kahit na ang Kimi K2.5 ang iyong paborito ngayon, ang pagbuo ng iyong produkto upang makapagpalit ng mga modelo sa hinaharap ay ang pinakamahusay na pangmatagalang desisyon sa engineering. Nagbabago ang pagpepresyo, nangyayari ang mga outage, lumilitaw ang mga rate limit, at minsan ang mga modelo ay bumababa ang kalidad.

Isang simpleng, matibay na pattern ay: pumili ng default na modelo para sa karaniwang landas, isang espesyalistang modelo para sa mahihirap na kahilingan (coding agent o malawak na konteksto), at isang fallback na modelo para sa pagiging maaasahan. Ito mismo ang dapat gawing madali ng isang AI gateway.

Paano ginagawang mapagpalit ng ShareAI ang Kimi K2.5 at ang mga alternatibo nito

Ang ShareAI ay binuo para sa opsyonalidad ng modelo: isang OpenAI-compatible API sa isang malawak na katalogo, upang maikumpara at ma-route ang mga modelo nang hindi muling isinusulat ang mga integrasyon. Simulan sa Pamilihan ng Modelo, subukan ang mga prompt sa Palaruan, at mag-integrate sa pamamagitan ng Sanggunian ng API.

Kung ikaw ay nag-o-onboard ng isang team, ang Pangkalahatang-ideya ng Console ay isang mabilis na oryentasyon. Para sa pagpaplano ng produksyon, bantayan ang Mga Tala ng Paglabas at ang Gabay sa Provider.

Halimbawa: palitan ang modelo field (walang rewrite)

Ito ang pangunahing bentahe ng isang solong AI gateway: nananatili ang parehong hugis ng request ng iyong app, at pinapalitan mo ang mga modelo sa pamamagitan ng pagbabago ng isang field. Una, gumawa ng key sa Console: Gumawa ng API Key.

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Ngayon palitan lamang ang pangalan ng modelo (ang lahat ng iba pa ay nananatiling pareho):

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Sa isang workflow ng Kimi K2.5 alternatives, pinapayagan ka nitong magpatakbo ng mabilis na bake-offs, magdagdag ng fallbacks, at panatilihin ang leverage habang nagbabago ang landscape ng modelo.

Paano pumili ng tamang Kimi K2.5 alternative sa loob ng 30 minuto

- Tukuyin ang trabaho (ang code agent ay nag-aayos ng mga test, ang RAG ay sumasagot mula sa internal na mga dokumento, pagsusuri ng kontrata, UI-to-code).

- Gumawa ng maliit na eval set (10–30 prompt), kabilang ang mga failure case at edge case.

- Subukan ang 3–5 kandidato (Kimi K2.5 + dalawang espesyalista + isang murang fallback) at puntos para sa tamang sagot, pagiging maaasahan ng pag-format, katumpakan ng paggamit ng tool, at latency.

- Ipadala kasama ang fallback upang ang mga outage, limitasyon, at regression ay hindi maging mga insidente na nakikita ng user.

Kung nais mo ng malinis na panimulang punto para sa setup at pinakamahusay na mga kasanayan, i-bookmark ang ShareAI Dokumentasyon at ang Mabilis na pagsisimula ng API.

FAQ

Bukas na source o open-weight ba ang Kimi K2.5?

Ipinamamaligya ng Moonshot AI ang Kimi K2.5 bilang “open source” at naglalagay ng mga link sa pampublikong availability sa pamamagitan ng karaniwang mga OSS distribution channel. Sa praktika, maraming mga koponan ang gumagamit ng terminong bukas na timbang upang maging eksakto: ang mga timbang ay magagamit, ngunit ang lisensya at ang buong training stack ay maaaring magkaiba mula sa mga pamantayan ng “klasikong” open-source software.

Sanggunian: Opisyal na pahina ng Kimi K2.5.

Kailan ko dapat piliin ang Kimi K2.5 kaysa sa mga alternatibo?

Piliin ang Kimi K2.5 kapag ang iyong workload ay mabigat na multimodal (kasama ang video), agentic, at nakikinabang mula sa “swarm” na diskarte ng modelo sa paghahati ng malalaking gawain. Kung gumagawa ka ng UI-mula-sa-visual na mga workflow, ito rin ay isang natural na lugar upang magsimula.

Alin ang pinakamahusay na alternatibo para sa mga coding agent kumpara sa pangkalahatang coding?

Kung gumagawa ka ng isang repo-aware na agent na nag-eedit ng maraming file, nagpapatakbo ng mga pagsusuri, at umuulit, magsimula sa Devstral 2. Kung nais mo ng premium na “pinakamahusay na pagsisikap” na pagiging maaasahan para sa kumplikadong coding, ang Claude Opus 4.5 ay isang karaniwang benchmark na pagpipilian—lalo na para sa mga kritikal na landas.

Alin ang pinakamahusay na alternatibo para sa mahahabang dokumento at napakalaking konteksto?

Para sa mga workflow na “basahin muna ang lahat,” ang Grok 4.1 Fast ay nasa malaking-context bucket. Gayunpaman, maraming produkto ang mas mahusay gamit ang RAG kasama ang mas maliit na context window, kaya subukan ang parehong pamamaraan sa halip na ipagpalagay na laging panalo ang mas malaking context.

Paano ko maihahambing nang patas ang mga modelo?

Gamitin ang parehong set ng prompt, grading rubric, at mga setting (temperature, max tokens, formatting rules). I-grade bawat gawain: tamang sagot, format/JSON reliability, tool accuracy, latency, at gastos bawat matagumpay na resulta.

Ano ang pinakamabilis na paraan para mag-A/B test ng mga alternatibo ng Kimi K2.5 nang hindi nire-rebuild ang aking app?

I-standardize sa isang API interface at palitan ang modelo field. Gamit ang gateway tulad ng ShareAI, maaari mong ikumpara ang mga kandidato sa Palaruan at pagkatapos ipadala ang parehong request shape sa pamamagitan ng API.

Maaari ba akong mag-route batay sa “pinakamura” o “pinakamabilis”?

Iyan ang ideya sa likod ng policy-based routing: pumili ng modelo batay sa mga limitasyon tulad ng cost ceiling, latency target, o uri ng gawain. Kahit magsimula ka nang simple (manual model selection), ang pagbuo patungo sa routing policies ay nagpapanatili ng flexibility habang nagbabago ang mga provider at modelo.

Paano nakakatulong ang fallback models sa production?

Pinoprotektahan ka ng fallbacks mula sa mga pansamantalang pagkabigo, provider rate limits, mga isyung rehiyonal, at model regressions. Ang fallback strategy ay kadalasang mas mahalaga sa karanasan ng user kaysa sa paghabol sa nag-iisang “pinakamahusay” na modelo sa papel.

Paano ko makokontrol ang mga gastos?

Gumamit ng murang default na modelo para sa karaniwang landas, limitahan ang output tokens, at ireserba ang mga premium na modelo para sa mga request na talagang nangangailangan nito. Subaybayan ang gastos bawat matagumpay na resulta, hindi lamang ang gastos bawat token.

Kailangan ko bang mag-self-host para sa privacy o compliance?

Hindi palagi. Depende ito sa iyong data classification, residency needs, at vendor terms. Magsimula sa policy (kung anong data ang maaaring ipadala saan), pagkatapos pumili ng deployment approach na tumutugma dito.

Anong mga gawain ang patuloy na nakikinabang sa open-weight self-hosting?

Ang mga karaniwang dahilan ay kinabibilangan ng lokasyon ng data, predictable na latency, malalim na pagpapasadya, at mahigpit na integrasyon sa mga panloob na kagamitan at guardrails. Kung iyon ang iyong mga limitasyon, ang mga open-weight na modelo ay maaaring maging matibay na pundasyon—kung handa kang pangasiwaan ang mga operasyon.

Paano kung magbago ang pag-uugali ng modelo sa paglipas ng panahon?

Ipagpalagay na mangyayari ito. Panatilihin ang isang regression eval set, subaybayan ang quality drift, at tiyaking mabilis kang makakabalik sa pamamagitan ng pagpapalit ng mga modelo o provider.

Konklusyon: piliin ang pinakamahusay na modelo ngayon, panatilihin ang kakayahang magpalit bukas

Ang Kimi K2.5 ay isang seryosong modelo mula sa Moonshot AI, at para sa maraming mga koponan ito ay isang mahusay na baseline. Ngunit ang pinaka-produksyon-friendly na diskarte ay ang pagpili ng pinakamahusay na modelo para sa bawat trabaho—at panatilihin ang kakayahang magpalit kapag nagbago ang kalagayan.

Kung nais mo ang kakayahang umangkop na iyon nang walang patuloy na gawain ng reintegration, magsimula sa pamamagitan ng pag-browse sa Marketplace ng mga modelo, pagsubok sa Palaruan, at paggawa ng iyong account sa pamamagitan ng Mag-sign in / Mag-sign up. ::contentReference[oaicite:0]{index=0}