Maligayang pagdating sa GPT-OSS ng OpenAI sa ShareAI

Ang ShareAI ay nakatuon sa pagbibigay sa iyo ng pinakabago at pinakamakapangyarihang mga modelo ng AI—at ginagawa namin ito muli ngayon.

Ilang oras ang nakalipas, Ang OpenAI ay naglabas ng makabagong GPT-OSS mga modelo, at maaari mo nang simulan ang paggamit ng mga ito sa loob ng ShareAI network!

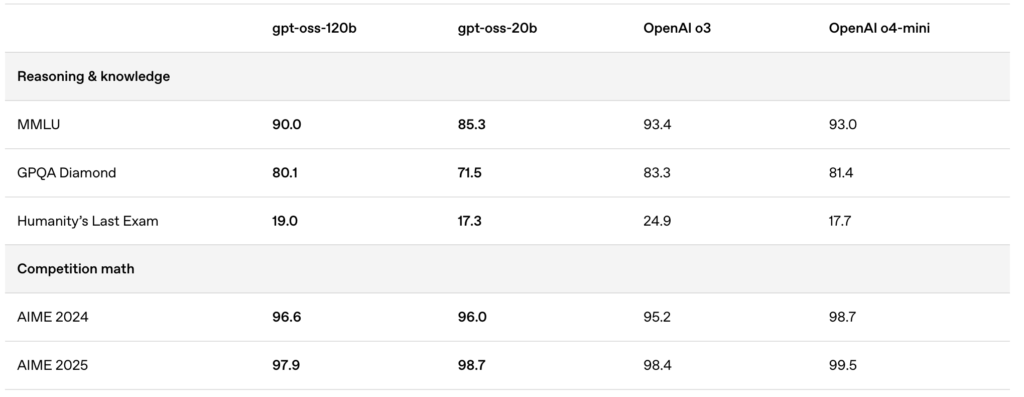

Ang bagong inilabas na mga modelo—gpt-oss:20b at gpt-oss:120b—nagbibigay ng pambihirang lokal na karanasan sa chat, makapangyarihang kakayahan sa pangangatwiran, at pinahusay na suporta para sa mga advanced na senaryo ng developer.

🚀 Simulan ang paggamit ng GPT-OSS sa ShareAI

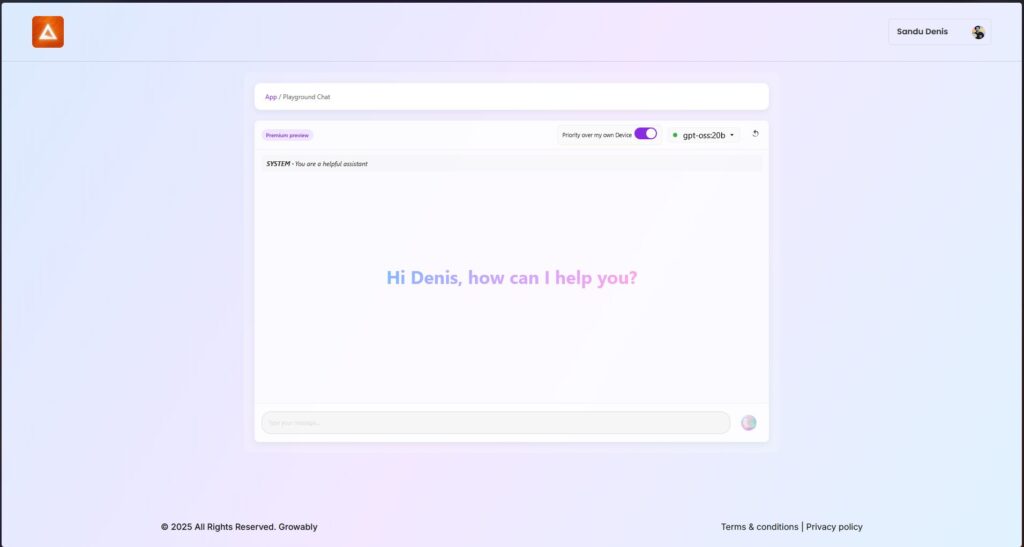

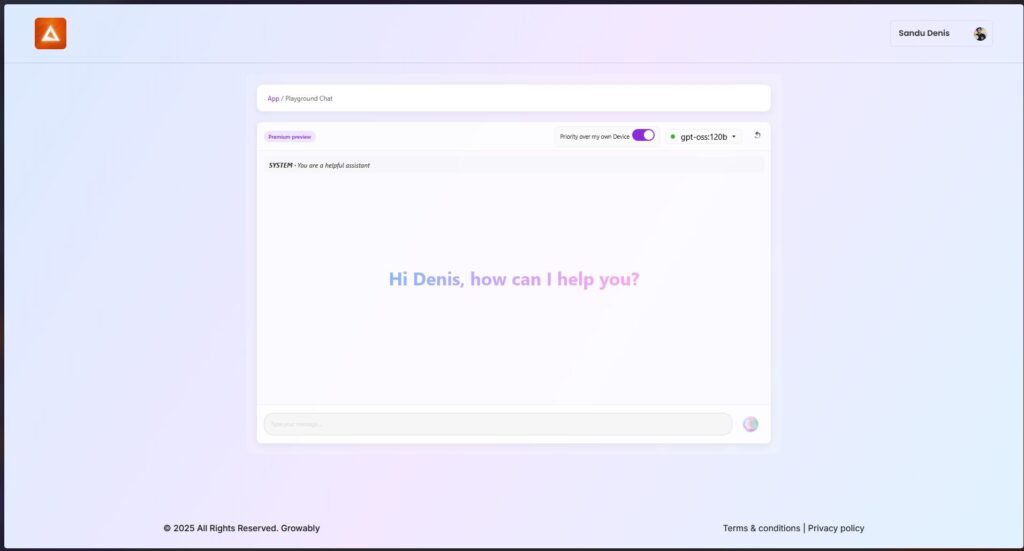

Maaari mong subukan ang mga modelong ito ngayon gamit ang pinakabagong bersyon ng Windows client ng ShareAI.

- I-download ang ShareAI para sa Windows (link sa pahina ng pag-download)

Pagkatapos ng pag-install, madali mong maida-download at mapatakbo ang mga modelo ng GPT-OSS nang direkta mula sa ShareAI app—walang komplikadong setup o konfigurasyon na kinakailangan.

✨ Mga Tampok ng GPT-OSS

Narito kung bakit ang GPT-OSS ay isang game-changer para sa iyong AI-driven workflows:

- Kakayahang Agentic:

Gamitin ang mga built-in na tampok para sa pagtawag ng function, pag-browse sa web, pagtawag ng Python tools, at mga output ng structured data. - Buong transparency sa chain-of-thought:

Makakuha ng malinaw na visibility sa proseso ng pangangatwiran ng modelo, na nagbibigay-daan sa mas madaling debugging at mas mataas na tiwala sa mga nabuong resulta. - Mga naa-configure na antas ng pangangatwiran:

Madaling ayusin ang pagsisikap sa pangangatwiran (mababa, katamtaman, mataas) batay sa iyong pangangailangan sa latency at pagiging kumplikado. - Fine-tunable na arkitektura:

I-customize ang mga modelo nang malawakan gamit ang parameter fine-tuning para sa mga partikular na use-case. - Pahintulot na Lisensya ng Apache 2.0:

Mag-innovate nang malaya nang walang mga restriktibong copyleft licenses o panganib sa patent—perpekto para sa komersyal na deployment at mabilis na eksperimento.

🔥 Na-optimize gamit ang MXFP4 Quantization

Inilunsad ng OpenAI ang MXFP4 quantization, na malaki ang binabawasan ang memory footprint ng mga modelo ng GPT-OSS:

- Ipinaliwanag ang Format ng MXFP4:

Ang mga modelo ng GPT-OSS ay gumagamit ng isang teknika ng quantization kung saan ang mga timbang ng Mixture-of-Experts (MoE) ay na-quantize sa 4.25 bits lamang bawat parameter. Ang mga timbang ng MoE ay bumubuo ng higit sa 90% ng kabuuang mga parameter ng modelo, na ginagawang napaka-epektibo ang quantization. - Pinahusay na Compatibility:

Ang na-optimize na quantization na ito ay nagbibigay-daan:- Sa gpt-oss:20b modelo na tumakbo nang maayos sa mga makina na may kasing liit ng 16GB memorya.

- Sa gpt-oss:120b modelo na magkasya nang kumportable sa isang 80GB GPU.

Sinusuportahan ng ShareAI ang format na MXFP4 nang direkta—walang karagdagang hakbang, conversion, o abala na kinakailangan. Ang aming pinakabagong update sa engine ay may kasamang mga bagong binuong kernel na partikular na idinisenyo para sa format na MXFP4, na tinitiyak ang pinakamataas na pagganap.

📌 Mga Modelo ng GPT-OSS na Magagamit Ngayon:

GPT-OSS:20B

- Perpekto para sa mababang latency, mga espesyal na gawain, o lokal na deployment.

- Nag-aalok ng matatag na pagganap kahit sa mga simpleng hardware setup.

GPT-OSS:120B

- Nagbibigay ng makapangyarihang pangangatwiran, advanced na kakayahan ng ahente, at versatility na angkop para sa mga mahihirap na gawain sa malakihang sukat.

- Perpekto para sa mga developer at negosyo na nangangailangan ng mas malalim na pangangatwiran, mas mataas na katumpakan, at mas malawak na aplikasyon ng AI.

🛠️ Subukan ang GPT-OSS ngayon

Handa ka na bang maranasan ang mga kakayahan ng AI ng susunod na henerasyon?

- I-download ang ShareAI Windows Client (link sa pahina ng pag-download)

- Tingnan ang Dokumentasyon (link sa mga dokumento ng gumagamit o mga tutorial)

Manatiling nakatutok—patuloy na pinalalawak ng ShareAI ang aming library ng modelo, pinapalakas ang iyong mga proyekto sa AI sa bawat hakbang.

Masayang pag-prompt! 🚀