Requesty Alternatifleri 2026: ShareAI vs Eden AI, OpenRouter, Portkey, Kong AI, Unify, Orq & LiteLLM

Güncellendi Şubat 2026

Geliştiriciler seçiyor Talep birçok LLM sağlayıcısı arasında tek bir OpenAI uyumlu geçit için artı yönlendirme, analiz ve yönetim. Ancak eğer daha çok önemsiyorsanız her yönlendirme öncesinde pazar yeri şeffaflığı (fiyat, gecikme, çalışma süresi, kullanılabilirlik), katı uç politikası, veya bir kendi kendine barındırılan proxy, bu Requesty alternatiflerinden biri yığınınıza daha iyi uyabilir.

Bu alıcı rehberi bir yapıcı gibi yazılmıştır: belirli ödünler, net hızlı seçimler, derinlemesine incelemeler, yan yana karşılaştırmalar ve bir kopyala-yapıştır ShareAI hızlı başlangıç böylece bugün gönderebilirsiniz.

Requesty'yi Anlamak (ve nerede uygun olmayabileceğini)

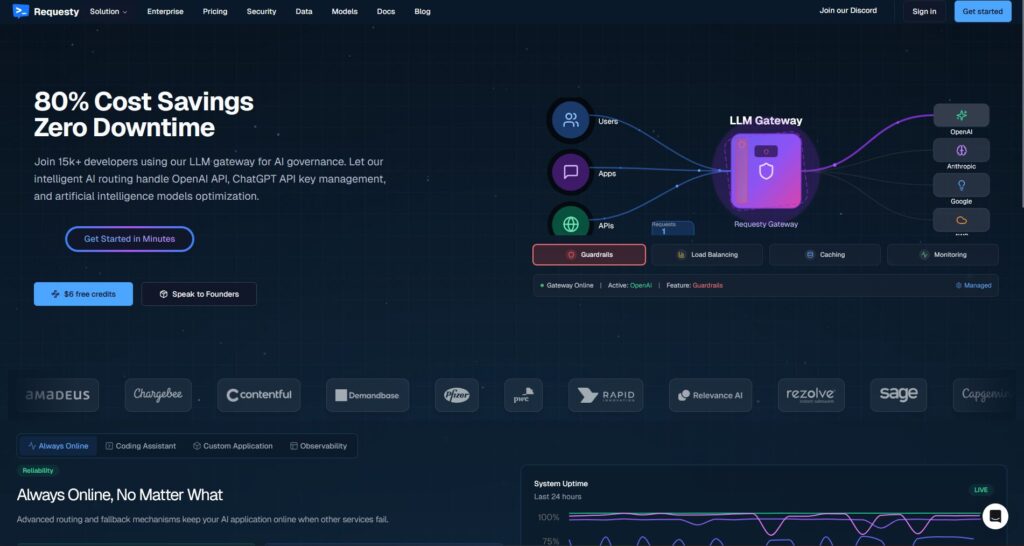

Requesty nedir. Requesty bir LLM'dir geçit. OpenAI uyumlu istemcinizi bir Requesty uç noktasına yönlendirir ve istekleri birden fazla sağlayıcı/model arasında yönlendirirsiniz—genellikle yedekleme, analiz ve politika koruma önlemleriyle. tek bir yer AI çağrılarınızda kullanım yönetimi, maliyet izleme ve yönetişim uygulama için tasarlanmıştır.

Ekiplerin bunu seçme nedeni.

- Tek bir API, birçok sağlayıcı. SDK dağınıklığını azaltın ve gözlemlenebilirliği merkezileştirin.

- Yedekleme ve yönlendirme. Bir sağlayıcıda kesinti olsa bile çalışma süresini sabit tutun.

- Kurumsal yönetişim. Merkezi politika, organizasyon düzeyinde kontroller, kullanım bütçeleri.

Requesty'nin uygun olmayabileceği yerler.

- İstiyorsunuz her yönlendirme öncesinde pazar yeri şeffaflığı (fiyat, gecikme, çalışma süresi, sağlayıcı başına mevcut durumu hemen görün, ardından seçin).

- İhtiyacınız var uç birimi düzeyinde politika kendi yığınınızda (ör. Kong, Portkey) veya kendi kendine barındırma (LiteLLM).

- Yol haritanız gerektiriyor geniş çok modlu özellikleri tek bir çatı altında (OCR, konuşma, çeviri, belge ayrıştırma) LLM sohbetinin ötesinde—ShareAI gibi bir düzenleyici daha uygun olabilir.

Requesty alternatifini nasıl seçilir

1) Toplam Sahip Olma Maliyeti (TCO). $/1K jetonlarda durmayın. Şunları dahil edin: önbellek isabet oranları, yeniden denemeler/yedeklemeler, sıralama, değerlendirici maliyetleri, istek başına genel giderler ve gözlemlenebilirlik/uyarıların operasyonel yükü. “En ucuz liste fiyatı” genellikle israfı azaltan bir yönlendirici/geçide kaybeder.

2) Gecikme ve güvenilirlik. Tercih edin bölgeye duyarlı yönlendirme, sıcak önbellek yeniden kullanımı (istem istemi önbellekleme etkin olduğunda aynı sağlayıcıya bağlı kalma) ve hassas geri dönüşler (429'ları yeniden deneme; zaman aşımında yükseltme; yinelenen harcamayı önlemek için fan-out'u sınırlama).

3) Gözlemlenebilirlik ve yönetişim. Eğer koruma önlemleri, denetim günlükleri, redaksiyon ve uçta politika önemliyse, bir geçit gibi Portkey veya Kong AI Gateway genellikle saf bir toplayıcıdan daha güçlüdür. Birçok ekip yönlendirici + geçit kombinasyonunu en iyi sonuçlar için birleştirir.

4) Kendi kendine barındırma vs yönetilen. Docker/K8s/Helm ve OpenAI uyumlu uç noktaları mı tercih ediyorsunuz? Bakınız LiteLLM (OSS) veya Kong AI Gateway (kurumsal altyapı). İster misiniz barındırılan hız + pazar yeri görünürlüğü? Bakınız ShareAI (bizim seçimimiz), OpenRouter, veya Birleştir.

5) Sohbetin ötesinde genişlik. Yol haritanız OCR, konuşmadan metne, çeviri, görüntü oluşturma ve belge ayrıştırmayı tek bir düzenleyici altında içeriyorsa, ShareAI teslimatı ve test etmeyi basitleştirebilir.

6) Geleceğe hazırlık. Modelleri/sağlayıcıları değiştirmeyi zahmetsiz hale getiren araçları seçin (evrensel API'ler, dinamik yönlendirme, açık model takma adları), böylece yeniden yazmaya gerek kalmadan daha yeni/daha ucuz/daha hızlı seçenekleri benimseyebilirsiniz.

En iyi Requesty alternatifleri (hızlı seçimler)

ShareAI (pazar yeri şeffaflığı + yapıcı ekonomisi için bizim seçimimiz)

Tek bir API ile 150+ model anında yedekleme ve bir pazar yeri değil yüzeye çıkaran fiyat, gecikme, çalışma süresi, kullanılabilirlik yönlendirmeden önce. Sağlayıcılar (topluluk veya şirket) korur gelirin çoğu, teşvikleri güvenilirlikle hizalama. Hızlı bir başlangıç yapın Playground'da, anahtarları alın Konsol, ve okuyun Belgeler.

Eden AI (çok modlu düzenleyici)

LLM'ler arasında birleşik API artı görüntü, OCR/doküman ayrıştırma, konuşma ve çeviri—yanında Model Karşılaştırması, izleme, önbellekleme ve toplu işleme.

OpenRouter (önbellek farkındalıklı yönlendirme)

Birçok LLM arasında barındırılan yönlendirici ile istem önbellekleme ve sağlayıcıya bağlılık, sıcak bağlamları yeniden kullanmak için; bir sağlayıcı kullanılamaz hale geldiğinde geri döner.

Portkey (ağ geçidinde politika ve SRE işlemleri)

AI ağ geçidi ile programlanabilir geri dönüşler, hız sınırı oyun kitapçıkları, ve basit/semantik önbellek, artı üretim kontrolü için ayrıntılı izler/metrikler.

Kong AI Gateway (uç yönetimi ve denetim)

Getir AI eklentileri, politika, analitik Kong ekosistemine; ekipler arasında merkezi kontroller gerektiğinde bir pazar yönlendiricisiyle iyi eşleşir.

Birleştir (veri odaklı yönlendirici)

Evrensel API ile canlı karşılaştırmalar maliyet/hız/kaliteyi bölge ve iş yüküne göre optimize etmek için.

Orq.ai (deneyler ve LLMOps)

Deneyler, değerlendiriciler (dahil RAG metrikler), dağıtımlar, RBAC/VPC—değerlendirme ve yönetimin bir arada olması gerektiğinde harika.

LiteLLM (kendi kendine barındırılan proxy/geçit)

Açık kaynaklı, OpenAI uyumlu proxy ile bütçeler/sınırlamalar, günlük kaydı/metrikler ve bir Yönetici UI'si. Docker/K8s/Helm ile dağıtın; operasyonlar size ait.

Derinlemesine incelemeler: en iyi alternatifler

ShareAI (İnsan Gücüyle Çalışan AI API'si)

Ne olduğunu. Sağlayıcı öncelikli bir AI ağı ve birleşik API. Modeller/sağlayıcılar için geniş bir kataloğa göz atın ve anında yedekleme. yönlendirin. Pazar yeri fiyat, gecikme, çalışma süresi ve kullanılabilirliği tek bir yerde sunar, böylece her yönlendirme öncesinde doğru sağlayıcıyı seçebilirsiniz. Başlayın Playground'da, anahtarlar oluşturun Konsol, ve takip edin API hızlı başlangıç.

Takımlar neden bunu seçiyor.

- Pazar yeri şeffaflığı — sağlayıcıyı gecikme/süreklilik/kullanılabilirlik önceden görün.

- Varsayılan olarak dayanıklılık — hızlı hata toleransı biri kesildiğinde bir sonraki en iyi sağlayıcıya.

- Yapıcıya uyumlu ekonomi — harcamaların çoğu modelleri çevrimiçi tutan GPU sağlayıcılarına akar.

- Sürtünmesiz başlangıç — Modelleri Gözat, test edin Playground'da, ve gönder.

Sağlayıcı gerçekleri (modelleri çevrimiçi tutarak kazanın). Herkes sağlayıcı olabilir (Topluluk veya Şirket). Şu yollarla katılın Windows/Ubuntu/macOS/Docker. Katkıda bulunun boş zaman patlamaları veya çalıştır her zaman açık. Teşvikleri seçin: Ödüller (para), Takas (tokenler/AI Tüketici), veya Misyon (NGO'lara %1 bağış yapın). Ölçeklendikçe, kendi çıkarım fiyatlarınızı belirleyebilirsiniz belirleyebilir ve pazarda. Detaylar: Sağlayıcı Kılavuzu.

İçin ideal. Ürün ekipleri isteyen pazar yeri şeffaflığı ile, dayanıklılık, ve büyümek için alan sağlayıcı moduna geçmek—satıcıya bağımlı olmadan.

Eden AI

Ne olduğunu. Birleşik bir API, LLM'ler + görüntü oluşturma + OCR/doküman ayrıştırma + konuşma + çeviri, birden fazla satıcı SDK'sını birleştirme ihtiyacını ortadan kaldırır. Model Karşılaştırması sağlayıcıları yan yana test etmenize yardımcı olur. Ayrıca vurgular Maliyet/API İzleme, Toplu İşleme, ve Önbellekleme.

Uygun olduğunda. Yol haritanız çok modlu ve tek bir yüzeyden OCR/konuşma/çeviriyi LLM sohbetiyle birlikte düzenlemek istiyorsunuz.

Dikkat edilmesi gerekenler. Eğer bir şeye ihtiyacınız varsa talep başına pazar yeri görünümü (fiyat/gecikme/süreklilik/kullanılabilirlik) veya sağlayıcı düzeyinde ekonomi için, pazar yeri tarzı bir yönlendirici düşünün ShareAI Eden'in çok modlu özellikleriyle birlikte.

OpenRouter

Ne olduğunu. Birleştirilmiş bir LLM yönlendirici ile sağlayıcı/model yönlendirme ve istem önbellekleme. Önbellekleme etkinleştirildiğinde, OpenRouter sizi aynı sağlayıcıda sıcak bağlamları yeniden kullanmak için tutmaya çalışır; eğer o sağlayıcı kullanılamazsa, geri döner bir sonraki en iyiye.

Uygun olduğunda. İstiyorsunuz barındırılan hız ve önbellek farkındalıklı yönlendirme maliyeti düşürmek ve verimi artırmak için—özellikle tekrar eden istemlerle yüksek-QPS sohbet iş yüklerinde.

Dikkat edilmesi gerekenler. Derin kurumsal yönetim için (ör. SIEM dışa aktarımları, organizasyon genelinde politika), birçok ekip OpenRouter'ı Portkey veya Kong AI Gateway ile eşleştirin.

Portkey

Ne olduğunu. Bir AI operasyon platformu + geçit programlanabilir geri dönüşler, hız sınırı oyun kitapçıkları, ve basit/semantik önbellek, artı izler/metrikler SRE tarzı kontrol için.

- İç içe yedekler ve koşullu yönlendirme — yeniden deneme ağaçlarını ifade edin (ör. 429'ları yeniden deneyin; 5xx'e geçiş yapın; gecikme artışlarında devreye girin).

- Anlamsal önbellek — genellikle kısa istemler/mesajlarda kazanır (sınırlamalar geçerlidir).

- Sanal anahtarlar/bütçeler — ekip/proje kullanımını politikada tutun.

Uygun olduğunda. İhtiyacınız var politika odaklı yönlendirme birinci sınıf gözlemlenebilirlik ile, ve bir işletim konusunda rahatsınız geçit bir veya daha fazla yönlendirici/pazar yeri önünde bir katman.

Kong AI Gateway

Ne olduğunu. Bir uç ağ geçidi getiren AI eklentileri, yönetişim ve analiz Kong ekosistemine (Konnect veya kendi kendine yönetilen yoluyla). Bu bir altyapıdır—API platformunuz zaten Kong etrafında dönüyorsa ve ihtiyacınız varsa güçlü bir uyum sağlar merkezi politika/denetim.

Uygun olduğunda. Uç yönetişim, denetlenebilirlik, veri yerleşimi, ve merkezi kontroller ortamınızda tartışılmazdır.

Dikkat edilmesi gerekenler. Bekleyin kurulum ve bakım. Birçok ekip Kong'u bir pazar yeri yönlendiricisiyle eşleştirir (ör. ShareAI/OpenRouter) sağlayıcı seçimi ve maliyet kontrolü için.

Birleştir

Ne olduğunu. A veri odaklı yönlendirici optimize eden maliyet/hız/kalite için kullanarak canlı karşılaştırmalar. Bir evrensel API sunar ve model seçimlerini bölge/iş yüküne göre günceller.

Uygun olduğunda. İstiyorsunuz kıyaslama rehberli seçim gerçek dünya performansına sürekli uyum sağlar.

Orq.ai

Ne olduğunu. Bir üretken yapay zeka iş birliği + LLMOps platformu: deneyler, değerlendiriciler (dahil RAG bağlam uygunluğu/doğruluğu/sağlamlık gibi metrikler), dağıtımlar ve RBAC/VPC.

Uygun olduğunda. İhtiyacınız var deney + değerlendirme yönetimle tek bir yerde—ardından aynı yüzeyden doğrudan dağıtım yapın.

LiteLLM

Ne olduğunu. Bir açık kaynak proxy/geçit ile OpenAI-uyumlu uç noktalar, bütçeler ve oran sınırları, günlük/ölçümler ve bir Yönetici UI. Şu yollarla dağıtın Docker/K8s/Helm; trafiği kendi ağınızda tutun.

Uygun olduğunda. İstiyorsunuz kendi kendine barındırma ve tam altyapı kontrolü popüler OpenAI tarzı SDK'lar için kolay uyumluluk ile.

Dikkat edilmesi gerekenler. Herhangi bir OSS geçidi gibi, operasyonlar ve yükseltmeler size aittir. İzleme, ölçeklendirme ve güvenlik güncellemeleri için zaman ayırmayı unutmayın.

Hızlı başlangıç: bir modeli dakikalar içinde çağırın (ShareAI)

Başlayın Playground'da, ardından bir API anahtarı alın ve gönderin. Referans: API hızlı başlangıç • Belgeler Ana Sayfası • Sürümler.

#!/usr/bin/env bash"

// ShareAI — Sohbet Tamamlamaları (JavaScript, Node 18+);

Geçiş ipucu: Mevcut Requesty modellerinizi ShareAI eşdeğerlerine eşleyin, istek/cevap şekillerini yansıtın ve bir özellik bayrağı arkasında başlayın.. Önce %5–10 trafik gönderin, karşılaştırın gecikme/maliyet/kalite, ardından artırın. Ayrıca bir ağ geçidi (Portkey/Kong) çalıştırıyorsanız, emin olun önbellekleme/yedeklemeler katmanlar arasında çift tetiklenmesin.

Bir bakışta karşılaştırma

| Platform | Barındırılan / Kendi kendine barındırma | Yönlendirme ve Yedekleme | Gözlemlenebilirlik | Genişlik (LLM + ötesi) | Yönetim/Politika | Notlar |

|---|---|---|---|---|---|---|

| Talep | Barındırılan | Failover ile yönlendirici; OpenAI uyumlu | Dahili izleme/analitik | LLM merkezli (sohbet/tamamlamalar) | Kurum düzeyinde yönetim | OpenAI temel URL'sini Requesty ile değiştirin; kurumsal vurgu. |

| ShareAI | Barındırılan + sağlayıcı ağı | Anında yedekleme; pazar yeri rehberli yönlendirme için | Kullanım günlükleri; pazar yeri istatistikleri | Geniş model kataloğu | Sağlayıcı düzeyinde kontroller | İnsan Gücüyle Çalışan pazar yeri; ile başlayın Playground'da. |

| Eden AI | Barındırılan | Sağlayıcıları değiştir; toplu; önbellekleme | Maliyet ve API izleme | LLM + görüntü + OCR + konuşma + çeviri | Merkezi faturalama/anahtar yönetimi | Sağlayıcıları yan yana test etmek için Model Karşılaştırması. |

| OpenRouter | Barındırılan | Sağlayıcı/model yönlendirme; istem önbellekleme | İstek düzeyinde bilgi | LLM-merkezli | Sağlayıcı politikaları | Desteklenen yerlerde önbellek yeniden kullanımı; kullanılabilirlik olmadığında geri dönüş. |

| Portkey | Barındırılan & Ağ Geçidi | Politika geri dönüşleri; hız sınırı oyun kitapları; anlamsal önbellek | İzler/metrikler | LLM-öncelikli | Ağ geçidi yapılandırmaları | SRE tarzı koruma rayları ve organizasyon politikası için harika. |

| Kong AI Gateway | Kendi kendine barındırma/Enterprise | AI eklentileri aracılığıyla yukarı akış yönlendirme | Kong aracılığıyla metrikler/denetim | LLM-öncelikli | Güçlü uç yönetimi | Altyapı bileşeni; bir yönlendirici/pazar yeri ile eşleşir. |

| Birleştir | Barındırılan | Veri odaklı yönlendirme maliyet/hız/kaliteye göre | Karşılaştırma keşfi | LLM-merkezli | Yönlendirici tercihleri | Kıyaslama rehberli model seçimi. |

| Orq.ai | Barındırılan | Orkestrasyonda yeniden denemeler/yedekler | Platform analitiği; RAG değerlendiriciler | LLM + RAG + değerlendirmeler | RBAC/VPC seçenekleri | İş birliği ve deney odaklılık. |

| LiteLLM | Kendi kendine barındırma/OSS | Yeniden deneme/yedekleme; bütçeler/sınırlamalar | Günlük kaydı/metrikler; Yönetici UI | LLM-merkezli | Tam altyapı kontrolü | OpenAI-uyumlu; Docker/K8s/Helm dağıtımı. |

SSS

Requesty nedir?

Bir LLM geçit izleme, yönetim ve maliyet kontrolleri ile tek bir OpenAI-uyumlu API üzerinden çoklu sağlayıcı yönlendirmesi sunar.

En iyi Requesty alternatifleri nelerdir?

En iyi seçenekler şunlardır ShareAI (pazar yeri şeffaflığı + anında yedekleme), Eden AI (çok modlu API + model karşılaştırması), OpenRouter (önbellek farkındalığı yönlendirmesi), Portkey (politika ve anlamsal önbellek ile ağ geçidi), Kong AI Gateway (uç yönetimi), Birleştir (veri odaklı yönlendirici), Orq.ai (LLMOps/değerlendiriciler) ve LiteLLM (kendi barındırdığı proxy).

Requesty vs ShareAI — hangisi daha iyi?

Seç ShareAI eğer istiyorsanız bir şeffaf bir pazar yeri yüzeye çıkaran fiyat/gecikme/süreklilik/erişilebilirlik yönlendirmeden önce, artı anında hata toleransı ve yapıcı uyumlu ekonomi. Seç Talep eğer kurumsal yönetimle tek bir barındırılan geçidi tercih ediyorsanız ve bir pazar yeri görünümü olmadan sağlayıcıları seçmekte rahatsanız. ShareAI’yi deneyin Model Pazarı ve Playground'da.

Requesty vs Eden AI — farkı nedir?

Eden AI kapsar LLM'ler + çok modlu (görüş/OCR, konuşma, çeviri) ve içerir Model Karşılaştırması; Talep daha fazladır LLM-merkezli yönlendirme/yönetim ile. Yol haritanızda tek bir API altında OCR/konuşma/çeviri gerekiyorsa, Eden AI teslimatı basitleştirir; geçit tarzı yönlendirme için Requesty uygundur.

Requesty vs OpenRouter — her birini ne zaman seçmeli?

Seç OpenRouter ne zaman istem önbellekleme ve sıcak önbellek yeniden kullanımı mesele (sizi aynı sağlayıcıda tutma eğilimindedir ve kesintilerde geri döner). Seç Talep tek bir yönlendirici ile kurumsal yönetim için ve önbellek farkında sağlayıcı bağlılığı sizin için öncelikli değilse.

Requesty vs Portkey vs Kong AI Gateway — yönlendirici mi yoksa geçit mi?

Talep bir yönlendiricidir. Portkey ve Kong AI Gateway vardır geçitlerdir: şunlarda başarılıdırlar politika/kılavuzlar (geri dönüşler, hız sınırları, analizler, uç yönetimi). Birçok yığın kullanır hem: model seçimi ve maliyet kontrolü için org-genel politika için bir geçit + bir yönlendirici/pazar yeri.

Requesty vs Unify — Unify hakkında benzersiz olan nedir?

Birleştir kullanır canlı karşılaştırmalar ve maliyet/hız/kalite için optimize etmek için dinamik politikalar. Eğer isterseniz veri odaklı yönlendirme bölge/iş yüküne göre gelişen, Unify etkileyici; Requesty geçit tarzı yönlendirme ve yönetim üzerine odaklanıyor.

Requesty vs Orq.ai — değerlendirme ve RAG için hangisi?

Orq.ai sağlar bir deney/deneyim değerlendirmesi yüzey (RAG değerlendiricileri dahil), ayrıca dağıtımlar ve RBAC/VPC. Eğer ihtiyacınız varsa LLMOps + değerlendiriciler, Orq.ai erken aşamalarda bir yönlendiriciyi tamamlayabilir veya değiştirebilir.

Requesty vs LiteLLM — barındırılan mı yoksa kendi kendine barındırılan mı?

Talep barındırılıyor. LiteLLM bir kendi kendine barındırılan proxy/geçit ile bütçeler ve oran sınırları ve bir Yönetici UI; trafiği VPC'nizin içinde tutmak ve kontrol düzlemini sahiplenmek istiyorsanız harika.

İş yüküm için en ucuz hangisi: Requesty, ShareAI, OpenRouter, LiteLLM?

Bağlıdır model seçimine, bölgeye, önbelleklenebilirliğe ve trafik düzenlerine. Yönlendiriciler gibi ShareAI/OpenRouter yönlendirme ve önbellek farkındalığı ile maliyeti azaltabilir; geçitler gibi Portkey ekler anlamsal önbellekleme; LiteLLM işletim platformu yükünü azaltır, eğer bunu çalıştırmaktan rahatsanız. Şununla karşılaştırın istemlerinizi ve takip edin sonuç başına etkili maliyet—sadece liste fiyatı değil.

Requesty'den ShareAI'ye minimum kod değişikliğiyle nasıl geçiş yaparım?

Modellerinizi ShareAI eşdeğerlerine eşleyin, istek/yanıt şekillerini yansıtın ve bir özellik bayrağı arkasında başlayın.. Küçük bir %'yi önce yönlendirin, gecikme/maliyet/kaliteyi karşılaştırın, ardından artırın. Eğer bir geçit de çalıştırıyorsanız, önbellekleme/yedeklemeler katmanlar arasında çift tetikleme yapmadığınızdan emin olun.

Bu makale “Requestly alternatiflerini” de kapsıyor mu? (Requesty vs Requestly)

Evet—Requestly (ile bir L) bir geliştirici/QA araç setidir (HTTP engelleme, API taklit/test, kurallar, başlıklar) bir LLM yönlendiricisi yerine. Eğer Requestly alternatiflerini, arıyorsanız, muhtemelen Postman, Fiddler, mitmproxy, vb. ile karşılaştırıyorsunuzdur. Eğer Talep (LLM geçidi) demek istiyorsanız, bu kılavuzdaki alternatifleri kullanın. Canlı sohbet etmek isterseniz, bir toplantı ayırtın: meet.growably.ro/team/shareai.

ShareAI'yi tam bir entegrasyon olmadan denemenin en hızlı yolu nedir?

Açın Playground'da, bir model/sağlayıcı seçin ve tarayıcıda istemleri çalıştırın. Hazır olduğunuzda, Konsol bir anahtar oluşturun ve cURL/JS kod parçacıklarını uygulamanıza ekleyin.

ShareAI sağlayıcısı olabilir ve kazanç elde edebilir miyim?

Evet. Herkes Topluluk veya Şirket sağlayıcı olarak Windows/Ubuntu/macOS veya Docker. Katkıda bulunun boş zaman patlamaları veya çalıştır her zaman açık. kullanarak katılabilir. Ödüller (para), Takas (tokenler/AI Tüketici), veya Misyon seçin (NGO'lara %1 bağış yapın). Şuraya bakın Sağlayıcı Kılavuzu.

Tek bir “en iyi” Requesty alternatifi var mı?

Her ekip için tek bir kazanan yok. Eğer pazar yeri şeffaflığı + anında yedekleme + geliştirici ekonomisi, değerliyse, şuradan başlayın ShareAI. İçin çok modlu iş yükleri (OCR/konuşma/çeviri), bakın Eden AI. Eğer ihtiyacınız varsa uç yönetimi, değerlendirin Portkey veya Kong AI Gateway. Tercih edin kendi kendine barındırma? Düşünün LiteLLM.

Sonuç

İken Talep güçlü bir LLM geçidi olsa da, en iyi seçiminiz önceliklere bağlıdır:

- Pazar yeri şeffaflığı + dayanıklılık: ShareAI

- Tek bir API altında çok modlu kapsama: Eden AI

- Barındırılan formda önbellek farkındalığı yönlendirme: OpenRouter

- Uçta politika/kılavuzlar: Portkey veya Kong AI Gateway

- Veri odaklı yönlendirme: Birleştir

- LLMOps + değerlendiriciler: Orq.ai

- Kendinden barındırılan kontrol düzlemi: LiteLLM

Sağlayıcıları seçerken her bir rota öncesinde fiyat/gecikme/süreklilik/kullanılabilirlik, anında yedekleme, ve oluşturucuya uyumlu ekonomi kontrol listenizde varsa, açın Playground'da, bir API anahtarı oluşturun, ve göz atın Model Pazarı bir sonraki isteğinizi akıllı bir şekilde yönlendirmek için.