Các lựa chọn thay thế RouteLLM 2026: Khi nào nên chọn ShareAI (và những điều khác cần cân nhắc)

Cập nhật Tháng 2 2026

Các nhà phát triển lựa chọn RouteLLM để định tuyến các lời nhắc đến các mô hình rẻ hơn trong khi nhắm đến chất lượng gần GPT-4—đặc biệt đối với các nhiệm vụ giống như benchmark nơi một bộ định tuyến học được có thể tự tin giảm cấp. Nhưng nếu bạn quan tâm nhiều hơn đến tính minh bạch của thị trường trước mỗi tuyến đường (giá trực tiếp, độ trễ, thời gian hoạt động, khả dụng), chuyển đổi tức thì giữa nhiều nhà cung cấp, chính sách biên và kiểm toán, hoặc một proxy/cổng tự lưu trữ, một trong những các lựa chọn thay thế RouteLLM có thể phù hợp với ngăn xếp của bạn hơn.

Hướng dẫn mua này được viết như một nhà xây dựng: các đánh đổi cụ thể, lựa chọn nhanh, phân tích sâu, so sánh cạnh nhau, và một khởi động nhanh ShareAI copy-paste để bạn có thể triển khai ngay hôm nay.

Hiểu RouteLLM (và nơi nó có thể không phù hợp)

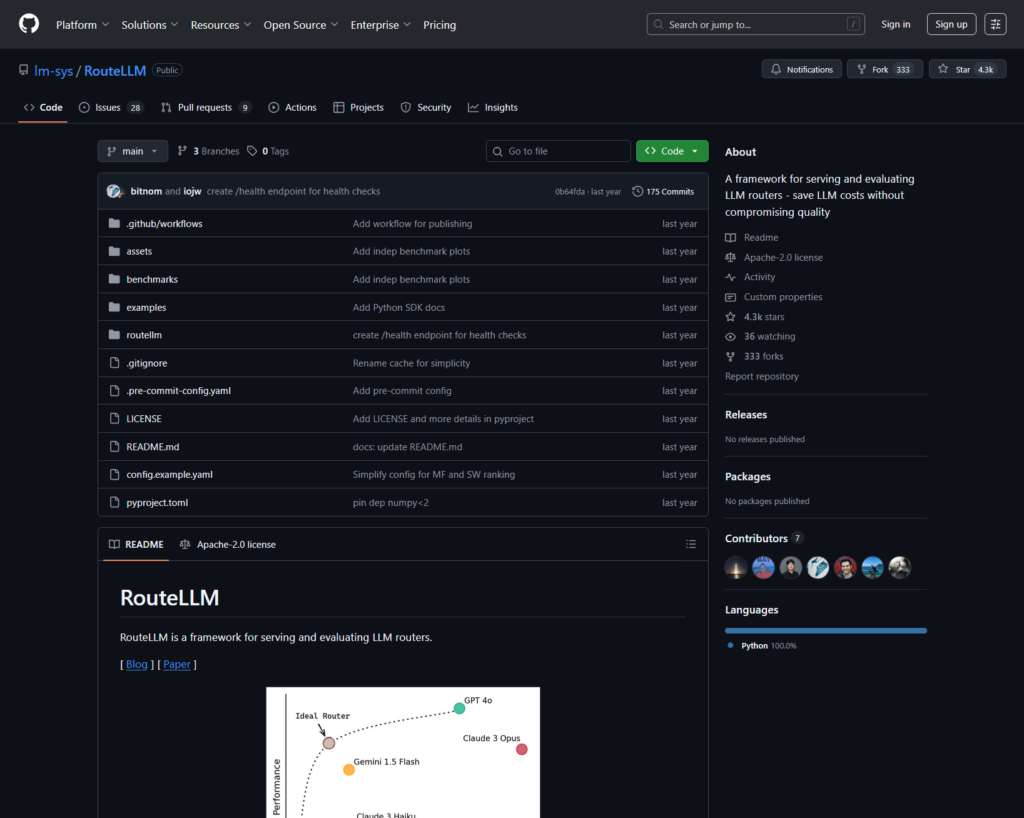

RouteLLM là gì. RouteLLM là một framework mã nguồn mở để phục vụ và đánh giá các bộ định tuyến LLM. Nó cung cấp một máy khách/máy chủ tương thích với OpenAI và đi kèm với các mô hình định tuyến đã được huấn luyện có thể định tuyến các truy vấn đơn giản hơn đến các mô hình rẻ hơn—được báo cáo giảm chi phí lên đến 85% trong khi duy trì ~95% hiệu suất GPT-4 trên các benchmark phổ biến (ví dụ: MT-Bench).

Tại sao các nhóm chọn nó.

- Định tuyến nhận thức chi phí với các chính sách được hỗ trợ bởi nghiên cứu.

- Mã nguồn mở và có thể mở rộng trong Python.

- Tương thích với OpenAI con đường thử nghiệm định tuyến mà không cần viết lại SDK nặng.

Nơi RouteLLM có thể không phù hợp.

- Bạn muốn minh bạch thị trường trực tiếp (giá, độ trễ, thời gian hoạt động, khả dụng) trước mỗi tuyến—không chỉ là một chính sách học được.

- Bạn cần chuyển đổi dự phòng đa nhà cung cấp

- Lộ trình của bạn trải dài API đa phương thức như OCR, giọng nói, dịch thuật và phân tích tài liệu dưới một mái nhà.

Cách chọn một lựa chọn thay thế RouteLLM

- Tổng chi phí sở hữu (TCO). Đừng dừng lại ở $/1K token. Tính tỷ lệ truy cập bộ nhớ đệm, thử lại/chuyển đổi dự phòng, xếp hàng, chi phí đánh giá và gánh nặng vận hành của nhật ký/cảnh báo. Bộ định tuyến và cổng với bộ nhớ đệm ngữ nghĩa có thể làm cho “giá niêm yết đắt hơn” trở nên rẻ hơn trong thực tế.

- Độ trễ & độ tin cậy. Ưu tiên định tuyến theo vùng, độ bám dính nhà cung cấp khi bộ nhớ đệm đang nóng và chuyển đổi dự phòng chính xác (thử lại 429s, tăng cấp khi hết thời gian chờ). Các bộ định tuyến được lưu trữ giữ bạn trên cùng một nhà cung cấp cho các ngữ cảnh nóng và chuyển đổi dự phòng khi nhà cung cấp gặp sự cố thường có xu hướng chiến thắng.

- Khả năng quan sát & quản trị. Nếu các rào chắn bảo vệ, xóa thông tin, nhật ký kiểm tra và chính sách tại biên là quan trọng, một cổng AI (Portkey hoặc Kong AI Gateway) thường mạnh hơn một bộ định tuyến thuần túy. Nhiều nhóm kết hợp bộ định tuyến + cổng.

- Tự lưu trữ so với được quản lý. Thích Docker/K8s/Helm và proxy tương thích OpenAI? Thử LiteLLM. Muốn tốc độ được lưu trữ + khả năng hiển thị thị trường? Cân nhắc ShareAI hoặc OpenRouter.

- Phạm vi rộng hơn ngoài trò chuyện. Nếu bạn cần OCR, giọng nói, dịch thuật hoặc phân tích tài liệu cùng với trò chuyện LLM, một bộ điều phối đa phương thức như Eden AI sẽ hữu ích.

- Định tuyến dựa trên dữ liệu. Nếu bạn thích các đánh giá trực tiếp để điều chỉnh chi phí/tốc độ/chất lượng theo khu vực hoặc khối lượng công việc, hãy đánh giá Unify.

Các lựa chọn thay thế tốt nhất cho RouteLLM (lựa chọn nhanh)

ShareAI (lựa chọn của chúng tôi cho sự minh bạch của thị trường + kinh tế xây dựng)

Một API trên một danh mục lớn các mô hình/nhà cung cấp với chuyển đổi tức thì và một thị trường nổi bật giá cả, độ trễ, thời gian hoạt động, khả dụng trước khi bạn định tuyến. Bắt đầu nhanh trong Sân chơi, lấy chìa khóa trong Bảng điều khiển, duyệt qua Tài liệu, và so sánh các tùy chọn trong Mô hình.

Eden AI (nhà điều phối đa phương thức)

API hợp nhất trên các LLM cộng hình ảnh, OCR/phân tích tài liệu, giọng nói và dịch thuật—cùng với so sánh mô hình, giám sát, lưu trữ và xử lý hàng loạt.

OpenRouter (định tuyến nhận thức bộ nhớ đệm)

Bộ định tuyến được lưu trữ trên nhiều LLM với bộ nhớ đệm gợi ý và sự gắn kết nhà cung cấp để tái sử dụng các ngữ cảnh đã làm nóng; chuyển đổi khi một nhà cung cấp không khả dụng.

Portkey (chính sách & hoạt động SRE tại cổng)

Cổng AI với các phương án dự phòng có thể lập trình, sách hướng dẫn giới hạn tốc độ và bộ nhớ đệm ngữ nghĩa—cùng với các dấu vết/đo lường chi tiết để kiểm soát sản xuất.

Kong AI Gateway (quản trị & kiểm toán tại biên)

Đưa các plugin AI, chính sách và phân tích vào hệ sinh thái Kong; phù hợp mạnh mẽ khi bạn cần kiểm soát cạnh tập trung giữa các nhóm.

Hợp nhất (bộ định tuyến dựa trên dữ liệu)

API phổ quát với các đánh giá trực tiếp để tối ưu hóa chi phí/tốc độ/chất lượng theo khu vực và khối lượng công việc.

Orq.ai (thử nghiệm & LLMOps)

Thử nghiệm, đánh giá (bao gồm các chỉ số RAG), triển khai và RBAC/VPC—tuyệt vời khi đánh giá và quản trị cần sống cùng nhau.

LiteLLM (proxy/cổng tự lưu trữ)

Proxy mã nguồn mở, tương thích với OpenAI với ngân sách/giới hạn, ghi nhật ký/chỉ số và giao diện quản trị. Triển khai với Docker/K8s/Helm; bạn sở hữu hoạt động.

Phân tích sâu: các lựa chọn thay thế hàng đầu cho RouteLLM

ShareAI (API AI do con người cung cấp)

Nó là gì. Mạng AI ưu tiên nhà cung cấp và API thống nhất. Duyệt qua danh mục lớn các mô hình/nhà cung cấp và định tuyến với chuyển đổi tức thì. Thị trường hiển thị giá, độ trễ, thời gian hoạt động và khả dụng ở một nơi để bạn có thể chọn nhà cung cấp phù hợp trước mỗi tuyến. Bắt đầu trong Sân chơi, tạo khóa trong Bảng điều khiển, và theo dõi hướng dẫn nhanh API trong Tài liệu. Duyệt qua Thị Trường Mô Hình.

- Minh bạch thị trường — xem giá/độ trễ/thời gian hoạt động/khả dụng ngay từ đầu.

- Khả năng phục hồi mặc định — chuyển đổi nhanh sang nhà cung cấp tốt nhất tiếp theo khi một nhà cung cấp gặp sự cố.

- Kinh tế phù hợp với nhà xây dựng — phần lớn chi tiêu chảy đến các nhà cung cấp GPU giữ cho các mô hình hoạt động trực tuyến.

- Khởi đầu không ma sát — thử nghiệm trong Playground, sau đó triển khai.

Thông tin nhà cung cấp (kiếm tiền bằng cách giữ cho các mô hình hoạt động trực tuyến). Bất kỳ ai cũng có thể trở thành nhà cung cấp (Cộng đồng hoặc Công ty). Đăng ký qua Windows/Ubuntu/macOS hoặc Docker. Đóng góp các đợt thời gian nhàn rỗi hoặc chạy luôn bật. Chọn các ưu đãi: Phần thưởng (tiền), Trao đổi (token/AI Prosumer), hoặc Sứ mệnh (quyên góp % cho các tổ chức phi chính phủ). Xem Hướng dẫn Nhà cung cấp hoặc mở Bảng điều khiển Nhà cung cấp.

Lý tưởng cho. Các nhóm sản phẩm muốn sự minh bạch của thị trường, khả năng phục hồi và không gian để phát triển sang chế độ nhà cung cấp—mà không bị khóa bởi nhà cung cấp.

Eden AI

Nó là gì. Một API thống nhất bao gồm LLMs + tạo hình ảnh + OCR/phân tích tài liệu + giọng nói + dịch thuật để bạn không phải ghép nối nhiều SDK của nhà cung cấp. Họ cũng nhấn mạnh so sánh mô hình, giám sát và xử lý hàng loạt.

Phù hợp khi. Lộ trình của bạn là đa phương thức và bạn muốn điều phối OCR/giọng nói/dịch thuật cùng với trò chuyện LLM.

Lưu ý. Nếu bạn cần một chế độ xem thị trường theo yêu cầu (giá cả/độ trễ/thời gian hoạt động/khả dụng) hoặc kinh tế cấp nhà cung cấp, ghép nối một bộ định tuyến thị trường như ShareAI.

OpenRouter

Nó là gì. Một bộ định tuyến LLM thống nhất với định tuyến nhà cung cấp/mô hình. bộ nhớ đệm nhắc. Với bộ nhớ đệm được kích hoạt, OpenRouter có xu hướng giữ bạn trên cùng một nhà cung cấp để tái sử dụng ngữ cảnh nóng; nếu nhà cung cấp đó không khả dụng, nó sẽ chuyển sang nhà cung cấp khác. Nó cũng hỗ trợ gợi ý chiến lược (ví dụ: trọng số giá).

Phù hợp khi. Bạn muốn tốc độ được lưu trữ và định tuyến nhận thức bộ nhớ đệm để giảm chi phí và cải thiện thông lượng—đặc biệt trong khối lượng công việc trò chuyện QPS cao với các lời nhắc lặp lại.

Lưu ý. Đối với quản trị doanh nghiệp sâu (xuất SIEM, chính sách toàn tổ chức), nhiều nhóm ghép nối OpenRouter với Portkey hoặc Kong AI Gateway.

Portkey

Nó là gì. Một cổng AI với các phương án dự phòng có thể lập trình, sách hướng dẫn giới hạn tốc độ và bộ nhớ đệm đơn giản/ngữ nghĩa, cùng với dấu vết/đo lường để kiểm soát kiểu SRE. Bộ nhớ đệm ngữ nghĩa đặc biệt hữu ích cho các lời nhắc/tin nhắn ngắn khi ngưỡng tương đồng được điều chỉnh tốt.

Phù hợp khi. Bạn cần định tuyến dựa trên chính sách với khả năng quan sát hạng nhất và bạn thoải mái vận hành một lớp cổng trước một hoặc nhiều bộ định tuyến/thị trường.

Cổng AI Kong

Nó là gì. Một cổng biên mang các plugin AI, chính sách và phân tích vào hệ sinh thái Kong (thông qua Konnect hoặc tự quản lý). Nếu nền tảng API của bạn đã xoay quanh Kong và bạn cần chính sách/kiểm toán trung tâm, đây là một lựa chọn mạnh mẽ.

Phù hợp khi. Quản trị biên, khả năng kiểm toán, cư trú dữ liệu và kiểm soát tập trung là không thể thương lượng trong môi trường của bạn.

Hợp nhất

Nó là gì. Một bộ định tuyến dựa trên dữ liệu tối ưu hóa chi phí/tốc độ/chất lượng bằng cách sử dụng các tiêu chuẩn trực tiếp, điều chỉnh theo khu vực và khối lượng công việc.

Phù hợp khi. Bạn muốn lựa chọn dựa trên tiêu chuẩn liên tục thích ứng với hiệu suất thực tế.

Orq.ai

Nó là gì. Một nền tảng hợp tác AI tạo sinh + LLMOps: thí nghiệm, đánh giá (bao gồm các chỉ số RAG), triển khai và RBAC/VPC. Tuyệt vời khi đánh giá và quản trị cần sống cùng nhau.

Phù hợp khi. Bạn cần thử nghiệm + đánh giá với quản trị tại một nơi—sau đó triển khai trực tiếp từ cùng một giao diện.

LiteLLM

Nó là gì. Một proxy/cổng nguồn mở với các điểm cuối tương thích OpenAI, ngân sách & giới hạn tốc độ, ghi nhật ký/thống kê, và giao diện quản trị. Triển khai qua Docker/K8s/Helm; giữ lưu lượng trong mạng của bạn.

Phù hợp khi. Bạn muốn tự lưu trữ và kiểm soát toàn bộ hạ tầng với khả năng tương thích đơn giản cho các SDK kiểu OpenAI phổ biến.

Lưu ý. Như với bất kỳ cổng OSS nào, bạn sở hữu vận hành và nâng cấp.

Bắt đầu nhanh: gọi một mô hình trong vài phút (ShareAI)

Bắt đầu trong Sân chơi, sau đó lấy một khóa API và triển khai. Tham khảo: Bắt đầu nhanh API • Trang chủ Tài liệu • Phát hành.

#!/usr/bin/env bash"

// ShareAI — Hoàn thành Chat (JavaScript, Node 18+);

Mẹo di chuyển. Ánh xạ các mô hình RouteLLM hiện tại của bạn sang các mô hình tương đương của ShareAI, phản chiếu hình dạng yêu cầu/phản hồi, và bắt đầu sau một cờ tính năng. Gửi 5–10% lưu lượng đầu tiên, so sánh độ trễ/chi phí/chất lượng, sau đó tăng dần. Nếu bạn cũng chạy một cổng (Portkey/Kong), đảm bảo bộ nhớ đệm/dự phòng không kích hoạt kép giữa các lớp.

So sánh nhanh

| Nền tảng | Lưu trữ / Tự lưu trữ | Định tuyến & Dự phòng | Khả năng quan sát | Phạm vi rộng (LLM + hơn nữa) | Quản trị / Chính sách | Ghi chú |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Bộ định tuyến học; máy khách/máy chủ tương thích OpenAI | CLI/nhật ký; tập trung nghiên cứu | Tập trung vào LLM | Chính sách qua hạ tầng của bạn | Tuyệt vời cho tiết kiệm chi phí cấp nghiên cứu; mang theo các kiểm soát cạnh của riêng bạn. |

| Chia sẻAI | Lưu trữ + mạng nhà cung cấp | Chuyển đổi tức thì; lựa chọn hướng dẫn bởi thị trường | Nhật ký sử dụng; thống kê thị trường | Danh mục mô hình rộng | Kiểm soát cấp nhà cung cấp | Thị trường do con người điều khiển; bắt đầu với Sân chơi và Mô hình. |

| Eden AI | Lưu trữ | Chuyển đổi nhà cung cấp; lô; bộ nhớ đệm | Giám sát chi phí & API | LLM + hình ảnh + OCR + giọng nói + dịch thuật | Thanh toán trung tâm/quản lý khóa | Bộ điều phối đa phương thức. |

| OpenRouter | Lưu trữ | Định tuyến nhà cung cấp/mô hình; bộ nhớ đệm gợi ý; độ bám dính nhà cung cấp | Thông tin cấp yêu cầu | Tập trung vào LLM | Chính sách nhà cung cấp | Tái sử dụng bộ nhớ đệm; dự phòng khi không khả dụng. |

| Portkey | Cổng lưu trữ | Dự phòng chính sách; sổ tay giới hạn tốc độ; bộ nhớ đệm ngữ nghĩa | Dấu vết/số liệu | Ưu tiên LLM | Cấu hình cổng | Rào chắn kiểu SRE. |

| Cổng AI Kong | Tự lưu trữ/Dành cho doanh nghiệp | Định tuyến ngược qua các plugin AI | Số liệu/kiểm toán qua Kong | Ưu tiên LLM | Quản trị mạnh mẽ ở biên | Thành phần hạ tầng; kết hợp với bộ định tuyến/thị trường. |

| Hợp nhất | Lưu trữ | Định tuyến dựa trên dữ liệu theo chi phí/tốc độ/chất lượng | Trình khám phá điểm chuẩn | Tập trung vào LLM | Chính sách định tuyến | Lựa chọn dựa trên hướng dẫn đánh giá. |

| Orq.ai | Lưu trữ | Thử lại/phương án thay thế trong điều phối | Phân tích nền tảng; đánh giá RAG | LLM + RAG + đánh giá | Tùy chọn RBAC/VPC | Tập trung vào hợp tác & thử nghiệm. |

| LiteLLM | Tự lưu trữ/OSS | Thử lại/dự phòng; ngân sách/giới hạn | Ghi nhật ký/thống kê; Giao diện quản trị | Tập trung vào LLM | Kiểm soát cơ sở hạ tầng toàn diện | Tương thích OpenAI; Triển khai Docker/K8s/Helm. |

Câu hỏi thường gặp: RouteLLM so với phần còn lại

RouteLLM so với ShareAI — cái nào tốt hơn?

Chọn Chia sẻAI nếu bạn muốn một thị trường minh bạch hiển thị giá cả/độ trễ/thời gian hoạt động/khả dụng trước mỗi tuyến đường, cộng thêm chuyển đổi dự phòng tức thì và kinh tế học phù hợp với nhà xây dựng. Chọn RouteLLM nếu bạn thích một bộ định tuyến dựa trên nghiên cứu, đã học và bạn cảm thấy thoải mái khi vận hành cơ sở hạ tầng xung quanh nó (cổng, ghi nhật ký, kiểm toán). Bắt đầu với Sân chơi và Thị Trường Mô Hình.

RouteLLM so với Eden AI — sự khác biệt là gì?

Eden AI bao gồm các LLM và đa phương thức (thị giác/OCR, giọng nói, dịch thuật) với so sánh và giám sát. RouteLLM tập trung vào định tuyến học cho các LLM. Nếu lộ trình của bạn cần OCR/giọng nói/dịch thuật dưới một API, Eden AI đơn giản hóa việc cung cấp; nếu nghiên cứu định tuyến là ưu tiên, RouteLLM phù hợp. Kết hợp với ShareAI khi bạn muốn sự minh bạch của thị trường cho mỗi yêu cầu.

RouteLLM so với OpenRouter — khi nào nên chọn mỗi cái?

Chọn OpenRouter khi nào bộ nhớ đệm nhắc và việc tái sử dụng bộ nhớ đệm ấm là quan trọng (nó có xu hướng giữ bạn trên cùng một nhà cung cấp và quay lại khi có sự cố). Chọn RouteLLM cho các chính sách học mà bạn tự vận hành. Nhiều ngăn xếp kết hợp OpenRouter với một cổng cho chính sách/khả năng quan sát—và vẫn sử dụng ShareAI khi họ muốn sự minh bạch của thị trường trước mỗi tuyến đường.

RouteLLM so với Portkey — bộ định tuyến hay cổng?

RouteLLM là một bộ định tuyến. Portkey là một cổng: nó xuất sắc trong chính sách/đường ray bảo vệ (sổ tay dự phòng, bộ nhớ đệm ngữ nghĩa) và dấu vết/chỉ số chi tiết. Nhiều nhóm chạy cả hai: một cổng cho chính sách toàn tổ chức + một bộ định tuyến/thị trường cho lựa chọn mô hình và kiểm soát chi phí. ShareAI kết hợp tốt ở đây khi bạn muốn khả năng hiển thị thị trường trước tuyến đường.

RouteLLM so với Kong AI Gateway — ai cần cái nào?

Chọn Cổng AI Kong khi nào quản trị biên (chính sách/kiểm toán tập trung, nơi lưu trữ dữ liệu) là không thể thương lượng. Giữ RouteLLM phía sau nó nếu bạn vẫn muốn định tuyến học cho giá cả/hiệu suất. Sử dụng Chia sẻAI cùng với khi bạn muốn chọn nhà cung cấp bởi giá cả/độ trễ/thời gian hoạt động/khả dụng trước mỗi tuyến đường.

RouteLLM so với Unify — điều gì độc đáo về Unify?

Hợp nhất sử dụng các tiêu chuẩn trực tiếp và chính sách động để tối ưu hóa cho chi phí/tốc độ/chất lượng. Nếu bạn muốn lựa chọn dựa trên dữ liệu phát triển theo khu vực/tải công việc, Unify rất hấp dẫn; RouteLLM tập trung vào các mô hình định tuyến học mà bạn lưu trữ. Sử dụng Chia sẻAI khi bạn thích chọn nhà cung cấp với chế độ xem thị trường và chuyển đổi dự phòng tức thì.

RouteLLM so với Orq.ai — cái nào để đánh giá & RAG?

Orq.ai cung cấp một bề mặt thử nghiệm/đánh giá (bao gồm các bộ đánh giá RAG), cùng với triển khai và RBAC/VPC. Nếu bạn cần LLMOps + bộ đánh giá, Orq.ai có thể bổ sung hoặc thay thế một bộ định tuyến thuần túy từ sớm. Mang Chia sẻAI khi bạn muốn lựa chọn nhà cung cấp với sự minh bạch của thị trường và khả năng phục hồi trong sản xuất.

RouteLLM so với LiteLLM — lưu trữ hay tự lưu trữ?

RouteLLM là logic định tuyến OSS; LiteLLM là một proxy/gateway tương thích với OpenAI với ngân sách, giới hạn tốc độ và giao diện quản trị—tuyệt vời nếu bạn muốn giữ lưu lượng truy cập trong VPC của mình và sở hữu mặt phẳng điều khiển. Các nhóm thường kết hợp LiteLLM để tự lưu trữ với Chia sẻAI để có khả năng hiển thị thị trường và chuyển đổi dự phòng tức thì giữa các nhà cung cấp.

Cái nào rẻ nhất cho tải công việc của tôi: RouteLLM, ShareAI, OpenRouter, LiteLLM?

Nó phụ thuộc vào lựa chọn mô hình, khu vực, khả năng lưu trữ và mẫu lưu lượng. Các bộ định tuyến như ShareAI/OpenRouter có thể giảm chi phí thông qua định tuyến và tính dính nhận biết bộ nhớ đệm; các cổng như Portkey thêm bộ nhớ đệm ngữ nghĩa; LiteLLM giảm chi phí nền tảng nếu bạn thoải mái vận hành nó. Đánh giá với cơ sở hạ tầng của bạn lời nhắc và theo dõi chi phí hiệu quả trên mỗi kết quả—không chỉ giá niêm yết.

RouteLLM là gì?

Một khung mã nguồn mở để phục vụ và đánh giá các bộ định tuyến LLM; cung cấp các bộ định tuyến đã được đào tạo và các đường dẫn tương thích với OpenAI; thường được trích dẫn để giảm chi phí đáng kể trong khi vẫn giữ chất lượng gần GPT-4 trên các nhiệm vụ giống MT-Bench.

Cách nhanh nhất để thử ShareAI mà không cần tích hợp đầy đủ là gì?

Mở Sân chơi, chọn một mô hình/nhà cung cấp, và chạy lời nhắc trong trình duyệt. Khi sẵn sàng, tạo một khóa và thả các đoạn mã cURL/JS ở trên vào ứng dụng của bạn.

Tôi có thể trở thành nhà cung cấp ShareAI và kiếm tiền không?

Có. Bất kỳ ai cũng có thể tham gia làm Cộng đồng hoặc Công ty nhà cung cấp sử dụng Windows/Ubuntu/macOS hoặc Docker. Đóng góp thời gian nhàn rỗi bùng nổ hoặc chạy luôn hoạt động. Chọn các ưu đãi: Phần thưởng (tiền), Trao đổi (token/AI Prosumer), hoặc Sứ mệnh (quyên góp % cho các tổ chức phi chính phủ). Xem Hướng dẫn Nhà cung cấp hoặc mở Bảng điều khiển Nhà cung cấp.

Kết luận

Trong khi RouteLLM là một bộ định tuyến OSS mạnh mẽ, lựa chọn tốt nhất của bạn phụ thuộc vào ưu tiên:

- Minh bạch thị trường + khả năng phục hồi: Chia sẻAI

- Phạm vi đa phương thức dưới một API: Eden AI

- Định tuyến nhận biết bộ nhớ đệm ở dạng được lưu trữ: OpenRouter

- Chính sách/đường dẫn bảo vệ tại biên: Portkey hoặc Kong AI Gateway

- Định tuyến dựa trên dữ liệu: Hợp nhất

- LLMOps + bộ đánh giá: Orq.ai

- Mặt phẳng điều khiển tự lưu trữ: LiteLLM

Nếu giá cả/độ trễ/thời gian hoạt động/khả dụng trước mỗi tuyến đường, chuyển đổi dự phòng tức thì, và kinh tế phù hợp với nhà xây dựng nằm trong danh sách kiểm tra của bạn, hãy mở Sân chơi, tạo một khóa API, và duyệt qua Thị Trường Mô Hình để định tuyến yêu cầu tiếp theo của bạn một cách thông minh.