歡迎 OpenAI 嘅 GPT-OSS 加入 ShareAI

呢頁Cantonese係用TranslateGemma自動由英文翻譯過嚟嘅。翻譯可能唔係完全準確。.

ShareAI 致力為你帶嚟最新同最強嘅 AI 模型——今日我哋再次做到咗。.

幾個鐘前,, OpenAI 發佈咗佢突破性嘅 GPT-OSS 模型,而你而家已經可以喺 ShareAI 網絡入面開始使用佢哋!

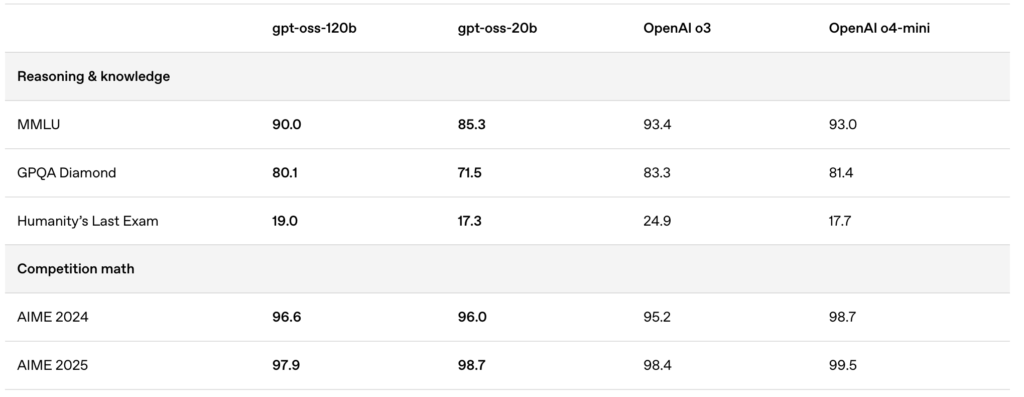

新發佈嘅模型——gpt-oss:20b 同埋 gpt-oss:120b——提供卓越嘅本地對話體驗、強大嘅推理能力,仲有加強咗對高級開發者場景嘅支援。.

🚀 喺 ShareAI 上開始使用 GPT-OSS

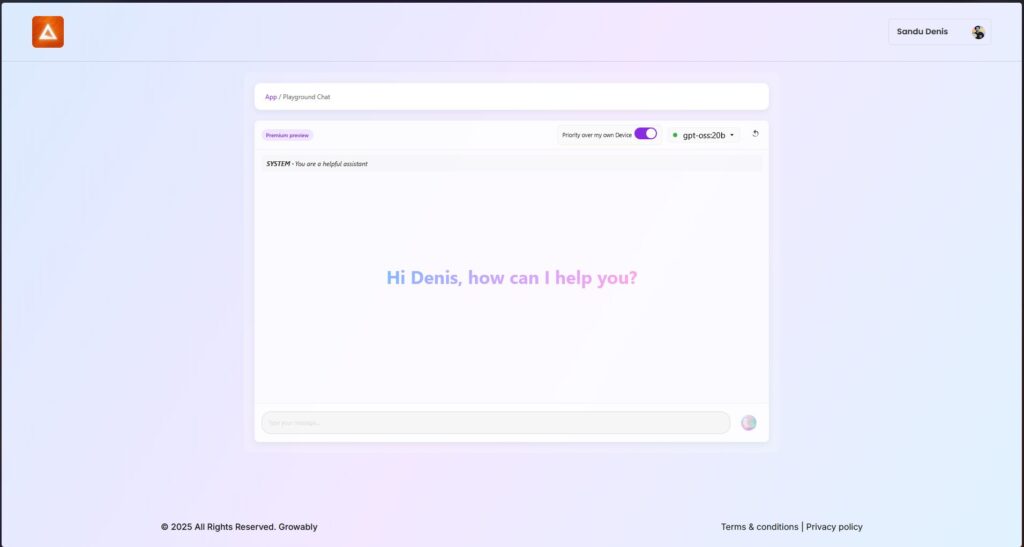

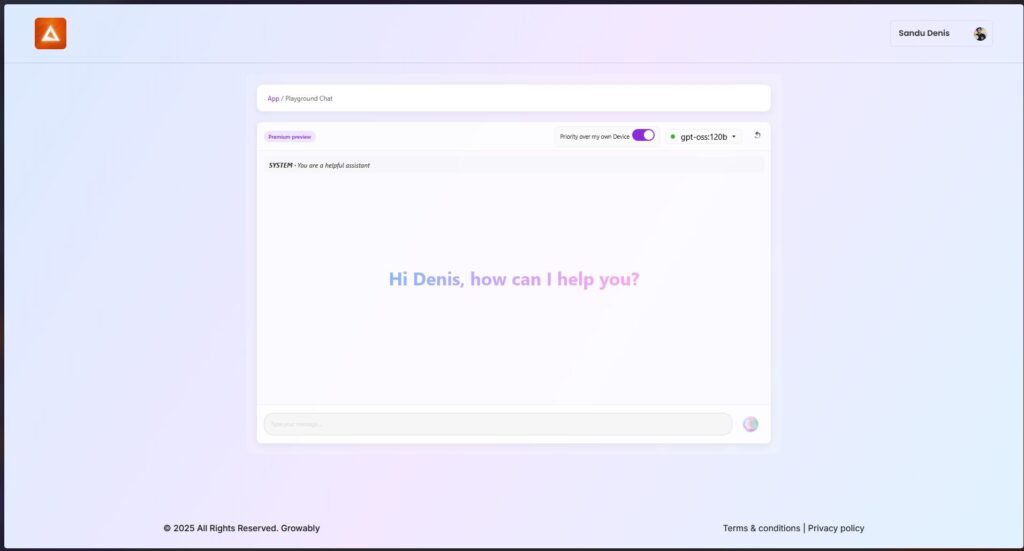

你而家可以用最新版本嘅 ShareAI Windows 客戶端試用呢啲模型。.

- 下載 ShareAI Windows 版 (連結到下載頁面)

安裝後,你可以直接喺ShareAI應用程式度輕鬆下載同埋運行GPT-OSS模型——唔需要複雜嘅設置或者配置。.

✨ GPT-OSS 功能亮點

以下係GPT-OSS點解係你AI驅動工作流程嘅改變者:

- 主動能力:

利用內置功能進行功能調用、網頁瀏覽、Python工具調用同埋結構化數據輸出。. - 完整嘅思維鏈透明度:

清楚睇到模型嘅推理過程,令調試更加容易,對生成結果更加信任。. - 可配置嘅推理層次:

根據你嘅延遲同埋複雜性需求,輕鬆調整推理努力(低、中、高)。. - 可微調架構:

通過參數微調廣泛定制模型以適應特定用途。. - 寬鬆嘅Apache 2.0許可證:

自由創新,無需受限於限制性嘅Copyleft許可證或者專利風險——非常適合商業部署同快速實驗。.

🔥 用MXFP4量化優化

OpenAI引入咗MXFP4量化,大幅減少GPT-OSS模型嘅內存佔用:

- MXFP4 格式解釋:

GPT-OSS 模型使用咗一種量化技術,將專家混合(MoE)權重量化到每個參數只需 4.25 bits。呢啲 MoE 權重佔咗模型總參數嘅 90% 以上,令量化效率極高。. - 增強兼容性:

呢個優化嘅量化技術可以:- 令 gpt-oss:20b 模型喺只需 16GB 記憶體嘅機器上順暢運行.

- 令 gpt-oss:120b 模型可以輕鬆適配單個 80GB GPU.

ShareAI 原生支持呢個 MXFP4 格式——唔需要額外步驟、轉換或者麻煩。我哋最新嘅引擎更新配備咗專為 MXFP4 格式設計嘅新開發內核,確保達到最佳性能。.

📌 GPT-OSS 模型現已推出:

GPT-OSS:20B

- 適合低延遲、專門任務或者本地部署。.

- 即使喺硬件配置唔高嘅情況下都提供穩定性能。.

GPT-OSS:120B

- 提供強大嘅推理能力、先進嘅代理能力,同埋適合大規模高要求任務嘅多功能性。.

- 完美適合需要更深層推理、更高準確性同更廣泛AI應用嘅開發者同企業。.

🛠️ 今日試下GPT-OSS

準備好體驗下一代AI能力未?

- 下載ShareAI Windows客戶端 (連結到下載頁面)

- 睇文件 (連結到用戶文檔或教程)

敬請期待—ShareAI繼續擴展我哋嘅模型庫,喺每一步都為你嘅AI項目賦能。.

開心提示!🚀