欢迎 OpenAI 的 GPT-OSS 加入 ShareAI

此页面中的 简体中文 是使用 TranslateGemma 从英文自动翻译的。翻译可能不完全准确。.

ShareAI 致力于为您带来最新、最强大的 AI 模型——今天我们再次做到了。.

几小时前,, OpenAI 发布了其突破性的 GPT-OSS 模型,您现在已经可以在 ShareAI 网络中开始使用它们了!

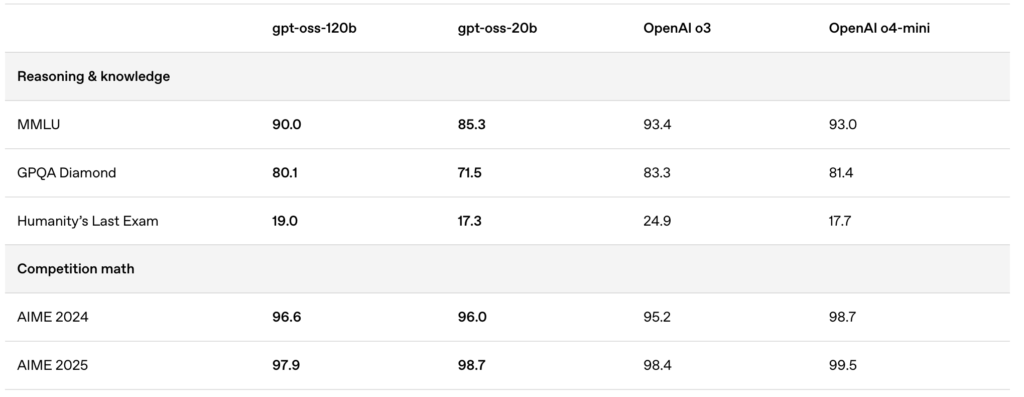

新发布的模型——gpt-oss:20b 和 gpt-oss:120b——提供卓越的本地聊天体验、强大的推理能力以及对高级开发者场景的增强支持。.

🚀 在 ShareAI 上开始使用 GPT-OSS

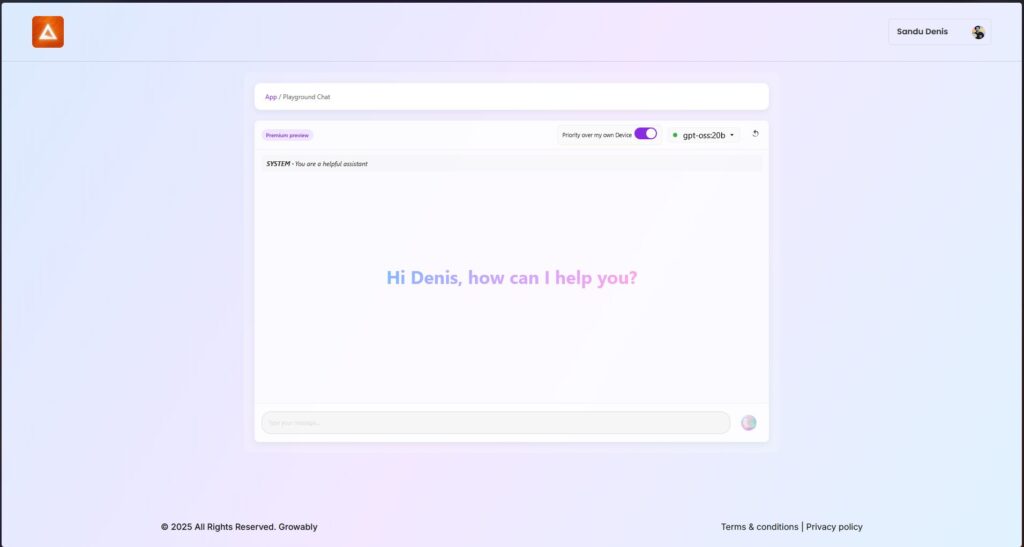

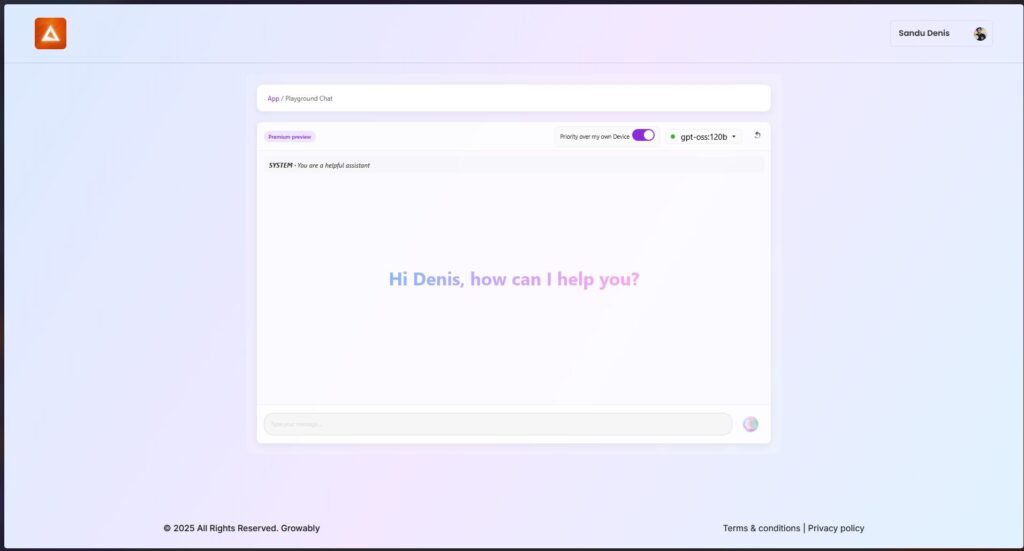

您现在可以通过最新版本的 ShareAI Windows 客户端试用这些模型。.

- 下载 ShareAI for Windows (链接到下载页面)

安装后,您可以直接从ShareAI应用程序轻松下载并运行GPT-OSS模型——无需复杂的设置或配置。.

✨ GPT-OSS功能亮点

以下是GPT-OSS为何能改变您的AI驱动工作流程的原因:

- 智能代理功能:

利用内置功能进行函数调用、网页浏览、Python工具调用和结构化数据输出。. - 完整的思维链透明性:

清晰了解模型的推理过程,使调试更容易并增强对生成结果的信任。. - 可配置的推理级别:

根据您的延迟和复杂性需求,轻松调整推理努力程度(低、中、高)。. - 可微调的架构:

通过参数微调广泛定制模型以适应特定用例。. - 宽松的Apache 2.0许可证:

自由创新,无需受限于限制性版权许可证或专利风险——非常适合商业部署和快速实验。.

🔥 使用MXFP4量化优化

OpenAI引入了MXFP4量化,大幅减少了GPT-OSS模型的内存占用:

- MXFP4 格式解析:

GPT-OSS 模型采用了一种量化技术,其中专家混合(Mixture-of-Experts,MoE)权重被量化到每个参数仅 4.25 位。这些 MoE 权重占模型总参数的 90% 以上,使得量化效率极高。. - 增强兼容性:

此优化的量化技术允许:- 模型 gpt-oss:20b 在仅有 16GB 内存的机器上流畅运行.

- 模型 gpt-oss:120b 模型能够轻松适配单个 80GB GPU.

ShareAI 原生支持此 MXFP4 格式——无需额外步骤、转换或麻烦。我们最新的引擎更新配备了专为 MXFP4 格式设计的新开发内核,确保性能达到巅峰。.

📌 GPT-OSS 模型现已推出:

GPT-OSS:20B

- 适用于低延迟、专业任务或本地部署。.

- 即使在硬件配置较低的情况下也能提供强劲性能。.

GPT-OSS:120B

- 提供强大的推理能力、先进的代理能力以及适合大规模高要求任务的多功能性。.

- 完美适用于需要更深层次推理、更高准确性和更广泛AI应用的开发者和企业。.

🛠️ 今天就试试GPT-OSS

准备好体验下一代AI能力了吗?

- 下载ShareAI Windows客户端 (链接到下载页面)

- 查看文档 (链接到用户文档或教程)

敬请期待——ShareAI将持续扩展我们的模型库,为您的AI项目每一步提供支持。.

祝您提示愉快!🚀