Beste Moonshot AI Kimi K2.5-Alternativen für Startups & Entwickler im Jahr 2026 (und wie man Modelle schnell mit einem ShareAI-Gateway austauscht)

Moonshot AI’s Kimi K2.5 ist eine dieser Veröffentlichungen, die sofort die Stimmung in offenen Modellen verändert: multimodal, agentisch, langkontextuell und wirklich nützlich für “echte Arbeit”-Workflows. Wenn Sie Kimi K2.5-Alternativen, recherchieren, hinterfragen Sie wahrscheinlich nicht seine Leistung – Sie hinterfragen die Passform.

Die beste Alternative hängt davon ab, was Sie entwickeln: ein Codierungsagent, ein Langdokument-Analyst, ein forschungsorientierter Bot oder eine Produktionsfunktion, bei der Zuverlässigkeit und Kostenvorhersehbarkeit wichtiger sind als rohe Spezifikationen. Und da sich Modellpreise und -qualität schnell ändern können, ist der langfristige Gewinn, Ihr Produkt modellwechselbarzu halten – nicht an einen einzigen Anbieter oder ein Modell gebunden.

Dieser Leitfaden behandelt die stärksten Kimi K2.5-Alternativen für Startups und Entwickler sowie wie man Modelle einfach über ein einziges KI-Gateway wie TeilenAI.

Schneller Vergleich von Kimi K2.5-Alternativen

Hier ist eine praktische Kurzliste, organisiert nach dem, was Teams normalerweise in der Produktion benötigen. Betrachten Sie dies als Ihre “probieren Sie diese zuerst”-Karte.

| Option | Am besten geeignet für | Warum Teams es Kimi K2.5 vorziehen | Kompromisse |

|---|---|---|---|

| DeepSeek-V3.2 | Argumentation + Agenten mit kleinem Budget | Schwerpunkt auf logischem Denken mit agentenfreundlichen Modi | Sie benötigen weiterhin Auswertungen; Verhalten variiert je nach Konfiguration |

| GLM-4.7 | Agenten-Workflows + UI-Generierung | Starke “Spezifikation → UI”-Tendenzen und Zuverlässigkeit bei mehrstufigen Workflows | Reife des Ökosystems variiert je nach Stack/Anbieter |

| Devstral 2 | Code-Agenten / SWE-Workflows | Spezialisiert auf repository-bewusste Software-Engineering-Aufgaben | Engerer Fokus als generalistische Modelle |

| Claude Opus 4.5 | Hochriskantes logisches Denken + Codierung | Premium-Zuverlässigkeit und starke Leistung für kritische Arbeiten | Höhere Kosten; Einschränkungen durch geschlossenes Modell |

| Grok 4.1 Schnell | Massiver Kontext + Tool-Aufruf | Entwickelt für ultra-langen Kontext und Agenten-Tooling | Geschlossenes Modell; Stil-/Stimmenanpassung kann variieren |

| ShareAI (Gateway) | Modell-agnostisch bleiben | Eine API für viele Modelle; Modelle ohne Neuschreibungen austauschen | Kein eigenes Modell—eine Infrastrukturschicht |

Was ist Moonshot AI’s Kimi K2.5?

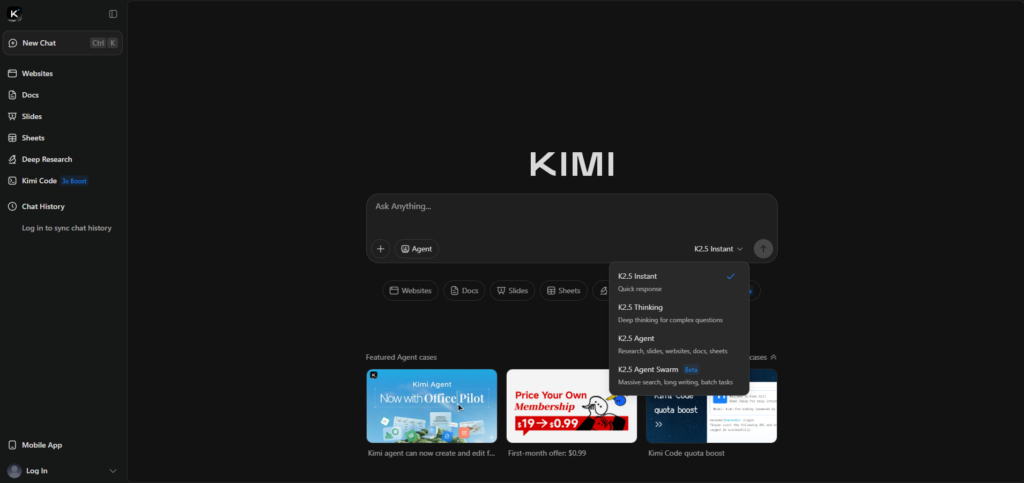

Kimi K2.5 ist ein Flaggschiffmodell von Moonshot AI, vermarktet als “Open Source”, mit Schwerpunkt auf multimodaler Argumentation und agentischer Ausführung. Die offizielle Veröffentlichungsseite hebt multimodale Eingaben (einschließlich Video) und “Agent Swarm”-Stil-Parallelisierung für komplexe Aufgaben hervor.

Wenn Sie die offizielle Funktionsliste und den Veröffentlichungskontext möchten, starten Sie hier: Kimi K2.5 (Moonshot KI).

Warum Menschen nach Alternativen zu Kimi K2.5 suchen

Die meisten Teams wechseln nicht, weil Kimi “schlecht” ist. Sie wechseln, weil sich die Anforderungen ändern, sobald man vom Demo- in den Produktionsmodus wechselt.

- Sie benötigen die beste Codierungszuverlässigkeit für Änderungen an mehreren Dateien, Fehlerbehebung oder repo-bewusste Workflows.

- Sie benötigen einen großen Kontext (Verträge, Wissensdatenbanken, Repositories) ohne brüchige Chunking-Strategien.

- Sie möchten geringere Varianz für kritische, kundenorientierte oder regulierte Workflows.

- Sie möchten keine Abhängigkeit—Sie möchten Hebelwirkung behalten, wenn sich Preise, Limits oder Qualität ändern.

Open-Weight-Alternativen (maximale Kontrolle)

DeepSeek-V3.2 (Schlussfolgerung + Agenten-Workflows)

DeepSeek-V3.2 ist eine starke Wahl, wenn Sie ein “Reasoning-First”-Modell für technische Aufgaben und Agenten-Pipelines suchen, insbesondere wenn Sie kostenempfindlich sind. Es wird oft als zuverlässiges Alltagsmodell für strukturiertes Denken und Werkzeugnutzungsmuster verwendet.

Referenz: DeepSeek API Release Notes.

GLM-4.7 (agentische Workflows + UI-Generierung)

GLM-4.7 lohnt sich zu testen, wenn Ihr Produkt mit Kimi's “Visual-to-Code”- und Workflow-Ausführungsansatz überschneidet. Teams evaluieren es oft für mehrstufiges Agentenverhalten und Zuverlässigkeit bei der UI-/Frontend-Generierung.

Referenz: GLM-4.7-Dokumentation.

Devstral 2 (Software-Engineering-Agenten)

Wenn Ihre Hauptanforderung End-to-End-Softwareentwicklung ist – Multi-Datei-Bearbeitungen, Repo-Navigation, Testkorrekturen – ist Devstral 2 als Spezialist positioniert. Es ist eine starke Alternative zu Kimi K2.5, wenn “Coding-Agent” der Kernjob ist, nicht multimodale Generalität.

Referenz: Mistral Devstral 2 Ankündigung.

Geschlossene Modelle (Grenzleistung + Unternehmenshaltung)

Claude Opus 4.5 (hochkomplexes Denken/Coding)

Claude Opus 4.5 ist eine übliche Wahl “Zahlen für Zuverlässigkeit”, wenn Korrektheit wichtiger ist als Kosten. Wenn Ihre Arbeitslast empfindlich auf subtile Denkfehler oder Codierungsfehler reagiert, ist es eine der stärksten Premium-Alternativen zu Moonshot AI’s Kimi K2.5.

Referenz: Anthropic: Claude Opus 4.5.

Massive-Kontext + Echtzeit-Tool-Alternativen

Grok 4.1 Fast (ultralanger Kontext + Tools)

Grok 4.1 Fast ist aus einem Grund bemerkenswert: Es ist um extrem langen Kontext und Agenten-Tools herum aufgebaut. Wenn Sie “erst alles lesen”-Workflows haben (große Repos, umfangreiche Dokumentensätze), kann es eine überzeugende alternative Kategorie sein, die neben Kimi K2.5 getestet werden sollte.

Referenz: xAI: Grok 4.1 Schnell.

Der Startup-“Cheat-Code”: Setzen Sie das Produkt nicht auf ein Modell

Auch wenn Kimi K2.5 heute Ihr Favorit ist, ist es die beste langfristige Ingenieursentscheidung, Ihr Produkt so zu gestalten, dass es später Modelle wechseln kann. Preisänderungen, Ausfälle passieren, Ratenlimits erscheinen und manchmal machen Modelle Rückschritte.

Ein einfaches, langlebiges Muster ist: Wählen Sie ein Standardmodell für den üblichen Weg, ein Spezialistenmodell für schwierige Anforderungen (Coding-Agent oder massiver Kontext) und ein Ersatzmodell für Zuverlässigkeit. Genau das sollte ein AI-Gateway einfach machen.

Wie ShareAI Kimi K2.5 und seine Alternativen austauschbar macht

ShareAI ist für Modelloptionen gebaut: eine OpenAI-kompatible API über einen breiten Katalog, sodass Sie Modelle vergleichen und routen können, ohne Integrationen neu zu schreiben. Beginnen Sie mit dem Modell-Marktplatz, Testaufforderungen in der Spielplatz, und integrieren über die API-Referenz.

Wenn Sie ein Team einarbeiten, ist die Konsolenübersicht eine schnelle Orientierung. Für die Produktionsplanung behalten Sie Versionshinweise und den Anbieterleitfaden.

Beispiel: tauschen Sie das Modell Feld (keine Neuschreibung)

Dies ist der Kernvorteil eines einzigen KI-Gateways: Ihre App behält die gleiche Anforderungsstruktur bei, und Sie wechseln die Modelle, indem Sie ein Feld ändern. Erstellen Sie zuerst einen Schlüssel in der Konsole: API-Schlüssel erstellen.

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Tauschen Sie jetzt nur den Modellnamen aus (alles andere bleibt gleich):

curl -s "https://api.shareai.now/api/v1/chat/completions" \"In einem Kimi K2.5-Alternativen-Workflow können Sie damit schnelle Vergleiche durchführen, Fallbacks hinzufügen und die Hebelwirkung beibehalten, während sich die Modelllandschaft verändert.

So wählen Sie die richtige Kimi K2.5-Alternative in 30 Minuten aus

- Definieren Sie die Aufgabe (Code-Agent behebt Tests, RAG beantwortet Fragen aus internen Dokumenten, Vertragsanalyse, UI-zu-Code).

- Erstellen Sie ein kleines Evaluationsset (10–30 Aufforderungen), einschließlich Fehlerfälle und Randfälle.

- Testen Sie 3–5 Kandidaten (Kimi K2.5 + zwei Spezialisten + eine günstige Rückfalloption) und bewerten Sie Korrektheit, Zuverlässigkeit der Formatierung, Genauigkeit der Werkzeugnutzung und Latenz.

- Ausliefern mit einer Rückfalloption damit Ausfälle, Begrenzungen und Regressionen keine benutzerseitigen Vorfälle werden.

Wenn Sie einen sauberen Ausgangspunkt für Einrichtung und Best Practices möchten, speichern Sie die Seite als Lesezeichen ShareAI-Dokumentation und den API-Schnellstart.

FAQ

Ist Kimi K2.5 Open Source oder Open-Weight?

Moonshot AI vermarktet Kimi K2.5 als “Open Source” und verweist auf die öffentliche Verfügbarkeit über gängige OSS-Distributionskanäle. In der Praxis verwenden viele Teams den Begriff Open-Weight um präzise zu sein: Gewichte sind verfügbar, aber Lizenzierung und der vollständige Trainingsstack können von den “klassischen” Open-Source-Software-Normen abweichen.

Referenz: Kimi K2.5 offizielle Seite.

Wann sollte ich Kimi K2.5 gegenüber Alternativen wählen?

Wählen Sie Kimi K2.5, wenn Ihre Arbeitslast stark multimodal ist (einschließlich Video), agentisch ist und von dem “Schwarm”-Ansatz des Modells zur Zerlegung großer Aufgaben profitiert. Wenn Sie UI-aus-visuellen Workflows erstellen, ist es ebenfalls ein natürlicher Ausgangspunkt.

Welche Alternative ist am besten für Coding-Agenten vs. allgemeines Coding?

Wenn Sie einen repo-bewussten Agenten erstellen, der mehrere Dateien bearbeitet, Tests durchführt und iteriert, beginnen Sie mit Devstral 2. Wenn Sie Premium-Zuverlässigkeit für komplexes Coding wünschen, ist Claude Opus 4.5 eine häufige Benchmark-Wahl – insbesondere für kritische Pfade.

Welche Alternative ist am besten für lange Dokumente und großen Kontext?

Für Workflows wie “erst alles lesen”, gehört Grok 4.1 Fast in die Kategorie mit großem Kontext. Das gesagt, viele Produkte funktionieren besser mit RAG plus einem kleineren Kontextfenster, also testen Sie beide Ansätze, anstatt anzunehmen, dass größerer Kontext immer gewinnt.

Wie vergleiche ich Modelle fair?

Verwenden Sie denselben Prompt-Satz, Bewertungsrubrik und Einstellungen (Temperatur, maximale Tokens, Formatierungsregeln). Bewerten Sie pro Aufgabe: Korrektheit, Format/JSON-Zuverlässigkeit, Werkzeuggenauigkeit, Latenz und Kosten pro erfolgreichem Ergebnis.

Was ist der schnellste Weg, Kimi K2.5-Alternativen zu A/B-testen, ohne meine App neu zu erstellen?

Standardisieren Sie auf eine API-Schnittstelle und tauschen Sie das Modell Feld aus. Mit einem Gateway wie ShareAI können Sie Kandidaten im Spielplatz vergleichen und dann dieselbe Anforderungsstruktur über das API.

versenden. Kann ich nach “günstigstem” oder “schnellstem” routen?

Das ist die Idee hinter richtlinienbasierter Weiterleitung: Wählen Sie ein Modell basierend auf Einschränkungen wie Kostenobergrenze, Latenzziel oder Aufgabentyp. Selbst wenn Sie einfach beginnen (manuelle Modellauswahl), bleibt der Aufbau von Routing-Richtlinien flexibel, während Anbieter und Modelle sich weiterentwickeln.

Wie helfen Fallback-Modelle in der Produktion?

Fallbacks schützen Sie vor vorübergehenden Ausfällen, Anbieter-Ratenlimits, regionalen Problemen und Modellregressionen. Eine Fallback-Strategie ist oft wichtiger für die Benutzererfahrung als das Streben nach dem auf dem Papier “besten” Modell.

Wie kontrolliere ich die Kosten?

Verwenden Sie ein günstiges Standardmodell für den häufigen Pfad, begrenzen Sie die Ausgabetokens und reservieren Sie Premium-Modelle für Anfragen, die sie wirklich benötigen. Verfolgen Sie die Kosten pro erfolgreiches Ergebnis, nicht nur die Kosten pro Token.

Muss ich für Datenschutz oder Compliance selbst hosten?

Nicht immer. Es hängt von Ihrer Datenklassifizierung, den Anforderungen an den Datenstandort und den Bedingungen des Anbieters ab. Beginnen Sie mit der Richtlinie (welche Daten wohin gesendet werden können) und wählen Sie dann den Bereitstellungsansatz, der dazu passt.

Welche Aufgaben profitieren noch von Open-Weight-Self-Hosting?

Häufige Gründe sind Datenlokalität, vorhersehbare Latenz, tiefgehende Anpassung und enge Integration mit internen Tools und Schutzmaßnahmen. Wenn das Ihre Einschränkungen sind, können Open-Weight-Modelle eine starke Grundlage sein – vorausgesetzt, Sie sind bereit, die Betriebsverantwortung zu übernehmen.

Was, wenn sich das Modellverhalten im Laufe der Zeit ändert?

Gehen Sie davon aus, dass es das tut. Halten Sie einen Regressionstest-Datensatz bereit, überwachen Sie Qualitätsabweichungen und stellen Sie sicher, dass Sie schnell zurückrollen können, indem Sie Modelle oder Anbieter wechseln.

Fazit: Wählen Sie heute das beste Modell und behalten Sie die Möglichkeit, morgen zu wechseln.

Kimi K2.5 ist ein ernstzunehmendes Modell von Moonshot AI und für viele Teams eine ausgezeichnete Basis. Aber der produktionsfreundlichste Ansatz ist, das beste Modell für jede Aufgabe zu wählen – und die Möglichkeit zu behalten, zu wechseln, wenn sich die Landschaft ändert.

Wenn Sie diese Flexibilität ohne ständige Reintegrationsarbeit möchten, beginnen Sie mit dem Durchsuchen der Modell-Marktplatz, dem Testen im Spielplatz, und erstellen Sie Ihr Konto über Anmelden / Registrieren. ::contentReference[oaicite:0]{index=0}