Las mejores alternativas a Moonshot AI Kimi K2.5 para startups y desarrolladores en 2026 (y cómo cambiar modelos rápidamente con una puerta de enlace ShareAI).

Moonshot AI’s Kimi K2.5 es uno de esos lanzamientos que cambia instantáneamente el ambiente en modelos abiertos: multimodal, agente, de largo contexto y genuinamente útil para flujos de trabajo de “trabajo real”. Si estás investigando alternativas a Kimi K2.5, probablemente no estés cuestionando su poder—estás cuestionando su ajuste.

La mejor alternativa depende de lo que estés desarrollando: un agente de codificación, un analista de documentos largos, un bot de investigación que utiliza herramientas, o una característica de producción donde la fiabilidad y la previsibilidad de costos importan más que las especificaciones brutas. Y debido a que los precios y la calidad de los modelos pueden cambiar rápidamente, la victoria a largo plazo es mantener tu producto intercambiable de modelo—no bloqueado a un solo proveedor o modelo.

Esta guía cubre las alternativas más fuertes a Kimi K2.5 para startups y desarrolladores, además de cómo cambiar modelos fácilmente a través de una única puerta de enlace de IA como ShareAI.

Comparación rápida de alternativas a Kimi K2.5

Aquí tienes una lista práctica, organizada por lo que los equipos suelen necesitar en producción. Piensa en esto como tu mapa de “prueba estos primero”.

| Opción | Mejor para | Por qué los equipos lo eligen sobre Kimi K2.5 | Compromisos |

|---|---|---|---|

| DeepSeek-V3.2 | Razonamiento + agentes con presupuesto limitado | Enfoque en el razonamiento primero con modos amigables para agentes | Aún necesitas evaluaciones; el comportamiento varía según la configuración |

| GLM-4.7 | Flujos de trabajo de agentes + generación de UI | Fuertes tendencias de “especificación → UI” y confiabilidad en flujos de trabajo de múltiples pasos | La madurez del ecosistema varía según la pila/proveedor |

| Devstral 2 | Agentes de código / flujos de trabajo SWE | Especializado en tareas de ingeniería de software conscientes del repositorio | Enfoque más limitado que los modelos generalistas |

| Claude Opus 4.5 | Razonamiento de alto riesgo + codificación | Confiabilidad premium y alto rendimiento para trabajo crítico | Mayor costo; restricciones de modelo cerrado |

| Grok 4.1 Rápido | Contexto masivo + llamada a herramientas | Diseñado en torno a un contexto ultra-largo y herramientas de agentes | Modelo cerrado; el estilo/tono puede variar |

| ShareAI (puerta de enlace) | Manteniéndose agnóstico al modelo | Una API para muchos modelos; intercambia modelos sin reescrituras | No es un modelo en sí mismo, sino una capa de infraestructura |

¿Qué es Kimi K2.5 de Moonshot AI?

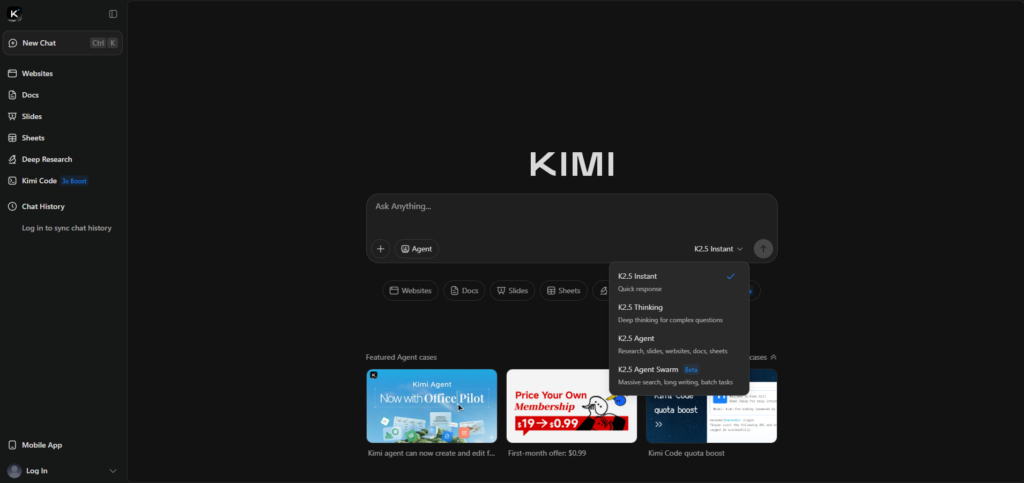

Kimi K2.5 es un modelo insignia de Moonshot AI, comercializado como “código abierto,” con énfasis en el razonamiento multimodal y la ejecución agente. La página oficial de lanzamiento destaca entradas multimodales (incluido video) y la paralelización estilo “Agent Swarm” para tareas complejas.

Si deseas la lista oficial de características y el contexto de lanzamiento, comienza aquí: Kimi K2.5 (Moonshot AI).

Por qué las personas buscan alternativas a Kimi K2.5

La mayoría de los equipos no cambian porque Kimi sea “malo.” Cambian porque las restricciones cambian una vez que pasas de la demostración a la producción.

- Necesitas la mejor confiabilidad en codificación para cambios en múltiples archivos, corrección de errores o flujos de trabajo conscientes del repositorio.

- Necesitas un contexto enorme (contratos, bases de conocimiento, repositorios) sin estrategias frágiles de fragmentación.

- Quieres menor variabilidad para flujos de trabajo críticos, orientados al cliente o regulados.

- No quieres estar atado—quieres mantener la ventaja cuando cambien los precios, límites o calidad.

Alternativas de peso abierto (máximo control)

DeepSeek-V3.2 (razonamiento + flujos de trabajo de agentes)

DeepSeek-V3.2 es una excelente opción cuando necesitas un modelo “primero el razonamiento” para tareas técnicas y flujos de trabajo de agentes, especialmente si eres sensible a los costos. A menudo se utiliza como un modelo confiable para el pensamiento estructurado y patrones de uso de herramientas.

Referencia: Notas de lanzamiento de la API de DeepSeek.

GLM-4.7 (flujos de trabajo agentivos + generación de UI)

Vale la pena probar GLM-4.7 si tu producto se superpone con el enfoque de “visual-a-código” y ejecución de flujos de trabajo de Kimi. Los equipos a menudo lo evalúan para el comportamiento agentivo de múltiples pasos y la confiabilidad en la generación de UI/front-end.

Referencia: Documentación de GLM-4.7.

Devstral 2 (agentes de ingeniería de software)

Si su principal requisito es la ingeniería de software de extremo a extremo—ediciones de múltiples archivos, navegación por repositorios, corrección de pruebas—Devstral 2 está posicionado como un especialista. Es una fuerte alternativa a Kimi K2.5 cuando el “agente de codificación” es el trabajo principal, no el generalismo multimodal.

Referencia: Anuncio de Mistral Devstral 2.

Modelos cerrados (rendimiento de frontera + postura empresarial)

Claude Opus 4.5 (razonamiento/codificación de alto riesgo)

Claude Opus 4.5 es una opción común de “pagar por fiabilidad” cuando la corrección importa más que el costo. Si su carga de trabajo es sensible a errores sutiles de razonamiento o errores de codificación, es una de las alternativas premium más fuertes a Kimi K2.5 de Moonshot AI.

Referencia: Anthropic: Claude Opus 4.5.

Alternativas de herramientas de contexto masivo + en tiempo real

Grok 4.1 Fast (contexto ultra-largo + herramientas)

Grok 4.1 Fast es notable por una razón: está diseñado en torno a un contexto extremadamente largo y herramientas de agente. Si tiene flujos de trabajo de “leer todo primero” (grandes repositorios, conjuntos de documentos extensos), puede ser una categoría alternativa convincente para probar junto a Kimi K2.5.

Referencia: xAI: Grok 4.1 Rápido.

El “código secreto” de las startups: no apueste el producto a un solo modelo

Incluso si Kimi K2.5 es su favorito hoy, construir su producto para que pueda cambiar de modelo más adelante es la mejor decisión de ingeniería a largo plazo. Los cambios de precios, las interrupciones ocurren, aparecen límites de tasa y, a veces, los modelos retroceden.

Un patrón simple y duradero es: elegir un modelo predeterminado para el camino común, un modelo especialista para solicitudes difíciles (agente de codificación o contexto masivo), y un modelo de respaldo para fiabilidad. Esto es exactamente lo que una puerta de enlace de IA debería facilitar.

Cómo ShareAI hace que Kimi K2.5 y sus alternativas sean intercambiables

ShareAI está diseñado para la opcionalidad de modelos: una API compatible con OpenAI a través de un amplio catálogo, para que pueda comparar y enrutar modelos sin reescribir integraciones. Comience con el Mercado de Modelos, prueba indicaciones en el Área de pruebas, e integrar a través de la Referencia de API.

Si estás incorporando un equipo, el Resumen de la Consola es una orientación rápida. Para la planificación de producción, mantén un ojo en Notas de Lanzamiento y la Guía del proveedor.

Ejemplo: intercambia el modelo campo (sin reescribir)

Esta es la ventaja principal de una única puerta de enlace de IA: tu aplicación mantiene la misma forma de solicitud, y cambias modelos modificando un campo. Primero, crea una clave en la Consola: Crear clave API.

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Ahora intercambia solo el nombre del modelo (todo lo demás permanece igual):

curl -s "https://api.shareai.now/api/v1/chat/completions" \"En un flujo de trabajo de alternativas Kimi K2.5, esto te permite realizar comparaciones rápidas, agregar respaldos y mantener ventaja mientras el panorama de modelos cambia.

Cómo elegir la alternativa correcta de Kimi K2.5 en 30 minutos

- Define el trabajo (agente de código corrige pruebas, RAG responde desde documentos internos, análisis de contratos, UI a código).

- Crea un pequeño conjunto de evaluación (10–30 indicaciones), incluyendo casos de fallo y casos límite.

- Prueba de 3 a 5 candidatos (Kimi K2.5 + dos especialistas + una opción económica de respaldo) y puntúa por corrección, fiabilidad de formato, precisión en el uso de herramientas y latencia.

- Lanza con un respaldo para que las interrupciones, límites y regresiones no se conviertan en incidentes visibles para los usuarios.

Si deseas un punto de partida limpio para la configuración y las mejores prácticas, guarda en marcadores el Documentación de ShareAI y la inicio rápido de la API.

Preguntas frecuentes

¿Es Kimi K2.5 de código abierto o de peso abierto?

Moonshot AI comercializa Kimi K2.5 como “código abierto” y enlaza a la disponibilidad pública a través de canales comunes de distribución OSS. En la práctica, muchos equipos usan el término peso abierto para ser precisos: los pesos están disponibles, pero la licencia y toda la pila de entrenamiento pueden diferir de las normas de software de “código abierto clásico”.

Referencia: Página oficial de Kimi K2.5.

¿Cuándo debería elegir Kimi K2.5 sobre otras alternativas?

Elige Kimi K2.5 cuando tu carga de trabajo sea altamente multimodal (incluyendo video), agente y se beneficie del enfoque “enjambre” del modelo para descomponer tareas grandes. Si estás construyendo flujos de trabajo de UI a partir de visuales, también es un lugar natural para comenzar.

¿Qué alternativa es mejor para agentes de codificación frente a codificación general?

Si estás construyendo un agente consciente del repositorio que edite múltiples archivos, ejecute pruebas e itere, comienza con Devstral 2. Si deseas una fiabilidad premium de “mejor esfuerzo” para codificación compleja, Claude Opus 4.5 es una opción de referencia común, especialmente para rutas críticas.

¿Qué alternativa es mejor para documentos largos y contextos enormes?

Para flujos de trabajo de “leer todo primero”, Grok 4.1 Fast está en el grupo de contexto masivo. Dicho esto, muchos productos funcionan mejor con RAG más una ventana de contexto más pequeña, así que prueba ambos enfoques en lugar de asumir que un contexto más grande siempre gana.

¿Cómo comparo modelos de manera justa?

Usa el mismo conjunto de indicaciones, rúbrica de evaluación y configuraciones (temperatura, tokens máximos, reglas de formato). Evalúa por tarea: corrección, formato/confiabilidad de JSON, precisión de herramientas, latencia y costo por resultado exitoso.

¿Cuál es la forma más rápida de hacer pruebas A/B de alternativas de Kimi K2.5 sin reconstruir mi aplicación?

Estandariza en una interfaz API y cambia el modelo campo. Usando una puerta de enlace como ShareAI, puedes comparar candidatos en el Área de pruebas y luego enviar la misma forma de solicitud a través del API.

¿Puedo enrutar por “más barato” o “más rápido”?

Esa es la idea detrás del enrutamiento basado en políticas: elige un modelo basado en restricciones como límite de costo, objetivo de latencia o tipo de tarea. Incluso si comienzas de manera simple (selección manual de modelos), construir hacia políticas de enrutamiento te mantiene flexible a medida que los proveedores y modelos evolucionan.

¿Cómo ayudan los modelos de respaldo en producción?

Los respaldos te protegen de fallos transitorios, límites de tasa de proveedores, problemas regionales y regresiones de modelos. Una estrategia de respaldo a menudo importa más para la experiencia del usuario que perseguir el único modelo “mejor” en papel.

¿Cómo controlo los costos?

Usa un modelo predeterminado barato para el camino común, limita los tokens de salida y reserva modelos premium para solicitudes que realmente los necesiten. Rastrea el costo por resultado exitoso, no solo el costo por token.

¿Necesito alojar por mi cuenta para privacidad o cumplimiento?

No siempre. Depende de la clasificación de tus datos, necesidades de residencia y términos del proveedor. Comienza con la política (qué datos se pueden enviar y dónde), luego elige el enfoque de implementación que coincida con ella.

¿Qué tareas aún se benefician del autoalojamiento con pesos abiertos?

Las razones comunes incluyen la localización de datos, latencia predecible, personalización profunda e integración estrecha con herramientas internas y medidas de seguridad. Si esas son tus limitaciones, los modelos de peso abierto pueden ser una base sólida, si estás listo para encargarte de las operaciones.

¿Qué pasa si el comportamiento del modelo cambia con el tiempo?

Asume que lo hará. Mantén un conjunto de evaluación de regresión, monitorea la deriva de calidad y asegúrate de poder retroceder rápidamente cambiando modelos o proveedores.

Resumen: elige el mejor modelo hoy, mantén la capacidad de cambiar mañana.

Kimi K2.5 es un modelo serio de Moonshot AI, y para muchos equipos es una excelente línea base. Pero el enfoque más amigable para la producción es elegir el mejor modelo para cada tarea y mantener la capacidad de cambiar cuando el panorama cambie.

Si deseas esa flexibilidad sin trabajo constante de reintegración, comienza navegando por el Mercado de modelos, probando en el Área de pruebas, y creando tu cuenta a través de Iniciar sesión / Registrarse. ::contentReference[oaicite:0]{index=0}