Bienvenido GPT-OSS de OpenAI a ShareAI

ShareAI está comprometido a ofrecerte los modelos de IA más recientes y poderosos—y lo estamos haciendo nuevamente hoy.

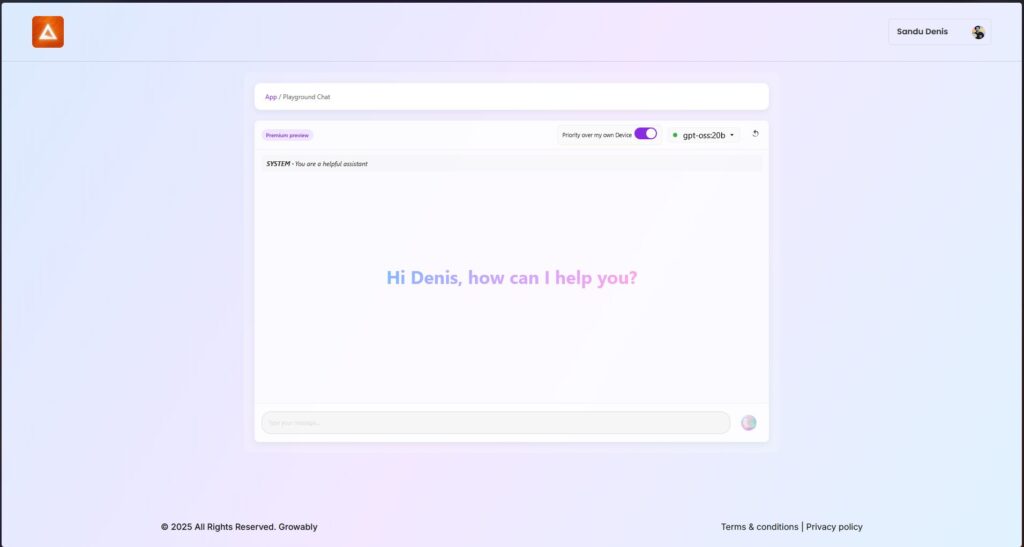

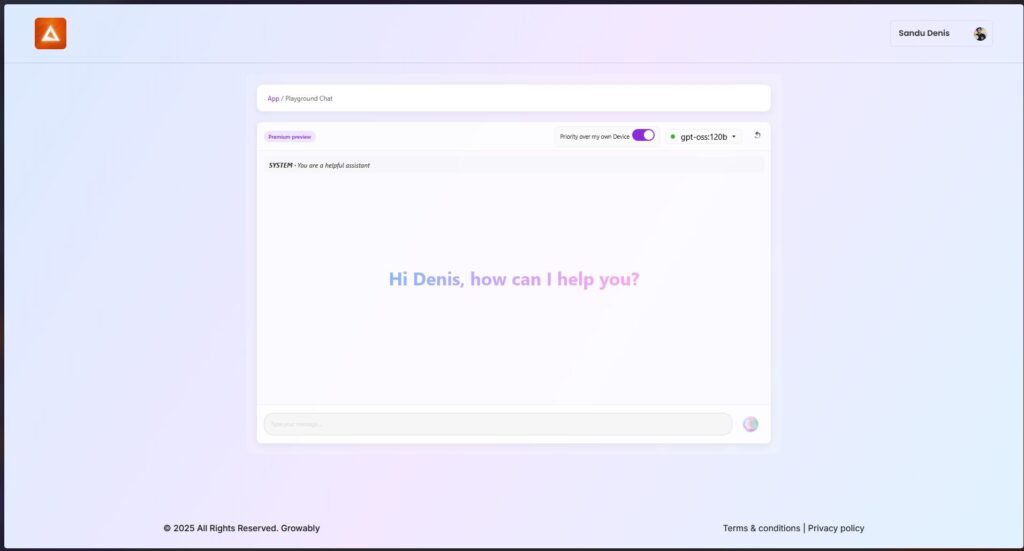

Hace unas horas, OpenAI lanzó su revolucionario GPT-OSS modelos, ¡y ya puedes comenzar a usarlos dentro de la red de ShareAI!

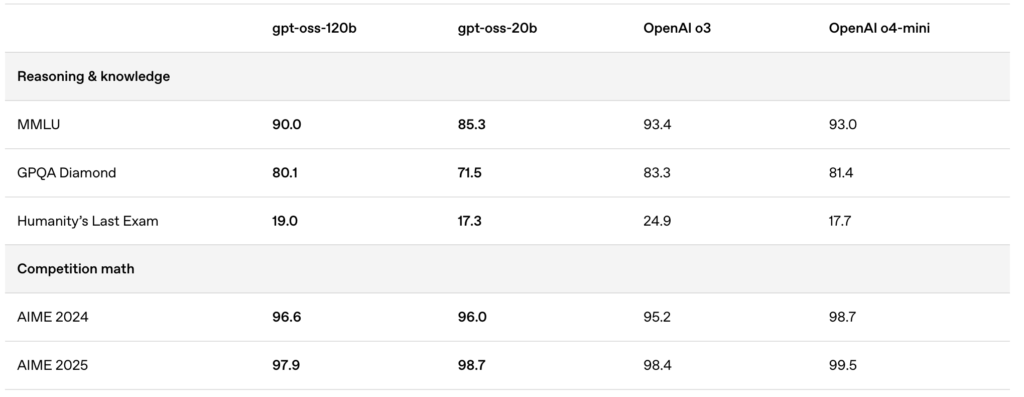

Los modelos recién lanzados—gpt-oss:20b and gpt-oss:120b—ofrecen experiencias excepcionales de chat local, potentes capacidades de razonamiento y soporte mejorado para escenarios avanzados de desarrollo.

🚀 Comienza con GPT-OSS en ShareAI

Puedes probar estos modelos ahora mismo utilizando la última versión del cliente de Windows de ShareAI.

- Descarga ShareAI para Windows (enlace a la página de descarga)

Después de la instalación, puedes descargar y ejecutar fácilmente los modelos GPT-OSS directamente desde la aplicación ShareAI—sin configuraciones complicadas ni ajustes necesarios.

✨ Destacados de las características de GPT-OSS

Aquí está la razón por la cual GPT-OSS es un cambio revolucionario para tus flujos de trabajo impulsados por IA:

- Capacidades agénticas:

Aprovecha las funciones integradas para llamadas de funciones, navegación web, llamadas a herramientas de Python y salidas de datos estructurados. - Transparencia completa en la cadena de pensamiento:

Obtén una visibilidad clara del proceso de razonamiento del modelo, lo que facilita la depuración y genera mayor confianza en los resultados generados. - Niveles de razonamiento configurables:

Ajusta fácilmente el esfuerzo de razonamiento (bajo, medio, alto) según tus necesidades de latencia y complejidad. - Arquitectura ajustable:

Personaliza ampliamente los modelos con ajustes de parámetros para casos de uso específicos. - Licencia permisiva Apache 2.0:

Innova libremente sin licencias restrictivas copyleft ni riesgos de patentes—perfecto para implementación comercial y experimentación rápida.

🔥 Optimizado con cuantización MXFP4

OpenAI ha introducido la cuantización MXFP4, reduciendo significativamente el uso de memoria de los modelos GPT-OSS:

- Formato MXFP4 Explicado:

Los modelos GPT-OSS utilizan una técnica de cuantificación donde los pesos de Mixture-of-Experts (MoE) se cuantifican a solo 4.25 bits por parámetro. Estos pesos MoE comprenden más del 90% de los parámetros totales del modelo, haciendo la cuantificación increíblemente eficiente. - Compatibilidad Mejorada:

Esta cuantificación optimizada permite:- Que el gpt-oss:20b modelo funcione sin problemas en máquinas con tan solo 16GB de memoria.

- Que el gpt-oss:120b Que el modelo se ajuste cómodamente en una sola GPU de 80GB.

ShareAI admite este formato MXFP4 de forma nativa—sin pasos adicionales, conversiones ni complicaciones requeridas. Nuestra última actualización del motor incluye kernels desarrollados específicamente para el formato MXFP4, asegurando un rendimiento máximo.

📌 Modelos GPT-OSS Disponibles Ahora:

GPT-OSS:20B

- Ideal para tareas especializadas de baja latencia o implementaciones locales.

- Ofrece un rendimiento robusto incluso en configuraciones de hardware modestas.

GPT-OSS:120B

- Ofrece razonamiento poderoso, capacidades avanzadas de agencia y versatilidad adecuada para tareas exigentes a gran escala.

- Perfecto para desarrolladores y empresas que requieren un razonamiento más profundo, mayor precisión y aplicaciones de IA más amplias.

🛠️ Prueba GPT-OSS hoy

¿Listo para experimentar capacidades de IA de próxima generación?

- Descarga el cliente de Windows de ShareAI (enlace a la página de descarga)

- Ver documentación (enlace a los documentos del usuario o tutoriales)

Mantente atento: ShareAI continúa ampliando nuestra biblioteca de modelos, potenciando tus proyectos de IA en cada paso del camino.

¡Feliz uso! 🚀