Alternatives à RouteLLM 2026 : Quand choisir ShareAI (et quoi d'autre considérer)

Mis à jour en février 2026

Les développeurs choisissent RouteLLM pour acheminer les invites vers des modèles moins coûteux tout en visant une qualité proche de GPT-4—surtout pour des tâches de type benchmark où un routeur appris peut réduire en toute confiance. Mais si vous vous souciez davantage de la transparence du marché avant chaque route (prix en direct, latence, disponibilité, temps de fonctionnement), basculement instantané entre plusieurs fournisseurs, politique de périphérie et audit, ou un proxy/passerelle auto-hébergé, l'une de ces alternatives à RouteLLM pourrait mieux convenir à votre pile.

Ce guide d'achat est écrit comme le ferait un constructeur : compromis spécifiques, choix rapides, analyses approfondies, comparaisons côte à côte, et un démarrage rapide ShareAI prêt à copier-coller pour que vous puissiez livrer dès aujourd'hui.

Comprendre RouteLLM (et où il peut ne pas convenir)

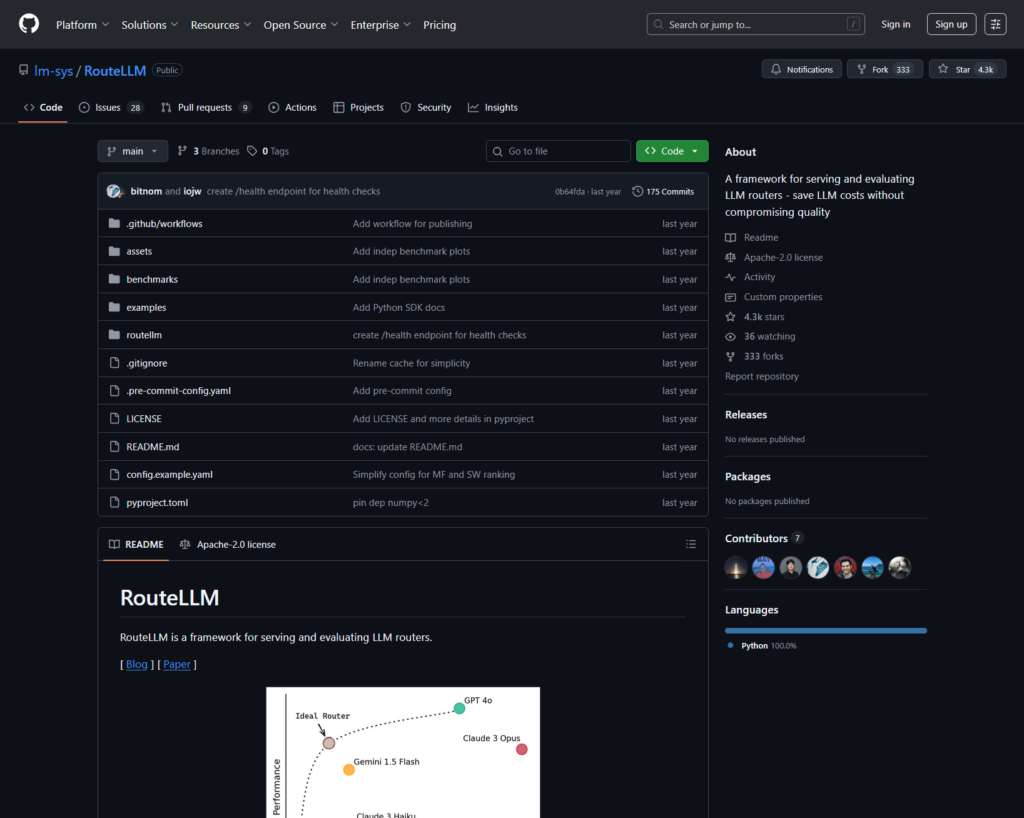

Ce qu'est RouteLLM. RouteLLM est un framework open-source pour servir et évaluer des routeurs LLM. Il propose un client/serveur compatible OpenAI prêt à l'emploi et fournit des modèles de routage entraînés qui peuvent acheminer des requêtes plus simples vers des modèles moins coûteux—rapportant jusqu'à 85% de réduction des coûts tout en maintenant ~95% des performances de GPT-4 sur des benchmarks courants (par exemple, MT-Bench).

Pourquoi les équipes le choisissent.

- Routage conscient des coûts avec des politiques soutenues par la recherche.

- Open source et extensible en Python.

- Compatible avec OpenAI chemin vers un routage d'essai sans réécritures lourdes de SDK.

Où RouteLLM peut ne pas convenir.

- Vous voulez transparence du marché en direct (prix, latence, disponibilité, accessibilité) avant chaque route—pas seulement une politique apprise.

- Vous avez besoin basculement multi-fournisseurs

- Votre feuille de route s'étend API multimodales comme OCR, discours, traduction et analyse de documents sous un même toit.

Comment choisir une alternative à RouteLLM

- Coût total de possession (TCO). Ne vous arrêtez pas à $/1K tokens. Comptez les taux de cache, les reprises/retours en arrière, la mise en file d'attente, les coûts des évaluateurs et le fardeau opérationnel des journaux/alertes. Les routeurs et passerelles conscients du cache avec un cache sémantique peuvent rendre un “ prix de liste plus cher ” moins coûteux en pratique.

- Latence et fiabilité. Privilégiez le routage sensible à la région, la fidélité au fournisseur lorsqu'un cache est chaud, et les retours précis (réessayer les 429, escalader en cas de délais d'attente). Les routeurs hébergés qui vous maintiennent sur le même fournisseur pour des contextes chauds et reviennent en arrière lorsqu'un fournisseur a des défaillances ont tendance à l'emporter.

- Observabilité et gouvernance. Si les garde-fous, la rédaction, les journaux d'audit et les politiques à la périphérie sont importants, une passerelle IA (Portkey ou Kong AI Gateway) est généralement plus forte qu'un simple routeur seul. De nombreuses équipes associent routeur + passerelle.

- Auto-hébergé vs géré. Vous préférez Docker/K8s/Helm et un proxy compatible OpenAI ? Essayez LiteLLM. Vous voulez une vitesse hébergée + visibilité du marché ? Envisagez ShareAI ou OpenRouter.

- Étendue au-delà du chat. Si vous avez besoin d'OCR, de discours, de traduction ou d'analyse de documents en plus du chat LLM, un orchestrateur multimodal tel qu'Eden AI est utile.

- Routage basé sur les données. Si vous préférez des benchmarks en direct pour orienter le coût/la vitesse/la qualité par région ou charge de travail, évaluez Unify.

Meilleures alternatives à RouteLLM (sélections rapides)

ShareAI (notre choix pour la transparence du marché + l'économie des créateurs)

Une API pour un large catalogue de modèles/fournisseurs avec basculement instantané et un marché qui met en avant le prix, la latence, le temps de disponibilité, la disponibilité avant de router. Commencez rapidement dans le Terrain de jeu, prenez les clés dans le Console, parcourez Docs, et comparez les options dans le Modèles.

Eden AI (orchestrateur multimodal)

API unifiée à travers les LLM plus image, OCR/analyse de documents, discours et traduction—ainsi que comparaison de modèles, surveillance, mise en cache et traitement par lots.

OpenRouter (routage conscient du cache)

Routeur hébergé à travers de nombreux LLMs avec mise en cache des invites et adhérence aux fournisseurs pour réutiliser des contextes chauds ; revient en arrière lorsqu'un fournisseur est indisponible.

Portkey (politiques & opérations SRE à la passerelle)

Passerelle IA avec basculements programmables, playbooks de limitation de débit et cache sémantique—plus des traces/métriques détaillées pour le contrôle en production.

Kong AI Gateway (gouvernance et audit en périphérie)

Apportez des plugins IA, des politiques et des analyses à l'écosystème Kong ; un excellent choix lorsque vous avez besoin de contrôles centralisés à la périphérie pour plusieurs équipes.

Unify (routeur basé sur les données)

API universelle avec des benchmarks en direct pour optimiser le coût/la vitesse/la qualité par région et charge de travail.

Orq.ai (expérimentation et LLMOps)

Expériences, évaluateurs (y compris les métriques RAG), déploiements et RBAC/VPC—idéal lorsque l'évaluation et la gouvernance doivent coexister.

LiteLLM (proxy/passerelle auto-hébergé)

Proxy open-source compatible OpenAI avec budgets/limites, journalisation/métriques et une interface administrateur. Déployez avec Docker/K8s/Helm ; vous gérez les opérations.

Analyses approfondies : principales alternatives à RouteLLM

ShareAI (API IA alimentée par les utilisateurs)

Ce que c'est. Un réseau IA axé sur les fournisseurs et une API unifiée. Parcourez un large catalogue de modèles/fournisseurs et effectuez un routage avec basculement instantané. La place de marché affiche le prix, la latence, la disponibilité et le temps de fonctionnement en un seul endroit pour vous permettre de choisir le bon fournisseur avant chaque routage. Commencez dans le Terrain de jeu, créez des clés dans le Console, et suivez le guide de démarrage rapide de l'API dans le Docs. Parcourez le Marché des Modèles.

- Transparence du marché — voyez le prix/la latence/la disponibilité/le temps de fonctionnement en un coup d'œil.

- Résilience par défaut — basculement rapide vers le meilleur fournisseur suivant lorsqu'un problème survient.

- Économie alignée sur les constructeurs — la majorité des dépenses va aux fournisseurs de GPU qui maintiennent les modèles en ligne.

- Démarrage sans friction — testez dans le Playground, puis déployez.

Faits sur les fournisseurs (gagnez en maintenant les modèles en ligne). Tout le monde peut devenir un fournisseur (Communauté ou Entreprise). Intégrez via Windows/Ubuntu/macOS ou Docker. Contribuez avec des pics de temps inactif ou fonctionnez en continu. Choisissez vos incitations : Récompenses (argent), Échange (jetons/Prosumer IA) ou Mission (faites don d'un % à des ONG). Consultez le Guide du fournisseur ou ouvrez le Tableau de bord des fournisseurs.

Idéal pour. Les équipes produit qui souhaitent une transparence du marché, une résilience et de la place pour évoluer en mode fournisseur—sans verrouillage fournisseur.

Eden IA

Ce que c'est. Une API unifiée qui couvre les LLM + génération d'images + OCR/analyse de documents + discours + traduction afin que vous n'ayez pas à assembler plusieurs SDK de fournisseurs. Ils mettent également l'accent sur la comparaison de modèles, la surveillance et le regroupement.

Bon choix lorsque. Votre feuille de route est multimodale et vous souhaitez orchestrer OCR/discours/traduction en parallèle avec le chat LLM.

Points de vigilance. Si vous avez besoin d'un vue du marché par demande (prix/latence/disponibilité/temps de fonctionnement) ou économie au niveau du fournisseur, associez un routeur de marché comme ShareAI.

OpenRouter

Ce que c'est. Un routeur LLM unifié avec routage fournisseur/modèle et la mise en cache des invites. Avec la mise en cache activée, OpenRouter tend à vous maintenir sur le même fournisseur pour réutiliser des contextes chauds ; si ce fournisseur est indisponible, il bascule. Il prend également en charge des indices de stratégie (par exemple, pondération par prix).

Bon choix lorsque. Vous souhaitez un hébergement rapide et un routage conscient du cache pour réduire les coûts et améliorer le débit—surtout dans les charges de travail de chat à haut QPS avec des invites répétées.

Points de vigilance. Pour une gouvernance d'entreprise approfondie (exportations SIEM, politique à l'échelle de l'organisation), de nombreuses équipes associent OpenRouter à Portkey ou Kong AI Gateway.

Portkey

Ce que c'est. Une passerelle IA avec des solutions de repli programmables, des playbooks de limitation de débit et un cache simple/sémantique, plus des traces/métriques pour un contrôle de style SRE. Le cache sémantique est particulièrement utile pour les invites/messages courts lorsque les seuils de similarité sont bien ajustés.

Bon choix lorsque. Vous avez besoin d'un routage basé sur des politiques avec une observabilité de premier ordre, et vous êtes à l'aise pour exploiter une couche de passerelle devant un ou plusieurs routeurs/marchés.

Kong Passerelle IA

Ce que c'est. Une passerelle edge qui intègre des plugins IA, des politiques et des analyses dans l'écosystème Kong (via Konnect ou autogéré). Si votre plateforme API tourne déjà autour de Kong et que vous avez besoin de politiques/audits centralisés, c'est un choix solide.

Bon choix lorsque. La gouvernance edge, l'auditabilité, la résidence des données et les contrôles centralisés sont non négociables dans votre environnement.

Unifier

Ce que c'est. Un routeur basé sur les données qui optimise le coût/la vitesse/la qualité en utilisant des benchmarks en direct, ajustés par région et charge de travail.

Bon choix lorsque. Vous souhaitez une sélection guidée par des benchmarks qui s'adapte continuellement aux performances réelles.

Orq.ia

Ce que c'est. Une plateforme de collaboration IA générative + LLMOps : expériences, évaluateurs (y compris les métriques RAG), déploiements et RBAC/VPC. Idéal lorsque l'évaluation et la gouvernance doivent coexister.

Bon choix lorsque. Vous avez besoin d'expérimentation + évaluation avec gouvernance en un seul endroit, puis déployez directement depuis la même interface.

LiteLLM

Ce que c'est. Un proxy/passerelle open-source avec des points de terminaison compatibles OpenAI, budgets et limites de taux, journalisation/métriques, et une interface administrateur. Déployez via Docker/K8s/Helm ; gardez le trafic dans votre propre réseau.

Bon choix lorsque. Vous souhaitez un hébergement autonome et un contrôle total de l'infrastructure avec une compatibilité simple pour les SDK populaires de type OpenAI.

Points de vigilance. Comme avec toute passerelle OSS, vous êtes responsable des opérations et des mises à jour.

Démarrage rapide : appelez un modèle en quelques minutes (ShareAI)

Commencez dans le Terrain de jeu, puis obtenez une clé API et expédiez. Références : démarrage rapide de l'API • Accueil Docs • Versions.

#!/usr/bin/env bash"

// ShareAI — Complétions de Chat (JavaScript, Node 18+);

Conseil de migration. Associez vos modèles actuels sélectionnés par RouteLLM aux équivalents ShareAI, reflétez les formes de requête/réponse et commencez derrière un drapeau de fonctionnalité. Envoyez d'abord 5–10% du trafic, comparez la latence/le coût/la qualité, puis augmentez progressivement. Si vous utilisez également une passerelle (Portkey/Kong), assurez-vous que la mise en cache/les solutions de secours ne se déclenchent pas deux fois entre les couches.

Comparaison en un coup d'œil

| Plateforme | Hébergé / Auto-hébergé | Routage et Replis | Observabilité | Ampleur (LLM + au-delà) | Gouvernance / Politique | Notes |

|---|---|---|---|---|---|---|

| RouteLLM | OSS | Routeur intelligent ; client/serveur compatible OpenAI | CLI/journaux ; focus sur la recherche | Centré sur LLM | Politique via votre infrastructure | Idéal pour des économies de coûts de niveau recherche ; apportez vos propres contrôles de périphérie. |

| ShareAI | Hébergé + réseau de fournisseurs | Basculement instantané ; sélection guidée par le marché | Journaux d'utilisation; statistiques du marketplace | Catalogue de modèles étendu | Contrôles au niveau du fournisseur | Marché alimenté par les personnes ; commencez avec Terrain de jeu et Modèles. |

| Eden IA | Hébergé | Changer de fournisseurs; lot; mise en cache | Surveillance des coûts et des API | LLM + image + OCR + discours + traduction | Facturation centrale/gestion des clés | Orchestrateur multimodal. |

| OpenRouter | Hébergé | Routage fournisseur/modèle ; mise en cache des invites ; adhérence au fournisseur | Informations au niveau des requêtes | Centré sur LLM | Politiques des fournisseurs | Réutilisation du cache ; repli en cas d'indisponibilité. |

| Portkey | Passerelle hébergée | Replis de politique ; playbooks de limitation de débit ; cache sémantique | Traces/métriques | LLM-prioritaire | Configurations de passerelle | Garde-fous de style SRE. |

| Kong Passerelle IA | Auto-hébergé/Entreprise | Routage en amont via des plugins IA | Métriques/audit via Kong | LLM-prioritaire | Gouvernance forte des bords | Composant d'infrastructure ; s'associe avec des routeurs/marchés. |

| Unifier | Hébergé | Routage basé sur les données par coût/vitesse/qualité | Explorateur de référence | Centré sur LLM | Politiques de routage | Sélection guidée par des benchmarks. |

| Orq.ia | Hébergé | Réessais/replis dans l'orchestration | Analytique de plateforme ; évaluateurs RAG | LLM + RAG + évaluations | Options RBAC/VPC | Collaboration et focus sur l'expérimentation. |

| LiteLLM | Auto-hébergement/OSS | Réessayer/repli ; budgets/limites | Journalisation/métriques ; Interface Admin | Centré sur LLM | Contrôle total de l'infrastructure | Compatible avec OpenAI ; Déploiement Docker/K8s/Helm. |

FAQ : RouteLLM vs le reste

RouteLLM vs ShareAI — lequel est meilleur ?

Choisissez ShareAI si vous voulez un marché transparent qui met en avant prix/latence/disponibilité/temps de fonctionnement avant chaque itinéraire, plus basculement instantané et des économies alignées sur le constructeur. Choisissez RouteLLM si vous préférez un routeur basé sur la recherche et que vous êtes à l'aise pour gérer l'infrastructure autour de celui-ci (passerelles, journalisation, audit). Commencez avec le Terrain de jeu et Marché des Modèles.

RouteLLM vs Eden AI — quelle est la différence ?

Eden IA couvre les LLM et multimodal (vision/OCR, discours, traduction) avec comparaison et surveillance. RouteLLM se concentre sur le routage appris pour les LLM. Si votre feuille de route nécessite OCR/discours/traduction sous une API unique, Eden AI simplifie la livraison ; si la recherche sur le routage est la priorité, RouteLLM convient. Associez-le à ShareAI lorsque vous souhaitez une transparence du marché par demande.

RouteLLM vs OpenRouter — quand choisir chacun ?

Choisissez OpenRouter quand la mise en cache des invites et la réutilisation du cache chaud sont importants (cela tend à vous maintenir sur le même fournisseur et revient en cas de pannes). Choisissez RouteLLM pour des politiques apprises que vous gérez vous-même. De nombreuses piles associent OpenRouter à une passerelle pour la politique/observabilité—et utilisent toujours ShareAI lorsqu'elles souhaitent une transparence du marché avant chaque itinéraire.

RouteLLM vs Portkey — routeur ou passerelle ?

RouteLLM est un routeur. Portkey est une passerelle: il excelle dans les politiques/garde-fous (playbooks de secours, cache sémantique) et les traces/métriques détaillées. De nombreuses équipes utilisent les deux : une passerelle pour la politique à l'échelle de l'organisation + un routeur/marché pour le choix du modèle et le contrôle des coûts. ShareAI s'associe bien ici lorsque vous souhaitez une visibilité du marché avant l'itinéraire.

RouteLLM vs Kong AI Gateway — qui a besoin de quoi ?

Choisissez Kong Passerelle IA quand gouvernance de l'edge (politique/audit centralisé, résidence des données) est non négociable. Gardez RouteLLM derrière si vous souhaitez toujours un routage appris pour le prix/performance. Utilisez ShareAI parallèlement lorsque vous souhaitez choisir des fournisseurs par prix/latence/disponibilité/temps de fonctionnement avant chaque itinéraire.

RouteLLM vs Unify — qu'est-ce qui est unique à propos de Unify ?

Unifier utilise des benchmarks en direct et des politiques dynamiques pour optimiser pour coût/vitesse/qualité. Si vous souhaitez une sélection basée sur les données qui évolue par région/charge de travail, Unify est convaincant ; RouteLLM se concentre sur des modèles de routage appris que vous hébergez. Utilisez ShareAI lorsque vous préférez choisir des fournisseurs avec une vue du marché et un basculement instantané.

RouteLLM vs Orq.ai — lequel pour l'évaluation et RAG ?

Orq.ia fournit une surface d'expérimentation/évaluation (y compris des évaluateurs RAG), ainsi que des déploiements et RBAC/VPC. Si vous avez besoin de LLMOps + évaluateurs, Orq.ai peut compléter ou remplacer un routeur pur dès le début. Apportez ShareAI lorsque vous souhaitez un choix de fournisseur avec transparence du marché et résilience en production.

RouteLLM vs LiteLLM — hébergé vs auto-hébergé ?

RouteLLM est une logique de routage OSS ; LiteLLM est un proxy/passerelle compatible OpenAI avec des budgets, des limites de taux et une interface administrateur—idéal si vous souhaitez garder le trafic à l'intérieur de votre VPC et posséder le plan de contrôle. Les équipes combinent souvent LiteLLM pour l'auto-hébergement avec ShareAI pour la visibilité du marché et le basculement instantané entre les fournisseurs.

Quel est le moins cher pour ma charge de travail : RouteLLM, ShareAI, OpenRouter, LiteLLM ?

Cela dépend du choix du modèle, de la région, de la mise en cache et des schémas de trafic. Les routeurs comme ShareAI/OpenRouter peuvent réduire les coûts via le routage et la persistance consciente du cache ; des passerelles comme Portkey ajoutent une mise en cache sémantique ; LiteLLM réduisent les frais de plateforme si vous êtes à l’aise pour les exploiter. Évaluez avec votre des invites et suivent le coût effectif par résultat—pas seulement le prix affiché.

Qu'est-ce que RouteLLM ?

Un framework open-source pour servir et évaluer les routeurs LLM ; inclut des routeurs entraînés et des chemins compatibles avec OpenAI ; souvent cité pour réduire considérablement les coûts tout en maintenant une qualité proche de GPT-4 sur des tâches similaires à MT-Bench.

Quelle est la façon la plus rapide d'essayer ShareAI sans une intégration complète ?

Ouvrez le Terrain de jeu, choisissez un modèle/fournisseur et exécutez des invites dans le navigateur. Une fois prêt, créez une clé et insérez les extraits cURL/JS ci-dessus dans votre application.

Puis-je devenir un fournisseur ShareAI et gagner ?

Oui. Tout le monde peut s'inscrire comme Communauté ou Entreprise fournisseur utilisant Windows/Ubuntu/macOS ou Docker. Contribuez aux rafales de temps d'inactivité ou exécutez toujours actif. Choisissez des incitations : Récompenses (argent), Échanger (jetons/Prosumer IA), ou Mission (donnez % aux ONG). Voir le Guide du fournisseur ou ouvrez le Tableau de bord des fournisseurs.

Conclusion

Bien que RouteLLM est un routeur OSS solide, votre meilleur choix dépend des priorités :

- Transparence du marché + résilience : ShareAI

- Couverture multimodale sous une seule API : Eden IA

- Routage conscient du cache sous forme hébergée : OpenRouter

- Politique/garde-fous à l'edge : Portkey ou Kong AI Gateway

- Routage basé sur les données : Unifier

- LLMOps + évaluateurs : Orq.ia

- Plan de contrôle auto-hébergé : LiteLLM

Si prix/latence/disponibilité/temps de fonctionnement avant chaque route, basculement instantané, et des économies alignées sur le constructeur figurent sur votre liste de contrôle, ouvrez le Terrain de jeu, créez une clé API, et parcourez le Marché des Modèles pour acheminer votre prochaine demande de manière intelligente.