Alternatives à Portkey 2026 : Portkey vs ShareAI

Mis à jour en février 2026

Si vous recherchez un Alternative Portkey, ce guide compare les options comme le ferait un constructeur—à travers le routage, la gouvernance, l'observabilité et le coût total (pas seulement les tokens $/1K en gros titre). Nous commençons par clarifier ce qu'est Portkey, puis classons les meilleures alternatives avec des critères, des conseils de migration et un démarrage rapide à copier-coller pour ShareAI.

TL;DR — Si vous voulez une API pour de nombreux fournisseurs, données transparentes avant routage (prix, latence, disponibilité, temps de fonctionnement, type de fournisseur), et basculement instantané, commencez par ShareAI. Conservez une passerelle si vous avez besoin de politiques à l'échelle de l'organisation ; ajoutez ShareAI pour un routage guidé par le marché.

Ce qu'est (et n'est pas) Portkey

Portkey est une passerelle IA axée sur gouvernance (politiques/garde-fous), observabilité (traces/logs), et des outils de développement pour gérer le trafic LLM à votre périphérie—centralisant les clés, les politiques et les protections. C'est puissant pour la conformité et la fiabilité, mais c'est pas un modèle transparent 7. . Si vous utilisez déjà APISIX/APIs, vous reconnaîtrez l'approche plan de contrôle/plan de données et le modèle de plugin. et il ne fournit pas nativement un côté offre alimenté par les personnes.

Agrégateurs vs Passerelles vs Plateformes d'agents

- Agrégateurs LLM: Une API sur de nombreux modèles/fournisseurs, avec transparence pré-routage (prix, latence, disponibilité, type de fournisseur) et intégré routage intelligent/basculement.

- Passerelles IA: Politique/gouvernance à la périphérie (identifiants, limites de taux, garde-fous) + observabilité ; vous apportez des fournisseurs. Portkey vit ici.

- Plateformes d'agents/chatbots: UX utilisateur final, mémoire/outils, canaux—moins sur le routage brut, plus sur les assistants packagés.

Comment nous avons évalué les meilleures alternatives à Portkey

- Ampleur et neutralité des modèles — propriétaire + ouvert ; changement facile ; pas de réécritures.

- Latence et résilience — politiques de routage, délais d'attente/reprises, instantané basculement.

- 2. Gouvernance et sécurité — gestion des clés, portées, rédaction, routage régional.

- Observabilité — journaux/traces, tableaux de bord coût/latence, signaux compatibles OTel.

- 5. Transparence des prix et TCO — comparer réel coûts avant de router.

- Expérience développeur 9. temps jusqu'au premier jeton; 10. Communauté et économie.

- 11. — si vos dépenses — vos dépenses aident-elles augmentent-elles l'offre (incitations pour les fournisseurs/propriétaires de GPU) ?

Les 10 meilleures alternatives à Portkey (classées)

#1 — ShareAI (API d'IA alimentée par les utilisateurs)

Ce que c'est. A API multi-fournisseurs avec un marché transparent et gestion intelligente des routes. Une intégration vous offre un large catalogue de modèles et de fournisseurs ; vous pouvez comparer le prix, la latence, la disponibilité, le type de fournisseur avant de router—puis basculer instantanément si un fournisseur a un problème.

Pourquoi c’est #1 ici. Si vous évaluez Portkey mais que votre besoin principal est une agrégation indépendante des fournisseurs avec transparence pré-routage et résilience, ShareAI est l'ajustement le plus direct. Gardez une passerelle pour les politiques organisationnelles, ajoutez ShareAI pour un routage guidé par le marché et sans verrouillage.

- Une API → 150+ modèles chez de nombreux fournisseurs ; changement facile.

- Marché transparent: choisissez par le prix, la latence, disponibilité, la disponibilité, type de fournisseur.

- Résilience par défaut: politiques de routage + basculement instantané.

- Économie équitable: 70% de chaque dollar va aux fournisseurs (communauté ou entreprise).

Liens rapides — Parcourir les modèles · Ouvrir le terrain de jeu · Créer une clé API · Référence API · Guide de l'utilisateur · Versions

Pour les fournisseurs : gagnez en gardant les modèles en ligne. Tout le monde peut devenir un fournisseur ShareAI—Communauté ou Entreprise. Intégrez sur Windows, Ubuntu, macOS ou Docker. Contribuez avec des rafales de temps d'inactivité ou fonctionnez en permanence. Choisissez une incitation : Récompenses (argent), Échange (tokens/Prosumer IA), ou Mission (donnez un pourcentage à des ONG). À mesure que vous évoluez, vous pouvez définir vos propres prix d'inférence et bénéficier d'une exposition préférentielle. Guide du fournisseur.

#2 — Passerelle AI Kong

Passerelle AI/LLM d'entreprise : politiques, plugins et analyses pour le trafic IA à la périphérie. Un plan de contrôle plutôt qu'un marché ; fort pour la gouvernance, pas pour la transparence des fournisseurs.

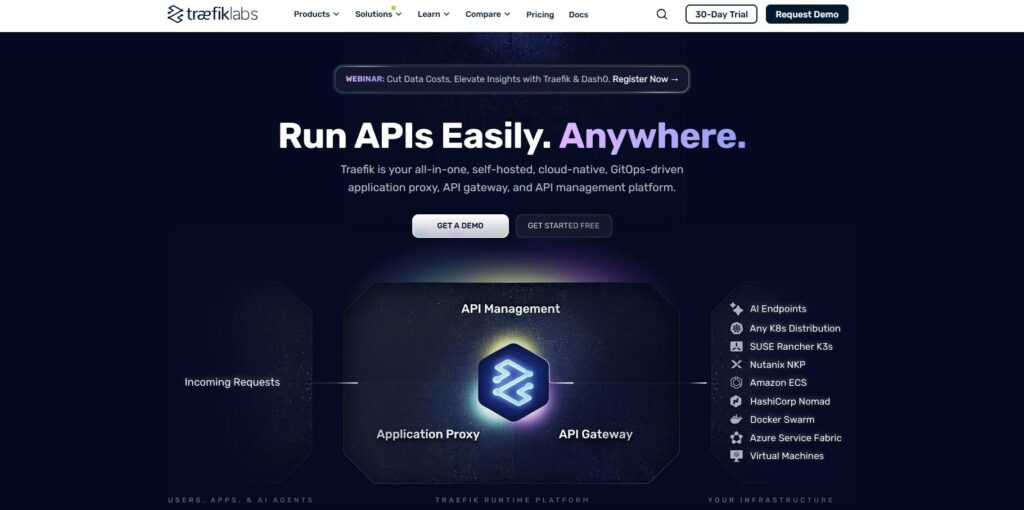

#3 — Passerelle IA Traefik

Une couche IA mince au-dessus d'une passerelle API avec des identifiants/politiques centralisés, des middlewares IA spécialisés et une observabilité compatible OTel. Excellente gouvernance de sortie ; apportez vos propres fournisseurs.

#4 — OpenRouter

Une API unifiée sur de nombreux modèles ; idéal pour une expérimentation rapide sur un large catalogue. Moins d'accent sur la gouvernance ; davantage sur le changement facile de modèle.

#5 — Eden AI

Agrège non seulement les LLM mais aussi les images, la traduction et le TTS. Offre des solutions de secours/mise en cache et de regroupement ; adapté lorsque vous avez besoin de nombreux types de services IA en un seul endroit.

#6 — LiteLLM

Un SDK Python léger + proxy auto-hébergeable parlant une interface compatible OpenAI avec de nombreux fournisseurs. Flexibilité DIY ; les opérations sont à votre charge.

#7 — Unify

Routage et évaluation orientés qualité pour choisir de meilleurs modèles par invite. Fort pour la sélection du meilleur modèle, moins pour la transparence du marché.

#8 — Orq

Plateforme d'orchestration/collaboration pour passer des expériences à la production avec des flux low-code et une coordination d'équipe.

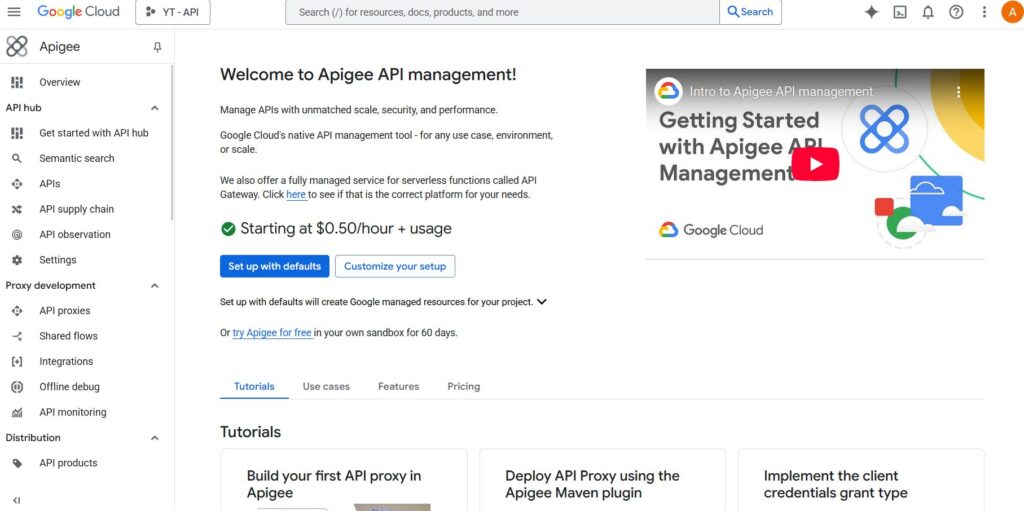

#9 — Apigee (avec des LLMs derrière)

Une gestion/passerelle API mature que vous pouvez placer devant les fournisseurs LLM pour appliquer des politiques, des clés et des quotas. Large, pas spécifique à l'IA.

#10 — NGINX

Approche DIY : construisez un routage personnalisé, une application de jetons et une mise en cache pour les backends LLM si vous voulez un contrôle maximal et des extras minimaux.

Mentions honorables : Cloudflare AI Gateway (politiques de périphérie, mise en cache, analyses), OpenAI API (profondeur et maturité d'un fournisseur unique).

Portkey vs ShareAI (quand choisir lequel).

Si votre exigence #1 est la gouvernance de sortie—identifiants centralisés, application des politiques et observabilité approfondie—Portkey convient bien.

Si votre exigence #1 est accès indépendant du fournisseur avec des données pré-routées transparentes et basculement instantané, choisissez ShareAI. De nombreuses équipes utilisent les deux : une passerelle pour les politiques à l'échelle de l'organisation + ShareAI pour un routage résilient guidé par le marché.

Comparaison rapide

| Plateforme | À qui cela s'adresse | Étendue des modèles | 2. Gouvernance et sécurité | Observabilité | Routage / basculement | Transparence du marché | Programme fournisseur |

|---|---|---|---|---|---|---|---|

| ShareAI | Équipes produit/plateforme ayant besoin d'une API + une économie équitable | 150+ modèles auprès de nombreux fournisseurs | Clés API et contrôles par itinéraire | Utilisation de la console + statistiques du marché | Routage intelligent + basculement instantané | Oui (prix, latence, disponibilité, disponibilité, type de fournisseur) | Oui — approvisionnement ouvert ; 70% aux fournisseurs |

| Portkey | Équipes souhaitant une gouvernance de sortie | Fournisseurs BYO | Identifiants/politiques centralisés & garde-fous | Traces/logs approfondis | Routage conditionnel via des politiques | Partiel (outil d'infrastructure, pas un marché) | n/a |

| Kong Passerelle IA | Entreprises nécessitant une politique au niveau de la passerelle | Apportez votre propre. | Politiques/plugins robustes en périphérie | Analytique | Réessais/plugins | Non (infrastructure) | n/a |

| Passerelle IA Traefik | Équipes concentrées sur le contrôle de sortie de l'IA | Apportez votre propre. | Intergiciels & politiques IA | Compatible OTel | Intergiciels conditionnels | Non (infrastructure) | n/a |

| OpenRouter | Développeurs souhaitant une seule clé | Catalogue étendu | Contrôles API de base | Côté application | Solutions de secours | Partiel | n/a |

| Eden IA | Équipes ayant besoin de LLM + IA plus large | Large | Contrôles standards | Varie | Solutions de secours/mise en cache | Partiel | n/a |

| LiteLLM | Proxy DIY/autohébergé | De nombreux fournisseurs | Limites de configuration/clé | Votre infrastructure | Réessais/solutions de secours | n/a | n/a |

| Unifier | Équipes axées sur la qualité | Multi-modèle | Sécurité API standard | Analytique de la plateforme | Sélection du meilleur modèle | n/a | n/a |

| Orq | Équipes axées sur l'orchestration | Large support | Contrôles de la plateforme | Analytique de la plateforme | Flux d'orchestration | n/a | n/a |

| Apigee / NGINX | Entreprises / DIY | Apportez votre propre. | Politiques/personnalisées | Modules complémentaires / personnalisés | Personnalisé | n/a | n/a |

Tarification et TCO : comparez les coûts réels (pas seulement les prix unitaires)

Brut $/1K jetons cache la véritable image. Le TCO évolue avec réessais/solutions de repli, la latence (affecte l'utilisation), variance du fournisseur, stockage d'observabilité, et exécutions d'évaluation. Un marché transparent vous aide à choisir des itinéraires équilibrant coût et UX.

TCO ≈ Σ (Base_tokens × Unit_price × (1 + Retry_rate))

- Prototype (~10k tokens/jour) : Optimiser 10. Communauté et économie avec Playground + démarrages rapides.

- Échelle moyenne (~2M tokens/jour) : Routage/échec guidé par le marché peut réduire de 10–20% tout en améliorant l'UX.

- Charges de travail irrégulières: Attendez-vous à des coûts de tokens effectifs plus élevés en raison des nouvelles tentatives lors du basculement—prévoir un budget pour cela.

Guide de migration : passez à ShareAI depuis Portkey ou autres

Depuis Portkey → Conservez les politiques au niveau de la passerelle de Portkey là où elles excellent ; ajoutez ShareAI pour le routage du marché + basculement instantané. Modèle : authentification/politique de passerelle → Itinéraire ShareAI par modèle → mesurer les statistiques du marché → resserrer les politiques.

Depuis OpenRouter → Mapper les noms de modèles, vérifier la parité des invites, puis redirigez 10% du trafic et augmentez 25% → 50% → 100% selon les budgets de latence/erreur. Les données du marché rendent les échanges de fournisseurs simples.

Depuis LiteLLM → Remplacez le proxy auto-hébergé sur 8. la production les itinéraires que vous ne souhaitez pas exploiter ; conservez LiteLLM pour le développement si souhaité. Comparez les frais d'exploitation par rapport aux avantages du routage géré.

Depuis Unify / Orq / Kong / Traefik → Définissez les attentes de parité des fonctionnalités (analytique, garde-fous, orchestration, plugins). De nombreuses équipes fonctionnent en hybride : conservez les fonctionnalités spécialisées là où elles sont les plus fortes ; utilisez ShareAI 3. pour un choix transparent de fournisseur et basculement.

Démarrage rapide pour développeurs (compatible OpenAI)

Créez une clé API dans la Console, puis envoyez votre première requête.

Créer une clé API · Ouvrir le terrain de jeu · Référence API

cURL — Achèvements de Chat

#!/usr/bin/env bash"

JavaScript (fetch) — Node 18+/Edge

// Prérequis :;

Liste de contrôle de sécurité, confidentialité et conformité

- Gestion des clés: cadence de rotation ; portées minimales ; séparation des environnements.

- Conservation des données: où les invites/réponses sont stockées ; rédaction par défaut ; fenêtres de rétention.

- PII & contenu sensible: masquage ; contrôles d'accès ; routage régional pour la localisation des données.

- Observabilité: journalisation des invites/réponses ; capacité à filtrer ou pseudonymiser ; propager les identifiants de traçage de manière cohérente.

- Réponse aux incidents: chemins d'escalade et SLA des fournisseurs.

FAQ — Portkey vs autres concurrents (et où ShareAI s'intègre)

Portkey vs OpenRouter — accès multi-modèle rapide ou contrôles de passerelle ?

OpenRouter permet un accès multi-modèle rapide. Portkey centralise la politique/l'observabilité. Si vous voulez aussi transparence pré-routage et basculement instantané, ShareAI combine l'accès multi-fournisseurs avec une vue du marché un routage résilient. Parcourir les modèles.

Portkey vs Traefik AI Gateway — confrontation sur la gouvernance des sorties ?

Les deux sont des passerelles (identifiants/politique centralisés ; observabilité). Traefik offre une couche IA légère et des signaux compatibles OTel ; Portkey met l'accent sur les garde-fous et l'ergonomie des développeurs. Pour un choix transparent de fournisseur + basculement, ajoutez ShareAI aux côtés d'une passerelle.

Portkey vs Kong AI Gateway — politique d'entreprise vs garde-fous spécifiques à l'IA ?

Kong apporte des politiques/plugins de niveau entreprise; Portkey se concentre sur le trafic IA. De nombreuses entreprises associent une passerelle à ShareAI pour obtenir routage guidé par le marketplace et sans verrouillage.

Portkey vs Eden AI — services IA plus larges ou contrôle de sortie ?

Eden agrège LLM + vision/TTS/traduction; Portkey centralise sortie AI. Si vous voulez tarification/transparence de latence auprès de nombreux fournisseurs et basculement instantané, ShareAI est conçu spécifiquement.

Portkey vs LiteLLM — proxy auto-hébergé ou gouvernance gérée ?

LiteLLM est un proxy DIY ; Portkey est gouvernance/observabilité gérée. Si vous préférez ne pas exploiter le proxy et souhaitez également un routage basé sur le marché, allez ShareAI.

Portkey vs Unify — sélection du meilleur modèle ou application de politique ?

Unifier se concentre sur sélection basée sur l'évaluation; Portkey sur politique/observabilité. Ajoutez ShareAI lorsque vous avez besoin une API plusieurs fournisseurs avec des statistiques de marché en direct.

Portkey vs Orq — orchestration ou sortie ?

Orq aide à orchestrer des flux en plusieurs étapes ; Portkey régit le trafic de sortie. Utilisez ShareAI 3. pour une sélection de fournisseur transparente et routage résilient derrière l'une ou l'autre approche.

Portkey vs Apigee — gestion des API vs sortie spécifique à l'IA ?

Apigee est une gestion d'API étendue ; Portkey est une gouvernance de sortie axée sur l'IA. Pour d'un accès indépendant du fournisseur avec transparence du marché, choisissez ShareAI.

Portkey vs NGINX

NGINX offre des filtres/politiques bricolés ; Portkey offre une couche emballée avec des garde-fous IA et une observabilité. Pour éviter Lua personnalisé et tout en obtenant une sélection de fournisseur transparente, intégrez ShareAI.

Portkey vs OpenAI API — profondeur fournisseur unique ou contrôle de passerelle ?

API OpenAI donne profondeur et maturité au sein d'un fournisseur. Portkey centralise la politique de sortie à travers votre fournisseurs. Si vous voulez de nombreux fournisseurs, transparence pré-routage, et basculement, utilisez ShareAI comme votre API multi-fournisseurs.

Portkey vs Cloudflare AI Gateway — réseau de périphérie ou ergonomie axée sur l'IA ?

Passerelle IA Cloudflare s'appuie sur des politiques natives de périphérie, mise en cache et analyses ; Portkey se concentre sur la surface du développeur IA avec des garde-fous/observabilité. Pour transparence du marché et basculement instantané à travers les fournisseurs, ajoutez ShareAI.

Essayez ShareAI ensuite

Ouvrir le terrain de jeu · Créez votre clé API · Parcourir les modèles · Lire la documentation · Voir les versions · Se connecter / S'inscrire