Melhores alternativas ao Moonshot AI Kimi K2.5 para startups e desenvolvedores em 2026 (e como trocar modelos rapidamente com um gateway ShareAI)

Moonshot AI’s Kimi K2.5 é um daqueles lançamentos que instantaneamente mudam o clima em modelos abertos: multimodal, agente, de longo contexto e genuinamente útil para fluxos de trabalho de “trabalho real”. Se você está pesquisando alternativas ao Kimi K2.5, você provavelmente não está questionando seu poder—você está questionando o ajuste.

A melhor alternativa depende do que você está desenvolvendo: um agente de codificação, um analista de documentos longos, um bot de pesquisa que utiliza ferramentas ou um recurso de produção onde confiabilidade e previsibilidade de custos importam mais do que especificações brutas. E porque os preços e a qualidade dos modelos podem mudar rapidamente, o ganho a longo prazo é manter seu produto alternável entre modelos—não preso a um único fornecedor ou modelo.

Este guia cobre as alternativas mais fortes ao Kimi K2.5 para startups e desenvolvedores, além de como trocar modelos facilmente através de um único gateway de IA como ShareAI.

Comparação rápida de alternativas ao Kimi K2.5

Aqui está uma lista prática, organizada pelo que as equipes geralmente precisam em produção. Pense nisso como seu mapa de “experimente estes primeiro”.

| Opção | Melhor para | Por que as equipes escolhem isso em vez do Kimi K2.5 | Compromissos |

|---|---|---|---|

| DeepSeek-V3.2 | Raciocínio + agentes com orçamento limitado | Foco em raciocínio em primeiro lugar com modos amigáveis para agentes | Você ainda precisa de avaliações; o comportamento varia conforme a configuração |

| GLM-4.7 | Fluxos de trabalho de agentes + geração de UI | Fortes tendências de “especificação → UI” e confiabilidade em fluxos de trabalho de múltiplas etapas | A maturidade do ecossistema varia conforme o stack/provedor |

| Devstral 2 | Agentes de código / fluxos de trabalho de engenharia de software | Especializado para tarefas de engenharia de software com reconhecimento de repositório | Foco mais restrito do que modelos generalistas |

| Claude Opus 4.5 | Raciocínio de alto risco + codificação | Confiabilidade premium e forte desempenho para trabalhos críticos | Custo mais alto; restrições de modelo fechado |

| Grok 4.1 Rápido | Contexto massivo + chamada de ferramentas | Projetado em torno de contexto ultra-longo e ferramentas de agentes | Modelo fechado; o estilo/voz pode variar |

| ShareAI (gateway) | Permanecendo agnóstico ao modelo | Uma API para muitos modelos; troque modelos sem reescritas | Não é um modelo em si—uma camada de infraestrutura |

O que é o Kimi K2.5 da Moonshot AI?

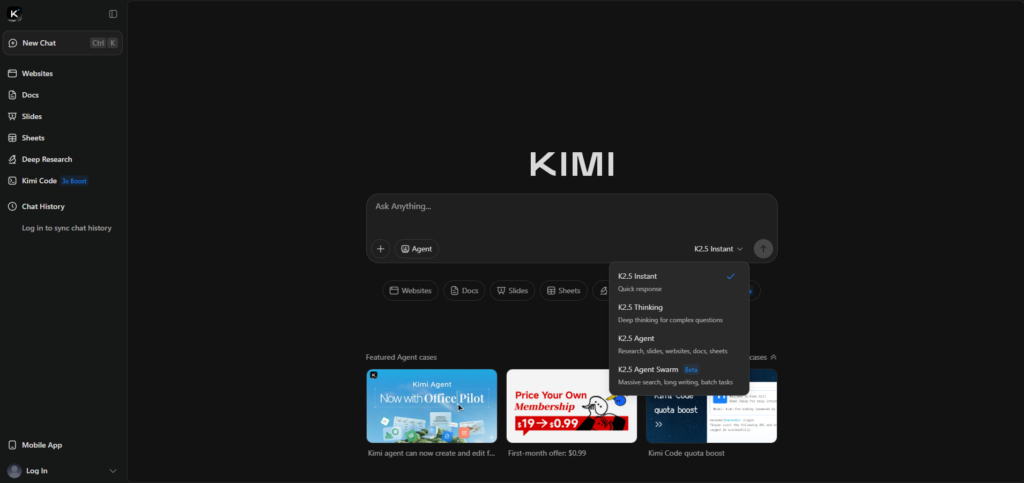

Kimi K2.5 é um modelo principal da Moonshot AI, comercializado como “código aberto,” com ênfase em raciocínio multimodal e execução agente. A página oficial de lançamento destaca entradas multimodais (incluindo vídeo) e paralelização estilo “Agent Swarm” para tarefas complexas.

Se você quiser a lista oficial de recursos e o contexto de lançamento, comece aqui: Kimi K2.5 (Moonshot AI).

Por que as pessoas procuram alternativas ao Kimi K2.5

A maioria das equipes não muda porque o Kimi é “ruim.” Elas mudam porque as restrições mudam quando você passa de demonstração para produção.

- Você precisa da melhor confiabilidade de codificação para alterações em vários arquivos, correção de bugs ou fluxos de trabalho conscientes do repositório.

- Você precisa de um grande contexto (contratos, bases de conhecimento, repositórios) sem estratégias frágeis de fragmentação.

- Você quer menor variância para fluxos de trabalho críticos, voltados para o cliente ou regulamentados.

- Você não quer ficar preso—você quer manter a vantagem quando os preços, limites ou qualidade mudarem.

Alternativas de peso aberto (controle máximo)

DeepSeek-V3.2 (raciocínio + fluxos de trabalho de agentes)

DeepSeek-V3.2 é uma escolha forte quando você quer um modelo “focado em raciocínio” para tarefas técnicas e pipelines de agentes, especialmente se você for sensível a custos. É frequentemente usado como um modelo confiável para o dia a dia em pensamento estruturado e padrões de uso de ferramentas.

Referência: Notas de lançamento da API DeepSeek.

GLM-4.7 (fluxos de trabalho agentivos + geração de UI)

GLM-4.7 vale a pena testar se o seu produto se sobrepõe ao ângulo de “visual-para-código” e execução de fluxo de trabalho do Kimi. As equipes frequentemente o avaliam para comportamento de agentes em múltiplas etapas e confiabilidade na geração de UI/front-end.

Referência: Documentação do GLM-4.7.

Devstral 2 (agentes de engenharia de software)

Se o seu principal requisito é engenharia de software de ponta a ponta—edições em vários arquivos, navegação em repositórios, correção de testes—o Devstral 2 é posicionado como um especialista. É uma forte alternativa ao Kimi K2.5 quando “agente de codificação” é o trabalho principal, não generalismo multimodal.

Referência: Anúncio do Mistral Devstral 2.

Modelos fechados (desempenho de ponta + postura empresarial)

Claude Opus 4.5 (raciocínio/codificação de alto risco)

Claude Opus 4.5 é uma escolha comum de “pagar pela confiabilidade” quando a correção importa mais do que o custo. Se sua carga de trabalho é sensível a erros sutis de raciocínio ou erros de codificação, é uma das alternativas premium mais fortes ao Kimi K2.5 da Moonshot AI.

Referência: Anthropic: Claude Opus 4.5.

Alternativas de ferramentas de contexto massivo + em tempo real

Grok 4.1 Fast (contexto ultra-longo + ferramentas)

Grok 4.1 Fast é notável por uma razão: é construído em torno de um contexto extremamente longo e ferramentas de agente. Se você tem fluxos de trabalho de “ler tudo primeiro” (grandes repositórios, grandes conjuntos de documentos), pode ser uma categoria alternativa atraente para testar junto com o Kimi K2.5.

Referência: xAI: Grok 4.1 Fast.

O “código secreto” das startups: não aposte o produto em um único modelo

Mesmo que o Kimi K2.5 seja o seu favorito hoje, construir seu produto para que possa trocar de modelo mais tarde é a melhor decisão de engenharia a longo prazo. Mudanças de preços, interrupções acontecem, limites de taxa aparecem e, às vezes, os modelos regridem.

Um padrão simples e durável é: escolha um modelo padrão para o caminho comum, um modelo especialista para solicitações difíceis (agente de codificação ou contexto massivo) e um modelo de fallback para confiabilidade. Isso é exatamente o que um gateway de IA deve facilitar.

Como o ShareAI torna o Kimi K2.5 e suas alternativas intercambiáveis

O ShareAI é construído para opcionalidade de modelo: uma API compatível com OpenAI em um amplo catálogo, para que você possa comparar e direcionar modelos sem reescrever integrações. Comece com o Marketplace de Modelos, testar prompts no Playground, e integrar via o Referência da API.

Se você estiver integrando uma equipe, o Visão geral do Console é uma orientação rápida. Para planejamento de produção, fique de olho em Notas de Lançamento e o Guia do Provedor.

Exemplo: troque o modelo campo (sem reescrita)

Esta é a principal vantagem de um único gateway de IA: seu aplicativo mantém o mesmo formato de solicitação, e você troca modelos alterando um campo. Primeiro, crie uma chave no Console: Criar Chave de API.

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Agora troque apenas o nome do modelo (todo o resto permanece o mesmo):

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Em um fluxo de trabalho de alternativas Kimi K2.5, isso permite realizar comparações rápidas, adicionar alternativas e manter a vantagem conforme o cenário de modelos muda.

Como escolher a alternativa certa para Kimi K2.5 em 30 minutos

- Defina o trabalho (agente de código corrige testes, respostas RAG de documentos internos, análise de contratos, UI para código).

- Crie um pequeno conjunto de avaliação (10–30 prompts), incluindo casos de falha e casos extremos.

- Teste 3–5 candidatos (Kimi K2.5 + dois especialistas + uma alternativa barata) e avalie a correção, confiabilidade de formatação, precisão no uso de ferramentas e latência.

- Lance com uma alternativa para que interrupções, limites e regressões não se tornem incidentes visíveis para os usuários.

Se você quiser um ponto de partida limpo para configuração e melhores práticas, adicione aos favoritos o Documentação ShareAI e o Início rápido da API.

Perguntas Frequentes

O Kimi K2.5 é open source ou open-weight?

A Moonshot AI comercializa o Kimi K2.5 como “open source” e fornece links para disponibilidade pública por meio de canais comuns de distribuição OSS. Na prática, muitas equipes usam o termo peso-aberto para ser preciso: os pesos estão disponíveis, mas o licenciamento e toda a pilha de treinamento podem diferir das normas de software “open-source” clássicas.

Referência: Página oficial do Kimi K2.5.

Quando devo escolher o Kimi K2.5 em vez de alternativas?

Escolha o Kimi K2.5 quando sua carga de trabalho for fortemente multimodal (incluindo vídeo), agente e se beneficiar da abordagem “swarm” do modelo para decompor grandes tarefas. Se você estiver criando fluxos de trabalho de UI a partir de visuais, também é um ponto de partida natural.

Qual alternativa é melhor para agentes de codificação versus codificação geral?

Se você estiver criando um agente ciente de repositórios que edita vários arquivos, executa testes e itera, comece com o Devstral 2. Se você quiser confiabilidade premium de “melhor esforço” para codificação complexa, o Claude Opus 4.5 é uma escolha comum de referência—especialmente para caminhos críticos.

Qual alternativa é melhor para documentos longos e contexto extenso?

Para fluxos de trabalho “leia tudo primeiro”, o Grok 4.1 Fast está no bucket de contexto massivo. Dito isso, muitos produtos funcionam melhor com RAG mais uma janela de contexto menor, então teste ambas as abordagens em vez de assumir que um contexto maior sempre vence.

Como comparo modelos de forma justa?

Use o mesmo conjunto de prompts, rubrica de avaliação e configurações (temperatura, tokens máximos, regras de formatação). Avalie por tarefa: correção, formato/confiabilidade JSON, precisão da ferramenta, latência e custo por resultado bem-sucedido.

Qual é a maneira mais rápida de testar alternativas do Kimi K2.5 em A/B sem reconstruir meu aplicativo?

Padronize em uma interface de API e troque o modelo campo. Usando um gateway como o ShareAI, você pode comparar candidatos no Playground e então enviar o mesmo formato de solicitação via API.

Posso rotear por “mais barato” ou “mais rápido”?

Essa é a ideia por trás do roteamento baseado em políticas: escolher um modelo com base em restrições como limite de custo, meta de latência ou tipo de tarefa. Mesmo que você comece simples (seleção manual de modelo), construir políticas de roteamento mantém você flexível à medida que provedores e modelos evoluem.

Como os modelos de fallback ajudam na produção?

Fallbacks protegem você de falhas transitórias, limites de taxa de provedores, problemas regionais e regressões de modelos. Uma estratégia de fallback muitas vezes importa mais para a experiência do usuário do que perseguir o “melhor” modelo no papel.

Como controlo os custos?

Use um modelo padrão barato para o caminho comum, limite os tokens de saída e reserve modelos premium para solicitações que realmente precisem deles. Acompanhe o custo por resultado bem-sucedido, não apenas o custo por token.

Preciso hospedar localmente para privacidade ou conformidade?

Nem sempre. Depende da classificação dos seus dados, necessidades de residência e termos do fornecedor. Comece com a política (quais dados podem ser enviados para onde), depois escolha a abordagem de implantação que corresponda a ela.

Quais tarefas ainda se beneficiam de hospedagem própria com pesos abertos?

Razões comuns incluem localização de dados, latência previsível, personalização profunda e integração estreita com ferramentas internas e diretrizes. Se essas forem suas restrições, modelos de peso aberto podem ser uma base sólida—se você estiver pronto para assumir as operações.

E se o comportamento do modelo mudar ao longo do tempo?

Assuma que mudará. Mantenha um conjunto de avaliação de regressão, monitore a deriva de qualidade e certifique-se de que pode reverter rapidamente alternando modelos ou provedores.

Resumo: escolha o melhor modelo hoje, mantenha a capacidade de mudar amanhã

Kimi K2.5 é um modelo sério da Moonshot AI, e para muitas equipes é uma excelente linha de base. Mas a abordagem mais amigável para produção é escolher o melhor modelo para cada tarefa—e manter a capacidade de mudar quando o cenário mudar.

Se você quiser essa flexibilidade sem trabalho constante de reintegração, comece navegando no marketplace de Modelos, testando no Playground, e criando sua conta via Entrar / Registrar-se. ::contentReference[oaicite:0]{index=0}