Meilleures alternatives à Moonshot AI Kimi K2.5 pour les startups et les développeurs en 2026 (et comment changer rapidement de modèles avec une passerelle ShareAI)

Moonshot AI’s Kimi K2.5 est l'une de ces versions qui change instantanément l'ambiance dans les modèles ouverts : multimodal, agentique, à long contexte, et véritablement utile pour les flux de travail de “vrai travail”. Si vous recherchez des alternatives à Kimi K2.5, vous ne remettez probablement pas en question sa puissance—vous remettez en question son adéquation.

La meilleure alternative dépend de ce que vous expédiez : un agent de codage, un analyste de documents longs, un bot de recherche utilisant des outils, ou une fonctionnalité de production où la fiabilité et la prévisibilité des coûts comptent plus que les spécifications brutes. Et parce que les prix et la qualité des modèles peuvent changer rapidement, le gain à long terme est de garder votre produit modifiable par modèle—non verrouillé à un seul fournisseur ou modèle.

Ce guide couvre les alternatives les plus solides à Kimi K2.5 pour les startups et les développeurs, ainsi que la manière de changer facilement de modèles via une passerelle IA unique comme ShareAI.

Comparaison rapide des alternatives à Kimi K2.5

Voici une liste pratique, organisée en fonction de ce dont les équipes ont généralement besoin en production. Considérez cela comme votre carte “essayez celles-ci en premier”.

| Option | Idéal pour | Pourquoi les équipes le choisissent plutôt que Kimi K2.5 | Compromis |

|---|---|---|---|

| DeepSeek-V3.2 | Raisonnement + agents avec un budget limité | Mise en avant du raisonnement avec des modes adaptés aux agents | Vous avez toujours besoin d'évaluations ; le comportement varie selon la configuration |

| GLM-4.7 | Flux de travail des agents + génération d'interface utilisateur | Fortes tendances “ spéc → UI ” et fiabilité des flux de travail en plusieurs étapes | La maturité de l'écosystème varie selon la pile/fournisseur |

| Devstral 2 | Agents de code / flux de travail SWE | Spécialisé pour les tâches d'ingénierie logicielle sensibles aux dépôts | Focalisation plus étroite que les modèles généralistes |

| Claude Opus 4.5 | Raisonnement à enjeux élevés + codage | Fiabilité premium et performances solides pour les travaux critiques | Coût plus élevé ; contraintes de modèle fermé |

| Grok 4.1 Rapide | Contexte massif + appel d'outils | Conçu autour d'un contexte ultra-long et d'outils d'agent | Modèle fermé ; le style/la voix peuvent varier |

| ShareAI (passerelle) | Rester agnostique au modèle | Une API pour de nombreux modèles ; changer de modèle sans réécritures | Pas un modèle en soi—une couche d'infrastructure |

Qu'est-ce que le Kimi K2.5 de Moonshot AI ?

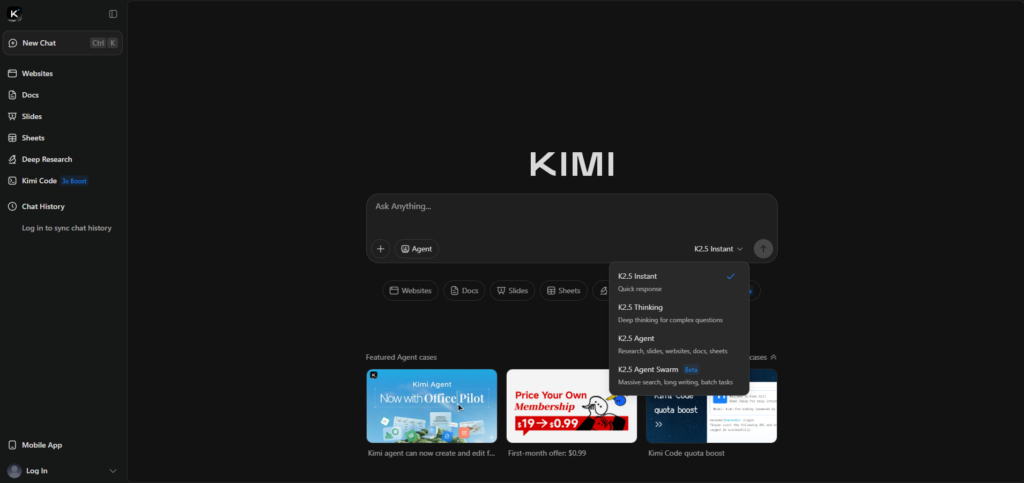

Kimi K2.5 est un modèle phare de Moonshot AI, commercialisé comme “ open source ”, avec un accent sur le raisonnement multimodal et l'exécution agentique. La page officielle de lancement met en avant des entrées multimodales (y compris vidéo) et une parallélisation de style “ Agent Swarm ” pour des tâches complexes.

Si vous voulez la liste officielle des fonctionnalités et le contexte de lancement, commencez ici : Kimi K2.5 (Moonshot IA).

Pourquoi les gens recherchent des alternatives à Kimi K2.5

La plupart des équipes ne changent pas parce que Kimi est “ mauvais ”. Elles changent parce que les contraintes évoluent une fois que vous passez de la démo à la production.

- Vous avez besoin de la meilleure fiabilité de codage pour les modifications multi-fichiers, la correction de bugs ou les workflows sensibles aux dépôts.

- Vous avez besoin d'un contexte important (contrats, bases de connaissances, dépôts) sans stratégies de découpage fragiles.

- Vous voulez une variance plus faible pour des flux de travail critiques, orientés client ou réglementés.

- Vous ne voulez pas de verrouillage—vous voulez conserver un levier lorsque les prix, les limites ou la qualité changent.

Alternatives à poids ouvert (contrôle maximal)

DeepSeek-V3.2 (raisonnement + flux de travail des agents)

DeepSeek-V3.2 est un excellent choix lorsque vous souhaitez un modèle “ axé sur le raisonnement ” pour des tâches techniques et des pipelines d'agents, en particulier si vous êtes sensible aux coûts. Il est souvent utilisé comme modèle fiable au quotidien pour une réflexion structurée et des schémas d'utilisation d'outils.

Référence : Notes de version de l'API DeepSeek.

GLM-4.7 (flux de travail agentiques + génération d'interface utilisateur)

GLM-4.7 mérite d'être testé si votre produit chevauche l'angle “ visuel vers code ” et l'exécution de flux de travail de Kimi. Les équipes l'évaluent souvent pour le comportement agent multi-étapes et la fiabilité de la génération d'interface utilisateur/front-end.

Référence : Documentation GLM-4.7.

Devstral 2 (agents d'ingénierie logicielle)

Si votre principale exigence est l'ingénierie logicielle de bout en bout—modifications multi-fichiers, navigation dans le dépôt, correction de tests—Devstral 2 est positionné comme un spécialiste. C’est une alternative solide à Kimi K2.5 lorsque le rôle principal est celui d’un “ agent de codage ”, et non le généralisme multimodal.

Référence : Annonce de Mistral Devstral 2.

Modèles fermés (performance de pointe + posture d’entreprise)

Claude Opus 4.5 (raisonnement/codage à enjeux élevés)

Claude Opus 4.5 est un choix courant de “ payer pour la fiabilité ” lorsque la précision compte plus que le coût. Si votre charge de travail est sensible aux erreurs de raisonnement subtiles ou aux erreurs de codage, c’est l’une des alternatives premium les plus solides à Kimi K2.5 de Moonshot AI.

Référence : Anthropic : Claude Opus 4.5.

Alternatives d’outils à contexte massif + en temps réel

Grok 4.1 Fast (contexte ultra-long + outils)

Grok 4.1 Fast est remarquable pour une raison : il est conçu autour d’un contexte extrêmement long et d’outils d’agent. Si vous avez des flux de travail “ lire tout d’abord ” (grands dépôts, ensembles de documents volumineux), cela peut être une catégorie alternative convaincante à tester aux côtés de Kimi K2.5.

Référence : xAI : Grok 4.1 Fast.

Le “ code de triche ” des startups : ne misez pas le produit sur un seul modèle

Même si Kimi K2.5 est votre préféré aujourd’hui, concevoir votre produit pour qu’il puisse changer de modèle plus tard est la meilleure décision d’ingénierie à long terme. Les changements de prix, les pannes surviennent, les limites de taux apparaissent, et parfois les modèles régressent.

Un modèle simple et durable est : choisir un modèle par défaut pour le chemin commun, un modèle spécialisé pour les demandes difficiles (agent de codage ou contexte massif), et un modèle de secours pour la fiabilité. C’est exactement ce qu’une passerelle IA devrait rendre facile.

Comment ShareAI rend Kimi K2.5 et ses alternatives interchangeables

ShareAI est conçu pour l’optionnalité des modèles : une API compatible OpenAI à travers un large catalogue, afin que vous puissiez comparer et router les modèles sans réécrire les intégrations. Commencez avec le Marché des Modèles, tester des invites dans le Terrain de jeu, et intégrer via le Référence API.

Si vous intégrez une équipe, le Aperçu de la console est une orientation rapide. Pour la planification de production, gardez un œil sur Notes de version et le Guide du fournisseur.

Exemple : échangez le modèle champ (pas de réécriture)

C'est l'avantage principal d'une passerelle IA unique : votre application conserve la même structure de requête, et vous changez de modèle en modifiant un seul champ. Tout d'abord, créez une clé dans la Console : Créer une clé API.

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Maintenant, échangez simplement le nom du modèle (tout le reste reste identique) :

curl -s "https://api.shareai.now/api/v1/chat/completions" \"Dans un flux de travail d'alternatives Kimi K2.5, cela vous permet de réaliser des comparaisons rapides, d'ajouter des solutions de secours et de conserver un avantage alors que le paysage des modèles évolue.

Comment choisir la bonne alternative Kimi K2.5 en 30 minutes

- Définissez la tâche (agent de code corrige les tests, RAG répond à partir de documents internes, analyse de contrat, UI-vers-code).

- Créez un petit ensemble d'évaluation (10–30 invites), y compris des cas d'échec et des cas limites.

- Tester 3–5 candidats (Kimi K2.5 + deux spécialistes + une solution de secours bon marché) et évaluer la correction, la fiabilité du formatage, la précision de l'utilisation des outils et la latence.

- Livrer avec une solution de secours afin que les pannes, les limites et les régressions ne deviennent pas des incidents visibles par les utilisateurs.

Si vous souhaitez un point de départ propre pour la configuration et les meilleures pratiques, ajoutez le Documentation ShareAI et le démarrage rapide de l'API.

FAQ

Kimi K2.5 est-il open source ou open-weight ?

Moonshot AI commercialise Kimi K2.5 comme “ open source ” et fournit des liens vers une disponibilité publique via des canaux de distribution OSS courants. En pratique, de nombreuses équipes utilisent le terme poids ouvert pour être précis : les poids sont disponibles, mais la licence et l'ensemble complet de formation peuvent différer des normes du logiciel “ open source classique ”.

Référence : Page officielle de Kimi K2.5.

Quand devrais-je choisir Kimi K2.5 plutôt que des alternatives ?

Choisissez Kimi K2.5 lorsque votre charge de travail est fortement multimodale (y compris la vidéo), agentique, et bénéficie de l'approche “ swarm ” du modèle pour décomposer de grandes tâches. Si vous construisez des workflows UI à partir de visuels, c'est également un point de départ naturel.

Quelle alternative est la meilleure pour les agents de codage par rapport au codage général ?

Si vous construisez un agent conscient des dépôts qui modifie plusieurs fichiers, exécute des tests et itère, commencez avec Devstral 2. Si vous souhaitez une fiabilité premium “ meilleure possible ” pour un codage complexe, Claude Opus 4.5 est un choix de référence courant—surtout pour les chemins critiques.

Quelle alternative est la meilleure pour les documents longs et les contextes volumineux ?

Pour les workflows “ lire tout d'abord ”, Grok 4.1 Fast est dans le groupe de contexte massif. Cela dit, de nombreux produits fonctionnent mieux avec RAG plus une fenêtre de contexte plus petite, alors testez les deux approches au lieu de supposer que le contexte plus grand gagne toujours.

Comment comparer les modèles de manière équitable ?

Utilisez le même ensemble de prompts, grille d'évaluation et paramètres (température, nombre maximal de tokens, règles de formatage). Évaluez par tâche : exactitude, fiabilité du format/JSON, précision des outils, latence et coût par résultat réussi.

Quelle est la manière la plus rapide de tester en A/B les alternatives de Kimi K2.5 sans reconstruire mon application ?

Standardisez sur une interface API unique et échangez le modèle champ. En utilisant une passerelle comme ShareAI, vous pouvez comparer les candidats dans le Terrain de jeu et ensuite envoyer la même forme de requête via le API.

Puis-je router par “ moins cher ” ou “ plus rapide ” ?

C'est l'idée derrière le routage basé sur des politiques : choisir un modèle en fonction de contraintes comme un plafond de coût, un objectif de latence ou un type de tâche. Même si vous commencez simplement (sélection manuelle de modèle), évoluer vers des politiques de routage vous garde flexible à mesure que les fournisseurs et modèles évoluent.

Comment les modèles de secours aident-ils en production ?

Les secours vous protègent contre les pannes transitoires, les limites de taux des fournisseurs, les problèmes régionaux et les régressions de modèles. Une stratégie de secours compte souvent plus pour l'expérience utilisateur que de poursuivre le “ meilleur ” modèle sur papier.

Comment contrôler les coûts ?

Utilisez un modèle par défaut bon marché pour le chemin commun, limitez les tokens de sortie et réservez les modèles premium pour les requêtes qui en ont réellement besoin. Suivez le coût par résultat réussi, pas seulement le coût par token.

Dois-je héberger moi-même pour la confidentialité ou la conformité ?

Pas toujours. Cela dépend de la classification de vos données, des besoins de résidence et des conditions du fournisseur. Commencez par une politique (quelles données peuvent être envoyées où), puis choisissez l'approche de déploiement qui y correspond.

Quelles tâches bénéficient encore de l'hébergement autonome avec poids ouverts ?

Les raisons courantes incluent la localisation des données, la latence prévisible, une personnalisation approfondie et une intégration étroite avec les outils internes et les garde-fous. Si ce sont vos contraintes, les modèles open-weight peuvent être une base solide—si vous êtes prêt à gérer les opérations.

Que se passe-t-il si le comportement du modèle change avec le temps ?

Supposons que ce sera le cas. Gardez un ensemble d'évaluation de régression, surveillez la dérive de qualité et assurez-vous de pouvoir revenir rapidement en arrière en changeant de modèles ou de fournisseurs.

Conclusion : choisissez le meilleur modèle aujourd'hui, gardez la capacité de changer demain

Kimi K2.5 est un modèle sérieux de Moonshot AI, et pour de nombreuses équipes, c'est une excellente référence. Mais l'approche la plus adaptée à la production est de choisir le meilleur modèle pour chaque tâche—et de conserver la capacité de changer lorsque le paysage évolue.

Si vous voulez cette flexibilité sans travail de réintégration constant, commencez par parcourir le Marché des modèles, tester dans le Terrain de jeu, et créer votre compte via le Se connecter / S'inscrire. ::contentReference[oaicite:0]{index=0}